全部新闻

一部有关乔治·奥威尔(George Orwell)和1984年的新电影,有一种独特的讲述故事的方式。它可能会困扰你。

奥威尔:2+2 = 5使用人工智能创建与右翼政治运动联系起来的图像。该纪录片借鉴了一系列来源,并采用了AI生成的视觉效果,包括唐纳德·特朗普的支持者的虚假图像,三角洲布鲁斯歌曲和脸部怪异的脸部怪异的tableaux。导演劳尔·佩克(Raoul Peck)的目标是透明他对AI的使用,将其视为电影在数字时代对真理和现实的批评的一部分。AI制作的元素强调了电影对极权主义和监视的探索,将历史分析与当代对技术对社会的影响的关注融为一体。

人工智能玩具在中国风靡一时,现在也出现在美国的货架上

中国公司在儿童人工智能玩具市场处于领先地位,预计到 2030 年该行业的产值将超过 1000 亿日元(140 亿美元)。著名产品包括 BubblePal 和 FoloToy,它们允许定制语音模式和角色。虽然这些玩具旨在为孩子们提供教育益处和陪伴,但家长的褒贬不一的评论凸显了人工智能反应故障和缺乏沉浸感等问题。尽管面临国内挑战,中国企业仍在国际扩张,美国竞争对手也进入市场。

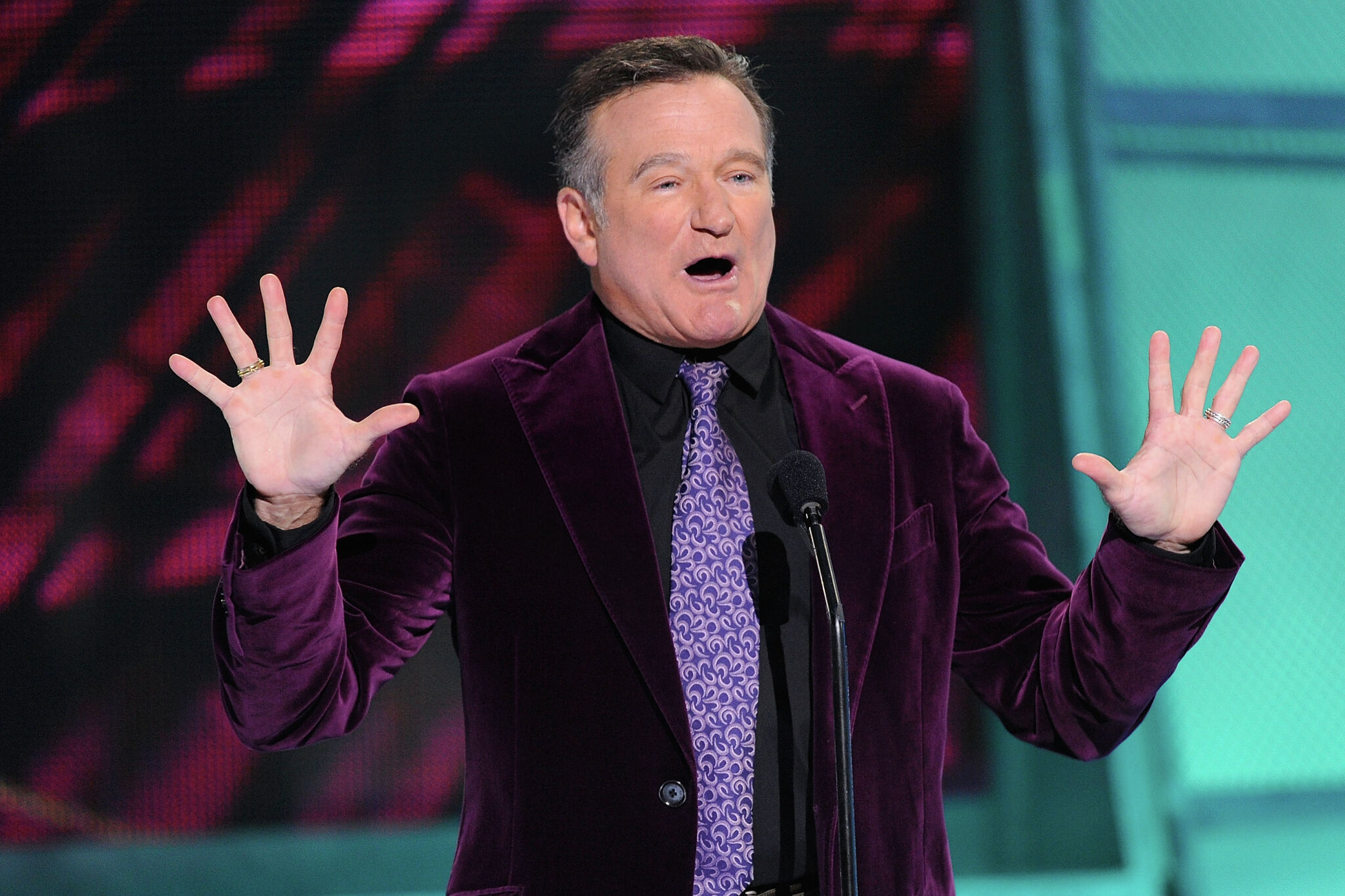

“不是他想要的”:罗宾·威廉姆斯的女儿谈论他的遗产

喜剧演员罗宾·威廉姆斯(Robin Williams)的女儿塞尔达·威廉姆斯(Zelda Williams)谴责了AI生成的视频,其中包括父亲的相似之处,称这种作品浪费了时间和精力。她认为,这些AI生成的艺术品与真正的人类艺术没有比较,并强调需要尊重心爱人物的记忆。威廉姆斯(Williams)此前曾在2023年的SAG-AFTRA罢工中批评AI技术,而Openai允许用户复制吉卜力工作室的风格。

荷兰芯片明星高管抨击欧盟过度监管人工智能

- Spotify 的 Daniel Ek 在共同创立并显着发展公司后辞去首席执行官职务。- 越来越多的美国顶尖研究人员移居欧洲,著名的欧盟研究计划的美国申请者数量增加了五倍。- 布鲁塞尔警告主要科技公司将人工智能整合到其服务中,强调遵守数字竞争规则。- 由于对《人工智能法案》的担忧日益加剧,欧盟正在准备暂停执行人工智能法规。

隐私、人工智能和国会

鉴于教皇利奥十四世提出的担忧以及最近的民意调查显示美国人对人工智能在数据保护方面的不信任,国会需要积极解决人工智能监管问题,以保护隐私并防止剥削。众议员 Warren Davidson 强调回答有关数据所有权、责任和政府监督等关键问题的重要性,以确保符合道德的人工智能发展。他强调了联邦政府采取行动的迫切需要,并警告说,鉴于目前缺乏隐私保护措施和人工智能技术的快速发展,如果国会不采取行动,州政府可能会介入。

现在购买的最好的人工智能(AI)股票之一是什么?

Marvell Technology的股票被强调为数据中心基础设施的大力投资,因为其同比增长了58%,这是对自定义AI芯片和连接组件的需求驱动的。分析师预测,收益将以每年33%的速度增长。该公司领导着关键数据中心组件,数据中心的收入在三年内翻了一番,现在占Marvell业务的75%。尽管预期增长了强劲,但该股票的价值仍然合理,以明年的收益估算为26倍。这种估值可能会在三年内将股票价格翻倍。