随着处理大量数据的需求持续激增,人工智能正在推动数据中心前所未有的需求。

随着科技巨头竞相扩展其基础设施以适应人工智能工作负载,他们面临着越来越大的挑战,即如何以可持续且经济的方式为这些运营提供动力——这甚至导致了甲骨文和微软到探索核能作为潜在的解决方案。

另一个关键问题是管理强大的人工智能硬件产生的热量。液冷已成为一种在处理不断增长的能源需求的同时保持最佳系统性能的有前景的方法。仅在 2024 年 10 月,多家科技公司就宣布了液冷解决方案,凸显了行业朝这个方向的明显转变。

液冷超级集群

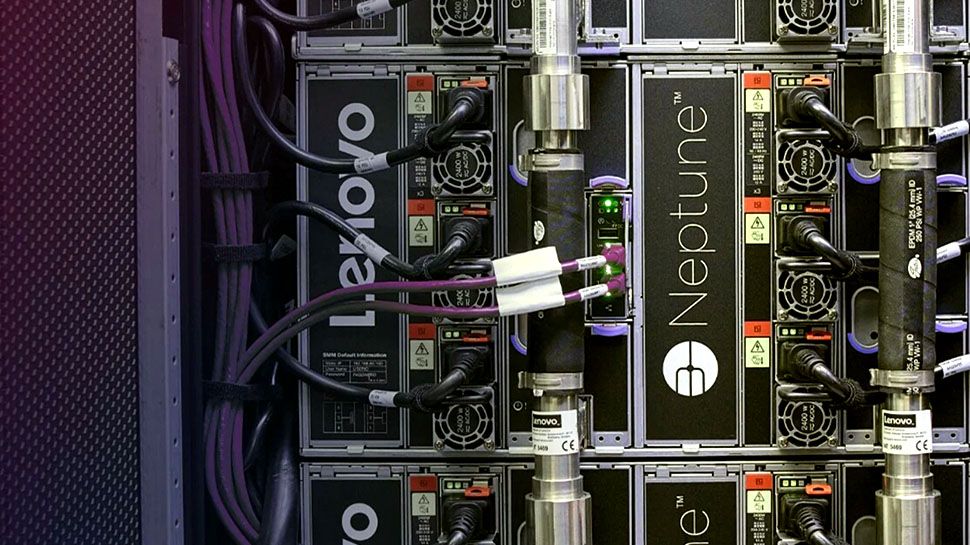

在最近的联想在 Tech World 活动中,该公司展示了其下一代 Neptune 服务器液体冷却解决方案。

第六代 Neptune 采用开环直接温水冷却,目前正在整个公司的合作伙伴生态系统中部署,使组织能够构建和运行用于生成式 AI 的加速计算,同时将数据中心功耗降低高达该公司表示,到 40%。

在2024年OCP全球峰会上,技嘉旗下技嘉计算展示了一款专为英伟达HGX H200 系统。除了DLC服务器之外,Giga还推出了G593-SD1,它配备了Nvidia H200 Tensor Core GPU专用的空气冷却室,针对那些尚未准备好完全采用液体冷却的数据中心。

戴尔的新型集成机架 7000 (IR7000) 是一款可扩展系统,专为液体冷却而设计。它能够管理高达 480KW 的未来部署,同时捕获近 100% 产生的热量。

“当今的数据中心无法跟上人工智能的需求,需要通过模块化、灵活和高效的设计进行高密度计算和液体冷却创新,”戴尔总裁 Arthur Lewis 表示。基础设施解决方案小组。– 这些新系统提供了组织在快速发展的人工智能领域保持竞争力所需的性能。 –

Supermicro 还推出了专为 AI 工作负载设计的液冷 SuperCluster,由 Nvidia Blackwell 平台提供支持。Supermicro 的液体冷却解决方案由适用于百亿亿次计算的 Nvidia GB200 NVL72 平台支持,已开始向部分客户提供样品,预计将于第四季度末实现全面量产。

– 我们正在推动可持续人工智能计算的未来,我们的液冷人工智能解决方案正在迅速被世界上一些最雄心勃勃的人工智能基础设施项目所采用,自 2024 年 6 月以来已发货超过 2,000 个液冷机架,— 美超微总裁兼首席执行官梁朝阳 (Charles Liang) 说道。

液冷 SuperCluster 具有先进的机架内或行内冷却剂分配单元 (CDU) 和定制冷板,用于在 1U 外形尺寸中容纳两个 Nvidia GB200 Grace Blackwell Superchips。

显然,随着工作负载的不断增长,液体冷却将成为数据中心运营的核心。这项技术对于管理下一代人工智能计算的热量和能源需求至关重要,我认为我们才刚刚开始看到它在未来几年对效率、可扩展性和可持续性产生的潜在影响。