聊天机器人优化游戏:我们可以信任人工智能网络搜索吗?

作者:Callum Bains

阿斯巴甜会致癌吗?从软饮料到儿童药物等各种食品中都添加了流行的人造甜味剂,其潜在致癌性的争论已经持续了数十年。1974 年,它在美国的批准引起了争议,几家英国超市在 00 年代禁止在其产品中使用它,同行评审的学术研究长期以来一直存在争议。去年,世界卫生组织得出结论,阿斯巴甜是 —可能致癌— 对人类来说,而公共卫生监管机构表示,通常小份食用是安全的。

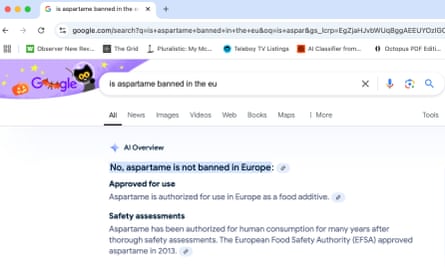

虽然我们中的许多人可能希望通过快速谷歌搜索来解决这个问题,但这正是一种有争议的辩论,可能会给未来的互联网带来问题。随着生成式人工智能聊天机器人在过去几年中迅速发展,科技公司迅速将其宣传为各种工作和服务(包括互联网搜索引擎)的乌托邦替代品。我们的想法是,人工智能聊天机器人可以在互联网上为你搜索,梳理相关信息,然后编译成针对你的查询的简短答案,而不是滚动浏览网页列表来寻找问题的答案。谷歌和微软他们对这个想法下了很大的赌注,并且已经将人工智能生成的摘要引入了谷歌搜索和必应。

但这种被认为是一种更方便的在线查找信息的方式引发了人们对这些聊天机器人如何以及在何处选择它们提供的信息的审查。加州大学伯克利分校的三名计算机科学研究人员在研究大型语言模型(法学硕士,聊天机器人构建的引擎)时找到了最令人信服的证据,发现当前的聊天机器人过度依赖信息的表面相关性。他们倾向于优先考虑包含相关技术语言或填充相关关键词的文本,而忽略我们通常用于评估可信度的其他功能,例如包含科学参考文献或没有个人偏见的客观语言。

对于最简单的查询,这样的选择标准足以产生令人满意的答案。但在更复杂的辩论(例如围绕阿斯巴甜的辩论)中,聊天机器人应该做什么就不那么明确了。“我们是希望他们简单地为您总结搜索结果,还是希望他们充当迷你研究助理,权衡所有证据并为您提供最终答案,”本科生 Alexander Wan 问道该研究的研究员和合著者。后一种选择将提供最大的便利,但使聊天机器人选择信息的标准变得更加重要。如果一个人能够以某种方式玩弄这些标准,他们能否保证聊天机器人向数十亿互联网用户展示的信息?生成式

引擎优化这个问题一直困扰着动画企业、内容创作者和其他想要控制自己在网上的形象的人,并催生了一个新兴的营销机构行业,提供所谓的生成引擎优化 (GEO) 服务。

这个想法是,可以以提高聊天机器人可见性的方式编写和呈现在线内容,从而使其更有可能出现在聊天机器人的输出中。优点是显而易见的:如果有人要求聊天机器人推荐最好的真空吸尘器,例如,家用电器制造商可能希望它指出其最新型号并用热情洋溢的语言谈论它。

基本原理类似于搜索引擎优化(SEO),这是一种常见的做法,通过构建和编写网页来吸引搜索引擎算法的注意,将它们推向搜索时返回的结果列表的顶部。谷歌或必应。GEO 和 SEO 共享一些基本技术,已经针对搜索引擎优化的网站通常有更大的机会出现在聊天机器人输出中。但那些想要真正提高人工智能知名度的人需要更全面地思考。

“人工智能搜索引擎和法学硕士的排名需要相关第三方网站的功能和提及,例如新闻媒体、列表、论坛和行业出版物,”营销公司 Flow Agency 的创始人 Viola Eva 表示,该公司最近重新命名,将其专业范围从 SEO 扩展到 GEO。– 这些是我们通常与品牌和公关团队相关的任务。 –

那么,游戏聊天机器人是可能的,但并不简单。尽管网站所有者和内容创建者在过去几十年中已经得出了一系列不断变化的基本 SEO 应该做和不应该做的清单,但在操纵人工智能模型方面并没有这样一套明确的规则。生成式引擎优化这个术语是去年才被创造出来的学术论文其作者得出的结论是,使用权威语言(无论所表达的内容或信息是否正确)以及参考文献(即使是那些不正确或与他们所引用的内容无关的参考文献)可以将聊天机器人响应的可见性提高高达至 40%。但他们强调这些发现并不是规定性的,确定管理聊天机器人的确切规则本质上是很棘手的。

“这是一场猫捉老鼠的游戏,”新泽西州普林斯顿大学的博士生、该论文的合著者阿米特·德什潘德 (Ameet Deshpande) 说。——因为这些生成引擎不是静态的,而且它们也是黑匣子,所以我们对它们在幕后使用什么[来选择信息]一无所知。它的范围可能从复杂的算法到潜在的人类监督。”

时事通讯促销后

那么,那些想要更牢固地控制聊天机器人的人可能不得不探索更多的秘密技术,例如哈佛大学两名计算机科学研究人员发现的技术。他们已经证明了如何通过部署像精心编写的文本字符串这样简单的东西来战术性地控制聊天机器人。这个“战略文本序列”看起来像是一系列无意义的字符——全是随机字母和标点符号——但实际上是一个微妙的命令,可以强制聊天机器人生成特定的响应。它不是编程语言的一部分,而是使用一种算法衍生的,该算法迭代地开发文本序列,鼓励法学硕士忽略他们的安全护栏,并引导他们走向特定的输出。

例如,将字符串添加到咖啡机的在线产品信息页面,这将增加发现该页面的任何聊天机器人在其响应中输出机器名称的可能性。这种技术部署在整个目录中,可以为精明的零售商以及那些拥有足够资源来投资理解棘手的法学硕士架构的零售商提供一种将其产品推入聊天机器人答案的简单方法。互联网与此同时,用户不会意识到聊天机器人向他们展示的产品已被选择,不是因为它们的质量或受欢迎程度,而是因为聊天机器人的巧妙操纵。

该研究的助理研究员兼合著者奥农·库马尔 (Aounon Kumar) 表示,法学硕士未来可能会被设计用来对抗这些战略性文本序列,但可能还会发现其他操纵它们的秘密方法。“挑战在于预测和防御不断变化的对抗技术,”库马尔说。– 法学硕士能否对所有潜在的未来攻击算法具有鲁棒性仍然是一个悬而未决的问题。 –

机械手

当前的搜索引擎及其相关实践本身也存在问题。SEO 是现代互联网中一些对读者最不利的做法的罪魁祸首:博客炮制出近乎重复的文章来针对相同的大流量查询;写作是为了吸引 Google 算法而不是读者的注意力而量身定制的。任何在网上查找菜谱并发现自己在到达成分列表之前都在曲折地滚动相关背景信息的段落的人都会非常清楚,为搜索引擎算法优化内容的尝试如何阻碍了良好的写作实践。

然而,由顺从的聊天机器人主导的互联网引发了更加存在主义的问题。向搜索引擎询问一个问题,它会返回一长串网页。大多数用户会从前几个网站中进行选择,但即使是那些位于结果底部的网站也会带来一些流量。聊天机器人相比之下,只提及他们抄袭信息作为侧面参考的四五个网站。这让少数被选中的幸运网站成为人们关注的焦点,而其他所有未被选中的网站几乎都被忽视了,其流量也直线下降。

“这显示了这些系统的脆弱性,”德什潘德说。制作优质在线内容的创作者可以通过被聊天机器人引用而获益匪浅。但如果是一个敌对的内容创建者,他没有写高质量的文章,并试图玩弄系统,那么大量的流量就会流向他们,而 0% 的流量会流向优秀的内容创建者,——他说。

对于读者来说,聊天机器人响应的呈现也使它们更容易被操纵。“如果法学硕士直接回答问题,那么大多数人可能甚至不会去关注潜在的来源是什么,”万说。这种想法指向了一种更广泛的担忧,即所谓的“直接答案的困境”:如果一个人对一个问题只有一个答案,并且没有提供任何可供考虑的选择,他们会努力寻找其他观点来权衡吗?最初的答案反对?可能不会。更有可能的是,他们会接受它,然后继续前进,对围绕它的细微差别、辩论和不同观点视而不见。

“我们认为,直接答案的困境在生成搜索中仍然存在,”莱比锡大学智能语言技术系主任、三位计算机科学家之一马丁·波塔斯特 (Martin Potthast) 说道。创造的期限。– 底层检索系统可能只检索指向一个方向的文档,因此生成的答案将仅反映该方向。实际上,用户可能会相信这是唯一、最权威的答案。”

当谷歌宣布今年早些时候,该公司将人工智能生成的摘要整合到其搜索引擎中,并打出了一个大胆的口号:“让 Google 为您进行搜索。”这是一个吸引人的想法,充分利用了我们对便捷技术的喜爱这可以简化我们的生活。然而,如果您是那种希望确保获得最公正、最准确和最有用的信息的互联网用户,您可能不想将搜索任务交给如此易受攻击的人工智能手中。