人工智能生成的图像和视频就在这里:它们如何影响研究?

作者:Kwon, Diana

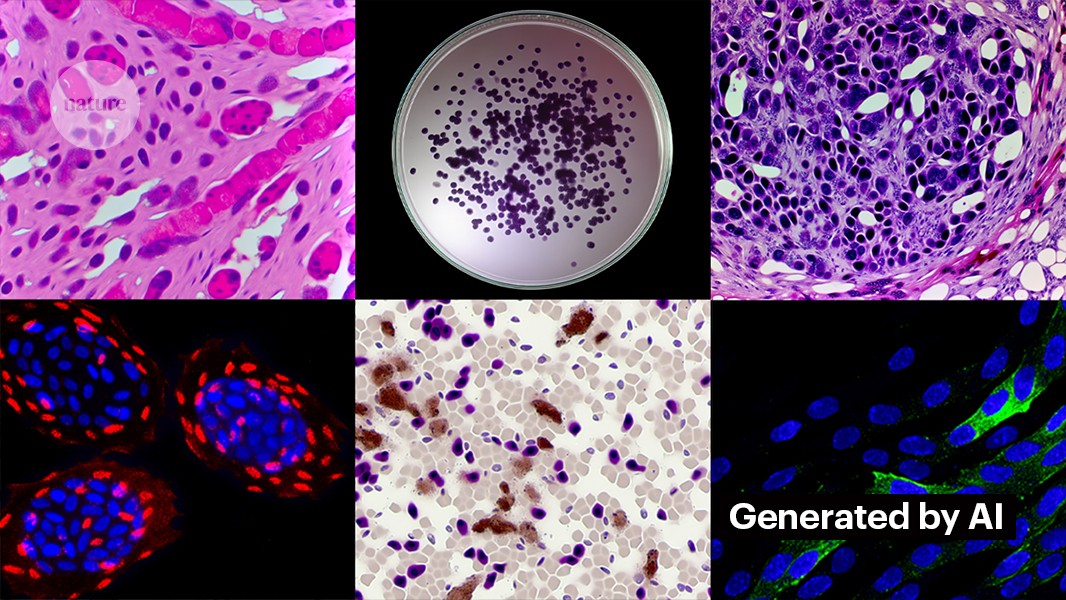

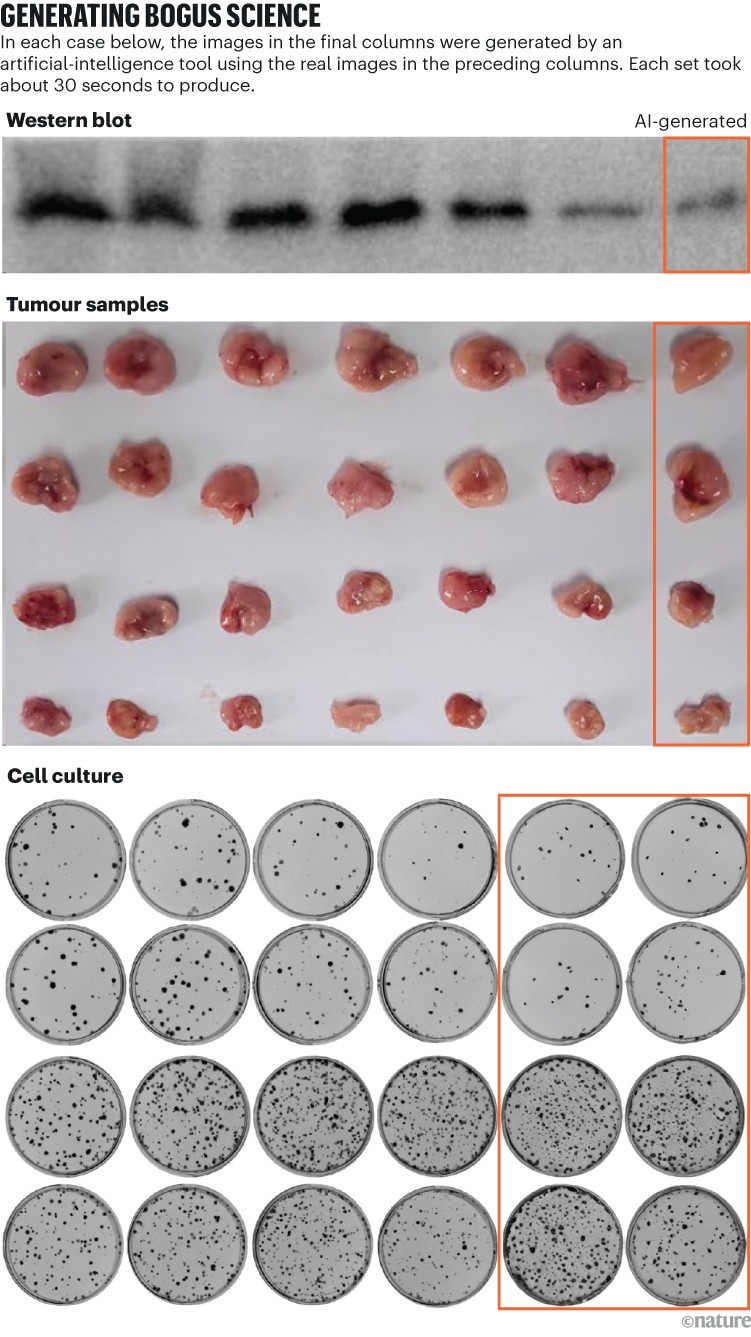

所有这些图像都是由人工智能生成的。图片来源:Proofig AI,2024

从科学家操纵数字到大规模生产假论文造纸厂,有问题的手稿长期困扰着学术文献。科学侦探孜孜不倦地工作揭露这种不当行为以纠正科学记录。但由于欺诈者引入了一种强大的新工具:生成式,他们的工作变得越来越困难人工智能(人工智能)。

“生成式人工智能发展非常快,”说贾娜·克里斯托弗,德国海德堡 FEBS Press 的图像完整性分析师。“在我的领域(形象诚信和出版道德)工作的人们越来越担心它提供的可能性。”

人工智能生成的图像和视频就在这里:它们如何影响研究?

轻松地生成式人工智能工具可以创建文本、图像和数据引发了人们对越来越不可信的科学文献的担忧,其中充斥着人类难以识别的虚假数据、手稿和结论。随着诚信专家、出版商和技术公司竞相争夺,一场军备竞赛已经开始开发人工智能工具可以帮助快速检测人工智能生成的论文中的欺骗性元素。

“这是一个可怕的发展,”克里斯托弗说。– 但也有人提出了一些聪明的人以及良好的结构性变革的建议。 –

研究诚信专家表示,尽管在某些情况下许多期刊已经允许人工智能生成文本,但使用此类工具创建图像或其他数据不太可能被视为可接受。“在不久的将来,我们可能会接受人工智能生成的文本,”说伊丽莎白·比克,加利福尼亚州旧金山的图像取证专家和顾问。– 但我在生成数据时划清了界限。 –

ChatGPT 和生成人工智能对科学意味着什么

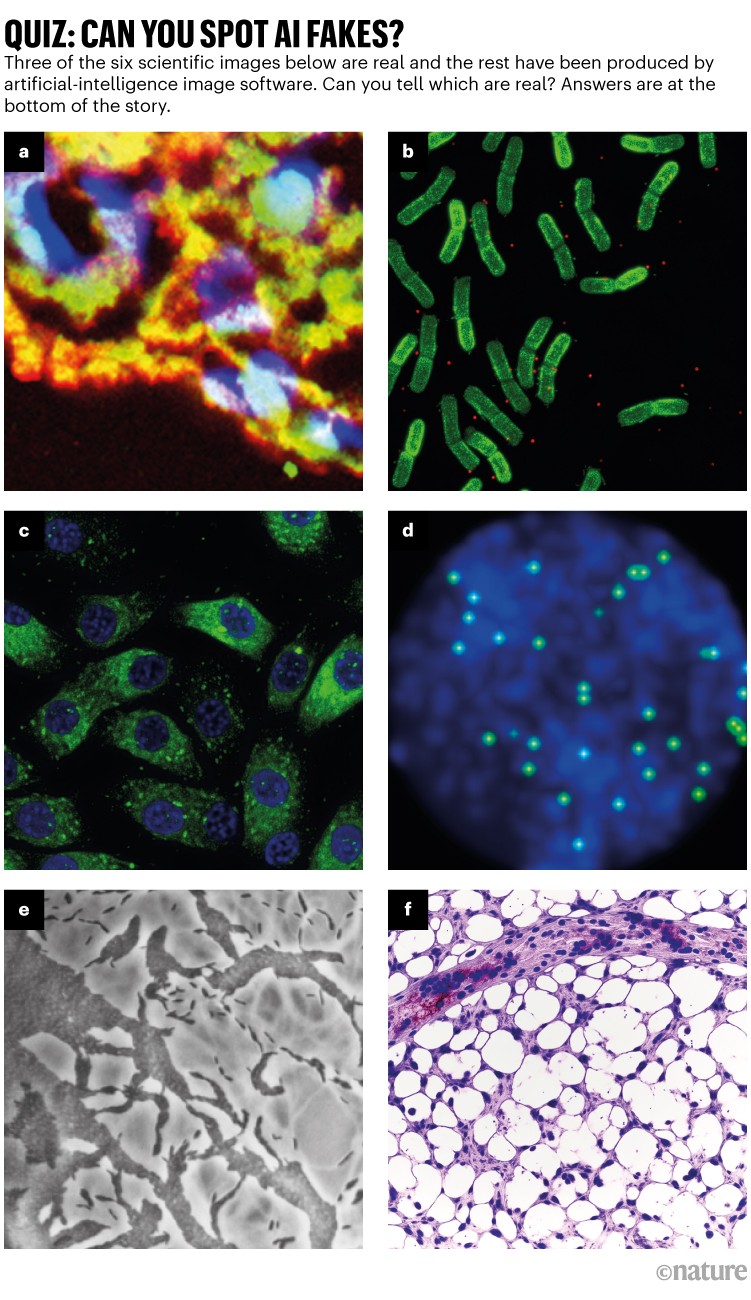

Bik、Christopher 和其他人怀疑,使用生成式 AI 制作的数据(包括图像)已经在文献中广泛存在,造纸厂正在利用 AI 工具批量生产手稿(参见“测验:你能发现 AI 赝品吗?”)?)。

精确定位人工智能生成的图像面临着巨大的挑战:它们通常几乎不可能与真实图像区分开来,至少用肉眼是不可能的。“我们感觉每天都会遇到人工智能生成的图像,”克里斯托弗说。“但是,只要您无法证明这一点,您就无能为力。”

在科学图像中使用生成式人工智能有一些明显的例子,例如现在臭名昭著的老鼠形象,其生殖器大得离谱和无意义的标签,使用图像工具 Midjourney 创建。这张图片于二月份由一家期刊发表,引发了社交媒体风暴,并被撤回几天后。

图片来源:Proofig(生成的图像)

大多数情况并不那么明显。在生成式人工智能兴起之前,用 Adobe Photoshop 或类似工具制作的图形(尤其是在分子和细胞生物学领域)通常包含侦探可以发现的明显迹象,例如相同的背景或异常缺乏涂片或污渍。人工智能制作的人物往往缺乏这样的迹象。“我看到大量的论文,我认为这些蛋白质印迹看起来并不真实,但没有确凿的证据,”Bik 说。“你只能说它们看起来很奇怪,这当然不足以给编辑写信。”

但有迹象表明,人工智能制作的人物正在出现在已发表的手稿中。使用 ChatGPT 等工具编写的文本在论文中呈上升趋势,这些文本是由作者忘记删除的标准聊天机器人短语泄露的,这些短语泄露了人工智能模型倾向于使用的单词。“所以我们必须假设数据和图像也会发生这种情况,”Bik 说。

欺诈者使用复杂图像工具的另一个线索是,侦探目前检测到的大多数问题都存在于几年前的论文中。“在过去的几年里,我们看到的形象问题越来越少,”比克说。“我认为大多数被抓到进行图像处理的人已经转向创建更清晰的图像。”

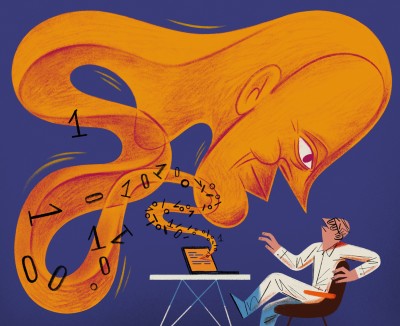

使用生成式人工智能创建干净的图像并不困难。Kevin Patrick 是一位在社交媒体上被称为 Cheshire 的科学图像侦探,他展示了它是多么容易,并将他的结果发布在 X 上。使用 Photoshop 的 AI 工具 Generative Fill,Patrick 创建了逼真的图像 - 可以实现出现在肿瘤、细胞培养、蛋白质印迹等领域的科学论文中。大多数图像的制作时间不到一分钟(请参阅“生成虚假科学”)。

“如果我能做到这一点,那些通过生成虚假数据获得报酬的人肯定也会这样做,”帕特里克说。“使用这样的工具可能会生成一大堆其他数据。”

一些出版商表示,他们在已发表的研究中发现了人工智能生成内容的证据。其中包括 PLoS,它已收到可疑内容的警报,并通过内部调查在论文和提交的材料中发现了人工智能生成的文本和数据的证据,旧金山 PLoS 出版道德团队的总编辑 Renée Hoch 表示,加利福尼亚州。(Hoch 指出,公共科学图书馆期刊并不禁止人工智能的使用,其人工智能政策侧重于作者责任和透明披露。)

图片来源:凯文·帕特里克

其他工具也可能为希望创建虚假内容的人提供机会。上个月,研究人员发表了1用于创建高分辨率显微图像的生成人工智能模型,一些诚信专家对这项工作表示担忧。“这项技术很容易被不怀好意的人利用,快速生成数百或数千张虚假图像,”Bik 说。

该工具的创建者、位于海法的以色列理工学院的 Yoav Shechtman 表示,该工具有助于为模型生成训练数据,因为很难获得高分辨率显微图像。但是,他补充说,它对于生成假货没有用,因为用户对输出几乎没有控制权。他建议,现有的成像软件(例如 Photoshop)对于处理图形更有用。

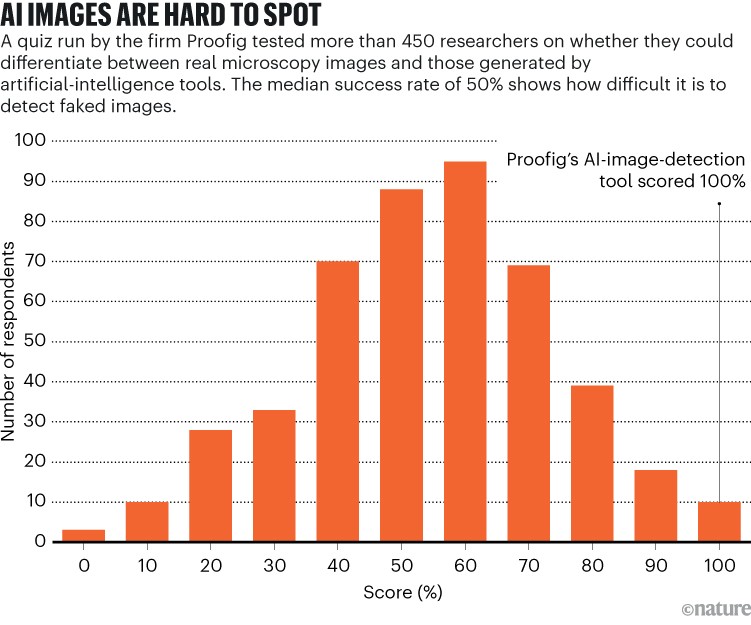

人眼可能看不到捕捉人工智能生成的图像,但人工智能可能会(请参阅“人工智能图像很难发现”)。

Imagetwin 和 Proofig 等工具背后的制造商正在扩展他们的软件,以淘汰由生成式人工智能创建的图像,这些工具使用人工智能来检测科学数据中的完整性问题。由于此类图像很难检测,因此两家公司都在创建自己的生成人工智能图像数据库来训练他们的算法。

人工智能模型输入人工智能生成的数据后,很快就会吐出无稽之谈

Proofig 已经在其工具中发布了一项功能,用于检测人工智能生成的显微图像。位于以色列雷霍沃特的公司联合创始人 Dror Kolodkin-Gal 表示,在对数千张 AI 生成的图像和论文中的真实图像进行测试时,该算法识别 AI 图像的准确率为 98%,误报率为 0.02%。德罗尔补充说,该团队现在正在努力了解他们的算法到底检测到了什么。

“我对这些工具抱有很大的希望,”克里斯托弗说。但她指出,他们的成果始终需要由能够验证他们标记的问题的专家进行评估。Christopher 尚未看到人工智能图像检测软件可靠的证据(Proofig 的内部评估尚未发布)。这些工具“有限,但肯定非常有用,因为这意味着我们可以加大筛选提交内容的力度”,她补充道。

来源:校对测验

多家出版商和研究机构已经使用打样和图像孪生。例如,《科学》杂志使用 Proofig 扫描图像完整性问题。梅根·费兰 (Meagan Phelan) 表示,科学在华盛顿特区,该工具尚未发现任何人工智能生成的图像。施普林格自然出版社

自然正在开发自己的文本和图像检测工具,称为 Geppetto 和 SnapShot,它们会标记不规则之处,然后由人类进行评估。(这自然新闻团队在编辑上独立于其出版商。)

出版集团也在采取措施解决人工智能图像的问题。英国牛津国际科学、技术和医学出版商协会 (STM) 的一位发言人表示,该协会正在“非常严肃地”对待这个问题,并指出了以下举措:联合行动和 STM 完整性中心,它们是对付造纸厂以及其他科学诚信问题。

ChatGPT 一周年:谁在使用它、如何使用以及为什么?

Christopher 是图像更改和复制 STM 工作组的主席,他表示,人们越来越认识到,需要开发验证原始数据的方法,例如使用类似于水印的隐形水印标记从显微镜拍摄的图像。人工智能生成文本中使用的内容– 可能是前进的方向。她补充道,这将需要设备制造商采用新技术和新标准。

帕特里克和其他人担心出版商不会迅速采取行动来应对这一威胁。“我们担心这将成为文献中的又一代问题,直到为时已晚,”他说。

尽管如此,一些人仍然乐观地认为,今天出现在报纸上的人工智能生成的内容将在未来被发现。

“我完全相信,技术将会进步到可以检测今天正在完成的事情的程度,因为在某些时候,它会被视为相对粗糙,”帕特里克说。– 诈骗者晚上不应该睡好觉。他们可以愚弄今天的流程,但我不认为他们能够永远愚弄这个流程。”

测验答案:图像一个,d和e来自真实的科学论文。图片乙,c和f由 Proofig 的人工智能软件生成。