由于中国实体无法获得像英伟达这样的公司提供的数万个先进的人工智能 GPU,因此该国的公司必须进行创新来训练其先进的人工智能模型。李开复,创始人兼掌门人 01.ai本周表示,他的公司仅花费 300 万美元就使用 2,000 个 GPU 训练了其先进的人工智能模型。

“令我在硅谷的朋友们震惊的不仅仅是我们的表现,而是我们只用了 300 万美元训练模型,而 GPT-4 的训练花费了 80 到 1 亿美元,”李开复说道(通过 @tsarnick)。据传 GPT-5 的训练费用约为 10 亿美元。[…] 我们相信比例定律,但当你进行出色的详细工程时,情况并非如此。[……] 作为一家中国公司,首先,由于美国法规的限制(以及与美国人工智能公司相比的估值劣势),我们获得 GPU 的机会有限。

据李开复介绍,OpenAI 等竞争对手花费了 80-1 亿美元来训练 GPT-4,据报道花费了 10 亿美元来训练 GPT-5,而 01.ai 只花费了 300 万美元来训练其高性能模型。根据公司网站图表,01.ai 的 Yi-Lightning 在加州大学伯克利分校 LMSIS 衡量的模型性能中排名第六。

当然,由于该公司令人印象深刻的成本效益,这一成就尤其引人注目。明显的差异表明,实现顶级人工智能功能并不总是需要大量预算,因为仔细的工程和有针对性的优化可以以一小部分成本和计算资源产生类似的结果。

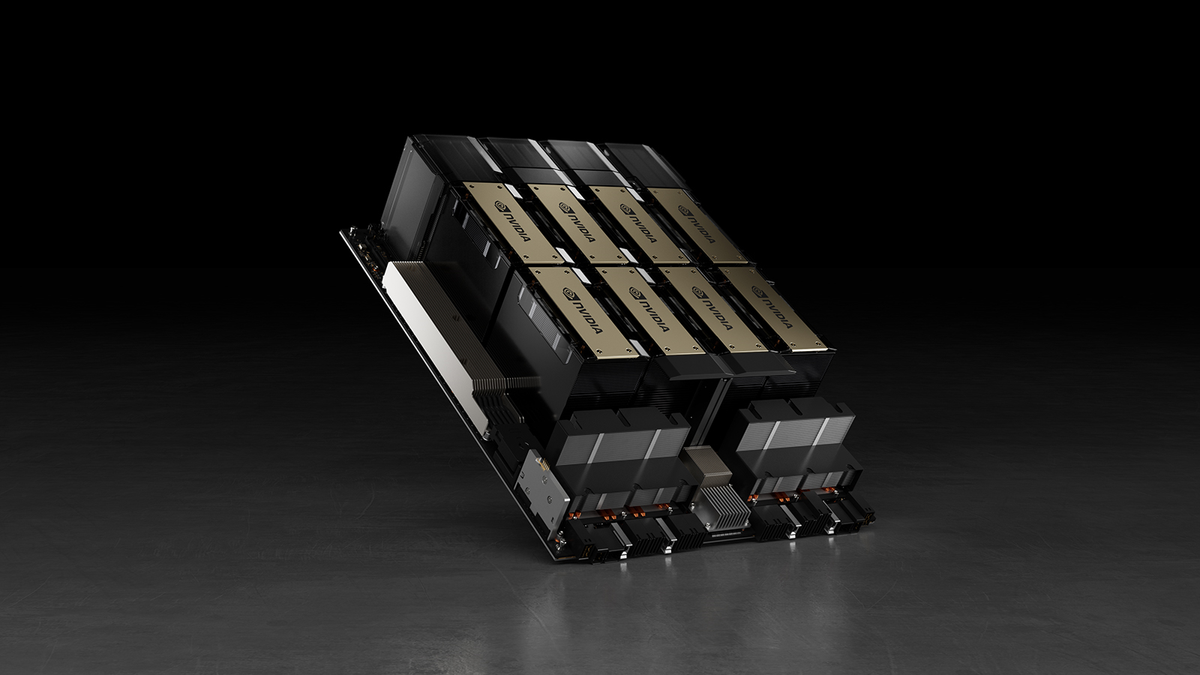

据信 OpenAI 使用了 10,000 个 NvidiaA100用于训练 GPT-3 模型等的 GPUH100处理器来训练其 GPT-4 和 GPT-4o 模型。使用各种创新解决方案,01.ai 必须使用 2,000 个未公开的 GPU 来训练其 Yi-Lightning 模型。然而,去年李开复表示他的公司 有足够的 GPU 来执行 1.5 年的路线图。然而,这些数字并不能相加。一个 Nvidia H100 GPU 的成本约为 30,000 美元,因此两千个此类 GPU 的成本将达到 600 万美元。

为了提高模型性能,01.ai专注于减少推理过程中的瓶颈,将计算需求转化为面向内存的任务,构建多层缓存系统,并设计专门的推理引擎来优化速度和资源分配。因此,ZeroOne.ai 的推理成本显着低于类似模型 - 每百万代币 10 美分 - 约为可比模型典型收费率的 1/30。

“当我们只有 2000 个 GPU 时,团队必须弄清楚如何使用它,”李开复说。– 作为首席执行官,我必须弄清楚如何确定优先级,然后我们不仅必须快速进行训练,而且还必须快速进行推理。所以,我们的推理是通过试图将计算问题转化为内存问题、通过构建多层缓存、通过构建特定的推理引擎等等来找出整个过程中的瓶颈。但底线是,我们的推理成本是每百万代币 10 美分。”

总体而言,中国企业,尤其是01.ai,面临着重大挑战。由于美国的出口限制,他们获得先进 GPU 的机会很少。与美国人工智能公司相比,它们还存在估值劣势,这影响了它们的可用资源和投资机会。