Cerebras 让 Meta 的 Llama 3.1 405B 大型语言模型以每秒 969 个令牌的速度运行,比之前快了 75 倍亚马逊Web Services 最快的 GPU 人工智能服务可能会集结起来。

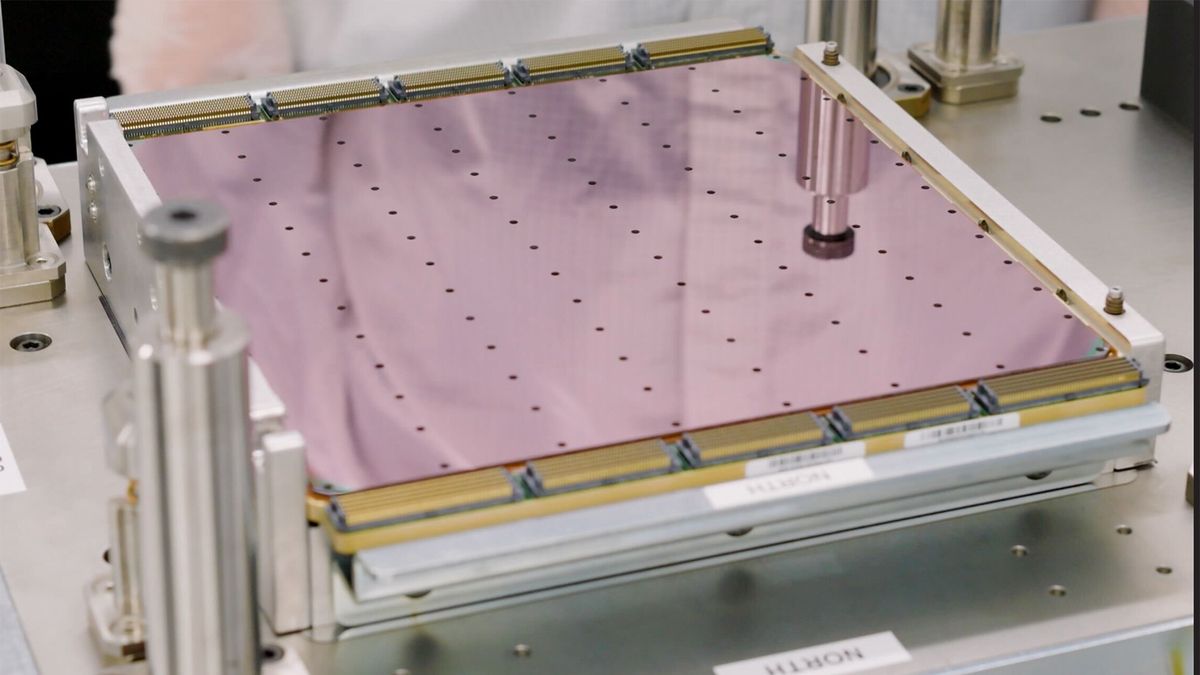

法学硕士在 Cerebras 的云 AI 服务 Cerebras Inference 上运行,该服务使用该芯片公司的第三代晶圆级发动机而不是 Nvidia 或 AMD 的 GPU。Cerebras 一直声称其推理服务是生成令牌(构成法学硕士响应的各个部分)最快的服务。第一次的时候推出8 月,Cerebras Inference 据称比 Llama 3.1 8B 和 Llama 3.1 70B 中通过 Amazon Web Services 等云提供商运行的 Nvidia GPU 快约 20 倍。

但自 7 月以来,Meta 提供了 Llama 3.1 405B,其拥有 4050 亿个参数,使其成为比拥有 700 亿个参数的 Llama 3.1 70B 更重的模型。大脑说其 Wafer Scale Engine 处理器可以“即时速度”运行这个大规模的 LLM,令牌速率为每秒 969 个,首次令牌时间仅为 0.24 秒;据该公司称,这是一项世界纪录,不仅是其芯片,还包括 Llama 3.1 405B 型号。

与从 AWS 租用的 Nvidia GPU 相比,Cerebras Inference 的速度显然快了 75 倍;Wafer Scale Engine 芯片的速度甚至比 Together AI 最快的 Nvidia GPU 还要快 12 倍。其最接近的竞争对手、人工智能处理器设计商 SambaNova 被 Cerebras Inference 击败了 6 倍。

为了说明其速度有多快,Cerebras 促使 Fireworks(最快的配备 GPU 的 AI 云服务)和 Inference 用 Python 创建一个国际象棋程序。Cerebras Inference 大约需要 3 秒,而 Fireworks 则需要 20 秒。

以下是即时 405B 的样子:Cerebras 与最快的 GPU 云:pic.twitter.com/d49pJmh3yT2024 年 11 月 18 日

“Cerebras 上的 Llama 3.1 405B 是迄今为止世界上最快的前沿模型,比 GPT-4o 快 12 倍,比 Claude 3.5 Sonnet 快 18 倍,”Cerebras 表示。– 得益于 Meta 的开放方法和 Cerebras 突破性推理技术的结合,Llama 3.1-405B 现在的运行速度比封闭前沿模型快 10 倍以上。 –

即使将查询大小从 1,000 个令牌增加到 100,000 个令牌(提示至少由几千个单词组成),Cerebras Inference 显然仍以每秒 539 个令牌的速度运行。在甚至可以运行此工作负载的其他五个服务中,最好的服务每秒仅收集 49 个令牌。

Cerebras 还吹嘘说,在分子动力学模拟中,仅一个第二代 Wafer Scale Engine 的性能就比 Frontier 超级计算机高出 768 倍。Frontier 曾是世界上最快的超级计算机直到周一 El Capitan 超级计算机推出,拥有 9,472 个 AMD 的 Epyc CPU。

此外,Cerebras 芯片的性能比 Anton 3 超级计算机高出 20%,考虑到 Anton 3 是为分子动力学而构建的,这是一项重大成就;其每秒 110 万个模拟步骤的性能也是计算机首次突破百万模拟步骤的障碍。