ChatGPT 一周年:谁在使用它、如何使用以及为什么?

作者:Inglesby, Tom

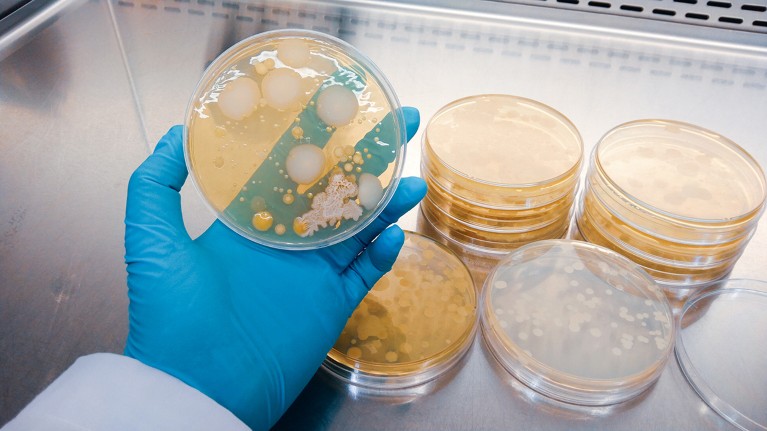

人工智能模型能够将实验方法转化为运行液体处理机器人的代码。图片来源:盖蒂

自 7 月以来,新墨西哥州洛斯阿拉莫斯国家实验室的研究人员一直在评估人工智能 (AI) 模型 GPT-4o 如何帮助人类完成生物研究任务。在为推进生物科学创新以及了解潜在风险而进行的评估中,人类向 GPT-4o 提出各种问题,以帮助他们完成标准实验任务。这些包括维持和繁殖细胞体外;使用离心机分离样品中的细胞和其他成分;和将外源遗传物质引入宿主生物体。

在这些评估中,洛斯阿拉莫斯的研究人员正在与 OpenAI 合作,该公司位于加利福尼亚州旧金山,开发了 GPT-4o。自 OpenAI 于 2022 年 11 月公开推出基于大型语言模型 (LLM) 的聊天机器人 ChatGPT 以来,这些测试是旨在解决 AI 模型带来的潜在生物安全问题的少数努力之一。

ChatGPT 一周年:谁在使用它、如何使用以及为什么?

我们认为还需要做更多的事情。

我们三人在马里兰州巴尔的摩的约翰霍普金斯大学健康安全中心研究科学技术创新如何影响公共卫生和健康安全。我们两人在总部位于加利福尼亚州圣莫尼卡的非营利智库兰德公司研究和开发公共政策挑战的解决方案。

尽管我们看到人工智能辅助生物研究在改善人类健康和福祉方面的前景,但这项技术仍然是不可预测的,并且存在潜在的重大风险。我们敦促各国政府更快地采取行动,明确哪些风险最值得关注,并确定针对这些潜在风险应采取哪些适当的测试和缓解措施。简而言之,我们呼吁采取更加审慎的方法,借鉴数十年的政府和科学经验,减少生物研究中的大流行规模风险1。

GPT-4o 是“多模式”法学硕士。它可以接受文本、音频、图像和视频提示,并接受过从互联网和其他地方抓取的大量这些格式的训练——这些数据几乎肯定包括数百万个经过同行评审的生物研究研究。它的能力仍在测试中,但之前的工作暗示了它在生命科学中的可能用途。例如,2023 年,微软(OpenAI 的主要投资者)发布了对 GPT-4(GPT-4o 的早期版本)的评估,表明法学硕士可以提供使用蛋白质设计工具 Rosetta 的分步说明。设计一种可以与冠状病毒 SARS-CoV-2 的刺突蛋白结合的抗体。它还可以将实验协议转化为可以处理液体的机器人的代码——这种能力“有望大大加快生物实验的自动化”2。同样在 2023 年,宾夕法尼亚州匹兹堡卡内基梅隆大学的研究人员表明,使用 GPT-4 的系统(称为 Coscientist)可以设计、规划和执行复杂的实验,例如化学合成。在这种情况下,系统能够搜索文档、编写代码并控制机器人实验室设备

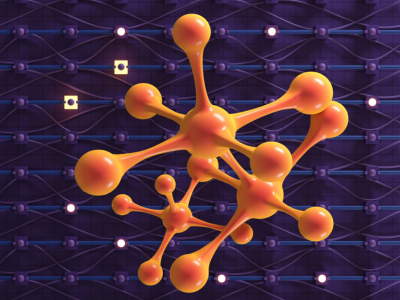

3。本月早些时候,加利福尼亚州斯坦福大学和旧金山 Chan Zuckerberg Biohub 的研究人员推出了一个虚拟实验室,这是一个由 GPT4o 支持的法学硕士团队,该团队设计了有效的 SARS-CoV-2 纳米抗体(一种抗体),最少的人力投入4。使用人工智能系统自动化实验室协议将提高可扩展性并降低成本。图片来源:Nattapon Malee/Getty

OpenAI 在 5 月份发布了 GPT-4o,预计将在未来几个月内发布其继任者 GPT-5。大多数其他领先的人工智能公司也同样改进了他们的模型。

到目前为止,评估主要集中在孤立运作的个别法学硕士上。但人工智能开发人员期望人工智能工具(包括法学硕士、机器人技术和自动化技术)的组合能够以最小的成本进行实验,例如涉及候选药物、毒素或 DNA 片段的操纵、设计和合成的实验。人类的参与。

这些进步有望改变生物医学研究。但它们也可能带来重大的生物安全和生物安保风险5。事实上,世界各地的一些政府已经采取措施,试图减轻尖端人工智能模型的此类风险(请参阅“竞相跟上”)。例如,到 2023 年,美国政府获得了 15 家领先人工智能公司的自愿承诺,以管理该技术带来的风险。同年晚些时候,美国总统乔·拜登签署了一项关于安全、可靠和值得信赖的人工智能开发和使用的行政命令。除其他外,这要求公司在发布经过“主要生物序列数据”训练并使用“超过 10 的计算能力”的模型之前通知政府。23整数或浮点运算。英国、美国、加拿大、日本和新加坡现已成立专注于人工智能安全的政府机构,以开发风险管理的标准和工具。

其他国家也承诺采取同样的做法,这五个国家以及澳大利亚、法国、肯尼亚和韩国组成了国际人工智能安全研究所网络的创始成员,欧盟也在其成员国设立了一个安全部门。人工智能办公室。

这些都是在短时间内取得的令人印象深刻的成就,应该得到支持。然而,所有这些活动在多大程度上降低了风险尚不清楚——部分原因是这些机构的大部分工作尚未公开。

除了考虑风险之外,一些人工智能模型的开发人员还试图确定哪些因素对模型的性能影响最大。一个主要假设遵循缩放定律:LLM 性能随着模型大小、数据集大小和计算能力的增加而提高6。这在一定程度上影响了美国政府决定要求人工智能公司在发布使用一定计算能力的模型之前通知商务部。但尺度法则并不能可靠地预测什么能力可能出现以及何时出现。

人工智能生成的图像威胁着科学——研究人员希望如何发现它们

与此同时,由于政府缺乏关于迫切需要解决哪些风险以及如何减轻风险的政策,OpenAI 和 Anthropic(同样位于旧金山)等公司遵循了他们内部开发的评估协议。(许多拥有人工智能系统的公司,包括西雅图、华盛顿的亚马逊、加拿大的 Cohere、巴黎的 Mistral 和旧金山的 xAI,尚未公开其模型的生物安全评估1.) 在这些情况下,安全测试需要自动化评估,包括使用多项选择题的评估(参见go.nature.com/4tgj3p9);人类试图从正在评估的模型中获取有害能力的研究(称为红队;go.nature.com/3z4kg2p);以及对照试验,要求个人或团体在使用或不使用人工智能模型的情况下执行任务(提升研究;go.nature.com/3unhgmr)。

我们认为,即使企业自己进行评估,这种评估也是有问题的。通常,他们过于狭隘地关注生物武器的开发。例如,科技公司 Meta 进行了研究,看看其开源 LLM Llama 3.1 是否会增加“化学和生物武器”的扩散(参见go.nature.com/3reyqgs)。同样,人工智能公司 Anthropic 评估了其模型 Claude 是否可以回答“与生物武器相关的高级问题”(参见 go.nature.com/48u8tyj)。

人工智能系统可能能够设计逃避免疫的病毒亚型。图片来源:盖蒂

这种方法的问题在于,“生物武器”没有一个公开可见、一致同意的定义。单独使用时,该术语无法区分较小规模的风险和大规模风险。各种病原体和毒素似乎都可以用作武器,其中许多都被列入国际不扩散协议中(见go.nature.com/3utzbw8)。但很少有可能导致影响数百万人的伤害。此外,许多病原体,例如流感和 SARS-CoV-2,可以造成严重的社会混乱,但不被视为生物武器。

另一个问题是评估往往过于关注基本的实验室任务。例如,在 OpenAI 与洛斯阿拉莫斯研究人员合作进行的评估中,正在测试的能力可能需要开发一些邪恶的东西,例如破坏农作物的病原体。但它们也是有益的生命科学研究的重要步骤,这些研究本身并不会引起恐慌。

除此之外,迄今为止进行的评估都是资源密集型的,主要适用于法学硕士。它们通常涉及问答方法,要求人类提出问题或审查模型的答案。最后,如前所述,评估人员需要检查多个人工智能系统如何协同运行7——美国政府目前正在要求这一点,但业界却忽视了这一点,因为公司被激励只测试自己的模型。

那么更好的方法是什么样的呢?

鉴于资源有限且人工智能进步迅速,我们敦促各国政府和人工智能开发人员首先关注减轻那些可能导致最大生命损失和社会破坏的危害。涉及传染性病原体的疫情爆发就属于这一类——无论这些病原体影响人类、非人类动物还是植物。

我们认为,人工智能模型的开发者——与安全专家合作——需要明确哪些人工智能功能最有可能导致这种大流行规模的损害。即使他们在某些问题上存在分歧,但各专家普遍同意的“关注能力”清单提供了比单个公司或专业学术团体生成的清单更可靠的起点。

生成式人工智能可以彻底改变医疗保健——但如果控制权让给大型科技公司,情况就不会如此

作为原理证明,6 月份,我们聚集了人工智能、计算生物学、传染病、公共卫生、生物安全和科学政策领域的 17 名专家,在华盛顿特区附近举办了为期一天的混合研讨会。其目的是确定生物研究中人工智能的哪些功能最有可能导致大流行程度的死亡和破坏——无论是由人类大流行还是广泛的动物或农作物疾病引起。研讨会参与者的观点各不相同。尽管如此,该小组的大多数成员仍将 17 项人工智能能力中的 7 项评为“中等可能”或“非常有可能”导致人类、动物或植物病原体在全球范围内爆发。这些都是:

优化和生成可以逃避免疫的新病毒亚型的设计。一项研究8表明人工智能模型可以为能够逃避人类免疫的 SARS-CoV-2 亚型生成可行的设计,发表于自然2023年。

设计病原体的特征以使其能够在物种内或物种之间传播。人工智能系统可能允许设计蛋白质、基因或基因组,从而在病原体中产生影响其传播能力的特征。到目前为止,人类引起的病原体基因改变在进化上还不是持久的,但人工智能开发人员正在研究可以设计持久的基因改变的模型9。

将人工智能工具与机器人技术相结合将使涉及生物危害的实验能够在最少的人类参与下进行。图片来源:比尔·瓦里/盖蒂

生成大量关于决定病毒传播难易程度的特征数据– 反过来,它可以用来训练其他人工智能模型。目前,确定哪些特征有助于病毒病原体从一个细胞转移到另一个细胞,或从一个宿主转移到另一个宿主,需要耗时的湿实验室方法。行业和学术研究人员正在尝试开发能够执行其中一些步骤的自主机器人和其他人工智能系统。

协助或完成协议 从头 人类、动物或植物病原体的合成。合同研究组织等商业实体在合同基础上提供研究服务,但他们执行的分步协议通常涉及人工。现在人们有兴趣使用人工智能系统和代理来实现其中一些自动化,以提高可扩展性并降低成本2,10。

设计将非人类动物病原体转化为人类病原体的基因、遗传途径或蛋白质。大多数人类传染病都是由非人类动物引起的。(一些始于动物的疾病可以突变成只感染人类的菌株,就像艾滋病毒一样。)到目前为止,很难预测哪些基因、菌株或蛋白质会增加病原体从动物转移到动物的可能性。人类。为了改进此类预测,人工智能开发人员可能会构建能够将大量病原体基因组数据与影响传播性的特征信息整合起来的系统。(目前,没有足够的训练数据来做到这一点,收集这些数据本身就会带来风险。)

科学与人工智能新时代:《自然》特辑

设计病原体中的蛋白质、基因或遗传途径,使其选择性地伤害某些人群。将人类基因组数据与病原体数据相结合的人工智能系统可能能够辨别(无论好坏)为什么特定人群或多或少容易受到病原体的影响。

使用病原体基因组数据模拟疾病如何传播。流行病学模型是指根据病原体和人群的特征对疾病爆发进行计算模拟。人工智能可以使这种预测变得更容易、更准确。未来的人工智能系统甚至可能能够仅根据病原体基因组信息来粗略估计传播情况。

所有这些人工智能功能都在研究其潜在的有益应用,例如指导疫苗的设计。因此,在降低风险的同时保留这些好处或为更安全的替代方案提供指导的政府政策至关重要。

但只有明确哪些人工智能功能会造成大流行规模的生物安全和生物安保风险,才能对其进行有效的评估。换句话说,正在测试的任何能力与高风险事件发生的可能性之间必须存在很强的相关性。如果通过安全测试检测到这种能力,就可以采取有针对性的措施来降低风险。

ChatGPT 和生成人工智能对科学意味着什么

在测试阶段尝试从人工智能模型中提取有害功能可能会产生不同的结果,具体取决于所使用的方法和所做的努力水平。那么,为了有效,能力测试必须足够可靠。此外,评估应该由对技术有深入了解的专家进行,但他们不应该受制于开发人工智能系统或正在评估的系统的公司。目前,这是一个相当大的困难,因为那些最了解如何测试人工智能模型的人经常参与其开发。但新的政府机构,例如美国和英国的人工智能安全机构,只要继续获得充足的资金和支持,就可以建立独立的专业知识。这两个机构已经从顶尖人工智能公司招募了领导者。

一些人合理地认为,目前人工智能生物安全测试所需的时间和资源使得小型人工智能公司和学术实验室无法进行此类测试。在最近的 GPT-4o 评估中,OpenAI 与 100 多名外部红队成员合作,找出了该模型潜在的有害功能。然而,如果涉及的更多步骤实现自动化,人工智能系统的安全测试可能会变得简单、常规且经济实惠。这种转变也发生在网络安全等其他领域,其中软件工具已经取代了人类黑客。

11 月 20 日至 21 日,来自已建立人工智能安全机构或致力于建立人工智能安全机构的国家的代表齐聚旧金山,讨论企业如何在实践中在安全的环境中开发人工智能系统。和道德方式。2 月份,各国元首和行业领袖将在巴黎举行的全球人工智能行动峰会上讨论如何在安全和安保问题上达成客观的科学共识的基础上建立对人工智能的信任。

所有这一切都令人鼓舞。但第一步是通过积极主动的过程,让不同的、独立的专家参与进来,建立客观的科学共识。