当我们将人类特征归因于动物或机器等非人类实体时,拟人化就会发生。聊天机器人,例如聊天GPT、Gemini 和 Copilot 通过模仿人类语言与我们交流,超越仅仅使用熟悉的单词和短语,采用人类的交流模式来鼓励这一点。通过这样做,他们能够进行情境化、连贯的对话,甚至可以展示幽默和同理心等情绪。

这些系统使用的语言旨在使与它们的交互感觉自然、流畅且易于理解。它方便了它们在不同情况下的使用,从客户服务到教育和娱乐。

到目前为止,语言被认为是人类独特的能力。然而,为这些聊天机器人提供支持的生成人工智能(AI)的进步迫使我们重新考虑这个想法。

人类语言最显着的特征之一是主观性,它体现在传达情感细微差别的词语或表达方式以及个人观点的表达中。它还包括形成对事件的看法,以及情境或文化元素的使用。

第一人称:“我”和“我们”

人类语言主体性的一个典型特征是人称代词的使用。第一人称“我”或“我们”让我们能够表达个人的想法和经历。第二人称——你——与对方互动,在对话的两个参与者之间建立关系。这被称为主体间性。

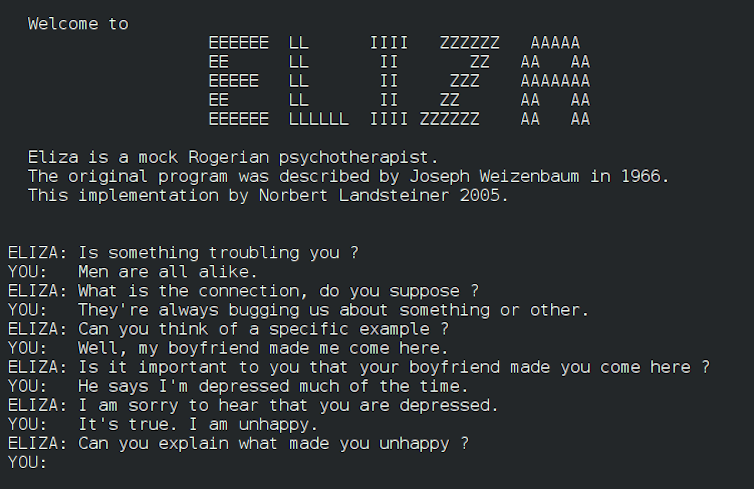

让我们看一个相对简单的例子:

用户:——我正在整理我的家。我如何决定保留、捐赠或扔掉哪些物品?

聊天机器人: – 好问题!整理您的物品可能会让人不知所措,但通过明确的策略,您可以更轻松地做出这些决定。以下是一些决定保留、捐赠或扔掉什么的想法。 –

聊天机器人隐式使用第一人称。虽然它没有说“我”或“我”,但它扮演了顾问或指南的角色,并且诸如“这里有一些想法”之类的短语将这些想法呈现为聊天机器人。自己的。

聊天机器人扮演了帮助者的角色,这意味着即使没有明确使用第一人称,用户也会感觉自己正在被单独称呼。此外,“这里是”的使用强化了聊天机器人作为提供有价值东西的人的形象。

阅读更多:我们向 ChatGPT 寻求法律建议 – 以下是您不应该这样做的五个原因

第二人称:“你”的力量

“您”(以及“您的”等其他形式)直接称呼用户。我们可以在前面示例的几个部分中看到这一点,例如短语“组织”你的财物 – 和 –你可以让这些决定变得更容易。通过以个人方式与您交谈,聊天机器人旨在让读者感觉他们正在积极参与对话,这种语言在试图让他人感到积极参与的文本中很常见。其他短语,例如“好问题!”不仅可以给用户的请求留下积极的印象,还可以鼓励他们参与。

像“整理你的物品可能会让人不知所措”这样的短语暗示着一种共享的体验,通过承认用户的情绪来创造一种同理心的错觉。

阅读更多:

ChatGPT 现在比以往任何时候都更擅长伪造人类情感和行为人工同理心

聊天机器人使用第一人称来模拟意识,并试图创造一种同理心的错觉。

通过采用助手位置并使用第二人称,它可以吸引用户并增强亲密感。这种组合产生了一种感觉人性化、实用且适合提供建议的对话,尽管它的同理心来自算法,而不是来自真正的理解。

习惯与模拟身份和个性的无意识实体互动可能会产生长期影响,因为这些互动会影响我们的个人、社会和文化生活。随着这些技术的进步,区分真人对话和人工智能系统对话将变得越来越困难。

人类与人工之间日益模糊的界限影响着我们如何理解沟通中的真实性、同理心和有意识的存在。我们甚至可能会将人工智能聊天机器人视为有意识的生物,从而对它们的真实能力产生困惑。

与其他人交谈有困难

与机器的交互也可以改变我们对人际关系的期望。当我们习惯了快速、无缝、无冲突的互动时,我们可能会在与真实的人的关系中变得更加沮丧。

人与人之间的互动因情感、误解和复杂性而充满色彩。从长远来看,与聊天机器人的反复互动可能会削弱我们处理冲突和接受人际互动中自然缺陷的耐心和能力。

此外,长时间接触模拟的人类互动会引发伦理和哲学困境。通过将人类品质归因于这些实体(例如感受或有意图的能力),我们可能会开始质疑有意识生活与完美模拟的价值。这可能会引发关于机器人权利和价值人类意识。

与模仿人类身份的无感知实体互动可以改变我们对沟通、关系和身份的看法。虽然这些技术可以提供更高的效率,但必须意识到它们的局限性以及对我们与机器和彼此之间交互方式的潜在影响。