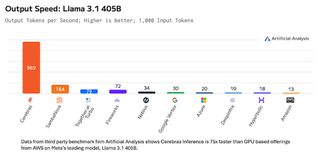

- Cerebras 在 Llama 3.1 405B 上达到每秒 969 个令牌,比 AWS 快 75 倍

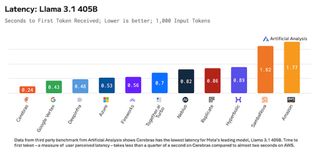

- 声称业界最低的 240 毫秒延迟,速度是 Google Vertex 的两倍

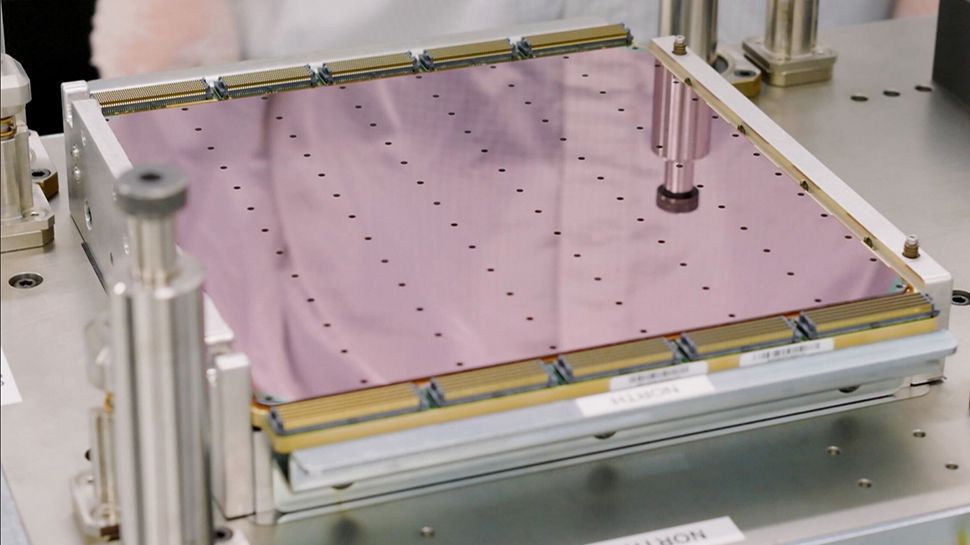

- Cerebras Inference 在带有 WSE-3 AI 处理器的 CS-3 上运行

Cerebras Systems 表示,它通过 Meta 的 Llama 3.1 405B 模型树立了人工智能性能的新基准,实现了前所未有的每秒 969 个代币的生成速度。

第三方基准测试公司 Artificial Analysis 声称,这种性能比主要超大规模提供商基于 GPU 的产品快 75 倍。它比 SambaNova 快近六倍(每秒 164 个令牌),比 SambaNova 快 14 倍以上谷歌Vertex 每秒 30 个令牌,远远超过每秒 20 个令牌的 Azure 和每秒 13 个令牌的 AWS。

此外,该系统还展示了世界上最快的第一个代币生成时间,只需 240 毫秒,几乎是 Google Vertex 430 毫秒的两倍,远远领先于 AWS 的 1,770 毫秒。

扩大领先优势

“Cerebras 保持着 Llama 3.1 8B 和 70B 性能的世界纪录,通过这一公告,我们将领先优势扩大到 Llama 3.1 405B - 每秒交付 969 个代币,”Cerebras 联合创始人兼首席执行官 Andrew Feldman 指出大脑。

“通过即时运行最大的模型,Cerebras 能够实现世界领先的开放前沿模型的实时响应。这在整个人工智能领域开辟了强大的新用例,包括推理和多代理协作。”¤

Cerebras 推理系统由 CS-3 超级计算机及其 Wafer Scale Engine 3 (WSE-3) 提供支持,支持 16 位精度的完整 128K 上下文长度。WSE-3 被称为“世界上最快的 AI 芯片”,具有 44GB 片上 SRAM、4 万亿个晶体管和 900,000 个 AI 优化内核。它提供 125 petaflops 的峰值 AI 性能,内存带宽是同类产品的 7,000 倍。英伟达H100。

Meta 的 GenAI 副总裁 Ahmad Al-Dahle 也赞扬了 Cerebras 的最新成果,他表示:“扩展推理对于加速人工智能和开源创新至关重要。”得益于 Cerebras 团队的出色工作,Llama 3.1 405B 现在成为世界上最快的前沿型号。借助 Llama 的强大功能和我们的开放方法,现在比以往任何时候都可以为更多的开发人员提供超快速且经济实惠的推理。

该系统的客户试用正在进行中,预计于 2025 年第一季度全面上市。起价为每百万个输入代币 6 美元,每百万个输出代币 12 美元。