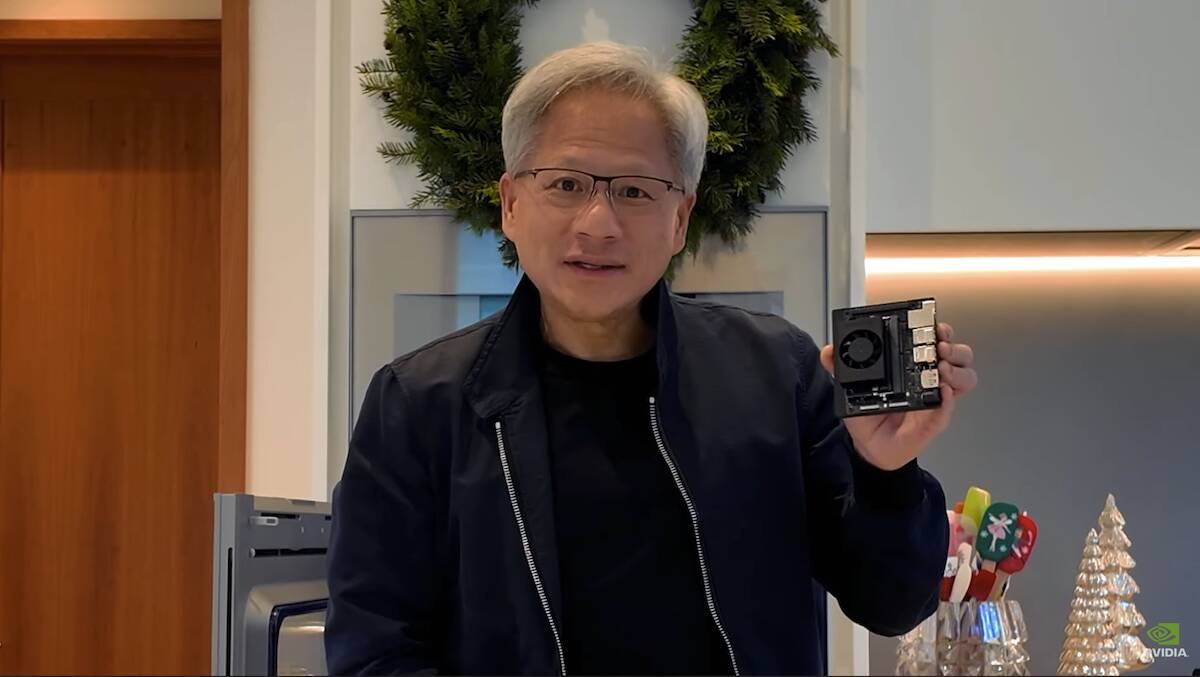

Nvidia 推出更便宜的 AI 开发板迎接假期

Nvidia 在假期期间推出了一款名为 Jetson Orin Nano Super 的小型新型开发板,将人工智能炒作带回家。

Nvidia 厚颜无耻地开账单董事会作为“最实惠的生成式人工智能超级计算机”,尽管这可能会大大扩展这个术语。

该开发套件由一个模块系统组成,类似于 Raspberry Pi 计算模块,位于用于 I/O 和电源的参考载板之上。而且,就像 Raspberry Pi 一样,Nvidia 的小型开发套件面向希望尝试生成式 AI 的开发人员和爱好者。

Orin Nano 配备 6 个 Arm Cortex-A78AE 核心以及一个基于旧版 Ampere 架构的 Nvidia GPU,具有 1024 个 CUDA 核心和 32 个张量核心。

该设计似乎与原来的杰特森·奥林·纳米。然而,Nvidia 表示,该主板的“超级”版速度更快,价格也更便宜,售价为 249 美元,而原价为 499 美元。

在性能方面,Jetson Orin Nano Super 在 INT8 下可达到 67 TOPS,这比任何英特尔、AMD 或高通最新 AI PC 中的 NPU 都要快,并配备 8GB LPDDR5 内存,内存带宽可达 102GB/s。据 Nvidia 称,这些规格反映了比前代产品性能提升了 70%,内存带宽增加了 50%。

对于那些希望使用为现代人工智能聊天机器人提供支持的大型语言模型(LLM)的人来说,带宽的提升尤其重要。在 102GB/s 的速度下,我们估计开发套件在运行 Meta 的 80 亿参数 Llama 3.1 模型的 4 位量化版本时,每秒应该能够以大约 18-20 个标记生成单词。

如果您对 TOPS、内存容量和带宽与模型性能有何关系感到好奇,可以查看我们的指南这里。

对于 I/O,开发套件的载板具有 SBC 的常用连接功能,包括千兆位以太网、DisplayPort、四个 USB 3.2 Gen 2 type-A 端口、USB-C、带 M 和 E 键的双 M.2 插槽,以及各种扩展头。

- 为本地人工智能购买 PC?这些是真正重要的规格

- Nvidia 的 CUDA 护城河到底有多深?

- 欧盟委员会告诉我们,仔细看看 Nvidia 对 Run.ai 的收购

- LLM 性能作弊代码:推测性解码简介

在软件支持方面,您可能会认为那些 Arm 内核可能有问题;然而,事实并非如此。Nvidia 多年来一直支持 Arm 处理器上的 GPU,其最先进的设计- GH200 和 GB200 - 利用其定制的基于 Arm 的 Grace CPU。这意味着您可以期待 GPU 巨头的软件套件得到广泛支持,其中包括 Nvidia Isaac、Metropolis 和 Holoscan 等。

除了 Nvidia Jetson AI 实验室提供的各种开放式 AI 模型外,该开发套件还支持多达四个摄像头,用于机器人或视觉处理工作负载。

除了新的开发套件之外,Nvidia 还推出了对其旧版 Jetson Orin NX 和 Nano 模块系统的软件更新,据说这将使 GenAI 性能提高 1.7 倍,所以如果你已经购买了 Orin Nano,你应该'不要错过太多。®