一种新的人工智能(AI)模型刚刚问世取得了人类水平的成果一项旨在测量“一般智力”的测试。

12 月 20 日,OpenAI 的 o3 系统在排行榜上得分为 85%ARC-AGI 基准测试,远高于之前人工智能最好成绩 55%,与人类平均得分持平。它在一项非常困难的数学考试中也取得了很好的成绩。

创建通用人工智能(AGI)是所有主要人工智能研究实验室的既定目标。乍一看,OpenAI 似乎至少朝着这个目标迈出了重要的一步。

尽管怀疑依然存在,但许多人工智能研究人员和开发人员感到事情发生了变化。对于许多人来说,通用人工智能的前景现在似乎比预期更加真实、紧迫和接近。他们是对的吗?

泛化和智能

要了解 o3 结果的含义,您需要了解 ARC-AGI 测试的全部内容。用技术术语来说,这是对人工智能系统适应新事物的“样本效率”的测试——系统需要看到多少新情况的例子才能弄清楚它是如何工作的。

像 ChatGPT (GPT-4) 这样的 AI 系统的样本效率不是很高。它接受了数百万人类文本示例的“训练”,构建了最有可能出现的单词组合的概率“规则”。

结果在常见任务上相当出色。它不擅长执行不常见的任务,因为它有关这些任务的数据较少(样本较少)。

在人工智能系统能够从少量示例中学习并以更高的样本效率进行适应之前,它们只会用于非常重复的工作以及可以容忍偶尔失败的工作。

从有限的数据样本中准确解决以前未知或新问题的能力被称为概括能力。它被广泛认为是智力的必要甚至基本元素。

网格和图案

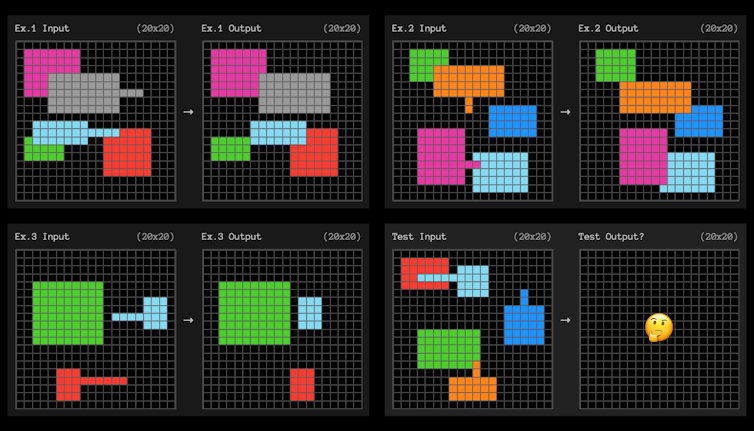

ARC-AGI 基准测试使用如下所示的小网格方形问题来测试样本的有效适应。人工智能需要找出将左侧网格变成右侧网格的模式。

每个问题都给出了三个可供学习的例子。然后,人工智能系统需要找出从三个例子到第四个例子的“概括”规则。

这些很像您有时可能记得在学校进行的智商测试。

薄弱的规则和适应

我们不知道 OpenAI 到底是如何做到的,但结果表明 o3 模型具有很强的适应性。仅从几个例子中,它就找到了可以推广的规则。

为了找出一种模式,我们不应该做出任何不必要的假设,或者比我们实际需要的更具体。在理论,如果您能够找出满足您要求的“最弱”规则,那么您就已经最大限度地提高了适应新情况的能力。

最弱的规则是什么意思?技术定义很复杂,但较弱的规则通常可以用更简单的语句描述。

在上面的示例中,该规则的简单英语表达可能类似于:“任何带有突出线的形状都将移动到该线的末尾,并“覆盖”与其重叠的任何其他形状。”¤

寻找思想链?

虽然我们还不知道 OpenAI 是如何实现这一结果的,但他们似乎不太可能故意优化 o3 系统来发现薄弱规则。然而,为了成功完成 ARC-AGI 任务,它必须找到它们。

我们确实知道 OpenAI 从 o3 模型的通用版本开始(它与大多数其他模型不同,因为它可以花更多时间“思考”难题),然后专门针对 ARC-AGI 对其进行训练测试。

设计该基准的法国人工智能研究员 Francois Chollet,相信o3 搜索不同的“思想链”,描述解决任务的步骤。然后,它会根据一些松散定义的规则或“启发式”选择“最佳”。

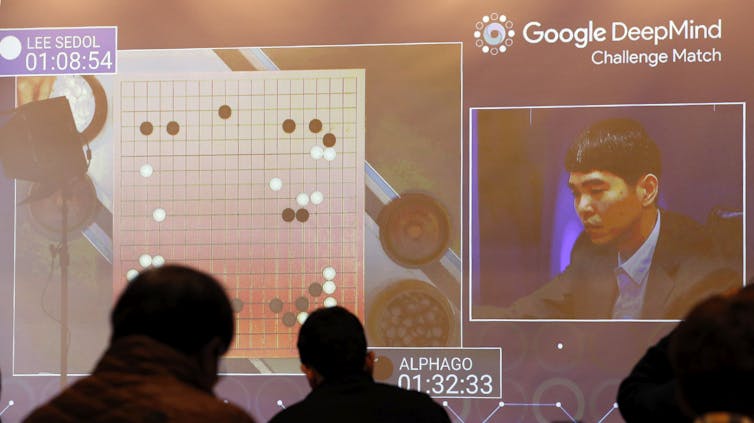

这与谷歌的 AlphaGo 系统通过搜索不同可能的走法序列来击败围棋世界冠军的方式“没有什么不同”。

您可以将这些思想链视为适合示例的程序。当然,如果它像围棋人工智能一样,那么它需要一个启发式或宽松的规则来决定哪个程序是最好的。

可能会生成数千个不同的看似同样有效的程序。该启发式可以是“选择最弱的”或“选择最简单的”。

然而,如果它像 AlphaGo 那么他们只是让人工智能创建启发式算法。这就是AlphaGo的过程。谷歌训练了一个模型来评估不同的动作序列比其他序列更好或更差。

我们还不知道什么

那么问题是,这真的更接近 AGI 吗?如果这就是 o3 的工作原理,那么底层模型可能不会比以前的模型好多少。

模型从语言中学习的概念可能并不比以前更适合泛化。相反,我们可能只是看到通过训练专门针对该测试的启发式方法的额外步骤发现的更普遍的“思想链”。一如既往,证据就在布丁中。

关于 o3 的几乎一切仍然未知。OpenAI 的披露仅限于少数媒体演示以及少数研究人员、实验室和人工智能安全机构的早期测试。

真正了解o3的潜力需要进行大量工作,包括评估、了解其能力的分布、失败的频率和成功的频率。

当 o3 最终发布时,我们将更好地了解它是否具有与普通人一样的适应能力。

如果是这样,它可能会产生巨大的革命性经济影响,开创自我完善加速智能的新时代。我们需要为通用人工智能本身制定新的基准,并认真考虑如何管理它。

如果没有,那么这仍然是一个令人印象深刻的结果。然而,日常生活将保持不变。