人工智能与人类智能水平有多接近?

作者:Jones, Nicola

一些研究人员认为人工智能系统很快就会达到人类水平的智能;其他人则认为它很遥远。图片来源:盖蒂

科技公司 OpenAI 上个月成为头条新闻,其最新的实验性聊天机器人模型 o3 在测试中取得了高分,标志着在通用人工智能(通用人工智能)。OpenAI 的 o3 得分为 87.5%,超过了之前人工智能 (AI) 系统的最高得分 55.5%。

人工智能与人类智能水平有多接近?

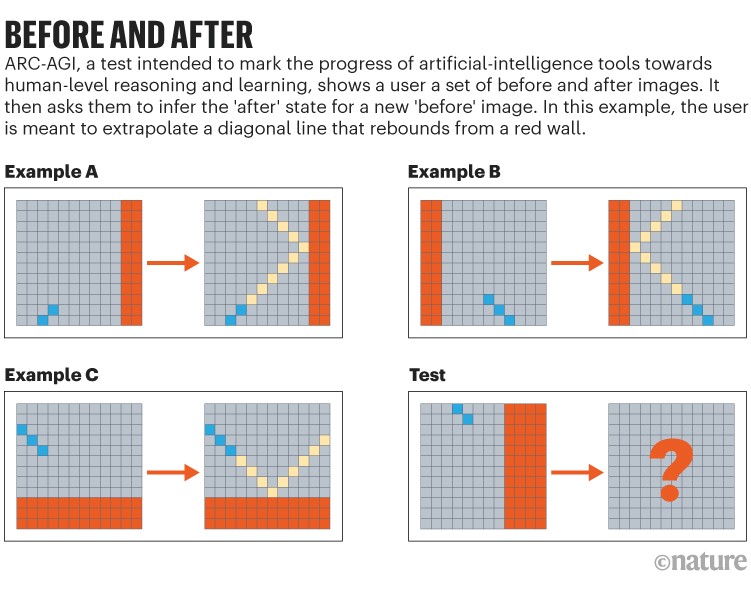

创建该测试的人工智能研究员 François Chollet 表示,这是“真正的突破”,该测试名为“通用人工智能抽象与推理语料库”(ARC-AGI)1,2019 年在位于加利福尼亚州山景城的 Google 工作期间。Chollet 表示,测试中的高分并不意味着 AGI(广泛定义为能够像人类一样进行推理、计划和学习技能的计算系统)已经实现,但 o3 是——“绝对”能够推理并且“具有相当大的概括能力”。

研究人员对 o3 在整个领域的表现感到震惊各种测试或基准,包括虚拟研究机构 Epoch AI 在 11 月宣布的极其困难的 FrontierMath 测试。“这非常令人印象深刻”,位于加利福尼亚州伯克利的模型评估与威胁研究小组的人工智能基准研究员 David Rein 说道。

ChatGPT 打破了图灵测试 — 评估 AI 新方法的竞赛已经开始

但包括 Rein 在内的许多人警告说,很难判断 ARC-AGI 测试是否真正衡量了人工智能的推理和概括能力。“有很多基准旨在衡量智力的一些基本因素,但事实证明它们并没有,”雷因说。他说,寻找更好的测试仍在继续。

总部位于旧金山的 OpenAI 尚未透露 o3 的工作原理,但该系统很快就到达了现场公司的 o1 模型,它使用“思维链”逻辑,通过一系列推理步骤来解决问题。一些专家认为,o3 可能会产生一系列不同的思想链,以帮助从一系列选项中找出最佳答案。

现在居住在华盛顿州西雅图的 Chollet 表示,在测试时花更多时间完善答案会对结果产生巨大影响。但 o3 的成本很高:为了完成 ARC-AGI 测试中的每项任务,其高分模式平均需要 14 分钟,可能花费数千美元。(Chollet 表示,计算成本是根据 OpenAI 对每个代币或单词向客户收取的费用来估算的,这取决于用电量和硬件成本等因素。)卡内基的向悦表示,这“引发了可持续性问题”宾夕法尼亚州匹兹堡梅隆大学研究为聊天机器人提供支持的大型语言模型 (LLM)。

尽管“AGI”一词通常用于描述在广泛的任务中满足或超越人类认知能力的计算系统,但它不存在技术定义。因此,对于人工智能工具何时能够实现通用人工智能,目前还没有达成共识。有人说,这个时刻已经到来;有人说,这个时刻已经到来。其他人则说还很遥远。

正在开发许多测试来跟踪 AGI 的进展。其中一些,包括 Rein 的 2023 年 Google-Proof 问答2,旨在评估人工智能系统在博士级科学问题上的表现。OpenAI 的 2024 MLE 基准测试让 AI 系统应对在线数据科学竞赛平台 Kaggle 上托管的 75 项挑战。这些挑战包括现实世界的问题,例如翻译古代卷轴和开发疫苗3。

资料来源:参考文献。1

好的基准需要回避许多问题。例如,人工智能在接受训练时必须没有遇到相同的问题,并且问题的设计方式应确保人工智能无法走捷径作弊。“法学硕士善于利用微妙的文本提示来得出答案,而无需进行真正的推理,”岳说。他补充说,理想情况下,测试应该像现实世界的条件一样混乱和嘈杂,同时还设定能源效率目标。

Yue 领导开发了一项名为“专家 AGI 大规模多学科多模态理解和推理基准”(MMMU) 的测试,该测试要求聊天机器人执行大学级别的基于视觉的任务,例如解释乐谱、图表和电路图4。Yue 表示,OpenAI 的 o1 保持着当前 78.2% 的 MMMU 记录(o3 的分数未知),而人类的顶级表现为 88.6%。

相比之下,ARC-AGI 依赖于人类通常在幼儿期发展的数学和模式识别的基本技能。它为考生提供了一组设计前后的演示,并要求他们推断新颖的“之前”设计的“之后”状态(请参阅“之前和之后”)。“我喜欢 ARC-AGI 测试,因为它具有互补的视角,”Yue 说。