我的同事和我在普渡大学(Purdue University)发现了AI系统中嵌入的人类价值观的重大失衡。这些系统主要针对信息和公用事业价值,而较少面向亲社会,福祉和公民价值观。

许多AI系统的核心是用于训练模型的大量图像,文本和其他形式的数据。尽管这些数据集经过精心策划,但有时包含不道德或禁止的内容并不少见。

为了确保AI系统在响应用户时不会使用有害内容,研究人员介绍了一种称为的方法从人类反馈中学习的强化。研究人员使用人类偏好的高度策划数据集来塑造AI系统的行为,以帮助和诚实。

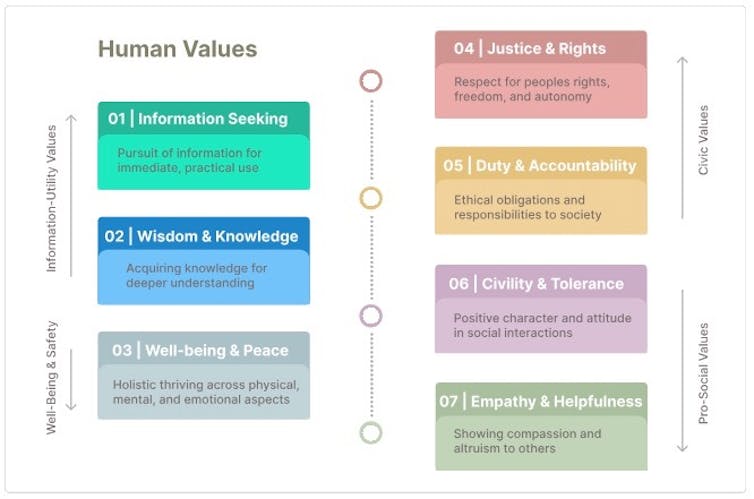

在我们的研究中,我们检查了领先的美国AI公司使用的三个开源培训数据集。我们通过道德哲学,价值理论以及科学,技术和社会研究的文献回顾来构建人类价值观的分类学。这些价值观是幸福与和平;寻求信息;正义,人权和动物权利;职责和问责制;智慧和知识;文明和宽容;以及同理心和帮助。我们使用分类法来手动注释数据集,然后使用注释来训练AI语言模型。

我们的模型使我们能够检查AI公司的数据集。我们发现这些数据集包含了几个示例,当用户问诸如我如何预订航班问题时,训练AI系统会有所帮助和诚实?移情,正义和人权。总体而言,智慧,知识和信息寻求是两个最常见的价值观,而正义,人权和动物权利是最不常见的价值。

为什么重要

用于训练AI的数据集中人类价值观的不平衡可能对AI系统如何与人互动并处理复杂的社会问题产生重大影响。随着人工智会更加集成到诸如法律,,,,卫生保健和社交媒体,重要的是,这些系统必须反映出集体价值观的平衡范围,以在道德上满足人们的需求。

这项研究也对政府和政策制定者至关重要,因为社会努力解决有关的问题人工智能治理和道德。了解AI系统中嵌入的价值观对于确保它们服务于人类的最大利益很重要。

还有其他研究正在进行

许多研究人员正在努力使人工智能系统与人类价值观保持一致。从人类反馈中引入强化学习是开创性的因为它提供了一种指导AI行为来帮助和真实的方法。

各种公司正在开发技术以防止AI系统中的有害行为。但是,我们的小组是第一个引入系统的方法来分析和了解通过这些数据集中实际嵌入哪些值的方法。

接下来是什么

通过使这些系统嵌入的值可见,我们旨在帮助AI公司创建更多平衡的数据集,以更好地反映其所服务社区的价值。两家公司可以使用我们的技术来找出他们做得不好的地方,然后改善其AI培训数据的多样性。

我们研究的公司可能不再使用其数据集的那些版本,但是它们仍然可以从我们的流程中受益,以确保其系统与社会价值和规范保持一致。