AI会危害科学摄影吗?还有时间创建道德行为准则

作者:Kapoor, Sayash

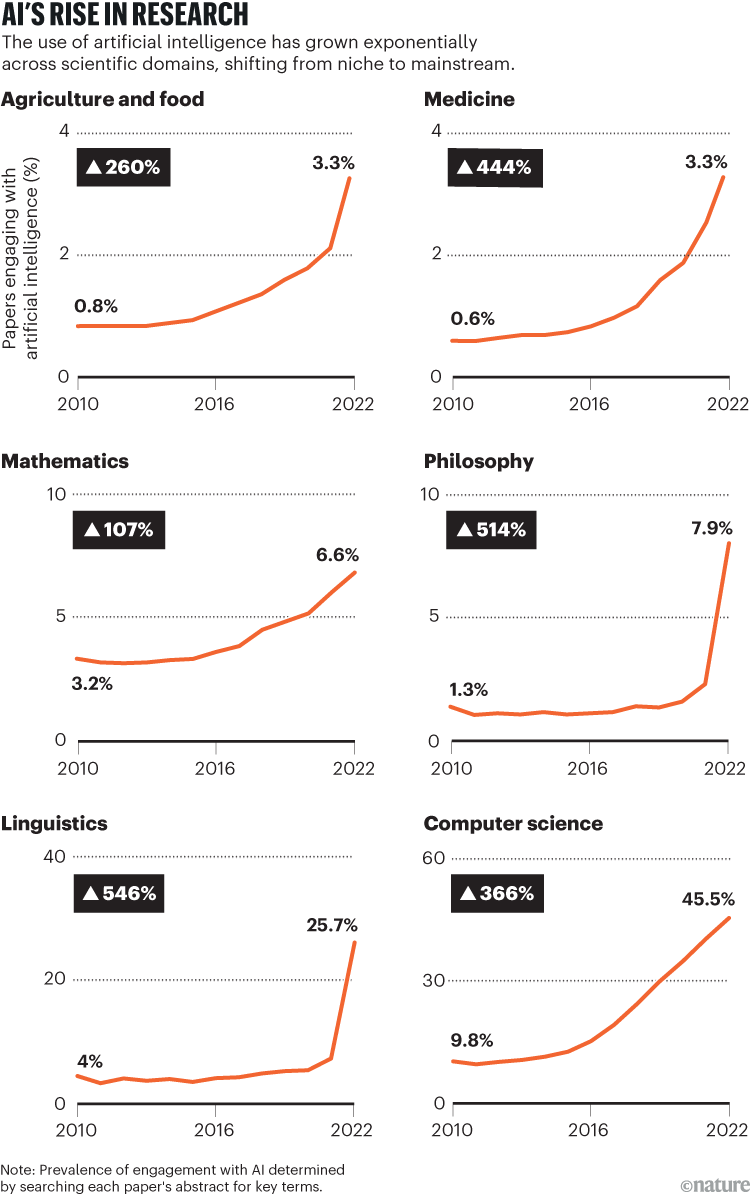

人工智能(AI)的使用正在跨科学的许多分支爆炸。在2012年至2022年之间,在20个领域与AI互动的科学论文的平均比例是三倍(参见研究的增长),包括经济学,地质,政治学和心理学1。希望AI可以加速科学发现很高,因为取得了基本进步的速度似乎正在放慢脚步

:尽管有更多的资金,出版物和人员,但我们的进步速度较慢。但是急于采用AI有后果。随着它的使用繁殖 - 预测疾病暴发,预测人们的生活成果并预期内战 - 有必要谨慎和内省。

尽管统计方法通常具有错误使用的风险,但由于其复杂性和黑盒性质,AI的风险甚至更大。并且错误越来越普遍,尤其是当计算机科学专业知识有限的研究人员使用现成的工具时。研究人员很容易高估AI模型的预测能力,从而在削弱实际进步的同时产生了进步的幻想。

在这里,我们讨论危险并提出一系列补救措施。建立有关如何使用这些工具和技术的明确的科学指南是紧迫的。

可以通过多种方式将AI部署在科学中。它可用于通过先前的工作有效梳理,或者(例如,候选药物)搜索问题空间,然后可以通过传统手段对其进行验证。

AI的另一种用途是建立一种感兴趣现象的机器学习模型,并询问它以获取有关世界的知识。研究人员称这种基于机器的科学为基础。它可以看作是对常规统计建模的升级。机器学习建模是统计功能强大,更自动化的手斧的电锯,但如果使用不正确,则危险。

资料来源:参考。1

我们的关注主要是关于这些基于模量的方法,在这些方法中,AI用于对系统的运作方式进行预测或检验假设。一个常见的错误来源是泄漏,当来自模型评估数据的信息不当影响其培训过程时,就会出现一个问题。发生这种情况时,机器学习模型可能会简单地记住评估数据中的模式,而不是捕获感兴趣现象背后的有意义的模式。这限制了此类模型的现实适用性,并且在科学知识方面几乎没有产生。

通过我们的调查和编译现有证据,我们发现,从精神病学和分子生物学到计算机安全的至少30个科学领域的论文 - 使用机器学习困扰着泄漏2(看go.nature.com/4ieawbk)。这是对考试的一种教学,或者更糟糕的是,在考试前给出答案。

例如,在COVID-19大流行期间,数百项研究表明,AI可以仅使用胸部X射线或CT扫描来诊断该疾病。对415项研究的系统评价发现,只有62个符合基本质量标准3。即使在其中,缺陷也很普遍,包括评估方法不佳,复制数据以及缺乏对阳性病例是否来自具有确认医学诊断的人的明确性。

在十多项研究中,研究人员使用了一个培训数据集,其中所有共同阳性病例均在成年人中,而否定因素是一到五岁的儿童。结果,AI模型仅学会了区分成年人和儿童,但是研究人员错误地得出结论,他们已经开发了19个探测器。

很难系统地捕获这样的错误,因为评估预测准确性非常棘手,而且还缺乏标准化。计算机代码库可以长数千行。错误可能很难发现,并且单个错误可能会昂贵。因此,我们认为基于机器学习的科学的可重复性危机仍处于初期。

通过一些研究在研究中使用大型语言模型,例如,通过将其用作心理学实验的人类参与者的替代物。这些模型对输入很敏感。提示措辞的小变化可能会导致输出的显着变化。而且,由于这些模型通常是由私人公司拥有和经营的,因此可以在任何时候限制对它们的访问权限,从而使这些研究难以复制。

匆忙采用AI和机器学习的风险更大在于,即使没有错误的发现,发现的洪流也可能不会带来真正的科学进步。

为了了解这种风险,请考虑2001年从2001年起具有影响力的影响的影响,在该论文中,统计学家Leo Breiman巧妙地描述4。

AI会危害科学摄影吗?还有时间创建道德行为准则

他强烈提倡后者,包括采用机器学习模型,而不是简单的统计模型,而预测精度优先于忠实地代表自然的问题。我们认为,这种倡导并未提及机器学习方法的已知局限性。本文在工程和自然科学中使用机器学习模型之间没有足够的区分。尽管Breiman发现这种黑盒模型可以在工程学中很好地工作,例如通过使用声纳数据对潜艇进行分类,但它们在自然科学中更难使用,其中解释自然(例如,水中声波传播的原理)是整个点。

这种混乱仍然很普遍,太多的研究人员被AI的商业成功所吸引。但是,仅仅因为建模方法对工程有益,这并不意味着它对科学有利。

有一个古老的格言,每个模型都是错误的,但是有些模型很有用。将产出从模型转换为关于世界的主张需要大量工作。机器学习的工具箱使构建模型变得更容易,但是它不一定会使提取有关世界的知识变得更容易,并且很可能会使它变得更加困难。结果,我们冒着产生更多但了解更少的风险5。

科学不仅是事实或发现的集合。实际的科学进步通过理论发生,这些理论解释了发现的集合和范式,这是理解和研究领域的概念工具。随着我们从发现转变为理论到范例,事情变得更加抽象,更广泛,更较少。我们怀疑基于AI的科学发现的快速扩散尚未加速,甚至可能抑制了这些较高水平的进步。

如果某个领域的研究人员担心各个论文中的缺陷,我们可以通过分析论文样本来衡量其患病率。但是,很难找到吸烟的证据表明,整个科学群落都过分强调预测准确性,以牺牲理解为代价,因为不可能访问反事实世界。也就是说,从历史上看,有许多田野被困在车辙中的例子,尽管他们擅长产生个人发现。其中包括化学之前的炼金术,哥白尼革命之前的天文学和板块构造之前的地质。

对AI研究的大喊大叫,这不会成为头条新闻

天文学的故事与AI特别相关。宇宙与地球的中心模型在预测行星运动方面非常准确,因为诸如epycles之类的技巧是,假设行星以圆圈移动,其中心沿着较大的圆形路径围绕地球围绕着地球旋转。实际上,许多现代的天文馆投影仪都使用这种方法来计算轨迹。

如今,AI擅长生产相当于电子环状的。所有其他是平等的,能够从缺陷的理论中挤出更多预测性果汁,而范式不足将有助于他们坚持更长的时间,阻碍真正的科学进步。

我们指出了在科学中使用AI的两个主要问题:在广泛采用AI的个人研究和认识论问题中的缺陷。

以下是提高基于机器学习的科学研究的信誉并避免幻想进步的暂定思想。我们将这些作为讨论的起点,而不是经过验证的解决方案。