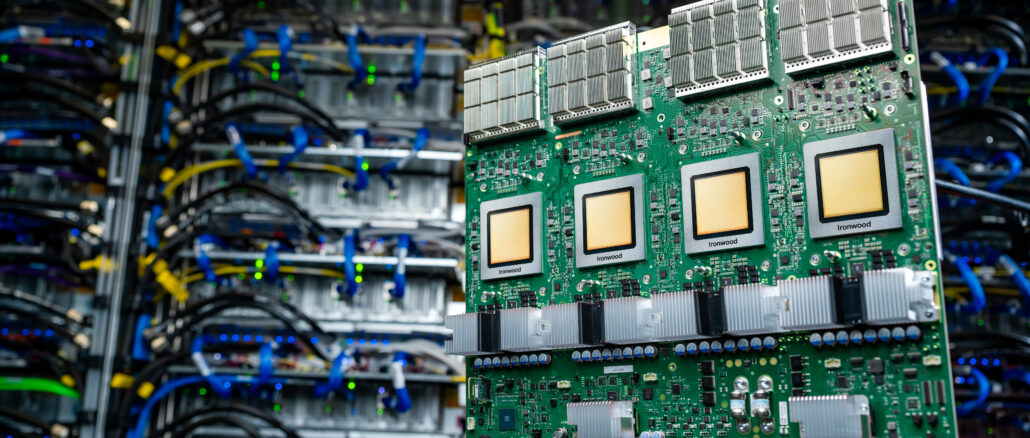

作为上周的Google Cloud之前,作为Google Cloud之前的预言的一部分,然后在主题演讲期间,Google的顶级黄铜不断比较Ironwood tpu V7P系统的吊舱与劳伦斯·利弗莫尔(Lawrence Livermore Livermore)国家实验室的El Capitan超级计算机。他们一直做错了,这让我们很生气。

对于大规模AI系统进行比较是完全合理的,即使在一种情况下(El Capitan),机器的主要目的是运行传统的HPC模拟和建模工作负载,而在另一个情况下(Ironwood Pod),机器也可以完全进行高级浮点数学,并且实际上只能进行AI培训和优点。从某种意义上说,使用CPU和GPU的混合体系结构进行计算的机器更像是一台通用机器,鉴于其宽的数值类型和计算和多种工作负载的精确度,并且这样的机器体系结构具有一定的价值,因为它是多功能的。

But, as it turns out, exascale-class machines like El Capitan at Lawrence Livermore and “Aurora†at Argonne National Laboratory, can hold their own against machines built with custom XPU accelerators, and because of the sweet deals that the US government’s Department of Energy secures with supercomputer makers, offer bang for the buck that we think is superior to what Google pays to use its own machinery and is far less than what it charges在TPU上租用AI工作量的客户。

这是我们看到的有问题的图表之一:

在这项数学中,Google正在比较El Capitan的持续性能与44,544 AMD ANTARES-A Instinct Mi300A混合CPU-GPU CPU-GPU计算机在64位浮点精度下运行高性能linpack(HPL)基准,以与9,21的Ironwood Pod相对于Ironwood Pod的高度峰值性能。

这是一个非常愚蠢的比较,而Google的顶级黄铜不仅应该更好,而且可以更了解。但也许更重要的是,表演只是故事的一半。您也必须考虑计算的成本。高性能必须具有最低的成本,并且没有人比美国政府能源部获得更好的HPC装备交易。

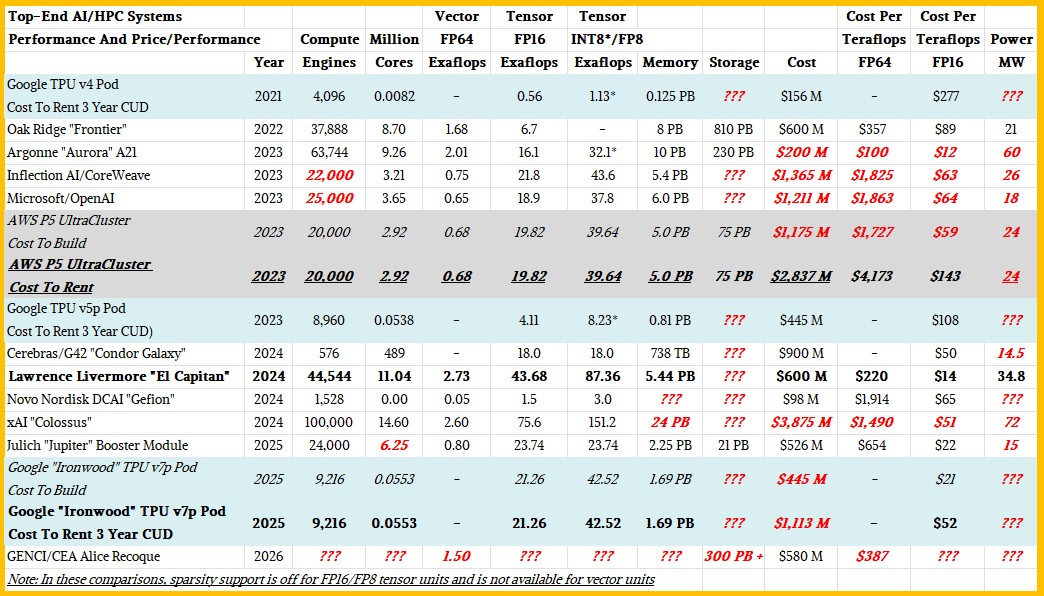

在没有大量数据的情况下,我们对现代AI/HPC系统进行了价格/性能分析,其中许多是基于CPU和GPU的组合,后者来自AMD或NVIDIA,而前者则在原始计算方面并不重要。看看:

我们意识到,这种比较并不完美。Google和Amazon Web服务定价包括三年租用系统的成本,当然包括电力,冷却,设施和管理的成本。对于显示的许多超级计算机,预算是用于设施,电源,冷却三到四年的预算,我们尽了最大的努力,不包括任何非经常性工程(NRE)费用(NRE),以使机器在现场运行和调整。对于各种AI机器,我们对无法提供信息的机器尺寸和成本进行了估算。

所有估计都以大胆的红色斜体显示,并且我们有问题标记目前无法进行估计。

我们仅显示具有3D圆环互连的TPU系统将它们链接到相当大的豆荚中。因此,前一代trillium tpu v6e系统,仅扩展到256个曲线拓扑中的计算发动机。

如您所料,在过去的四年中,即使机器的性能提高,FP64高精度和FP16和FP8低精度处理的成本也下降了。这是一件好事。但是机器的成本正在迅速上升,以至于我们称之为能力级的AI超级计算机现在要花费数十亿美元。(想想上面已安装的Xai巨像机器。)

在上表中,我们计算了租用Google TPU豆荚的成本,该豆荚使用折扣或cuds,类似于在亚马逊网络服务上的保留实例定价,并为长期承诺提供了折扣。传统的HPC超级计算机在该领域已有三年,有时四年,因此这是一个很好的比较点。估计的Ironwood TPU POD定价假设Google有些侵略性,就像从TPU V4 POD到TPU V5P POD的跳跃一样。

现在,清除混乱。铁木TPU V7P POD的额定值为21.26,以FP16分辨率为21.26,并以42.52 Exaflops的FP8分辨率为两倍。该POD具有1.69 pb的HBM内存,我们估计在三年的时间内建造约4.45亿美元,租金为11亿美元。如果您对此进行数学算法,那么Google可以使用9,216个Ironwood TPU使用Ironwood Pod,以每台Teraflops $ 21相互链接,您可以以每个Teraflops的价格租用约52美元。

由惠普(Hewlett Packard Enterprise)构建的El Capitan机器损失了劳伦斯·利弗莫尔(Lawrence Livermore)的6亿美元,在峰值性能下以FP16的分辨率为14美元。由于英特尔在Argonne的Aurora机器上进行了3亿美元的写入,因此Doe Lab仅为AI/HPC系统支付了2亿美元,这意味着其16.1 Exaflops以FP16精度为16.1,FP16 OOMPH仅需每TERAFlops 12美元。与El Capitan的Mi300A不同Ceepie-GeepiesIronwood POD的TPU V7P发动机不支持FP8处理,但它们确实像3D Torus设置中使用的两代Google TPU一样支持INT8处理。

FP8和INT8格式的效果是使任何具有它的机器的价格/性能加倍,并且其工作量可以利用;FP4可在NVIDIA的Blackwell gpus上获得,并将添加到未来的XPU AI Compune引擎中,然后再加倍。

我们将HPC的FP64性能标准化为AI的FP64性能,只是为了保持简单,但为FP8或INT8处理添加了列。公司将尽可能地在培训和推理中保持浮点格式,最终将不推荐INT16,INT8和INT4格式。

AWS P5 Ultruster是2022年末,整个2023年和2024年初使用NvidiahopperâH100GPU建造的集群的海报孩子。我们计算了租用20,000 GPU的群集的成本,然后基于估计的收购成本,基于估计的H100 H100和其他系统成本,并备份到收购成本。Microsoft Azure和Google Cloud将为建造相似的机器以及将容量租用到最终用户的能力。实际上,AWS和Microsoft锁定了他们的价格,因为GPU实例可能是合法的,也可能是不合法的。

Ironwood Pod如果我们的估计正确,将花费大约三分之一的Google构建和客户租用的价格,而租金要比这些相似性能的H100群集的价格少于这些H100群集,并且它们的使用量将不到一半以上的计算机。(至少是由插座计数进行的。)

但是,最后,让我们清楚。El Capitan在FP16和FP8分辨率上的性能比峰值理论性能的Ironwood Pod高2.05倍,Ironwood Pod没有El Capitan的性能24倍。的确,El Capitan在FP64精度下具有2.73个峰值性能的Exaflops,而Ironwood却没有,并且在FP64模式下,El Capitan在HPL上的额定值为1.74。

我们没有HPL-MXP结果对于El Capitan来说,但我们希望6月在汉堡举行的ISC 2025会议上举行一次。HPL-MXP使用大量混合精度计算来收敛于HPL测试中所有FP64数学相同的结果,如今,围绕有效的性能提升的顺序提供。这种混合精确度的使用导致了如何对实际HPC应用程序进行定制和提升以降低精度数学的方式,因此要么在同一硬件上完成更多的工作,要么使用较少的硬件来完成相同的工作。

注册我们的新闻通讯

直接从我们到您的收件箱中,介绍了一周的亮点,分析和故事,两者之间一无所有。

立即订阅