一个奇怪的短语在科学论文中不断出现,但是为什么呢?

作者:The Conversation

今年早些时候科学家发现了一个奇特的术语出现在发表的论文中:“营养电子显微镜”。

这句话听起来很技术性,但实际上是胡说八道,已成为“数字化石”。人工智能(AI)几乎不可能从我们的知识存储库中删除的系统。

就像被困在岩石中的生物化石一样,这些数字人工制品可能会成为我们信息生态系统中的永久固定装置。

植物电子显微镜的情况令人不安地了解AI系统如何在我们的集体知识中延续和放大错误。

不良扫描和翻译错误

营养电子显微镜似乎是通过无关误差的显着巧合起源的。

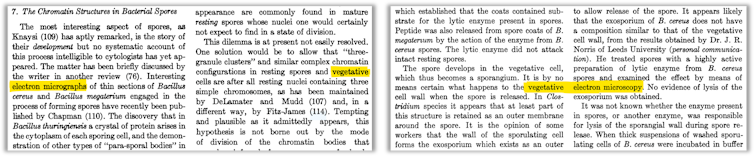

第一的,二 文件从1950年代发表在《细菌学评论》杂志上的1950年代开始进行了扫描和数字化。

但是,数字化过程错误地将“营养”与另一个文本的“电子”一起从另一个文本组合在一起。结果,创建了幻影术语。

几十年后,一些伊朗科学论文中出现了“营养电子显微镜”。在2017和2019,两篇论文在英语字幕和摘要中使用了该术语。

这似乎是由于翻译错误。在波尔西,“营养”和“扫描”的单词仅通过一个点有所不同。

上升错误

结果?截至今天,“植物电子显微镜”出现在22篇论文,根据Google Scholar。一个是有争议的主题从施普林格自然日记中撤回和Elsevier发布了更正另一个。

该术语也出现在讨论随后的新闻文章中诚信调查。

在2020年代,植物电子显微镜开始更频繁地出现。为了找出原因,我们不得不在现代AI模型中凝视,并在训练的大量数据中进行一些考古挖掘。

AI污染的经验证据

现代AI聊天机器人(例如Chatgpt)背后的大型语言模型对大量文本进行了“训练”,以预测一个可能的下一个单词。模型培训数据的确切内容通常是一个密切保护的秘密。

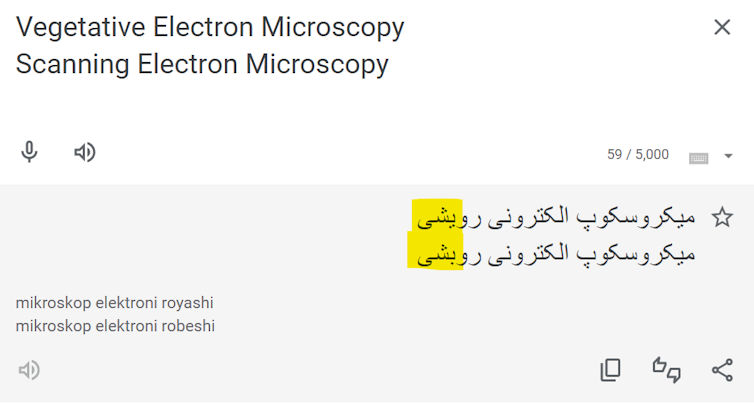

为了测试模型是否“知道”有关植物电子显微镜的“知道”,我们输入原始论文的摘要,以找出模型是否将其用胡说八道或更明智的替代方案完成。

结果揭示了。OpenAI的GPT-3始终用“营养电子显微镜”完成短语。诸如GPT-2和BERT之类的早期模型没有。这种模式帮助我们隔离了污染的何时何地。

我们还发现,在以后的模型中,包括GPT-4O和Anthropic的Claude 3.5的错误持续存在。这表明,废话术语现在可以永久嵌入AI知识库中。

通过比较我们对不同模型的培训数据集的了解,我们确定了普通爬行刮擦互联网页面的数据集是AI模型首次学习该学期的最有可能的向量。

比例问题

找到这种错误并不容易。修复它们可能几乎是不可能的。

一个原因是比例。例如,CommonCrawl数据集是数百万千兆字节的大小。对于大型科技公司以外的大多数研究人员来说,在此规模上工作所需的计算资源是无法访问的。

另一个原因是商业AI模型缺乏透明度。OpenAI和许多其他开发人员拒绝为其模型提供有关培训数据的精确细节。逆向工程的研究工作中的一些数据集也是被版权删除所困扰。

当发现错误时,没有简单的修复。简单的关键字过滤可以处理特定的术语,例如植物电子显微镜。但是,这也将消除合法的参考文献(例如本文)。

从根本上讲,此案提出了一个令人不安的问题。AI系统中还有多少其他荒谬的术语,等待被发现?

对科学和出版的影响

这种“数字化石”还提出了有关知识完整性的重要问题,因为AI辅助研究和写作变得更加普遍。

当通知包括植物电子显微镜在内的论文时,出版商反应不一致。一些人撤回了受影响的论文,而另一些则捍卫了它们。Elsevier尤其是试图证明该术语的有效性合理前最终进行更正。

我们尚不知道其他这样的怪癖是否会困扰着大型语言模型,但很有可能。无论哪种方式,AI系统的使用都已经为同行评审过程造成了问题。

例如,观察家注意到了“折磨的短语“用于逃避自动完整性软件,例如“伪造”意识“而不是“人工智能”。此外,短语例如,在其他缩回的论文中发现了“我是AI语言模型”。

一些自动筛选工具,例如有问题的纸筛现在,将植物电子显微镜标记为可能产生的含量的警告信号。但是,这种方法只能解决已知错误,而不是未被发现的错误。

用数字化石生活

人工智能的兴起通过没有单个演员控制的过程来使错误永久嵌入我们的知识系统中。这给科技公司,研究人员和发行商带来了挑战。

科技公司必须对培训数据和方法更加透明。研究人员必须找到新的方法来评估AI生成的令人信服的胡说八道。科学出版商必须改善他们的同行评审过程以发现人类和AI生成的错误。

数字化石不仅揭示了监视大量数据集的技术挑战,而且还揭示了在错误可能会自我延续的系统中保持可靠知识的基本挑战。![]()

亚伦·斯诺斯韦尔(Aaron J. Snoswell),AI问责制研究员,昆士兰州技术大学;凯文·维岑贝格(Kevin Witzenberger),研究研究员,Genai Lab,昆士兰州技术大学, 和Rayane El Masri,博士候选人,Genai Lab,昆士兰州技术大学