谷歌推出AlphaChip人工智能辅助芯片设计技术芯片布局作为电脑游戏 - Tom's Hardware

谷歌和联发科已经在使用它。

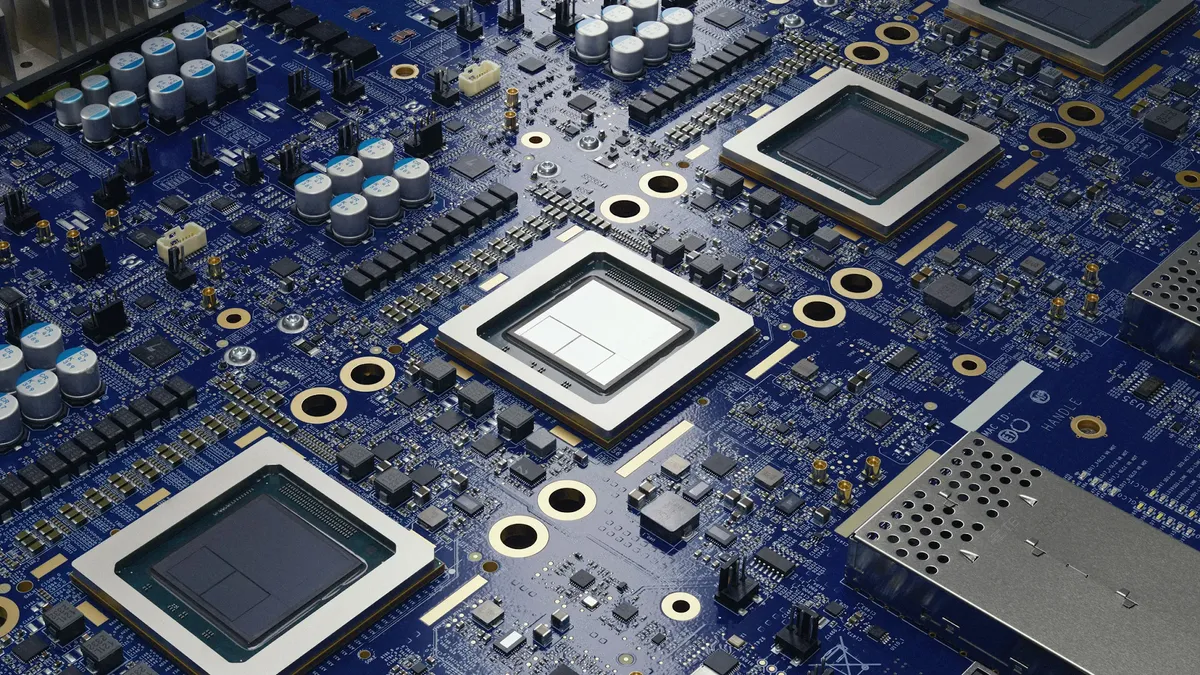

本周,谷歌推出了其用于设计芯片布局的 AlphaChip 强化学习方法。AlphaChip AI 有望大幅加快芯片布局设计的速度,并使其在性能、功耗和面积方面更加优化。现在与公众分享的强化学习方法在设计谷歌的张量处理单元(TPU)时发挥了重要作用,并已被包括联发科在内的其他公司采用。

传统上,芯片设计布局或布局规划已被采用。这是芯片开发过程中时间最长、劳动力最密集的阶段。近年来,Synopsys 开发了人工智能辅助芯片设计工具,可以加速开发并优化芯片的布局规划。然而,这些工具非常昂贵。Google 希望在某种程度上使这种人工智能辅助芯片设计方法大众化。

如今,如果由人类完成,为 GPU 等复杂芯片设计布局大约需要 24 个月。不太复杂的东西的布局规划可能需要几个月的时间,这意味着数百万美元的成本,因为设计团队通常非常重要。谷歌表示,AlphaChip 加快了这一时间线,可以在短短几个小时内创建芯片布局。此外,据说其设计非常优越,因为它们优化了功效和性能。谷歌还展示了一张图表,显示与人类开发人员相比,各种版本的 TPU 和 Trillium 的线长度减少。

AlphaChip 使用强化学习模型,其中代理在预设环境中采取行动,观察结果,并从这些经验中学习,以便在未来做出更好的选择。就 AlphaChip 而言,系统将芯片布局规划视为一种游戏,每次将一个电路组件放置在空白网格上。随着解决更多布局,系统不断改进,使用图神经网络来理解组件之间的关系。

自 2020 年以来,AlphaChip 一直用于设计 Google 自己的 TPU AI 加速器,驱动 Google 的许多大规模应用人工智能模型和云服务。这些处理器运行基于 Transformer 的模型,为 Google 的 Gemini 和 Imagen 提供支持。AlphaChip 改进了每一代 TPU 的设计,包括最新的第六代 Trillium 芯片,确保更高的性能和更快的开发。尽管如此,谷歌和联发科都依赖 AlphaChip 来实现有限的模块集,而人类开发人员仍然完成了大部分工作。

到目前为止,AlphaChip 已被用于开发各种处理器,包括谷歌的处理器TPU和联发科天玑5G片上系统,广泛应用于各类智能手机。因此,AlphaChip 能够泛化到不同类型的处理器。谷歌表示,它已经在各种芯片模块上进行了预训练,这使得 AlphaChip 在实践更多设计时能够生成越来越高效的布局。虽然人类专家学习,而且许多人学得很快,但机器的学习速度要高出几个数量级。

扩大人工智能在芯片开发中的使用

谷歌表示 AlphaChip 的成功启发了将人工智能用于芯片设计不同阶段的新研究浪潮。这包括将人工智能技术扩展到逻辑综合、宏选择和时序优化等领域,Synopsys 和 Cadence 已经提供了这些技术,尽管价格不菲。据 Google 称,研究人员还在探索如何将 AlphaChip 的方法应用于芯片开发的更进一步阶段。

保持领先地位:获取 Tom's Hardware 时事通讯

获取 Tom's Hardware's最好的消息和深入的评论,直接发送到您的收件箱。

“AlphaChip 激发了芯片设计强化学习的全新研究方向,跨越了从逻辑综合到布局规划、时序优化的设计流程谷歌的一份声明中写道。

展望未来,谷歌看到了 AlphaChip 彻底改变整个芯片设计生命周期的潜力:从架构设计到布局再到制造,人工智能驱动的优化可能会带来更快的芯片,更小(即更便宜),并且更节能。虽然目前 Google 的服务器和基于联发科天玑 5G 的智能手机受益于 AlphaChip,但未来应用可能会扩展到几乎所有领域。

AlphaChip 的未来版本已经在开发中,因此请继续关注更多信息人工智能驱动的芯片设计。

Anton Shilov 是 Toms Hardware 的特约撰稿人。在过去的几十年里,他涵盖了从 CPU 和 GPU 到超级计算机,从现代工艺技术和最新的制造工具到高科技行业趋势的所有内容。

bit_user 机器优化的主要好处是它可以同时考虑比人类更多的参数。在人类需要依赖启发式等拐杖的地方,人工智能可以应用更大的模式和规则字典来产生更优化的输出。文章称:虽然人类专家学习,而且许多人学得很快,但机器的学习速度却很慢。高出几个数量级。

我仍在等待看到使用 AI 进行代码优化的 C 编译器。就像芯片设计一样,现有的编译器依靠启发式方法来决定在什么情况下应用哪些优化。看起来人工智能,尤其是使用 PGO,可能会是一场巨大的胜利。文章称:据谷歌称,研究人员也在探索如何将 AlphaChip 的方法应用于芯片开发的更进一步阶段。

这样的事情实际上会激励我购买具有像样 NPU 的 CPU!