概括

- Llama2.C64是从1982年开始在旧硬件上运行的AI。

- 它运行了一个260k的小故事模型,将Llama2的功能带到了Commodore 64。

- llama2.C64创建类似儿童的故事,对这种过时的技术显示出令人印象深刻的结果。

在大型AI比赛中,各方都试图使他们的LLM在可能的最弱,最便宜的硬件上工作。硬件越弱,运行LLM的功率越少。但是,如何在1982年发布的硬件上运行AI模型?

这正是Maciej Witkowiak试图与他们的新项目一起做的。该项目的标题为“ Llama2.C64”,旨在使一个简单的AI在Commodore 64上运行,该项目很早就出现了,早在LLMS甚至是一件事情之前。尽管它绝对不会很快击败GPT-4O,但这仍然是一项令人印象深刻的壮举。

llama2.c64将新的带入旧的,尽管慢慢

正如第一次报道哈卡迪,Maciej Witkowiak向世界展示了Llama2.C64。您可能想象的,您不会从这个硬件中获得高性能,但是让任何事情都真正运行真的很酷。Witkowiak描述了这一点:

使用Maciej'Ytm/Elysium'Witkowiak移植到C64OSCAR64

llama2.c64是llama2.c到配备至少2MB REU的Commodore C64。

它运行260k小故事模型将Llama2的功能带入独特的C64硬件环境。

这不是聊天模型。

相反,想象一下一个故事开始的3岁孩子 - 他们将以最好的词汇和能力继续下去。

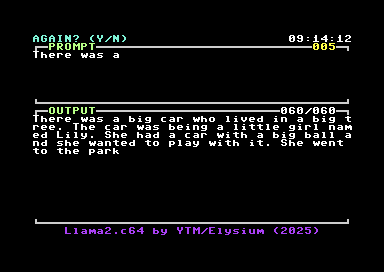

您可以在上图中看到一个llama2.c64的示例。果然,这听起来确实像是一个孩子在讲一个故事时在漫步的孩子,但是考虑到AI的工作很少以及故事继续进行,这对于一台42年历史的计算机来说真是太神奇了。

作为该项目的专业人士的一部分,Witkowiak指出,AI在您的控制之下,从事弱硬件工作,并声称“等待C64上的下一个令牌就像等待从笔记本电脑上运行DeepSeek的人一样令人兴奋。”同时,对于缺点,“没有一个真的,这真是太棒了”(尽管他承认这可能有点慢)。

如果您希望在功能更强大的东西上运行AI(但仍然足够令人印象深刻),请查看这些八个SBC非常适合在家运行AI。另外,您可以阅读一次我们的作家Ayush Pande,将他的旧PC变成了AI图像生成服务器。