想象一下,一个可以使用心脏扫描的AI模型来猜测即使被告知种族是什么,或者要寻找什么种族类别。听起来像科幻小说,但这是真实的。

我最近的研究我与同事一起进行的,发现AI模型可以猜测是否从心脏图像中识别为黑色或白色的患者是否准确96% - 尽管没有有关种族类别的明确信息。

这是一个惊人的发现,挑战了关于人工智能客观性的假设,并突出了一个更深的问题:AI系统不反映世界 - 他们吸收和复制偏见内置。

从实际专家那里获取您的新闻,直接进入收件箱。 注册我们的每日新闻通讯从政治和商业到艺术和科学,英国最新的新闻和研究介绍了所有对话。今天免费加入对话。

首先,重要的是要清楚:种族不是生物类别。现代遗传学显示有更多变化在所谓的种族群体中,而不是之间。

种族是一个社会结构,由社会发明的一组类别,以根据感知的身体特征和血统对人进行分类。这些分类没有地图干净地进行生物学,但它们塑造了从生活经验到获得护理的一切。

尽管如此,许多AI系统现在正在学习检测并可能采取这些社交标签,因为它们是使用由A形成的数据构建的将种族对待的世界,好像是生物学事实。

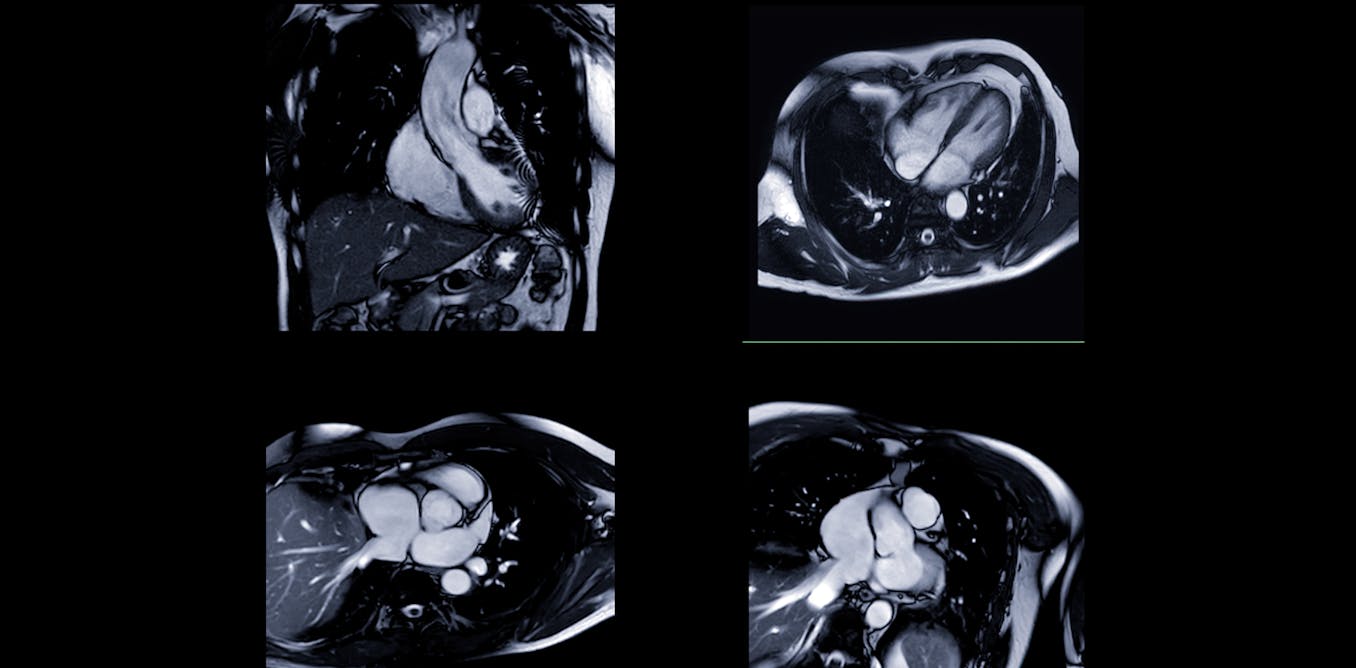

AI系统已经在改变医疗保健。他们可以分析胸部X射线,,,,阅读心脏扫描并标记潜在问题比人类医生快在某些情况下,在几秒钟内而不是分钟。医院正在采用这些工具为了提高效率,降低成本并标准化护理。

偏见不是一个错误

但是无论多么复杂,AI系统不是中立的。他们接受了现实数据的培训,该数据反映现实世界的不平等,,,,包括基于种族,性别,年龄和社会经济地位。这些系统可以学习以不同的治疗患者基于这些特征,即使没有人明确编程他们这样做。

偏见的主要来源是不平衡的训练数据。如果模型主要从浅皮肤患者那里学习,例如它可能会挣扎检测皮肤较暗的人的状况。皮肤科研究已经显示了这个问题。

甚至诸如Chatgpt等语言模型Arent Immune:一项研究发现有些模型仍然繁殖过时和错误的医学信念的证据,例如黑人患者皮肤比白人患者更厚的神话。

有时AI模型看起来准确,但出于错误的原因 - 一种称为的现象快捷方式学习。模型可能依靠无关紧要,但更容易发现数据中的线索,而不是学习疾病的复杂特征。

想象两个医院病房:一个使用扫描仪A治疗严重的Covid-19患者,另一位使用扫描仪B进行温和病例。AI可能会学会将扫描仪与严重疾病联系起来 - 不是因为它更好地了解该疾病,而是因为它在图像伪像A。

现在想象一下,使用扫描仪B对重病患者进行了扫描。该模型可能会错误地将其分类为不小的病人 - 不是由于医疗错误,而是因为它学习了错误的捷径。

这种有缺陷的推理可能适用于种族。如果种族群体之间的疾病患病率存在差异,AI最终可能会学习识别种族而不是带来危险后果的疾病。

在心脏扫描研究中,研究人员发现,AI模型实际上并不集中在心脏本身上,那里很少有与种族类别相关的可见差异。取而代之的是,它从心脏外部的区域中吸取了信息,例如皮下脂肪以及图像伪影 - 不需要的扭曲,例如运动模糊,噪声或压缩可能会降低图像质量。这些文物通常来自扫描仪,可以影响AI解释扫描的方式。

在这项研究中,黑人参与者的BMI高于平均水平,这可能意味着他们的皮下脂肪更高,尽管这不是直接研究的。一些研究表明,黑人的内在脂肪往往较少,并且较小的腰围在给定的BMI,但更多皮下脂肪。这表明AI可能已经在这些间接的种族信号上拾取了,而不是与心脏本身相关的任何事物。

这很重要,因为当AI模型学习种族时 - 反映种族不平等的社会模式 - 不理解上下文时,风险是它们可能会加强或恶化现有的差异。

这仅仅是关于安全性的。

解决方案

但是有解决方案:

多元化的培训数据:研究表明那做数据集更具代表性在不损害其他任何人的情况下,提高了各组的AI绩效。

建立透明度:许多AI系统被认为是黑匣子因为我们不了解他们如何得出结论。心脏扫描研究使用热图显示了图像的哪些部分影响了AI的决定,从而创造了一种形式可解释的AI这可以帮助医生和患者信任(或问题)结果 - 因此,当它使用不适当的捷径时,我们可以抓住。

谨慎对待种族:研究人员和开发人员必须认识到数据竞赛是一个社交信号,不是生物学真理。它需要周到的处理,以避免造成危害。

AI模型能够发现即使是最受训练的人眼可能会错过的模式。那是什么使它们如此强大,并且可能如此危险。它从中学到我们所做的一个有缺陷的世界。这包括我们对待种族的方式:不是科学现实,而是作为一种社会视角,健康,机会和风险分布不平等。

如果AI系统学习我们的快捷方式,他们可能会按大规模且责任较少地重复我们的错误。当生命在线时,这是我们负担不起的风险。