眼科的体现人工智能

作者:Shi, Danli

介绍

人工智能(AI)已迅速发展,并且越来越多地应用于医疗保健。传统的AI系统通常依赖于在固定计算环境中运行的数据驱动算法。尽管他们在图像识别和风险预测等任务中取得了显着的成功,但它们无法与环境进行物理相互作用限制了它们在动态临床环境中的有效性。

体现的AI(EAI)代表了一个新的范式,通过将AI整合到物理实体中,例如机器人,启用感知,学习并与其环境进行动态互动1。它的理论基础起源于1980年代后期,合并为实施例假设,这强调了身体互动在认知中的核心作用2。与依赖静态数据集的常规AI模型不同,EAI使用实时多模式输入进行上下文感知的适应,使其能够导航不断变化的环境并解决复杂的现实世界中的问题3。在大型语言模型(LLM),视觉语言模型(VLM)和强化学习(RL)中的最新突破进一步推动了下一代EAI系统的开发,为他们提供了智能大脑,对于需要个性化和响应能力的临床应用特别有价值4,,,,5。

在医疗保健中,EAI提供了有希望的应用。它可以支持疾病诊断,监测恢复和个性化患者护理,尤其是提高遥远或服务不足的地区的可及性和效率6。在眼科中,EAI具有独特的潜力,这是由于该领域对微观级别的手术精度,广泛的多模式成像数据以及广泛使用便携式成像设备的需求。通过实时感知和适应能力,EAI可以协助诸如基于多模式的诊断,手术计划,术中指导和个性化治疗优化等任务。因此,总结眼科技术的核心技术,当前的发展以及现有的挑战对于为未来的研究和临床实施提供信息至关重要。

本文提供了《眼科EAI》的介绍性指南。第一部分概述了EAI的概念和基本组成部分,包括感知,推理,行动和记忆。第二部分探讨了其在临床护理,教育和研究中的潜在应用。第三节讨论了该领域的现有挑战和未来方向。通过强调EAI的智能大脑方面,我们旨在为临床医生和视力研究人员提供有价值的见解。

EAI简介

EAI的特征和优势

EAI通过在模拟环境中并最终在现实世界中感知,移动,说话和互动的能力来解决传统的AI挑战。这些代理最初在虚拟设置中受过训练,可以将其学习的行为无缝地转移到物理机器人系统上。

与传统的眼科AI不同,它取决于大规模的静态数据集,例如图像,视频或互联网策划的文本,EAI强调了与环境的实时相互作用,密切反映了人类体验式学习。传统的基于Internet的AI系统经常因其对现有培训数据的质量和多样性的严重依赖,因此通常很难跨动态临床环境概括。尽管EAI系统仍可能利用Internet连接进行更新或远程计算,但它们的区别强度在于与环境的持续互动。

在EAI框架中,集成在智能代理中的多模式传感器收集实时感觉数据,包括视觉,触觉和听觉信号7,,,,8,,,,9。通过闭环感知行动周期,EAI系统将实时观察结果与历史知识相结合,以确定适当的行动策略,例如提供诊断援助,建议进一步检查或调整治疗计划。在每个动作之后,系统评估结果,将结果与预期结果进行比较,并完善未来的行为。这种感测,表演和学习的迭代循环使EAI逐渐捕获了个体的患者特征和疾病进展,从而支持更精确和个性化的医疗干预措施。

EAI的变革潜力在于其能够实现实时自适应眼科护理助理的能力。通过调整对个别检查结果的反应,EAI可以立即提供临床支持,个性化治疗指导和动态的患者管理。表中列出了传统AI和基于EAI的技术的比较摘要1。

EAI的进步

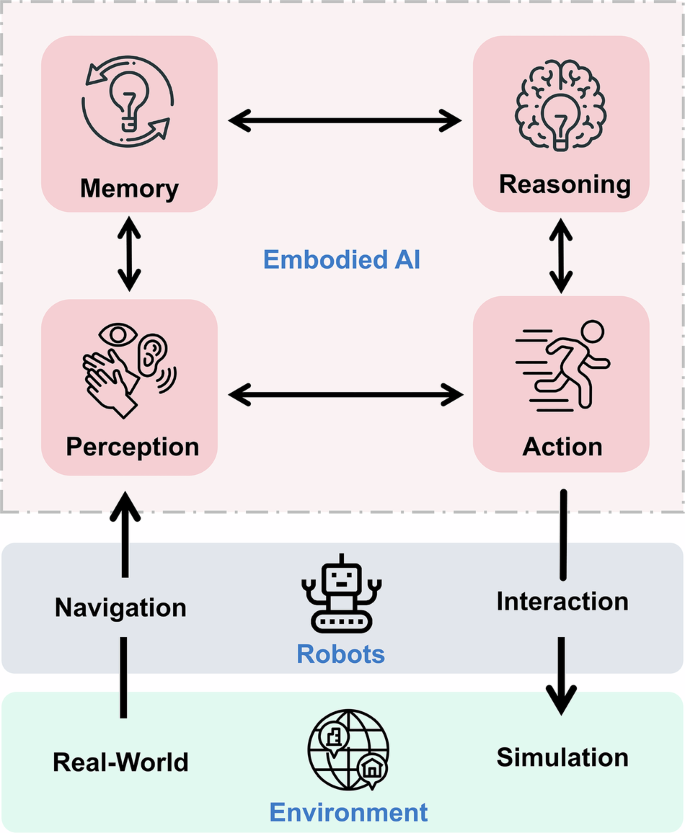

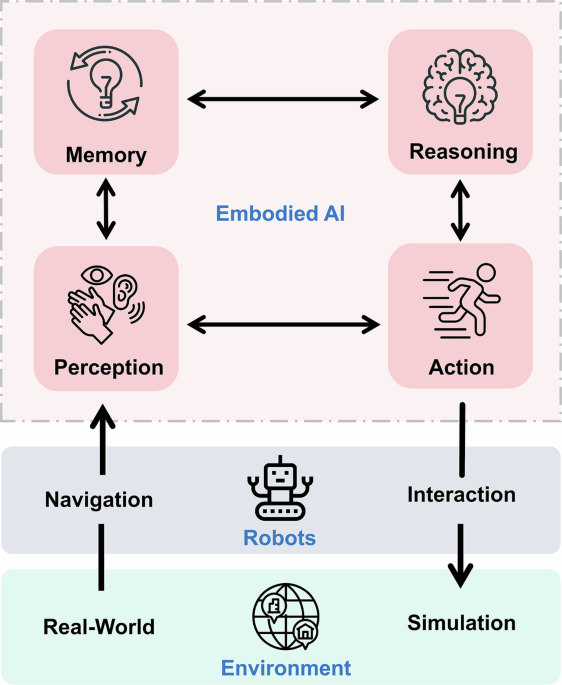

EAI以多个学科的进步为基础,包括智能算法,感觉知觉,决策和机器人控制10。EAI系统的开发本质上是跨学科的,它整合了神经科学,心理学,机器人技术,机器学习,LLM和相关技术的见解。这些系统不断发展,以增强关键功能,例如感知,语言理解,推理,计划,导航和电动机执行。在EAI的中心谎言四个基本过程:感知,记忆,推理和行动(图。1)。

感知:增强医学中的多模式感测

高级感知技术对于EAI系统至关重要11。

卷积神经网络(CNN)和基于变压器的架构在检测医学图像中的微妙疾病特征方面表现出了卓越的表现,表现优于传统图像处理技术12,,,,13。在眼科中,多模式数据的整合进一步提高了诊断准确性14,,,,15,,,,16。此外,生成的AI促进了数据的增加,从而增强了代表性不足或罕见疾病类别的模型性能。新兴的基础模型和表示学习提供了一系列诊断任务的数据有效改进17,,,,18,,,,19。同时,3D感知技术的进步增强了空间意识,并可以从第一人称角度准确解释体积数据20。

除了视觉输入之外,触觉和听觉感知越来越重要,尤其是在手术环境中。配备了这些功能的EAI系统可以向外科医生提供实时触觉或口头反馈,从而使机器人系统在复杂的眼镜过程中动态适应并最大程度地降低组织损害的风险21。视觉导航对自主系统至关重要,将视觉,触觉和语言信息结合在一起,以绘制周围环境,识别障碍并响应语音命令22。这些功能对于诸如室内导航和医疗程序之类的任务至关重要。

记忆:促进持续学习和上下文保留

记忆对于EAI系统在动态临床环境中有效运行至关重要。与静态AI模型不同,EAI系统既保持短期和长期记忆,以支持持续学习和上下文感知的决策23。

短期记忆捕获了最近的相互作用和瞬时环境变化,使得对不断发展的方案做出迅速响应。在眼科中,这在诸如术中监测之类的过程中至关重要,而实时适应至关重要24。

长期记忆存储从多个临床遭遇和人类反馈中积累了知识25。整合长期记忆支持诊断模型在目标情况下不断适应患者人群或罕见疾病表现。

短期和长期记忆的结合为终身学习提供了基础,从而无需完整的再培训就可以连续更新模型的知识库。

推理:授权临床决策

推理是EAI系统在复杂和不确定的医疗环境中运行的能力至关重要的。为了确保安全可解释的决策,EAI系统应使用高级技术(表2)为实时多模式数据过程产生透明的上下文感知响应,包括成像,临床文本和患者反馈。

LLM和VLM在多模式推理,自然语言和视觉输入转换为临床意义的动作中起关键作用26。通过逐步推论引导模型,诸如《思考链》(COT)之类的技术促使逻辑推理提高了逻辑推理27,而自相抗性方法通过从多个推理路径中选择最连贯的输出进一步提高了决策可靠性28。

图形神经网络支持临床变量之间的因果建模,促进个性化诊断和治疗计划29。RL,尤其是与深度学习集成的RL,使EAI系统能够通过反复试验的相互作用优化临床策略30。为了减少对手工奖励并提高稳定性的依赖,人类的反馈将系统行为与专家知识和特定于患者的环境保持一致31。这些进步使EAI系统推理能力能够连续完善32,,,,33,,,,34。

空间推理对于手术计划和自主导航至关重要。基于LLM的空间推理的最新发展减少了导航错误并支持了动态,顺序决策35,,,,36。高级任务计划工具(例如Prog Prompt和Socratic Planner)使系统能够将临床目标分解为可执行的子任务,并根据环境反馈动态调整计划37,,,,38。像ISR-LLM这样的框架通过使用迭代自我评估和实时适应来进一步提高不确定设置的性能39。

行动:关闭感知否决循环

动作模块将感知和推理的输出转换为精确的,上下文感知的物理操作,使EAI系统能够与物理或虚拟环境进行交互。

低级动作通常是对感官输入或外部指令的直接响应,并且受控制策略表示的约束,该策略表示编码机器人行为。具有计算效率和适应性执行复杂任务所需的有效控制政策平衡能力40。通过精确调节关节位置,机器人系统可以遵循高精度的预定义运动轨迹。力反馈机制通过在物理互动过程中实现实时调整,从而进一步提高安全性和精度41。这些低级动作通常执行确定性任务,例如在眼科设备中的仪器操纵或凝视跟踪。视觉语言动作模型通过将感官感知与运动控制相结合,从而扩展了此能力,从而响应动态变化,促进实时术中调整42。

高级操作会从内存和推理模块中整合输出,通常利用LLM,RL或混合策略。高级规划师(例如体现和LLM-Planner)合成环境和临床医生的输入,以生成自适应的,上下文感知的动作序列43。这些方法降低了对详尽预测和提高柔韧性的依赖,尤其是在视网膜修复和眼内激光手术等高风险应用中42,,,,44。

EAI在眼科中的应用

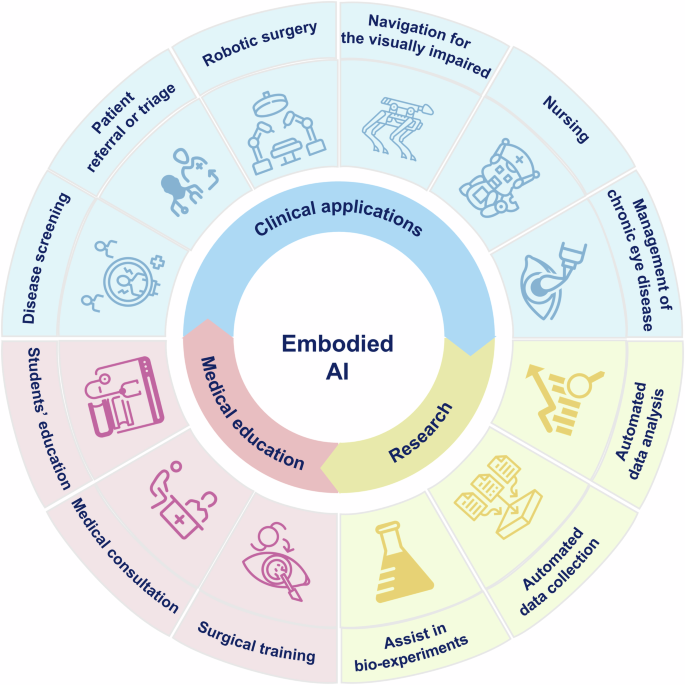

新兴的AI技术已经应用于眼科疾病的诊断和治疗45,,,,46,,,,47。随着EAI的兴起,其在眼科中的潜在应用正在引起人们的注意,包括疾病筛查和诊断,手术援助,对视力障碍的支持,医学教育和临床研究(图。2)。

临床应用中的EAI

眼病的诊断和筛查

全球老龄化的人口导致威胁性疾病的患病率上升,例如糖尿病性视网膜病,青光眼,与年龄相关的黄斑变性和白内障48。通过基于人群的筛查的早期检测对于维护视力和改善长期结果至关重要。

深度学习算法在眼病筛查中的最新应用已经达到了很高的精度49。但是,大规模实施仍然受到熟练人员和相关费用的需求的限制50,,,,51。EAI有望自主筛查,最大程度地减少人类干预。例如,EAI系统可以自动获取OCT图像并使用集成的AI算法来解释它们52,促进可扩展,快速且具有成本效益的筛选50。低成本的便携式设备也正在出现53,以及将深度学习模型与手持式红外偏心照相设备相结合的TRDS系统,可提供与桌面自动磨蚀器在不同的照明条件下相当的折射测量54。这些工具在服务不足的地区尤其有价值,包括农村,山区,高空和受冲突影响的地区,这些地区在逻辑上具有挑战性。

此外,EAI可以在初级保健和非恐怖设置中生成自动推荐建议55,,,,56。例如,Roboctnet系统集成了AI和机器人技术,以检测具有95%敏感性和76%特异性的急诊科的引用后段病理56。同样,IOMIDS平台将AI聊天机器人与多模式学习结合在一起,以基于用户历史记录和成像数据来支持自我诊断和分类57。这些系统对在家监测和更广泛的社区级筛查表现出了希望。

预计未来的EAI系统将纳入LLM,以促进自然,类似人类的互动,改善用户信任和可访问性58,,,,59,,,,60,,,,61,,,,62,,,,63,,,,64。LLM驱动的聊天机器人可以使患者在约会前或之后查询症状,作为认知引擎,以提高环境理解,决策和多模式信息集成的能力60,,,,61,,,,62,,,,63。

眼科手术助理

已利用各种手术机器人来协助眼科手术,包括玻璃体视网膜手术,白内障手术,角膜移植和斜视手术45。机器人辅助可以通过减轻生理手震动的影响来提高手术精度65。但是,当前的手术机器人通常需要操作员控制或监督,并且缺乏做出自主决定的能力66。

通过将手术机器人与实时术中监测技术(例如OCT,眼底摄影和外科视频)以及AI技术(如多模式大型模型)相结合,EAI可以增强实时感知和解释外科手术环境的能力。例如,Nespolo等。开发了一个基于Yolact ++的手术导航平台,能够检测,分类和分割仪器和组织,实现高速处理(38.77(38.77(38.77)87.44 fps)和高精度(AUPR最高为0.972)67。另一项研究使用基于区域的CNN实时分析视频帧,定位学生,识别手术阶段并在白内障手术期间提供实时反馈。68。该系统在接收器操作特性曲线值为0.996的情况下达到了面积为0.996,闪光乳化为0.972,去除皮质的0.997和0.880用于空闲相位识别。尽管这些研究并不能完全代表EAI系统,但它们为未来的EAI开发提供了关键的参考。EAI可以利用类似的CNN结构来增强环境理解,并使用实例实例分段模型来支持手术决策。

EAI有可能进一步提高眼科机器人手术的准确性和安全性。智能机器人系统可以帮助执行诸如视网膜下注射之类的精致眼科手术69,,,,70,,,,71。此外,基于AI的视频分析系统可以监测手术器械的运动,位置和深度,最大程度地减少与眼组织的意外碰撞并改善手术安全性72。例如,Wu等人。引入了一个自主机器人系统,用于视网膜下注射,该系统结合了眼内OCT,并具有深度学习的运动预测,即使在动态视网膜条件下也可以精确进行针头控制73。在自治方面,Kim等人。提出了一个基于模仿学习的导航系统,该系统在视网膜表面学习了专家工具轨迹,在不同的照明条件和仪器干扰下实现了亚毫米精度并保持稳健性74。最近,接受术中成像数据培训的RL和模仿学习剂使机器人能够在白内障手术的切口阶段自主执行任务。通过将外科医生的行动和偏好纳入培训过程,这些模型使机器人系统能够适应单个手术技术并个性化程序执行75。这些发现共同代表了在眼科手术中朝着更大的自主权和更深入整合的重要步骤。

视力障碍的体现导航

据预测,到205048。视力障碍的导航一直是一个长期的挑战。辅助工具,例如导犬,拐杖,智能手机和可穿戴设备,可以帮助盲人避免障碍,识别物体并在室内和室外环境中导航76。但是,导盲犬的有限可用性和寿命不足以满足全球出行需求。传统的辅助设备也缺乏,因为它们缺乏适应性和向用户学习或不断变化的环境学习的能力。

可以将各种智能技术集成到EAI中,以增强视力障碍的当前导航工具。例如,预计智能机器人和特殊的手杖将提供更有效的导航帮助77,,,,78。LLM可以在复杂的环境感知中支持EAI,并提供决策,改善环境理解,路径计划和动态调整22。EAI还可以通过触觉反馈,压力感应或语音识别系统与用户互动。例如,基于甘蔗的力感知系统可以实现双向交互,从而使机器人指南可以通过向前或转动来领导用户,而用户可以通过推动或拉动手势调整机器人的步行速度。与传统的辅助技术相比,基于EAI的解决方案通过不断从用户的反馈和行为学习来提供更大的智能,个性化和适应性。这些系统可以实时响应动态和不可预测的环境,通过最大程度地减少对手动调整或外部技术支持的需求来提高导航安全性并改善整体用户体验。

除导航外,EAI还可以帮助视觉障碍的人进行日常活动,例如烹饪,饮食和穿衣,从而增强其独立性79。它还可以监视环境并跟踪用户运动以防止跌倒80。此外,EAI可以通过启用基于家庭的视力监测并协助提醒和给予眼滴剂来支持慢性眼疾病的管理。通过整合智能健康聊天机器人81,EAI有望与视力障碍的使用者进行更自然的,类似人类的沟通,有助于减轻他们的负面情绪并促进心理健康。

医学教育中的EAI

对于患者,智能代理人已被雇用82。但是,传统的基于Internet的AI互动仅依赖文本或声音,缺乏肢体语言和情感表达的细微差别。EAI可以在沉浸式3D模拟器中开发智能代理,从而增强环境感知并通过面部表情,语音调制和其他渠道传达情绪。这些体现的药物可以提供更具吸引力和类似人类的互动性,从而有可能改善患者参与疾病管理。除了交互式支持外,EAI还可以帮助患者进行自我监测的疾病活动,提供有价值的数据进行随访和临床决策。例如,Notal Vision Home OCT(NVHO)使与新血管相关的黄斑变性患者每天在家进行视网膜成像。通过基于AI的软件对获得的扫描进行了分析,以检测和量化黄斑水肿,并与专家人类的评分达到超过94%的一致性83。此外,已经开发了一个机器人安装的OCT扫描仪,以从安全距离进行独立式个人图像,而无需进行操作员干预或稳定。尽管目前的分辨率仍然有限,但这种方法显示了对眼病的未来监测的潜力52。

医学生可以与EAI进行互动,以模拟眼科患者,提高他们在历史,身体检查和临床交流方面的技能,同时增加他们的学习参与84。此外,EAI也可以应用于眼科手术训练。DeepSurgery,一个基于AI的视频分析平台85,在白内障手术期间提供实时监督,并证明了专家级评估绩效(Kappa 0.58 0.77)。与机器人系统集成时,它可以通过指导手术步骤并提醒他们进行错误操作,从而帮助新手眼科医生提供帮助,从而促进了获得标准化和高效的白内障手术技术的获取。

医学研究

EAI具有通过启用自动化和大规模数据分析来改变眼科研究的潜力。传统的研究过程通常是缓慢且资源密集的,需要重复性任务,例如剂量测试,患者监测和手动数据收集。EAI可以通过自动执行这些任务,提供精确的结果并加快新疗法和药物的发展来有效改善。由EAI提供动力的高通量筛选允许同时测试多个变量,从而进一步提高了研究生产力。此外,一些需要熟练操作员的生物学实验可以通过机器人臂进行远程执行,从而扩大了研究实验室的能力86。

尽管迄今为止尚未据报道专门为眼科药物开发设计的EAI系统,但其他领域的最新进展表现出了可转移的框架和鼓舞人心的潜力。A-LAB是一种新型材料合成的自主平台,用机器人臂自动化样品转移,使用自然语言处理模型生成初始合成食谱,并采用主动学习来进行闭环优化机制87。在17天内,它在合成41种新型材料的合成中达到了71%的成功率,从而大大加速了材料发现过程。同样,在蛋白质工程和有机合成中,样本平台集成了智能代理,蛋白质设计和全自动机器人实验,以实现自主蛋白质工程88。它通过迭代地完善其对序列功能关系的理解,成功地加速了热稳定酶。这些跨学科的探索不仅验证了EAI在自动化科学研究中的有效性,而且还为眼科中的潜在应用提供了宝贵的见解,尤其是在药物筛查,疾病建模和治疗优化方面。

挑战和未来的方向

眼科中EAI的发展面临着几个挑战。在数据和算法级别上,获取大规模的,现实世界的交互式数据集并确保数据代表性困难。在系统能力方面,EAI在理解复杂环境和整合专门的眼科医学知识方面挣扎。此外,现有的评估指标不足以评估实时,交互式AI系统。最后,包括隐私,知情同意,问责制,AI偏见和卫生公平的道德问题仍然重要。

培训EA算法通常需要从现实世界环境中收集和处理大量交互数据,这通常是昂贵且资源密集的。此外,收集的数据集全面捕获现实情况的复杂性和可变性仍然很具有挑战性。尽管数据库共享可能有助于缓解数据短缺,但它引起了道德问题,特别是关于隐私保护。与虚拟仿真环境的互动提供了一种有希望的加速EAI开发方法89。但是,必须认识到,现实世界环境通常比模拟的环境更复杂和不可预测。

目前,EAI面临着限制其临床公用事业的几个关键挑战。一个主要挑战是其解释复杂和动态环境的能力不足,这可能会导致决策和任务执行的延迟90。此外,解决眼科中的这些挑战需要对专业医学知识有深刻的了解61。未来的研究应优先考虑自适应和可扩展的体现剂体系结构的发展,以提高概括能力。此外,扩大EAI中的医学知识基础对于确保眼科实践中的准确性,安全性和可靠性至关重要。

关于眼科中EAI的研究仍处于早期阶段。大多数研究主要评估基于AI的医疗设备在具有传统性能指标的临床应用中的性能,例如准确性和灵敏度。但是,鉴于EAI系统涉及与环境的实时互动,因此他们的评估需要更全面和多维协议。未来的研究应考虑适应眼科LLM和机器人系统的现有评估基准,同时纳入EAI的独特特征91,,,,92,,,,93。扩大静态数据以外的评估以包括交互式场景,将显着促进为眼科EAI建立标准化和整体评估框架94。

AI偏见和公平是在医疗保健中应用EAI的关键问题。A lack of diversity in training data, such as in gender, age, ethnicity, or geographic distribution, may lead to degraded performance in certain populations, potentially exacerbating existing health disparities95,,,,96。To promote fair and inclusive healthcare, it is imperative to adopt bias mitigation strategies and develop data governance frameworks that emphasize diversity and transparency.Furthermore, healthcare professionals must remain vigilant against automation bias and be prepared to critically evaluate and override AI-generated outputs when necessary.

Ethical and regulatory challenges in EAI are becoming increasingly prominent.Compared to traditional AI systems, EAI require more extensive evaluation and stricter regulation oversight.For example, the use of surgical robots in ophthalmic procedures introduces additional risks related to robot malfunctions97。When EAI is involved in disease diagnosis, treatment decision-making, or medical education, it is crucial that its outputs remain objective, clinically relevant, and demonstrate humanistic care.To solve these issues, autonomous smart devices intended for clinical use should obtain appropriate regulatory approval, such as FDA or CE certification, with regulatory standards tailored to their classification98,,,,99。FDA employs the “Levels of Autonomous Surgical Robots†(LASR) classification system, which categorizes robotic autonomy from Level 1 (robot-assisted) to Level 5 (fully autonomous)100。Computer scientists and healthcare professionals need to collaborate to refine classification criteria and ensure the safe and effective integration of EAI into clinical practice.In addition to technical oversight, robust governance models must be established to define accountability for clinical outcomes.In cases of errors or adverse events occur involving EAI systems, it remains unclear whether responsibility lies with developers, healthcare providers, or deploying institutions.Therefore, clear legal and ethical accountability frameworks are urgently needed.Furthermore, developers should incorporate explainability and human-in-the-loop mechanisms into EAI systems to enhance transparency, reliability and trust in clinical environments.

Lastly, privacy protection and informed consent present additional complexities in EAI systems101,,,,102。These systems often require real-time collection and processing of continuous multimodal data, including facial images, physiological parameters, and environmental information.However, the traditional model of “specific and explicit†consent is insufficient for the highly dynamic data environments associated with EAI systems.Therefore, a tiered consent framework should be established, distinguishing between physiologic data that requires strict authorization and environmental interaction metadata that can be broadly authorized.Moreover, adopting a dynamic consent process which allows patients to modify or withdraw their consent at any time would better respect patient autonomy103。Ensuring that patients make informed decisions based on a clear understanding of the EAI system’s functions, related risks, and their rights is an important step toward achieving ethical and responsible AI development.

结论

Unlike traditional Internet-based AI, EAI is characterized by real-time, context-specific interactions.EAI integrates multidisciplinary approaches and leverage its physical embodiment to interact with the environment through real-time perception, reasoning, and action, enabling self-learning and autonomous decision-making.Although still in its early stages, EAI holds significant promise in ophthalmology, with potential applications spanning rapid multimodal screening, precise surgical navigation, assistance for visually impaired individuals, personalized medical education, and efficient medical research.However, the implementation of EAI still faces challenges related to data acquisition, system architecture, and clinical integration.Future developments should focus on enhancing adaptability and decision-making, while also ensuring safe and responsible deployment through regulatory and ethical frameworks.

数据可用性

No datasets were generated or analysed during the current study.

参考

Duan, J., Yu, S., Tan, H. L., Zhu, H. & Tan, C. A survey of embodied AI: from simulators to research tasks.IEEE Trans。Emerg.顶部。计算。Intell。 6, 230–244 (2022).

文章一个 Google Scholar一个

Smith, L. & Gasser, M. The development of embodied cognition: six lessons from babies.艺术品。生活 11, 13–29 (2005).

文章一个 PubMed一个 Google Scholar一个

Strathearn, C. & Ma, M. Modelling user preference for embodied artificial intelligence and appearance in realistic humanoid robots.信息学 7, 28 (2020).

文章一个 Google Scholar一个

Kumar, K. A., Rajan, J. F., Appala, C., Balurgi, S. & Balaiahgari, P. R. Medibot: personal medical assistant.在Proc。2nd International Conference on Networking and Communications (ICNWC)1–6 (2024).

Thirunavukarasu, A. J. et al.Robot-assisted eye surgery: a systematic review of effectiveness, safety, and practicality in clinical settings.翻译。Vis.科学。技术。 13, 20 (2024).

文章一个 PubMed一个 PubMed Central一个 Google Scholar一个

Vimala, S. et al.Telemedical robot using IoT with live supervision and emergency alert.在Proc。 3rd International Conference on Pervasive Computing and Social Networking (ICPCSN)1327–1331 (IEEE, 2023).

Wang, W. et al.Neuromorphic sensorimotor loop embodied by monolithically integrated, low-voltage, soft e-skin.科学 380, 735–742 (2023).

文章一个 CAS一个 PubMed一个 Google Scholar一个

Liu, T. L. et al.Robot learning to play drums with an open-ended internal model.在Proc。IEEE International Conference on Robotics And Biomimetics (ROBIO)305–311 (IEEE, 2018).

Zhuang, Z. Y., Yu, X., Mahony, R. & IEEE.LyRN (Lyapunov Reaching Network): a real-time closed loop approach from monocular vision.在Proc。IEEE International Conference on Robotics and Automation (ICRA)8331–8337 (IEEE, 2020).

Zhao, Z. et al.Exploring embodied intelligence in soft robotics: a review.Biomimetics 9, 248 (2024).

文章一个 PubMed一个 PubMed Central一个 Google Scholar一个

Liu, Y., Tan, Y. & Lan, H. Self-supervised contrastive learning for audio-visual action recognition.在30th IEEE International Conference on Image Processing (ICIP)1000–1004 (IEEE, 2023).

Abrà moff, M. D., Lavin, P. T., Birch, M., Shah, N. & Folk, J. C. Pivotal trial of an autonomous AI-based diagnostic system for detection of diabetic retinopathy in primary care offices.npj Digit.医学 1, 39 (2018).

文章一个 PubMed一个 PubMed Central一个 Google Scholar一个

Ting, D. S. W. et al.Deep learning in ophthalmology: the technical and clinical considerations.Prog.Retin.Eye Res. 72, 100759 (2019).

文章一个 PubMed一个 Google Scholar一个

Shi, D. et al.Translation of color fundus photography into fluorescein angiography using deep learning for enhanced diabetic retinopathy screening.Ophthalmol.科学。 3, 100401 (2023).

文章一个 PubMed一个 PubMed Central一个 Google Scholar一个

Chen, R. et al.Translating color fundus photography to indocyanine green angiography using deep-learning for age-related macular degeneration screening.npj Digit.医学 7, 34 (2024).

文章一个 PubMed一个 PubMed Central一个 Google Scholar一个

Song, F., Zhang, W., Zheng, Y., Shi, D. & He, M. A deep learning model for generating fundus autofluorescence images from color fundus photography.ADV。Ophthalmol.PR。res。 3, 192–198 (2023).

Zhou,Y。等。从视网膜图像中检测可概括的疾病检测的基础模型。自然 622,156 - 163(2023)。

文章一个 CAS一个 PubMed一个 PubMed Central一个 Google Scholar一个

Shi, D. et al.EyeFound: a multimodal generalist foundation model for ophthalmic imaging.arxivpreprint at.https://doi.org/10.48550/arXiv.2405.11338(2024)。

Shi, D. et al.EyeCLIP: A visual-language foundation model for multi-modal ophthalmic image analysis.arxivpreprint at.https://doi.org/10.48550/arXiv.2409.06644(2024)。

Wang, T. et al.EmbodiedScan: a holistic multi-modal 3D perception suite towards embodied AI.在Proc。IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR)19757–19767 (IEEE,,,,2024).

Mieling, R. et al.Collaborative robotic biopsy with trajectory guidance and needle tip force feedback.在Proc。 IEEE International Conference on Robotics and Automation (ICRA)6893–6900 (IEEE,,,,2023)。

Lin, J. et al.Advances in embodied navigation using large language models: a survey.arxivpreprint at.https://arxiv.org/abs/2311.00530(2024)。

Gao, S. et al.Empowering biomedical discovery with AI agents.细胞 187, 6125–6151 (2024).

文章一个 CAS一个 PubMed一个 Google Scholar一个

Liu, S. et al.Long short-term human motion prediction in human-robot co-carrying.在Proc。International Conference on Advanced Robotics and Mechatronics (ICARM)815–820 (IEEE, 2023).

Wang, W. et al.Augmenting Language Models with Long-Term Memory.在Advances in Neural Information Processing Systems(eds Oh, A. et al.)36, 74530–74543 (Curran Associates, Inc., 2023).

Wang,J。等。Large language models for robotics: Opportunities, challenges, and perspectives.Journal of Automation and Intelligence 4, 52–64 (2025).

文章一个 Google Scholar一个

Wei, J. et al.Chain-of-thought prompting elicits reasoning in large language models.在36th Conference on Neural Information Processing Systems (NeurIPS)(eds. Koyejo, S. et al.) (Neural Information Processing Systems (NIPS), 2022).

Wang,X。等。Self-Consistency Improves Chain of Thought Reasoning in Language Models.The Eleventh International Conference on Learning Representations。https://openreview.net/forum?id=1PL1NIMMrw(2023)。

Wang,D。等。Hierarchical graph neural networks for causal discovery and root cause localization.arxivpreprint at.https://arxiv.org/abs/2302.01987(2023)。

Mnih, V. et al.Playing Atari with deep reinforcement learning.arxivpreprint at。https://arxiv.org/abs/1312.5602(2013)。

Gomaa, A. & Mahdy, B. Unveiling the role of expert guidance: a comparative analysis of user-centered imitation learning and traditional reinforcement learning.arxivpreprint at.https://arxiv.org/abs/2410.21403(2024)。

Zhang, R. et al.A graph-based reinforcement learning-enabled approach for adaptive human-robot collaborative assembly operations.J. Manuf.系统。 63, 491–503 (2022).

文章一个 Google Scholar一个

Zhang,Y。等。Towards efficient LLM grounding for embodied multi-agent collaboration.arxivpreprint at.https://arxiv.org/abs/2405.14314(2024)。

Wang, L., Fei, Y., Tang, H. & Yan, R. CLFR-M: Continual learning framework for robots via human feedback and dynamic memory.在Proc。IEEE International Conference on Cybernetics and Intelligent Systems (CIS) and IEEE International Conference on Robotics, Automation and Mechatronics (RAM)216–221 (IEEE, 2024).

Deng, H., Zhang, H., Ou, J. & Feng, C. Can LLM be a good path planner based on prompt engineering?Mitigating the hallucination for path planning.arxivpreprint at.https://arxiv.org/abs/2408.13184(2024)。

Chen, L. et al.Towards end-to-end embodied decision making via multi-modal large language model: explorations with GPT4-vision and beyond.NeurIPS 2023 Foundation Models for Decision Making Workshop。https://openreview.net/forum?id=rngOtn5p7t(2023)。

Singh, I. et al.ProgPrompt: generating situated robot task plans using large language models.在Proc。IEEE International Conference on Robotics and Automation (ICRA)11523–11530 (IEEE, 2023).

Shin, S., jeon, S., Kim, J., Kang, G.-C.& Zhang, B.-T.Socratic planner: inquiry-based zero-shot planning for embodied instruction following.arxivpreprint at.https://arxiv.org/abs/2404.15190(2024)。

Zhou, Z., Song, J., Yao, K., Shu, Z. & Ma, L. ISR-LLM: iterative self-refined large language model for long-horizon sequential task planning.在Proc。IEEE International Conference on Robotics and Automation (ICRA)2081–2088 (IEEE, 2024).

Yihao, L. et al.From screens to scenes: a survey of embodied AI in healthcare.inf。融合 119, 103033 (2025).

文章一个 Google Scholar一个

Huang, P. I. Y. Enhancement of robot position control for dual-user operation of remote robot system with force.反馈 14, 9376 (2024).

CAS一个 Google Scholar一个

Ding, P. et al.QUAR-VLA: Vision-Language-Action Model for Quadruped Robots.在Computer Vision – ECCV 2024(eds Leonardis, A. et al.) Vol.15063, 352–367 (Springer Nature Switzerland, Cham, 2025).

Mu, Y. et al.EmbodiedGPT: Vision-Language Pre-Training via Embodied Chain of Thought.在Advances in Neural Information Processing Systems(eds Oh, A. et al.) Vol.36, 25081–25094 (Curran Associates, Inc., 2023).

Song, C. H. et al.LLM-Planner: Few-Shot Grounded Planning for Embodied Agents with Large Language Models.在2023 IEEE/CVF International Conference on Computer Vision (ICCV)2986–2997 (IEEE, 2023).

Alafaleq, M. Robotics and cybersurgery in ophthalmology: a current perspective.J. Robot。外科。 17, 1159–1170 (2023).

文章一个 PubMed一个 Google Scholar一个

Nielsen, K. B., Lautrup, M. L., Andersen, J. K., Savarimuthu, T. R. & Grauslund, J. Deep learning–based algorithms in screening of diabetic retinopathy: a systematic review of diagnostic performance.Ophthalmol.Retin. 3, 294–304 (2019).

文章一个 Google Scholar一个

Zhu, Y. et al.Advancing glaucoma care: integrating artificial intelligence in diagnosis, management, and progression detection.生物工程 11, 122 (2024).

文章一个 PubMed一个 PubMed Central一个 Google Scholar一个

GBD 2019 Blindness and Vision Impairment Collaborators, Vision Loss Expert Group of the Global Burden of Disease Study Trends in prevalence of blindness and distance and near vision impairment over 30 years: an analysis for the Global Burden of Disease Study.Lancet Glob.健康 9, e130–e143 (2021).

文章一个 Google Scholar一个

Vujosevic, S., Limoli, C. & Nucci, P. Novel artificial intelligence for diabetic retinopathy and diabetic macular edema: what is new in 2024?.Curr。意见。Ophthalmol. 35, 472–479 (2024).

文章一个 PubMed一个 PubMed Central一个 Google Scholar一个

Liu, H. et al.Economic evaluation of combined population-based screening for multiple blindness-causing eye diseases in China: a cost-effectiveness analysis.Lancet Glob.健康 11, e456–e465 (2023).

文章一个 CAS一个 PubMed一个 Google Scholar一个

Kang, E. Y.-C.等。A multimodal imaging–based deep learning model for detecting treatment-requiring retinal vascular diseases: model development and validation study.JMIR Med.通知。 9, e28868 (2021).

文章一个 PubMed一个 PubMed Central一个 Google Scholar一个

Draelos, M. et al.Contactless optical coherence tomography of the eyes of freestanding individuals with a robotic scanner.纳特。生物。工程。 5, 726–736 (2021).

文章一个 PubMed一个 PubMed Central一个 Google Scholar一个

He, S. et al.Bridging the camera domain gap with image-to-image translation improves glaucoma diagnosis.翻译。Vis.科学。技术。 12, 20–20 (2023).

文章一个 PubMed一个 PubMed Central一个 Google Scholar一个

Zhen, Y., Yan, H., Qilin, S., Hong, C. & Wei, T. Artificial intelligence-enabled low-cost photorefraction for accurate refractive error measurement under complex ambient lighting conditions: a model development and validation study.Available at SSRN 5064133.(2024)。

Vought, R., Vought, V., Szirth, B. & Khouri, A. S. Future direction for the deployment of deep learning artificial intelligence: Vision threatening disease detection in underserved communities during COVID-19.Saudi J. Ophthalmol. 37, 193–199 (2023).

文章一个 PubMed一个 PubMed Central一个 Google Scholar一个

Song, A. et al.RobOCTNet: robotics and deep learning for referable posterior segment pathology detection in an emergency department population.翻译。Vis.科学。技术。 13, 12 (2024).

文章一个 PubMed一个 PubMed Central一个 Google Scholar一个

Ma, R. et al.Multimodal machine learning enables AI chatbot to diagnose ophthalmic diseases and provide high-quality medical responses.npj Digit.医学 8, 1–18 (2025).

文章一个 Google Scholar一个

Yang, Z. et al.Understanding natural language: potential application of large language models to ophthalmology.Asia Pac.J. Ophthalmol. 13, 100085 (2024).

文章一个 Google Scholar一个

Chotcomwongse, P., Ruamviboonsuk, P. & Grzybowski, A. Utilizing large language models in ophthalmology: the current landscape and challenges.Ophthalmol.ther。 13, 2543–2558 (2024).

文章一个 PubMed一个 PubMed Central一个 Google Scholar一个

Chen, X. et al.FFA-GPT: an automated pipeline for fundus fluorescein angiography interpretation and question-answer.npj Digit.医学 7, 111 (2024).

文章一个 PubMed一个 PubMed Central一个 Google Scholar一个

Chen, X. et al.EyeGPT for Patient Inquiries and Medical Education: Development and Validation of an Ophthalmology Large Language Model.医学互联网研究杂志 26, e60063 (2024).

文章一个 PubMed一个 PubMed Central一个 Google Scholar一个

Chen, X. et al.ICGA-GPT: report generation and question answering for indocyanine green angiography images.br。J. Ophthalmol. 108, 1450–1456 (2024).

文章一个 PubMed一个 Google Scholar一个

Chen, X. et al.ChatFFA: an ophthalmic chat system for unified vision-language understanding and question answering for fundus fluorescein angiography.Iscience 27, 110021 (2024).

文章一个 CAS一个 PubMed一个 PubMed Central一个 Google Scholar一个

Jin, K., Yuan, L., Wu, H., Grzybowski, A. & Ye, J. Exploring large language model for next generation of artificial intelligence in ophthalmology.正面。医学 10, 1291404 (2023).

文章一个 Google Scholar一个

Roizenblatt, M., Grupenmacher, A. T., Belfort Junior, R., Maia, M. & Gehlbach, P. L. Robot-assisted tremor control for performance enhancement of retinal microsurgeons.br。J. Ophthalmol. 103, 1195–1200 (2019).

文章一个 PubMed一个 Google Scholar一个

Gerber, M. J., Pettenkofer, M. & Hubschman, J. P. Advanced robotic surgical systems in ophthalmology.眼睛 34, 1554–1562 (2020).

文章一个 PubMed一个 PubMed Central一个 Google Scholar一个

Nespolo, R. G. et al.Feature Tracking and segmentation in real time via deep learning in vitreoretinal surgery: a platform for artificial intelligence-mediated surgical guidance.Ophthalmol.Retin. 7, 236–242 (2023).

文章一个 Google Scholar一个

Garcia Nespolo, R. et al.Evaluation of artificial intelligence-based intraoperative guidance tools for phacoemulsification cataract surgery.JAMA Ophthalmol. 140, 170–177 (2022).

文章一个 PubMed一个 PubMed Central一个 Google Scholar一个

Zhou, M. et al.Needle detection and localisation for robot-assisted subretinal injection using deep learning.CAAI Trans.Intell。技术。1–13 (2023).

Huang, Y., Asaria, R., Stoyanov, D., Sarunic, M. & Bano, S. PseudoSegRT: efficient pseudo-labelling for intraoperative OCT segmentation.Int J. Comput.协助。收音机。外科。 18, 1245–1252 (2023).

文章一个 Google Scholar一个

Ladha, R., Meenink, T., Smit, J. & de Smet, M. D. Advantages of robotic assistance over a manual approach in simulated subretinal injections and its relevance for gene therapy.Gene Ther. 30, 264–270 (2023).

文章一个 CAS一个 PubMed一个 Google Scholar一个

Baldi, P. F. et al.Vitreoretinal surgical instrument tracking in three dimensions using deep learning.翻译。Vis.科学。技术。 12, 20 (2023).

文章一个 PubMed一个 PubMed Central一个 Google Scholar一个

Wu, T. et al.Deep learning-enhanced robotic subretinal injection with real-time retinal motion compensation.arxivpreprint at.https://arxiv.org/abs/2504.03939(2025)。

Kim, J. W. et al.Autonomously navigating a surgical tool inside the eye by learning from demonstration.在Proc。 IEEE International Conference on Robotics and Automation (ICRA)7351–7357 (IEEE, 2020).

Gomaa, A., Mahdy, B., Kleer, N. & Krüger, A. Towards a surgeon-in-the-loop ophthalmic robotic apprentice using reinforcement and imitation learning.在Proc。IEEE/RSJ International Conference on Intelligent Robots and Systems (IROS)6939–6946 (IEEE, 2024).

Messaoudi, M. D., Menelas, B. J. & McHeick, H. Review of navigation assistive tools and technologies for the visually impaired.传感器22, 7888 (2022).

文章一个 PubMed一个 PubMed Central一个 Google Scholar一个

Tang, T. et al.Special cane with visual odometry for real-time indoor navigation of blind people.在IEEE International Conference on Visual Communications and Image Processing (VCIP)255–255 (IEEE, 2020).

Zhang,Y。等。Visual Navigation of Mobile Robots in Complex Environments Based on Distributed Deep Reinforcement Learning.在2022 6th Asian Conference on Artificial Intelligence Technology (ACAIT)1–5 (IEEE, 2022).

Guo, C. & Li, H. Application of 5G network combined with AI robots in personalized nursing in China: a literature review.正面。公共卫生 10, 948303 (2022).

文章一个 PubMed一个 PubMed Central一个 Google Scholar一个

Juang, L. H. & Wu, M. N. Fall Down Detection Under Smart Home System.J. Med。系统。 39, 107 (2015).

文章一个 PubMed一个 Google Scholar一个

Chen, X. et al.Visual Question Answering in Ophthalmology: a progressive and practical perspective.arxivpreprint at.https://arxiv.org/abs/2410.16662(2024)。

Tam, W. et al.Nursing education in the age of artificial intelligence powered Chatbots (AI-Chatbots): Are we ready yet?.Nurse Educ.今天 129, 105917 (2023).

文章一个 PubMed一个 Google Scholar一个

Liu, Y., Holekamp, N. M. & Heier, J. S. Prospective, longitudinal study: daily self-imaging with home OCT for neovascular age-related macular degeneration.Ophthalmol.Retin. 6, 575–585 (2022).

文章一个 Google Scholar一个

Chen, J., Zhan, X., Wang, Y. & Huang, X. Medical robots based on artificial intelligence in the medical education.在Proc。2nd International Conference on Artificial Intelligence and Education (ICAIE)1–4 (IEEE, 2021).

Wang, T. et al.Intelligent cataract surgery supervision and evaluation via deep learning.int。J. Surg. 104, 106740 (2022).

文章一个 PubMed一个 Google Scholar一个

Hamm, J. et al.A Modular robotic platform for biological research: cell culture automation and remote experimentation.ADV。Intell。系统。 6, 2300566 (2024).

文章一个 Google Scholar一个

Szymanski, N. J. et al.An autonomous laboratory for the accelerated synthesis of novel materials.自然 624, 86–91 (2023).

文章一个 CAS一个 PubMed一个 PubMed Central一个 Google Scholar一个

Rapp, J. T., Bremer, B. J. & Romero, P. A. Self-driving laboratories to autonomously navigate the protein fitness landscape.纳特。化学工程。 1, 97–107 (2024).

文章一个 PubMed一个 PubMed Central一个 Google Scholar一个

Tan, T. F. et al.Metaverse and virtual health care in ophthalmology: opportunities and challenges.Asia Pac.J. Ophthalmol.11, 237–246 (2022).

文章一个 Google Scholar一个

Kang, D., Nam, C. & Kwak, S. S. Robot feedback design for response delay.int。J. Soc.机器人。 16, 341–361 (2023).

文章一个 Google Scholar一个

Chen, X. et al.Evaluating large language models and agents in healthcare: key challenges in clinical applications.Intelligent Medicine 5, 151–163 (2025).

文章一个 Google Scholar一个

Xu, P., Chen, X., Zhao, Z. & Shi, D. Unveiling the clinical incapabilities: a benchmarking study of GPT-4V(ision) for ophthalmic multimodal image analysis.br。J. Ophthalmol. 108, 1384–1389 (2024).

文章一个 PubMed一个 Google Scholar一个

Majumdar, A. et al.Openeqa: Embodied question answering in the era of foundation models.在Proc。IEEE/CVF Conference on Computer Vision and Pattern Recognition16488–16498 (IEEE, 2024).

Cheng, Z. et al.EmbodiedEval: evaluate multimodal LLMs as embodied agents.arxivpreprint at.https://arxiv.org/abs/2501.11858(2025)。

Mahamadou, A. J. D. & Trotsyuk, A. A. Revisiting technical bias mitigation strategies.安努。Rev. Biomed.Data Sci. 8, (2025).

Hofmann, V., Kalluri, P. R., Jurafsky, D. & King, S. AI generates covertly racist decisions about people based on their dialect.自然 633, 147–154 (2024).

文章一个 CAS一个 PubMed一个 PubMed Central一个 Google Scholar一个

Di Paolo, M., Boggi, U. & Turillazzi, E. Bioethical approach to robot-assisted surgery.br。J. Surg. 106, 1271–1272 (2019).

文章一个 PubMed一个 Google Scholar一个

O'Sullivan, S. Legal, regulatory, and ethical frameworks for development of standards in artificial intelligence (AI) and autonomous robotic surgery.int。J. Med。机器人。计算。协助。外科 15, e1968 (2019).

文章一个 Google Scholar一个

Biswas, P., Sikander, S. & Kulkarni, P. Recent advances in robot-assisted surgical systems.生物。工程。ADV。 6, 100109 (2023).

文章一个 Google Scholar一个

Lee, A., Baker, T. S., Bederson, J. B. & Rapoport, B. I. Levels of autonomy in FDA-cleared surgical robots: a systematic review.npj Digit.医学 7, 103 (2024).

文章一个 PubMed一个 PubMed Central一个 Google Scholar一个

Fiske, A., Henningsen, P. & Buyx, A. Your Robot Therapist Will See You Now: Ethical Implications of Embodied Artificial Intelligence in Psychiatry, Psychology, and Psychotherapy.J. Med。Internet Res. 21, e13216 (2019).

文章一个 PubMed一个 PubMed Central一个 Google Scholar一个

Vats, T. et al.Navigating the landscape: Safeguarding privacy and security in the era of ambient intelligence within healthcare settings.Cyber Security Appl. 2, 100046 (2024).

文章一个 Google Scholar一个

Tamuhla, T., Tiffin, N. & Allie, T. An e-consent framework for tiered informed consent for human genomic research in the global south, implemented as a REDCap template.BMC Med。伦理 23, 119 (2022).

文章一个 PubMed一个 PubMed Central一个 Google Scholar一个

致谢

The study was supported by the Start-up Fund for RAPs under the Strategic Hiring Scheme (P0048623) from the Hong Kong Polytechnic University, the Global STEM Professorship Scheme (P0046113) from HKSAR and Henry G. Leong Endowed Professorship in Elderly Vision Health.We thank the InnoHK HKSAR Government for providing valuable supports.The research work described in this paper was conducted in the JC STEM Lab of Innovative Light Therapy for Eye Diseases funded by The Hong Kong Jockey Club Charities Trust.

道德声明

竞争利益

作者没有宣称没有竞争利益。

附加信息

Publisher’s note关于已发表的地图和机构隶属关系中的管辖权主张,Springer自然仍然是中立的。

权利和权限

开放访问This article is licensed under a Creative Commons Attribution-NonCommercial-NoDerivatives 4.0 International License, which permits any non-commercial use, sharing, distribution and reproduction in any medium or format, as long as you give appropriate credit to the original author(s) and the source, provide a link to the Creative Commons licence, and indicate if you modified the licensed material.You do not have permission under this licence to share adapted material derived from this article or parts of it.The images or other third party material in this article are included in the article’s Creative Commons licence, unless indicated otherwise in a credit line to the material.If material is not included in the article’s Creative Commons licence and your intended use is not permitted by statutory regulation or exceeds the permitted use, you will need to obtain permission directly from the copyright holder.To view a copy of this licence, visithttp://creativecommons.org/licenses/by-nc-nd/4.0/。重印和权限

引用本文

Qiu, Y., Chen, X., Wu, X.

等。Embodied artificial intelligence in ophthalmology.npj Digit.医学 8, 351 (2025).https://doi.org/10.1038/s41746-025-01754-4

已收到:

公认:

出版:

doi:https://doi.org/10.1038/s41746-025-01754-4