在重症监护医学中实施人工智能:共识22

作者:Bihorac, Azra

人工智能(AI)正在迅速进入重症监护,它具有提高诊断准确性和预后的潜力,简化重症监护室(ICU)工作流以及启用个性化护理。[1,,,,2]没有结构化的实施,评估和控制方法,这种转变可能会受到阻碍或可能导致患者的伤害和意外的后果。

尽管需要支持面临人员短缺,案件复杂性和成本上升的压倒性ICU,但在实际情况下,大多数AI工具仍未得到验证和未经测试。[3,,,,45这是给出的

为了解决这一差距,我们发布了重症监护界的呼吁:将AI集成到ICU中,必须遵循务实的,临床知情和风险意识的框架。[6,,,,7,,,,8[]由于具有强化主义者,AI研究人员,数据科学家和专家的多学科共识过程,本文提供了具体的建议,以指导AI安全,有效和有意义的AI采用。

方法

本手稿中提出的共识是通过专家讨论而不是正式的评分或对证据进行投票的出现的,因为认识到重症监护中的AI是一个迅速发展的领域,许多关键问题仍未得到解决。通过共识主持人(MC,AB,FT和JLV)选择参与者,以其对重症监护AI的认可贡献,以确保临床最终用户和AI开发人员的代表性。讨论与跨领域的故意参与,通过对现实世界中的挑战,当前的研究和监管景观的批判性研究进行了迭代。

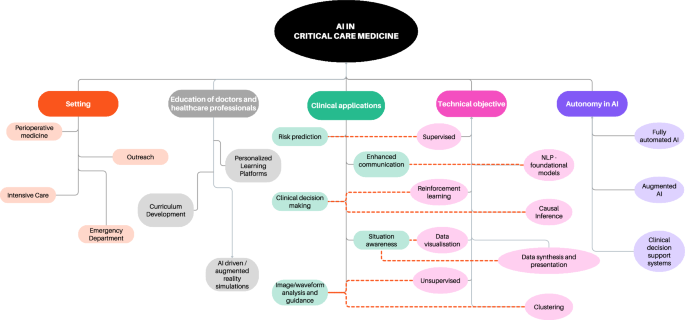

虽然纯粹是基于传统证据评分,但该手稿反映了严格的,专家驱动的对AI在重症监护中的关键障碍和机会的综合,旨在弥合现有的知识差距并在快速发展的领域提供可行的指导。指导医生在这个复杂而迅速发展的领域[9],一些当前的分类学和分类如图所示。 1。

重症监护中AI整合的主要障碍和挑战

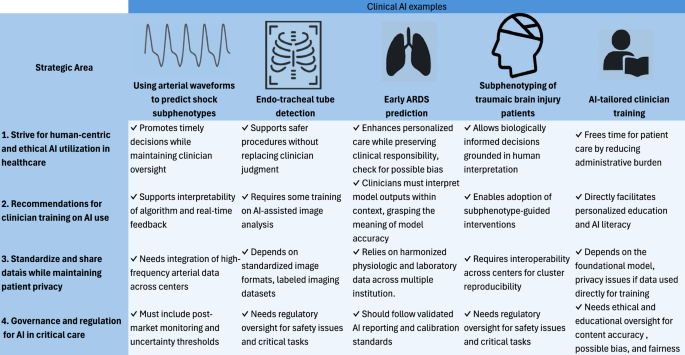

本节提出了由专家共识确定的重症监护中AI实施的主要障碍。这些未解决和不断发展的挑战促使我们向医师和其他医疗保健工作者,患者和社会利益相关者提出了一系列建议,强调了我们认为应该指导AI在医疗保健领域的进步的原则。挑战和原则分为四个主要领域,1)以人为中心的AI;2)建议有关AI使用的临床医生培训;3)数据模型和网络的标准化以及4)AI治理。这些总结在图中 2并在下一段中更详细地讨论。图2

因此,AI开发是由主要技术公司领导的,其目标可能并不总是与患者或医疗保健系统的目标保持一致[10,,,,11]。新AI模型的快速扩散与基于证据的医学文化形成鲜明对比。这引起了人们对部署未充分验证临床模型的担忧。[12这是给出的

此外,许多模型是使用占主导地位易受攻击的数据集开发的,导致算法偏差。[13] AI模型可能既缺乏时间有效性(在不同时间内应用于新数据)和地理有效性(当在不同的机构或区域中应用时)。时间或地理疾病模式的变异性,包括人口统计学,医疗保健基础设施和电子健康记录设计(EHR)的变异性,使普遍性更加复杂。

最后,使用人工智能引起了道德问题,包括对算法建议的信任以及在医学实践核心削弱人类联系的风险,即医生与患者之间的千年关系。[14这是给出的

建议

在这里,我们报告建议,分为四个领域。图 3报告了五个代表性AI用例的摘要,这些案例从波形分析到在这四个领域中绘制的个性化临床医生培训。

努力以人为中心和道德的AI利用率

除了其巨大的潜在收益外,AI滥用的风险不能被低估。当过早部署没有足够控制的情况下,AI算法可能是有害的[9,,,,15,,,,16,,,,17]。除了建立以维持控制的监管框架之外(以教派呈现。”重症监护中AI的治理和法规”)[18,,,,19]我们主张临床医生参与此过程并提供指导。

在医疗保健中开发以人为中心的AI

AI医学和医疗保健方面的发展应保持以人为中心的观点,促进同情心护理,并增加分配给患者 - 医师沟通和互动的时间。例如,使用AI在耗时或官僚任务中取代人类,例如文档和护理转移[20,,,,21,,,,22]。它可以制定临床笔记,确保在健康记录中准确捕获关键信息,同时减轻行政负担[23]。

建立在医疗保健中AI使用的社会合同

有一个很大的关注,AI可能会加剧社会医疗保健差异[24]。当考虑AI对医师的选择和行为的潜在影响时,应严格检查或加强加强偏见的可能性,以避免持续现有的健康不平等和不公平的数据驱动协会[24]。因此,让患者和社会代表参与讨论下一个医疗保健时代的愿景,其运营,目标和行动限制的讨论至关重要[25]。理想的目的是在医疗保健中建立AI的社会合同,以确保AI在医疗保健中的问责制和透明度。AI在医疗保健领域的社会契约应为所有利益相关者,患者,开发商,监管机构和管理人员定义明确的角色和责任。这包括临床医生的配备,可以批判性地评估AI工具,开发人员确保透明度,安全性和临床相关性,以及执行绩效,公平性和部署后监控标准的监管机构。我们倡导医院建立正式的监督机制,例如专门的AI委员会,以确保安全实施AI系统。这样的结构将有助于正式分享责任制,并确保AI部署与公平,安全和以人为本护理的核心价值保持一致。

优先考虑临床AI中的人类监督和道德治理

自希波克拉底宣誓以来,患者的护理一直基于医生与患者的联系,临床医生承担道德责任,以最大程度地利用患者的福利,同时最大程度地减少伤害。随着AI技术越来越多地整合到医疗保健中,他们的责任也必须扩展到监督其发展和应用。在ICU中,治疗决策在个别患者的偏好和社会考虑之间平衡的情况下,医疗保健专业人员必须领导这一转变[26]。作为强化主义者,我们应该保持对这一过程的治理,确保道德原则和科学严谨指导框架的发展,以衡量公平性,评估偏见并为AI不确定性建立可接受的阈值[6,,,,7,,,,8]。

尽管AI模型正在迅速出现,但大多数模型都在医学界之外开发。为了更好地使AI发展与临床伦理相结合,我们建议将包括临床医生,患者,伦理学家和技术专家组成的跨学科委员会纳入,他们应负责系统地审查重症监护中的算法行为,评估偏见的风险,并在决策过程中促进透明度。在这种情况下,AI开发提供了重新思考和推进患者护理中的道德原则的机会。

有关AI使用的临床医生培训的建议

开发和评估人类界面

尽管有一些有希望的结果[27,,,,28],AI的临床应用仍然有限[29,,,,30,,,,31]。迈向整合的第一步是了解临床医生如何与AI相互作用以及设计补充而不是破坏临床推理的系统[32]。这转化为对人类界面进行特定研究的需求,在该界面中,关键的关键领域是确定临床医生和AI系统之间最有效的认知接口。一方面,医生可能会对AI模型结果过度信任,可能会忽略关键信息。例如,在败血症检测中,由于训练数据的限制,AI算法可能会错过非典型表现或热带传染病。如果临床医生过于信任该算法的负产量,则可能会延迟发起必要的抗生素。另一方面,临床医生的行为可以以意想不到的方式影响AI的反应。为了更好地反映这种互动,过去几年提出了人与AI之间的协同作用,强调AI支持而不是取代人类临床医生[33]。这种合作已以两种形式描述:人类的增强(当人AI界面与单独人类相比相比相比增强临床表现)和人类协同作用(在此组合性能分别超过了人类和AI的临床表现)[34]。为了支持在重症监护临床实践中引入AI,我们建议从人类增强的概念开始,根据医学文献,它更具包容性和更好的建立[34]。后者的一个直接示例是开发可解释的实时仪表板,将复杂的多维数据合成为视觉格式,从而增强了临床医生的情境意识而不会压倒它们。

改善AI的疾病表征

根据一些简单的标准对患者进行分类和标记疾病和综合症标签的传统程序是医学教育的基础,但他们可能无法掌握潜在的病理学的复杂性并导致次优护理。在重症监护中,在患者状况复杂且迅速发展的情况下,AI驱动的表型通过利用大量遗传,放射学,生物标志物和生理数据而起着至关重要的作用。基于AI的表型方法可以大致分为两种方法。

一种方法涉及无监督的聚类,其中患者根据共享特征或模式进行分组而无需事先标记。Seymour等。证明了机器学习如何使用高维数据将化粪池患者分类为临床上有意义的亚组,这些数据随后可以为风险评估和预后提供信息[35]。另一个有前途的可能性是使用有监督或半监督的聚类技术,该技术结合了已知结果或部分标记,以增强患者亚组的表型[36]。

第二种方法属于因果推理框架,在该因果框架中进行表型的进行具体目标是识别因因果关系而受益于特定干预措施的亚组。该方法旨在通过确定治疗的影响如何变化来增强个性化治疗,以确保疗法针对最有可能受益的患者。例如,机器学习已根据对特定治疗干预措施的反应来对重症患者进行分层,从而有可能改善临床结果[37]。在大量的ICU脑损伤患者(TBI)患者中,基于神经系统和代谢谱的组合,无监督的聚类确定了六个不同的亚组。[38这是给出的

这些方法通过确保AI驱动的表型不仅具有描述性,而且可以采取可行,从而具有巨大的潜力来推进急性和重症监护。在将这些方法结合到临床工作流程中之前,我们需要确保临床医生可以接受广泛综合症和特定的子表型之间的范式转变,最终支持向个性化医学的过渡[35,,,,39,,,,40,,,,41]。

确保AI培训负责在医疗保健中使用AI

除临床实践外,本科医学教育还受到AI转化的直接影响[42]由于未来的工人需要能够理解和使用这些技术。从他们的教育开始时提供培训和知识,都要求所有临床医生都了解数据科学和AI的基本概念,方法和局限性,这些概念,方法和局限性应包括在医学学位核心课程中。这将使临床医生能够批判性地使用和评估AI,确定偏见和局限性并做出明智的决定,这可能最终使医学界的身份危机受益,并为数据分析和AI研究提供新的职业[42]。

除了本科教育外,必须培训经验丰富的医生,护士和其他盟友健康专业人员[43]。人工智能对学术教育的影响很深,超出了当前手稿的范围。一个有前途的例子是使用AI来支持临床教育和理解与AI相关的概念的个性化的,AI驱动的培训[44]。聊天机器人,自适应模拟平台和智能辅导系统等工具可以实时适应学生的学习需求,从而提供量身定制的教育。这可以应用于AI领域的临床培训和培训。

接受医疗决策的不确定性

不确定性是临床决策的内在组成部分,临床医生熟悉临床医生,并接受了培训,可以通过经验和直觉进行导航。但是,AI模型引入了一种新型的不确定性,这可能会破坏临床医生的信任,尤其是当模型充当不透明的黑匣子时[45,,,,46,,,,47]。这增加了模型和临床判断之间的认知距离,因为临床医生不知道如何解释它。为了弥合这一差距,出现了可解释的AI(XAI),提供了使模型预测更容易解释的工具,理想情况下,更值得信赖,以降低感知的不确定性[48]。

然而,我们认为仅仅解释性是不够的[48]。为了加速AI的采用和信任,我们提倡必须培训医生,以解释在不确定性下使用诸如合理性,与已知生物学的一致性以及与巩固临床推理保持一致的框架下的产量。49]。

在维护患者隐私的同时标准化和共享数据

在本节中,我们介绍了重症监护中AI部署的关键基础架构[50]。他们的成本应被视为对患者结果的投资,过程效率和降低运营成本。将数据所有权保留在医疗机构中,并承认患者和提供者为利益相关者,使他们可以从数据创造的价值中受益。相反,没有保障措施的临床数据风险成为私人公司的专有产品,这些产品被转向其来源机构,而不是通过合成数据集的开发和许可[51]。

标准化数据以促进可重复的AI模型

标准化数据收集对于创建可推广和可重现的AI模型以及促进不同中心和系统之间的互操作性至关重要。急性和重症监护的一个关键挑战是数据源的可变性,包括EHR,多组学数据(基因组学,转录组学,蛋白质组学和代谢组学),医学成像(放射学,病理学和超声波)以及临床注释和报告中的非结构化自由行数据。这些不同的数据方式对于开发AI驱动的决策支持工具至关重要,但是由于跨医疗机构的结构,格式和质量差异,它们的集成很复杂。

例如,ICU中器官功能障碍的检测,由不同的设备收集的血液动力学监测,不同制造商从呼吸机中收集的呼吸参数以及本地政策和法规的变化都会影响EHR数据质量,结构,结构,一致性以及不同中心的一致性和临床试验。

嵌入标准词汇(如LoINC和SNOMED CT)的观察性医学结果合作伙伴关系(OMOP)共同数据模型(CDM)继续受欢迎,作为构建医疗保健数据的框架,实现了交叉中心数据交换和模型互操作性[52,,,,53,,,,54]。同样,快速医疗保健互操作性资源(FHIR)提供了灵活的标准化信息交换解决方案,促进了结构化数据的实时可访问性[55]。

医院,设备和EHR公司必须为采用公认的标准做出贡献,以确保互操作性不是AI实施的障碍。

除了结构化数据之外,AI还具有通过自动标记和标记数据源,跟踪出处以及跨机构统一数据格式来增强数据标准化的潜力。利用AI执行这些任务可以帮助减轻数据不一致,从而提高AI驱动的临床应用的可靠性和可扩展性。

优先考虑数据安全,保障和患者隐私

数据安全,安全性和隐私都是在重症监护中应用AI的。数据安全是指保护数据免受意外损失或系统故障的保护,而数据安全性与恶意攻击的防御策略有关,包括黑客攻击,勒索软件或未经授权的数据访问[56]。在现代医院,数据安全和保障很快就会像手术室中的墙氧一样重要[57,,,,58]。医院护理期间,损坏或骇客的临床数据集可能与失电,药物或氧气一样灾难性。最后,数据隐私侧重于保护个人信息的保护,以确保根据法律标准存储和访问患者数据[56]。

实施优先考虑这三个支柱的AI对于医疗保健中的弹性数字基础设施至关重要。医学界的一种可能选择是支持开源模式,以提高透明度并减少对专有算法的依赖,并可能能够更好地控制分布式系统中的安全性和隐私问题[59]。但是,维持开源创新需要适当的激励措施,例如公共或专门的研究资金,学术认可和监管支持,以确保高质量的发展和长期生存能力[60]。没有这样的策略,开源模型的作用将降低,并有可能将更大的临床决策控制部分控制到商业算法。

开发严格的AI研究方法

我们认为,AI研究应与其他医学研究领域相同的方法论标准进行。实现这一目标将需要同行评审者和科学期刊的更大责任,以确保严格,透明度和临床相关性。

此外,在ICU研究中推进AI需要对必要的基础架构进行转换,尤其是在考虑高频数据收集和集成复杂的多模式患者信息时,在下面的各节中进行了详细介绍。在这种情况下,高度监视的环境(例如ICU和标准病房)之间的数据分辨率的差距变得显而易见。由于高分辨率监测系统,ICU提供了高水平的数据粒度,能够捕获患者生理状况的快速变化[61]。因此,这种新的大量,快速变化的生理数据和临床实践的新来源的整合可能会导致生理学学描述该领域的拟议术语可能与基因组学,蛋白质组学和其他的至关重要-omics推进个性化医学的领域。

AI将改变进行临床研究的方式,改善循证医学并进行随机临床试验(RCT)[RCT)[62]。AI不使用大型,异构试验人群,而是可以帮助研究人员设计并招募量身定制的患者子组以精确的RCT [63,,,,64]。这些精确方法可以解决与人口不均匀性有关的负重症监护试验的问题以及重大的混杂作用。因此,AI可以通过允许在数十个中心的数百个特定纳入标准的患者中加入非常微妙的细胞群来改善RCT,这是人类在实时实践中无法执行的任务,从而提高了试验效率,以在富裕人群中[65,,,,66,,,,67]。在引用的TBI示例中,在没有AI分层的情况下,对六个AI-AI识别的内型型内型(例如中等GC患者)进行RCT是不可行的。38]。这突显了AI在重症监护中实现精确试验设计的潜力。

AI和RCT之间有多个域进行互动,尽管全面的审查超出了本文的范围。其中包括试验模拟,以确定可能从干预措施中受益最大的患者人群,筛查干预措施的最有前途的药物,检测治疗效果的异质性以及自动筛查以提高临床试验的效率和成本。

确保AI模型在临床上有效,可再现和可推广需要遵守严格的方法论标准,尤其是在重症监护中,患者异质性,实时决策和高频数据收集带来了独特的挑战。几个既定的报告和验证框架已经为改善ICU环境中的AI研究提供了指导。尽管这些框架并非针对ICU环境,但我们认为应该通过专门的计划,课程和科学社会将这些框架迅速传播到重症监护界。

对于预测模型,三脚架指南的三脚架扩展集中于临床预测模型的透明报告,具体强调了校准,内部和外部验证以及公平性[68]。Probast-AI框架通过提供结构化工具来评估预测模型研究中的偏见风险和适用性[69]。COLSORT-AI将配偶框架扩展到包括AI特异性元素,例如算法透明度和AI介入试验的可重复性[70],尽管Stard-Ai提供了报告基于AI的诊断准确性研究的框架[71]。这些准则共同涵盖了与透明度,可重复性,公平性,外部验证和人类监督原则有关的几个问题,这些问题必须被视为任何可信赖的医疗保健AI研究基础。尽管这些框架可用,但许多涉及AI方法的ICU研究仍然无法满足这些标准,从而导致人们担心外部验证和普遍性不足[68,,,,72,,,,73]。

除了预测模型之外,最近文献中提出的针对特定护理的准则指南提供了针对性建议,以评估ICU环境中的AI工具,尤其是关于数据异质性,患者安全性以及与临床工作流程的整合。向前迈进,重症监护的AI研究必须与这些既定的框架保持一致,并采用更高的方法论标准,例如预注册的AI试验,不同ICU种群的预期验证以及算法性能的标准化基准。

鼓励协作AI模型

通过从多个ICU中心收集数据,或者将它们联合到结构化网络中,从而提高了外部有效性和可靠性,从而实现了单独机构无法实现的数据量的规模[74]。ICU处于数据共享工作的最前沿,提供了几个可公开可用的数据集供研究界使用[75]。有几种构建协作数据库的策略。网络是指合作研究联盟[76]该机构之间的协议和池临床研究数据对齐。相比之下,联合学习涉及一种分散的方法,其中数据存储在本地,并且中心之间只有模型或权重[77]。最后,集中的方法,例如Epic Cosmos倡议,利用从EHR收集的取消识别数据并存储在中央服务器上,可访问对整个医疗保健系统的研究和质量改进目的的大量患者人群[78]。联邦学习正在在欧洲受到关注,在欧洲,数据隐私法规对AI开发具有更大风险的方法,因此有利于分散模型[79]。相比之下,在美国,诸如Epic Cosmos之类的集中学习方法更为常见,那里的风险更容易有利于大规模的数据聚合。

同时,合成数据的使用正在成为一种补充策略,可以在保留患者隐私的同时进行数据共享。人工生成合成数据集以反映实际患者数据的特征,可用于训练和测试模型而无需暴露敏感信息[80]。大规模数据的可用性也可能支持创建数字双胞胎。数字双胞胎或反映个人的生物学和临床状态并依赖大量高保真数据集的虚拟模拟,可以在床边应用之前对干预措施进行预测性建模和虚拟测试,并提高干预措施的安全性。

ICU社区应主张在国家和国际层面扩展进一步的计划,以扩展协作AI模型。

Governance and regulation for AI in Critical Care

Despite growing regulatory efforts, AI regulation remains one of the greatest hurdles to clinical implementation, particularly in high-stakes environments like critical care, as regulatory governance, surveillance, and evaluation of model performance are not only conceptually difficult, but also require a large operational effort across diverse healthcare settings.The recent European Union AI Act introduced a risk-based regulatory framework, classifying medical AI as high-risk and requiring stringent compliance with transparency, human oversight, and post-market monitoring [18]。While these regulatory efforts provide foundational guidance, critical care AI presents unique challenges requiring specialized oversight.

By integrating regulatory, professional, and institutional oversight, AI governance in critical care can move beyond theoretical discussions toward actionable policies that balance technological innovation with patient safety [73,,,,81,,,,82]。

Grant collaboration between public and private sector

Given the complexity and significant economic, human, and computational resources needed to develop a large generative AI model, physicians and regulators should promote partnerships among healthcare institutions, technology companies, and governmental bodies to support the research, development, and deployment of AI-enabled care solutions [83]。Beyond regulatory agencies, professional societies and institutional governance structures must assume a more active role.Organizations such as Society of Critical Care Medicine (SCCM), European Society of Intensive Care Medicine (ESICM), and regulatory bodies like the European Medical Agency (EMA) should establish specific clinical practice guidelines for AI in critical care, including standards for model validation, clinician–AI collaboration, and accountability.Regulatory bodies should operate at both national and supranational levels, with transparent governance involving multidisciplinary representation—including clinicians, data scientists, ethicists, and patient advocates—to ensure decisions are both evidence-based and ethically grounded.To avoid postponing innovation indefinitely, regulation should be adaptive and proportionate, focusing on risk-based oversight and continuous post-deployment monitoring rather than rigid pre-market restrictions.Furthermore, implementing mandatory reporting requirements for AI performance and creating hospital-based AI safety committees could offer a structured, practical framework to safeguard the ongoing reliability and safety of clinical AI applications.

Address AI divide to improve health equality

The adoption of AI may vary significantly across various geographic regions, influenced by technological capacities, (i.e. disparities in access to software or hardware resources), and differences in investments and priorities between countries.This “AI divide†can separate those with high access to AI from those with limited or no access, exacerbating social and economic inequalities.

The EU commission has been proposed to act as an umbrella to coordinate EU wide strategies to reduce the AI divide between European countries, implementing coordination and supporting programmes of activities [84]。The use of specific programmes, such as Marie-Curie training networks, is mentioned here to strengthen the human capital on AI while developing infrastructures and implementing common guidelines and approaches across countries.

A recent document from the United Nations also addresses the digital divide across different economic sectors, recommending education, international cooperation, and technological development for an equitable AI resource and infrastructure allocation [85]。

Accordingly, the medical community in each country should lobby at both national level and international level through society and WHO for international collaborations, such as through the development of specific grants and research initiatives.Intensivist should require supranational approaches to standardized data collection and require policies for AI technology and data analysis.Governments, UN, WHO, and scientific society should be the target of this coordinated effort.

Continuous evaluation of dynamic models and post-marketing surveillance

A major limitation in current regulation is the lack of established pathways for dynamic AI models.AI systems in critical care are inherently dynamic, evolving as they incorporate new real-world data, while most FDA approvals rely on static evaluation.In contrast, the EU AI Act emphasizes continuous risk assessment [18]。This approach should be expanded globally to enable real-time auditing, validation, and governance of AI-driven decision support tools in intensive care units, as well as applying to post-market surveillance.The EU AI Act mandates ongoing surveillance of high-risk AI systems, a principle that we advocate to be adopted internationally to mitigate the risks of AI degradation and bias drift in ICU environments.In practice, this requires AI commercial entities to provide post-marketing surveillance plans and to report serious incidents within a predefined time window (15 days or less) [18]。Companies should also maintain this monitoring as the AI systems evolve over time.The implementation of these surveillance systems should include standardized monitoring protocols, embedded incident reporting tools within clinical workflows, participation in performance registries, and regular audits.These mechanisms are overseen by national Market Surveillance Authorities (MSAs), supported by EU-wide guidance and upcoming templates to ensure consistent and enforceable oversight of clinical AI systems.

Require adequate regulations for AI deployment in clinical practice

Deploying AI within complex clinical environments like the ICU, acute wards, or even regular wards presents a complex challenge [86]。

We underline three aspects for adequate regulation: first, a rigorous regulatory process for evaluation of safety and efficacy before clinical application of AI products.A second aspect is related with continuous post-market evaluation, which should be mandatory and conducted according to other types of medical devices [18]。

The third important aspect is liability, identifying who should be held accountable if an AI decision or a human decision based on AI leads to harm.This relates with the necessity for adequate insurance policies.We urge regulatory bodies in each country to provide regulations on these issues, which are fundamental for AI diffusion.

We also recommend that both patients and clinicians request that regulatory bodies in each country update current legislation and regulatory pathways, including clear rules for insurance policies to anticipate and reduce the risk for case laws.