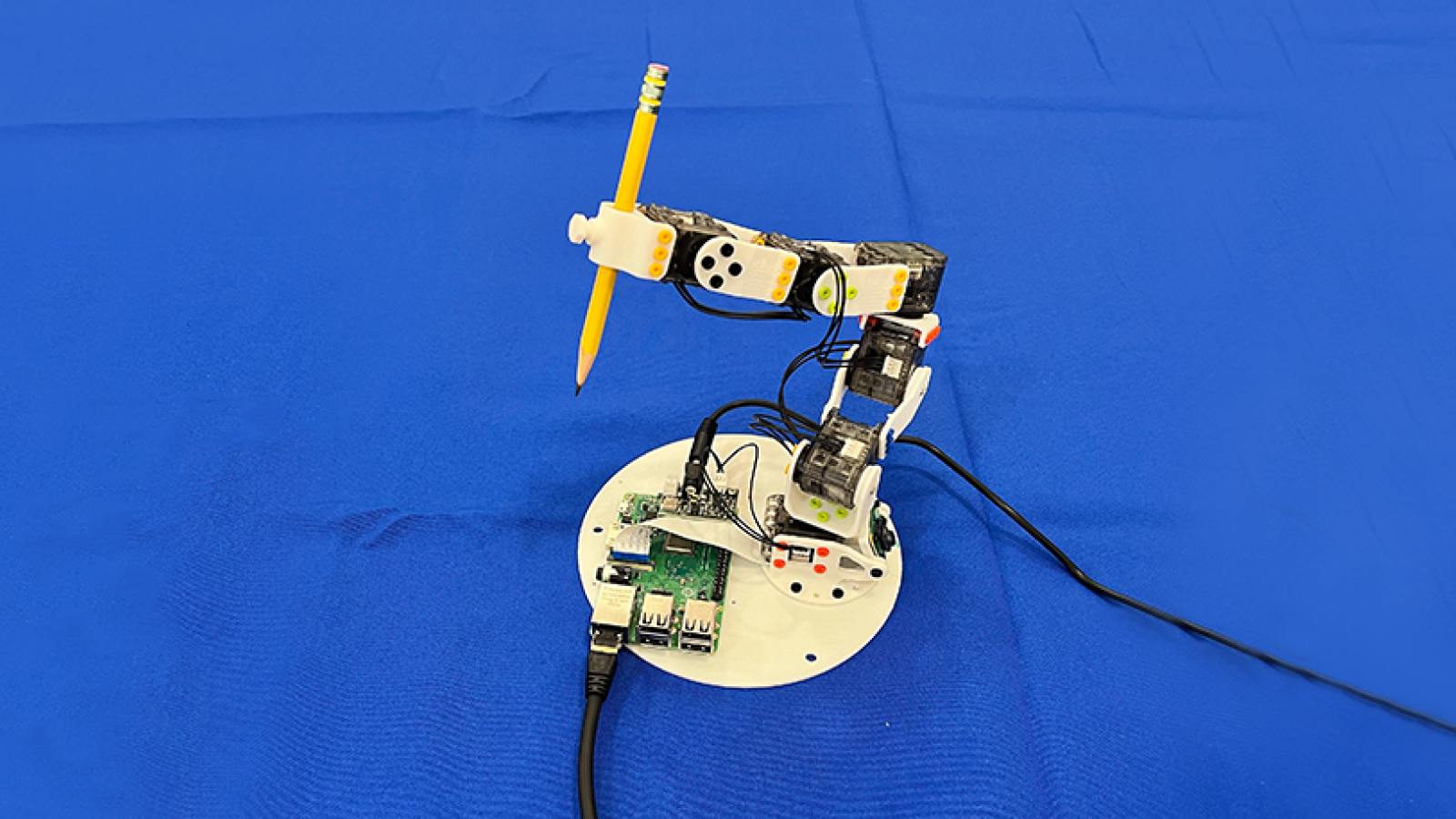

麻省理工学院的科学家开发了一种基于新颖的愿景人工智能(AI)可以教自己如何在不使用传感器或预训练的情况下控制任何机器人的系统。

该系统使用相机收集有关给定机器人架构的数据,就像人类在移动时使用眼睛学习自己一样。

这使AI控制器可以开发一个自学习模型,用于操作任何机器人,从本质上讲,机器使机器具有人性化的身体自我意识。

研究人员通过创建一个新的控制范式来实现这一突破,该范式使用摄像机映射机器人“ Visuomotor Jacobian Field”的视频流,该范围是机器人的Actuators的机器可见3D点的描述。

然后,AI模型可以预测精度运动。这使得将非传统的机器人体系结构(例如软机器人技术)和使用灵活材料设计的机器人架构转变为只有几个小时的培训的自主单元。

“想想如何学会控制手指:你摆动,观察,适应。”塞兹·莱斯特·李,MIT Csail的博士生和该项目的首席研究员,新闻稿。这就是我们的系统的作用。它通过随机动作进行实验,并确定哪些控制机器人的哪些部分。”

有关的:科学家在新的机器人皮肤上烧毁,戳戳和切开,可以“感觉到一切”

典型的机器人解决方案依靠精确的工程来创建机器,以使用预训练系统控制的精确规格。这些可能需要昂贵的传感器和AI模型,并开发了数百或数千个小时的微调,以预测所有可能的运动置换。用式附属物抓住对象,例如仍然是一个艰难的挑战在机器工程和AI系统控制的领域。

了解您周围的世界

相比之下,使用“ Jacobian Field”映射摄像机解决方案为自动化机器人系统的挑战提供了低成本,高保真的解决方案。

该小组在6月25日在《杂志》上发表了其调查结果自然。他们说,这项工作旨在模仿人类脑部学习控制机器的方法。

我们学习和重建3D配置并预测运动作为控制函数的能力仅来自视觉。根据该论文,在使用视频游戏控制器控制机器人时,人们可以在几分钟之内学习和放置对象,而我们唯一需要的传感器是我们的眼睛。”

该系统的框架是使用两到三个小时的多视频视频开发的机器人,该视频由12个消费级RGB-D摄像机捕获的随机生成的命令。

该框架由两个关键组件组成。第一个是一个深度学习的模型,从本质上允许机器人确定其在3维空间中的位置及其附属物。这使其可以预测在执行特定移动命令时其位置将如何变化。第二个是一个机器学习程序,将通用移动命令转换为机器人可以理解和执行的代码。

该团队通过对基于传统的摄像头控制方法进行基准有效性来测试新的培训和控制范式。雅各布式现场解决方案超过了现有的2D控制系统,尤其是当团队引入导致较旧方法进入失败状态的视觉遮挡时。但是,使用团队方法的机器成功创建了可导航的3D地图,即使场景被随机杂物部分遮住了。

一旦科学家开发了该框架,它就会应用于具有较大架构的各种机器人。最终结果是一个控制程序,该程序不需要进一步的人类干预才能使用单个摄像机训练和操作机器人。