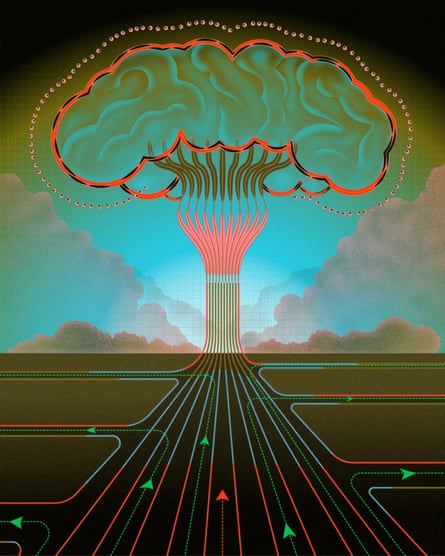

技术之所以发生,是因为这是可能的,Openai首席执行官Sam Altman,告诉2019年的《纽约时报》有意识地诠释了原子弹之父罗伯特·奥本海默。

Altman捕获了一个硅谷的咒语:技术无情地向前行驶。

另一个广泛的科技定罪是,第一个被称为人工通用情报(AGI)的人类级别的AI将导致两个未来之一:一个后期的阶段之一技术 - 乌托邦或人类的歼灭。

为了无数其他物种,人类的到来拼写厄运。我们的努力更加艰难,更快或更强壮 - 更聪明,更协调。在许多情况下,灭绝是我们实现的其他目标的偶然副产品。真正的agi将构成创建新物种,这可能很快跑智能或者人数少我们。它可以将人类视为一个小障碍,就像垤以计划中的水力大坝或利用资源,就像数十亿只动物被限制在工厂农场中一样。

奥特曼(Altman)以及其他顶级AI实验室的负责人认为,AI驱动的灭绝是一个真正的可能性(加入数百名领先的AI研究人员和著名人物)。

鉴于所有这些,很自然地问:我们是否应该真正尝试建立一项可能杀死我们所有人的技术?

也许最常见的答复说:AGI是不可避免的。不建造它太有用了。毕竟,AGI将是最终技术 - Alan Turing的同事称为人类需要做出的最后一个发明。此外,原因是在AI实验室内进行的,如果我们不这样做,其他人当然会做得不太负责任。

硅谷的新意识形态,有效的加速主义(e/acc),主张这种不可避免的是热力学第二定律的结果,其发动机是Technocapital。E/ACC宣言断言:无法停止此引擎。进步的棘轮只朝一个方向转向。回去不是一个选择。

为了奥特曼和E/ACC,技术采用神秘的质量 - 发明行军被视为自然事实。但这不是。技术是由无数强大力量促进的故意人类选择的产物。我们有代理商来塑造这些力量,历史表明我们以前做过。

没有任何技术是不可避免的,甚至不像AGI那样诱人。

最初的生物学家害怕新颖的风险禁止然后成功受监管1970年代重组DNA的实验。

没有人通过克隆,即使是从技术上讲十多年来,唯一的基因工程师人类的科学家是被监禁为了他的努力。

核电可以提供一致,无碳的能量,但对灾难的生动恐惧有动机扼杀法规和完全禁令。

如果Altman是更熟悉随着曼哈顿项目的历史,他可能意识到1945年创建核武器实际上一个高度偶然的结果,动机错误地认为,德国人在炸弹的种族中处于领先地位。带领9/11委员会的历史学家菲利普·泽利科夫(Philip Zelikow)说:我认为,如果美国在第二次世界大战期间没有建造原子弹,实际上对我来说还不清楚什么时候甚至可能如果有史以来建造的原子弹。

现在很难想象一个没有核武器的世界。但是在鲜为人知的一集中,当时的罗纳德·里根(Ronald Reagan)和苏联领导人米哈伊尔·戈尔巴乔夫(Mikhail Gorbachev)几乎同意抛弃所有炸弹(对星球大战卫星防御系统破坏了这些希望)。即使完全解除武装的梦想仍然如此,核武器的数量是少于1986年峰的20%,主要感谢国际协议。

这些选择不是真空做出的。里根是一个坚定的对手裁军数百万核冻结运动传给了他。1983年,他评论对他的国务卿致敬:如果事情变得更热,武器控制仍然是一个问题,也许我应该去看[苏联领导人尤里]安德罗波夫,并提议消除所有核武器。”

有非常强大的经济激励措施来保持燃烧化石燃料,但气候倡导有撬开Overton窗口并大大加快了我们的脱碳工作。

2019年4月,年轻的气候小组灭绝叛乱(XR)带来伦敦停止,要求英国目标净净碳排放到2025年。他们有争议的公民抗命促使议会降临宣布气候紧急情况和工党通过2030目标脱碳电力生产。

塞拉俱乐部超越煤炭竞选鲜为人知,但非常有效。在最初的五年中,这项运动帮助关闭了美国三分之一以上的燃煤电厂。谢谢 主要是从煤炭中移动,美国人均碳排放现在低于1913年。

在许多方面,规范建造AGI的努力的挑战远小于脱碳。百分之八十全球能源生产来自化石燃料。能量是使文明起作用的原因,但我们不依赖于假设的AGI使世界转弯。

此外,放缓和指导未来系统的发展并不意味着我们需要停止使用现有系统或开发专家AIS来解决医学,气候和其他地方的重要问题。

很明显,为什么这么多资本家是AI的爱好者:他们预见了一项可以实现长期梦想的技术,即将工人从循环(和资产负债表)中削减。

但是政府不是最大化的利润。当然,他们关心经济增长,但他们也关心诸如就业,社会稳定,市场集中以及偶尔民主等事情。

目前尚不清楚AGI将如何影响这些领域的整体影响。政府为大多数人在技术上失业的世界做准备。

资本家通常会得到他们想要的东西,尤其是最近几十年,对利润的无限追求可能会破坏任何监管努力,以减缓AI发展的速度。但是资本家没有总是得到他们想要的。

2月,在旧金山的一家酒吧里长期Openai安全研究人员向一个小组宣布,E/ACC不应该担心极端的安全人员,因为他们将永远没有权力。助推器实际上应该害怕AOC和参议员乔什·霍利(Josh Hawley),因为他们真的可以为您操蛋。

假设人类坚持了数千年,就无法知道我们最终会建立Agi。但这实际上不是不依次的人所说的。相反,信息往往是:AGI即将到来。阻力是徒劳的。

但是,无论我们是在五年,20年还是100年内建造AGI真的很重要。而且时间表在我们的控制中远远超过助推器所承认的。我怀疑很多人都意识到这一点,这就是为什么他们花了这么多努力试图说服其他人尝试尝试的原因。此外,如果您认为Agi是不可避免的,为什么还要说服任何人呢?

我们实际上有在Openai实际做到的十多年之前,需要训练GPT-2的计算能力,但是人们不知道是否值得这样做。

但是目前,顶级的AI实验室被锁定在一场激烈的比赛中实施甚至他们自己的安全团队都想要的所有预防措施。(一名Openai员工宣布最近,他退出了“由于失去了对阿吉(Agi)时期将负责任地行事的信心。测试减慢产品发布并消耗公司资源。

另一方面,政府受到同样的财务压力。

最近的一位不替代主义科技企业家说除非您控制书面代码的每一行,否则不可能调节AI开发。如果有人可以在笔记本电脑上旋转AGI,那可能是正确的。但事实证明,建筑物高级,通用的AI模型需要超级计算机的巨大阵列,由荒谬的垄断行业。因此,许多人工智能安全倡导者都看到计算治理作为一种有前途的方法。政府可以迫使云计算提供商停止下一代培训,这不符合已建立的护栏。可以选择阈值以锁定外卖或需要Orwellian级别的监视,而可以选择仅影响能够负担得起的球员超过1亿美元进行一次训练。

可以这么说,政府确实必须担心国际竞争和单方面裁军的风险。但国际条约可以协商以广泛的态度分享尖端AI系统的好处,同时确保实验室盲目扩展系统不明白。

尽管世界可能会感到脆弱,但竞争对手的合作却达到了令人惊讶的程度。

蒙特利尔协议固定的通过禁止氯氟化合物的臭氧层。世界上大多数地方都同意采用军事有用的武器以道德动机的禁令,例如生物和化学武器,,,,盲目激光武器和天气战。

在1960年代和70年代,许多分析师害怕每个国家都可以建立核武器的国家。但最多世界上大约三个核计划被遗弃了。这不是偶然发生的结果,而是通过故意的遗ecraft创建全球非扩散规范的结果,例如1968年不扩散条约。

在几次美国人被问到是否想要超人AI时大的 多数说不。反对AI已经成长了随着技术变得越来越普遍。当人们认为Agi是不可避免的时,他们真正说的是,受欢迎的意志不应该。助推器将群众视为省级新洛德迪人,他们不知道对他们有什么好处。这就是为什么不可避免的对他们具有这种修饰的魅力;它使他们避免提出真正的论点,他们知道这是舆论法院中的失败者。

AGI的平局很强。但是所涉及的风险是潜在的文明终止。需要进行文明规模的努力来迫使抵抗它的必要权力。

技术之所以发生,是因为人们实现了。我们可以选择否则。

-

驻军可爱是一名自由记者