随着新模型包含更多功能,正在继续增长。有了最新的进步,即使没有开发人员背景的发烧友也可以直接潜入这些模型。与流行的应用一样

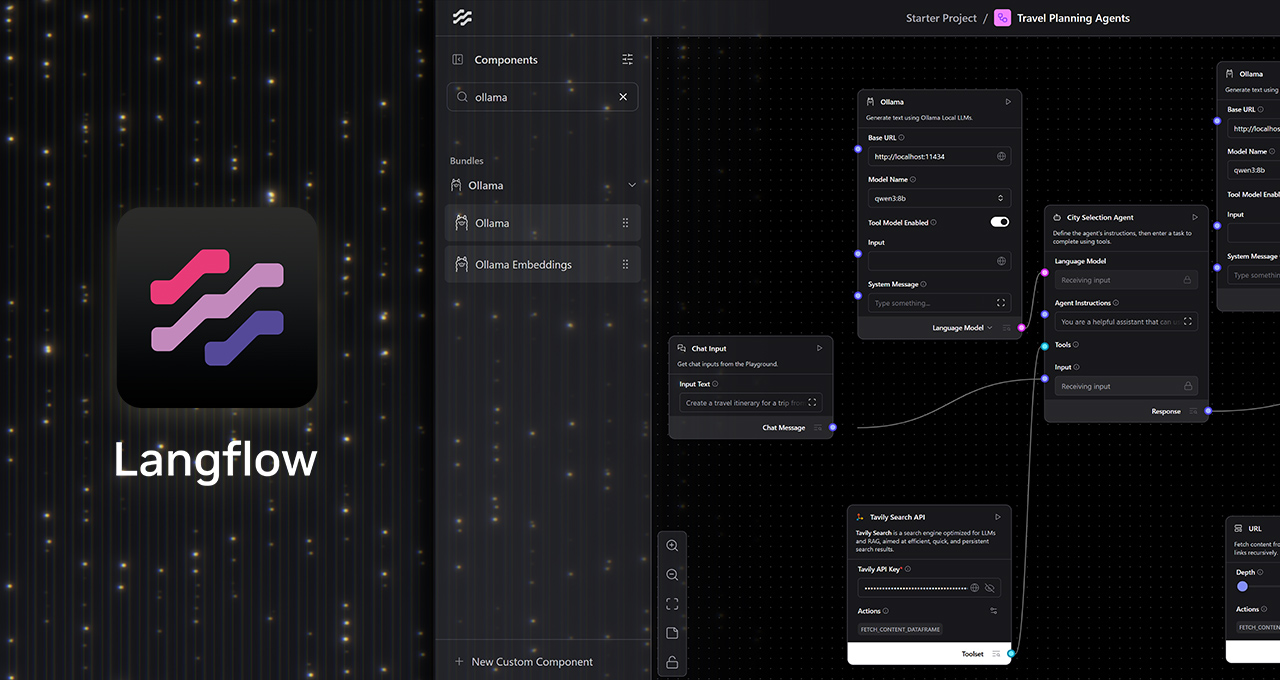

langflow一个用于设计自定义AI工作流的低音,视觉平台 - AI爱好者可以使用简单的无代码用户界面(UIS)来链生成的AI模型。并与本地整合霍拉马,用户现在可以创建本地AI工作流,并免费运行它们,并完全隐私,由NVIDIA提供支持Geforce RTX和RTX ProGPU。

生成AI的视觉工作流程

Langflow提供了易于使用的帆布风格界面,其中生成AI模型的组件像大语言模型(LLMS),工具,内存存储和控制逻辑可以通过简单的拖放UI连接。

这允许在不手动脚本的情况下构建和修改复杂的AI工作流程,从而减轻了能够决策和多步骤操作的代理的发展。人工智能爱好者可以在没有事先编码专业知识的情况下迭代并构建复杂的AI工作流程。

与运行单转LM查询的应用程序不同,Langflow可以构建高级的AI工作流,这些工作流的行为像智能合作者一样,能够分析文件,检索知识,执行功能并在上下文上响应动态输入。

Langflow可以通过Ollama的RTX GPU完全加速从云或本地运行模型。当地运行工作流程提供了多个关键好处:

- 数据隐私:输入,文件和提示仍然局限于设备。

- 低成本,没有API键:由于不需要云应用程序编程接口访问,因此不存在与运行AI模型相关的令牌限制,服务订阅或成本。

- 表现:RTX GPU启用低延迟,高通量推断,即使使用长上下文窗口。

- 离线功能:没有互联网,可以访问本地AI工作流程。

用Langflow和Ollama创建本地代理商

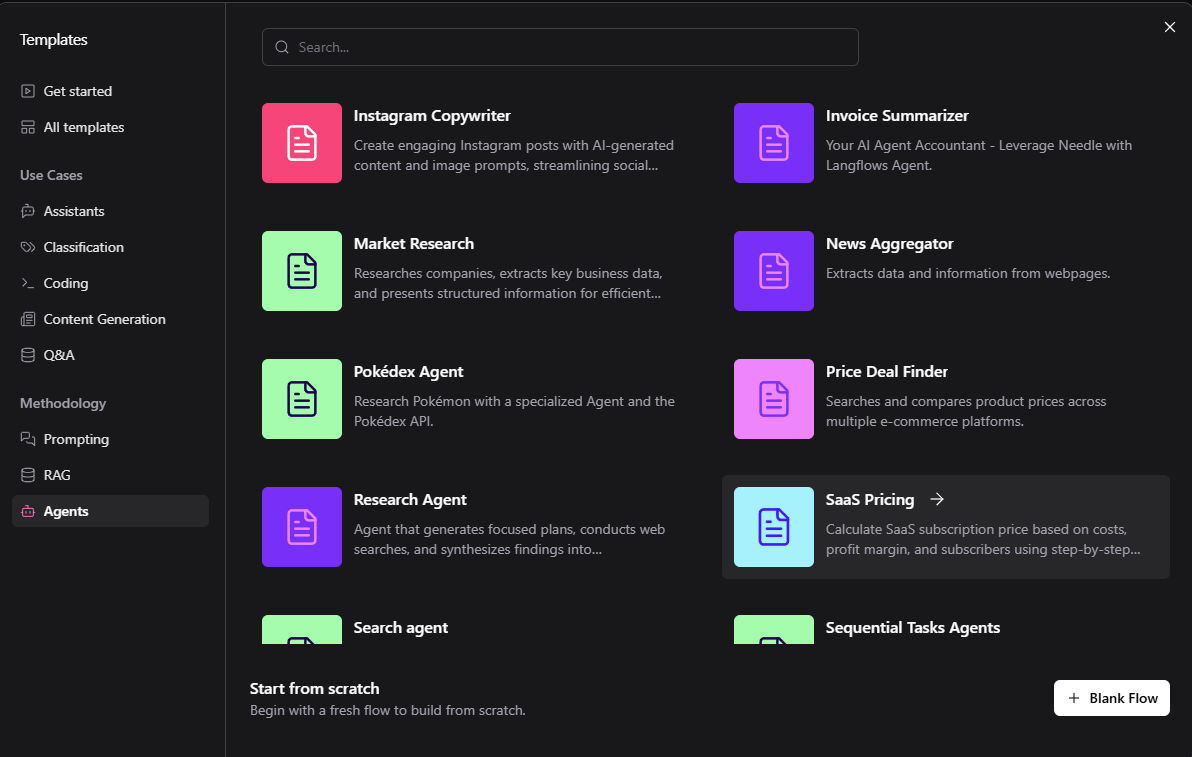

Langflow中的Ollama入门很简单。内置起动器可用于从旅行社到购买助手的用例。默认模板通常在云中运行以进行测试,但是可以自定义它们以langflow在RTX GPU上本地运行。

构建本地工作流程:

- 安装Windows的Langflow桌面应用。

- 安装霍拉马,然后运行Ollama并启动首选模型(Llama 3.1 8b或Qwen3 4B建议用于用户的第一个工作流)。

- 运行langflow并选择一个入门机。

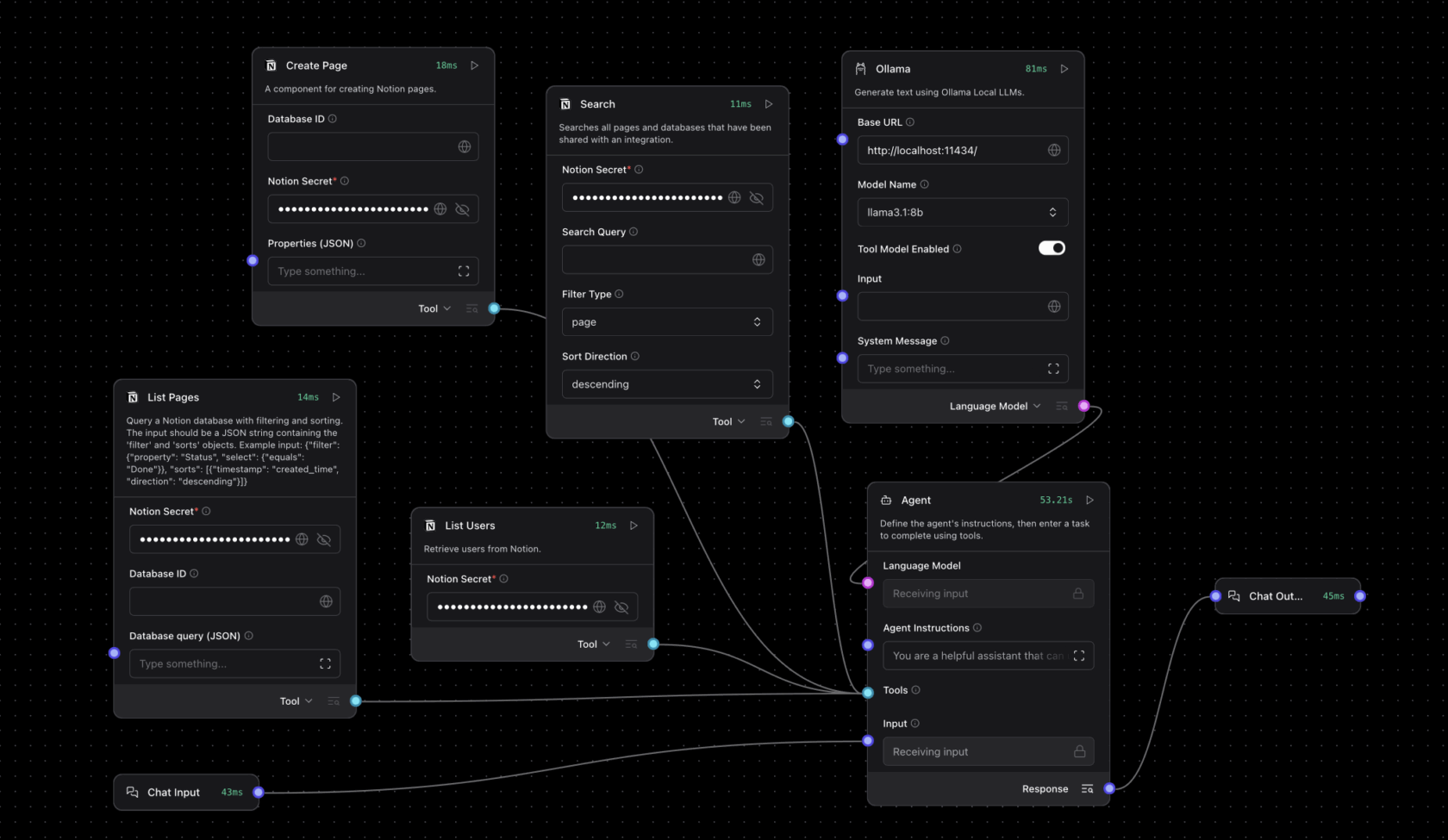

- 用本地的Ollama运行时替换云端点。对于代理工作流程,将语言模型设置为风俗,将Ollama节点拖到画布,然后将代理节点的自定义模型连接到语言模型Ollama节点的输出。

可以通过添加系统命令,本地文件搜索或结构化输出来修改和扩展模板,以满足高级自动化和助理用例。

观看Langflow团队的逐步演练:

开始

以下是两个开始探索的示例项目。

创建个人旅行行程代理:输入所有旅行要求 - 包括所需的餐厅预订,旅行者的饮食限制以及更多,以自动查找和安排住宿,交通,食品和娱乐。

扩展概念的功能:概念,一个用于组织项目的AI工作区应用程序,可以通过自动输入会议注释,根据松弛聊天或电子邮件更新项目状态的AI模型来扩展,并发送项目或会议摘要。

RTX混音添加模型上下文协议,解锁代理modsRTX混音

``一个开源平台,允许Modders使用生成的AI工具增强材料,并创建具有完整射线跟踪和神经渲染技术的惊人RTX重新启动器,正在为使用langflow添加对模型上下文协议(MCP)的支持。带有MCP的langflow节点为用户提供了直接接口,用于与RTX混音一起工作,使Modders可以构建能够与Remix文档和MOD函数智能交互的改装助手。

为了帮助Modders开始,NVIDIA的Langflow Remix模板包括:

一个

- 检索一代带有RTX混音文档的模块。实时访问Q&A风格支持的混音文档。

- 通过MCP的操作结节支持RTX混音中的直接函数执行,包括资产更换,元数据更新和自动化mod交互。

- 使用此模板构建的改装助理代理可以确定查询是信息性还是面向动作。

基于上下文,代理商会通过指导动态响应或采取请求的措施。例如,用户可能会提示代理:``将这种低分辨率的纹理换成更高分辨率的版本。在响应中,代理将检查资产的元数据,找到适当的替代品并使用MCP功能更新项目 - 而无需手动交互。

混音模板的文档和设置说明可在RTX混音开发人员指南。

控制RTX AI PC,带有langflow项目G-assist的PC

NVIDIA项目G助手是一个实验性的,设备的AI助手,在GeForce RTX PC上本地运行。它使用户可以通过简单的自然语言提示来查询系统信息(例如PC规格,CPU/GPU温度,利用率),调整系统设置等。

使用langflow中的G辅助组件,这些功能可以内置在自定义的代理工作流中。用户可以提示G-sistist获得GPU温度或调整风扇速度,其响应和动作将流过它们的组件链。

除了诊断和系统控制之外,G-assist还可以通过其插件体系结构进行扩展,该插件允许用户添加为其工作流量身定制的新命令。社区构建的插件也可以直接从langflow工作流中调用。

要开始使用langflow中的G辅助组件,阅读开发人员文档。

langflow也是开发工具为了NVIDIA NEMO微服务这是一个模块化平台,用于跨本地或云kubernetes环境构建和部署AI工作流程。

在对Ollama和MCP的综合支持下,langflow提供了一个实用的无代码平台,用于构建完全离线和设备运行的实时AI工作流程和代理,所有这些平台都由NVIDIA GEFORCE RTX和RTX PRO GPUS加速。

每个星期,RTX AI车库 博客系列具有社区驱动的AI创新和内容,以了解有关NVIDIA NIM微服务和AI蓝图以及构建的人的更多信息人工智能代理,创意工作流程,生产力应用以及在AI PC和工作站上的更多信息。

插入NVIDIA AI PCFacebook,,,,Instagram,,,,蒂克托克和x并通过订阅RTX AI PC新闻通讯。加入NVIDIASDiscord服务器与社区开发人员和AI爱好者建立联系,讨论与RTX AI的可能性。

看注意关于软件产品信息。