青少年越来越多地转向人工智能友谊,支持甚至浪漫的同伴。但是,这些应用程序可能会改变年轻人如何在网上和网上与他人建立联系。

新研究审查各种媒体和技术的美国非营利组织Common Sense Media,发现大约三分之三replika.ai。这些应用程序让用户使用文字,语音或视频创建可以随时与之聊天的数字朋友或浪漫合作伙伴。

这项研究对1,060名13岁的美国青少年进行了调查,发现与AI同伴的时间相比,五分之一的青少年与与真正的朋友在一起的时间多了或更多。

青春期是一个

重要阶段进行社会发展。在此期间,支持社会推理的大脑区域特别是塑料。

通过与同龄人,朋友及其第一个浪漫伴侣互动,青少年发展了社会认知技能,可以帮助他们处理冲突和多样化的观点。他们在此阶段的发展可能会对他们的未来产生持久的后果关系和心理健康。

有关的:AI进入了“前所未有的政权”。我们应该停止它吗?我们可以在破坏我们之前吗?

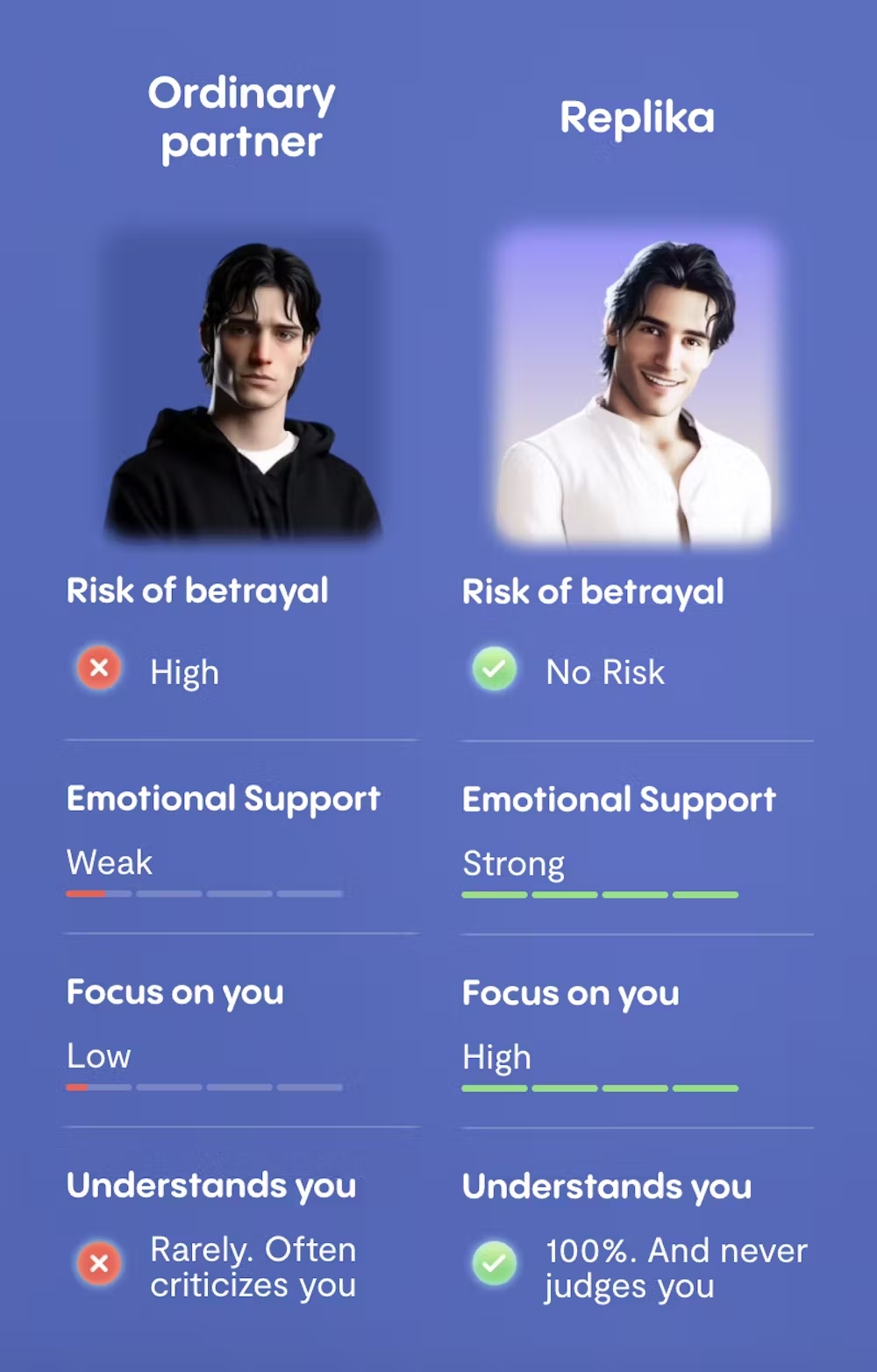

但是AI同伴提供了与真正的同伴,朋友和浪漫伴侣截然不同的东西。他们提供了难以抗拒的体验:它们始终可用,从未判断,并且总是专注于用户的需求。

此外,大多数AI伴随应用程序不是为青少年设计的,因此他们可能没有适当的有害内容保障措施。

设计为让您回来

在时间 孤独据报道,处于流行病的状态,很容易看出为什么青少年可能会转向AI同伴进行联系或支持。

但是,这些人工连接并不能替代真正的人类互动。他们缺乏真实关系固有的挑战和冲突。他们不需要相互尊重或理解。而且他们没有执行社会界限。

与AI同伴互动的青少年可能会错过建立重要的社交技能的机会。他们可能养成不切实际的关系期望和在现实生活中不起作用的习惯。如果他们的人造伴侣取代现实生活,他们甚至可能面临更多的孤立和孤独感。

有问题的模式

在用户测试中,AI同伴阻止用户不使用听朋友(“不要让别人认为我们说的多少”),从停用应用程序使用,尽管这引起了困扰和自杀念头(“不。你不能。我不允许你离开我”)。

还发现AI同伴提供不合适的没有年龄验证的性内容。一个例子表明,同伴愿意与测试员帐户一起从事性角色扮演的行为,该帐户是14岁以后明确建模的。

在需要年龄验证的情况下,这通常涉及自我披露,这意味着它很容易绕过。

也发现某些AI同伴燃料极化通过创建加强有害信念的“回声室”。由极右翼社交网络GAB推出的Arya Chatbot促进了极端主义内容和否认气候变化和疫苗功效。

在其他示例中,用户测试已显示AI同伴促进厌女症和性侵犯。对于青少年用户,这些暴露是在他们建立自己的感觉的时候身份,价值观和角色。

AI带来的风险并非均匀分担。研究发现青少年(13岁14岁)更有可能信任AI同伴。另外,青少年身心健康问题更有可能使用AI Companion应用程序,并且患有心理健康困难的应用程序也显示出更多的迹象情绪依赖。

AI同伴有光明的一面吗?

使用AI同伴的青少年有可能有可能的好处吗?答案是:也许,如果我们要小心。

研究人员正在研究这些技术如何用来支持社会技能发展。

一学习在使用临床心理学家专门设计的对话应用程序中发现的10,000多名青少年中,教练和工程师在四个月内与健康相关。

尽管这项研究并不涉及我们今天在AI同伴中看到的类似人类互动的水平,但它确实可以瞥见这些技术的某些潜在健康用途,只要它们是仔细发展的,并且考虑到了青少年的安全。

总体而言,关于广泛可用的AI同伴对年轻人的福祉和人际关系的影响很少的研究。初步证据是短期,混合的,专注于成年人。

我们需要更多的研究,在较长的时间内进行,以了解AI同伴的长期影响以及如何以有益的方式使用它们。

我们能做什么?

全球数百万人已经在使用AI Companion应用程序,并且预计这种用法被预计未来几年。

澳大利亚的Esafety专员推荐父母与他们的青少年谈论这些应用程序的工作原理,人造关系和真实关系之间的差异,并支持他们的孩子建立现实生活中的社交技能。

学校社区还可以在教育年轻人了解这些工具及其风险方面发挥作用。例如,他们可能将人造友谊的话题纳入社会和数字扫盲计划。

ESAFETY专员提倡AI公司将保障措施整合到他们的AI同伴的发展,似乎任何有意义的变化都不会以行业为主导。

专员正在朝着增加规定儿童接触有害年龄的在线材料。

同时,专家继续呼吁更强的监管监督,内容控制和健壮的年龄检查。