人工智能如何通过“监视工资”做法从公平的工资中解脱出艰苦的工作,以及如何修复它

作者:Maria Monroe

概述一个

不透明的算法和人工智能系统越来越多地塑造工人的薪酬,将薪酬决定从人类管理者那里转移,明确的法律标准和集体谈判。这种现象被称为算法工资歧视1或监视工资2首先记录在应用程序控制的乘车和食品交付工作中。现在,它正在传播到其他一系列行业和服务。

我们对500个AI劳动管理供应商的首次审核表明,包括医疗保健,客户服务,物流和零售等行业的传统雇主现在使用自动监视和决策系统来设定补偿结构并计算单个工资。如果没有政策干预,我们担心这些做法将成为标准化,从而增加收入不确定性,构成偏见和侵蚀工资设定的透明度。

政府执法机构和立法者应肯定,主动地禁止这些做法。这可以通过立法使用实时数据来自动化劳动力补偿结构(例如分层奖金,基于绩效的激励措施或低生产率的罚款)和自动化工资计算来完成。为了确保艰苦的工作与公平薪水之间存在正相关关系,工资设定的做法必须至少可预测和可审查。”

在本期简介中,我们首先研究了监视薪酬实践如何工作以及它们越来越多地在美国经济中部署。然后,我们详细介绍我们的审计调查结果,然后再提出政策建议,以确保在设定和计算工人工资方面的公平性和透明度。

监视薪酬实践如何工作以及它们在美国经济中变得越来越普遍

妮可(Nicole)在乘车公司Lyft Inc.(Lyft Inc.)获得了一份兼职工作,以帮助她的抵押贷款可调节利率提高。3经过漫长的一周在她从事医疗保健工作的正常工作之后,她将在周六早晨醒来,并在Lyft开始了第二次工作。几个星期以来,妮可将开车直到她赚取200美元的款项来支付更高的贷款,然后回家。

但是,在2个月内,她发现她花了更长的时间才能赚取每次转班200美元的目标金额。出于某些无法解释的原因,她的每日演出收入下跌了多达50美元。尽管她的驾驶员得分很高,并且比以往任何时候都更加努力,但在接下来的一年中,妮可的周六工资却下跌了50美元。为了维持生计,她也在星期日捡起了一个转变。妮可(Nicole)为莱夫特(Lyft)工作的时间越长,她赚取的次数就越少。

按需工人(例如妮可)是最早经历被称为算法工资歧视的人之一,也称为监视薪资:数字化工资设定,在这些工资设定中,公司使用大量的粒状数据,包括通过自动监控系统实时收集的数据,以建立补偿支架和/或/或计算个人薪水。4对可追溯至2016年的需求工人的研究(包括工人本身发起的工人)发现,这些黑匣子AI系统以确定薪酬的引入始终导致较低,不稳定且不确定的收入为应用程序控制的乘车手和食品交付工人。也许毫不奇怪,这导致工人的压力增加,工作场所伤害率更高以及总体工作满意度下降。5

在监视工资系统下,可能会以相同的工作支付不同的工资,而个别工人无法随着时间的推移预测其收入。这些薪酬实践尤其是那些依靠全景工人监视和算法智能或机器学习系统的薪酬实践。将漫长而艰苦的努力转向更高的工资和经济安全。随着时间的流逝,尼科尔(Nicole)的工作中有薪水,例如妮可(Nicole)的工作付费减少,表明公司内的薪酬范围转移,而且行业研究还肯定了像她这样的工人所描述的:工作更长的时间的人每小时支付更少的费用。

令人震惊的是,这种努力工作和安全,公平薪酬的解偶不再只是应用程序控制或演出工人的关注。专门从事劳动力管理的AI公司的筹资速度加剧了自动化产品的增长和销售,旨在通过引入可能影响或确定工资的监控和决策系统来提高劳动力效率。但是,由于软件公司通常不会通过产生动态的工资结构和计算来宣传其系统能力降低人工成本的能力,因此对这些产品,它们的功能以及其使用的个人和社会影响知之甚少。

因此,问题比比皆是。哪些工人的部门正在经历如何在工作中监控他们的工作,评估其表现并付费的干扰?这些系统的功能,局限性和风险是什么?而且,重要的是,这些系统是否会帮助或伤害日常工人?

为了开始填补这一知识差距,并确定最有可能受算法工资歧视系统影响的部门,我们对500名销售用于劳动管理的机器学习产品的AI供应商进行了首次分析。通过对这500家公司的风险评估,我们确定了20个供应商的子集,这些供应商很可能会使用机器学习系统来产生监视薪酬。据我们所知,这是对算法工资歧视实践在演出工作之外的传播的首次系统研究。

与通过雇主与雇员之间的合同谈判确定的设定工资不同,由机器学习系统确定的工资是实时生成的,使依靠他们的工人使它们变量,不确定且无法理解。尽管如此,下面详述的我们的研究中绝大多数产品也缺乏任何透明度或反馈机制。因此,尽管尼科尔(Nicole)等人的经历曾经仅限于应用程序控制的工作,但现在他们可能会传播到其他更传统的就业领域,从根本上改变了美国劳动力市场上的工人的工作与工资之间的关系。6

这些发现的潜在影响令人震惊。监视薪酬实践的传播到关键的,以人为中心的行业(例如医疗保健和客户服务)不仅改变了辛勤工作与公平薪水之间的关系,而且还改变了有意义的改变工作场所规范和文化,从而影响了医院中患者的治疗方式以及消费者的问题和利益如何解决。对应用程序控制工作的研究的经验教训表明,监视工资的引入激励工人以降低人工成本的方式进行绩效,但可能会降低中心的患者福祉或客户满意度。”

因此,监视工资的潜在灾难性后果远远超出了其对个人工人薪酬的不安全感和不可预测性的影响。

AI供应商启用并由客户部署的监视薪酬实践

使用我们的方法论中列出的参数分析最初的500个AI公司(请参见上面的框),我们确定了20个供应商,我们确定其产品具有产生算法工资歧视的高风险。尽管算法薪酬实践始于运输和交付领域,但我们的发现表明,它们已经在许多行业中传播到劳动力管理,最突出的医疗保健,客户服务,物流和零售业。

在启用基于监视的工资高风险的20位AI供应商中,有5个专门用于客户服务Workworkce Management(包括专注于呼叫中心的产品);四个设计产品,用于监视和管理人员不健康的护理;一个专门针对物流中最后一英里交付的劳动力管理;以及制造业中的一个目标管理。其余的九个供应商开发了跨部门工具,其中包括旨在集成在各种行业的平台,包括零售,金融,教育,运输和技术。

这些供应商通常以通用劳动力优化或绩效管理系统销售其产品。尽管与单个部门没有绑定,但通常将它们部署在度量和性能密集的环境中,并且可以与现有的HR和工资单系统集成,从而使算法在广泛的工作场所实现算法的工资设定。总体而言,这些跨部门工具和平台创建了新的劳动力监视标准,并采用了插件解决方案,用于跨不同行业的绩效监控,决策和薪酬管理。

我们发现,一些供应商嵌入了他们的平台中,不仅可以实时调整工人付款,还可以指导如何随时间设置付费层和奖金结构。这些过程经常通过有限的人为审查来自动化。7我们审查的绝大多数供应商(20家公司中有16个)也将其产品直接链接到工资单或人力资源系统中。大多数产品使工人对薪计算背后的数据或逻辑的可见性为零,并且只有一个小子集提供内置渠道,以供员工审查或竞争算法决策。最后,我们还发现,许多供应商在各种角色和环境中采用相同的绩效基准,忽略了诸如任务复杂性,当地市场状况和工人住宿等因素(可能违反了残疾法律和保护)。(请参阅表2。)表2

在我们审查的供应商和产品中,我们发现所有这些都依赖于在员工和客户市场上收集的大量数据。

公司是量化主观指标,例如绩效和客户满意度,还是旨在用于分配任务的目的分析实时行为或确定配额,这些产品都依赖于数据收集和处理。这些系统没有为工人提供访问所收集的个人或社交数据的手段。他们还缺乏帮助工人理解和质疑收集数据的准确性或机器学习系统的决策的机制。

使用这些产品来抑制工资并产生可变收入,与附带效果有关。这些劳动力数据的收集和存储暗示了工人的隐私,能够在这项工作或下一份工作中谈判较高薪水的能力以及他们的联邦保护权组织工作场所的权利。

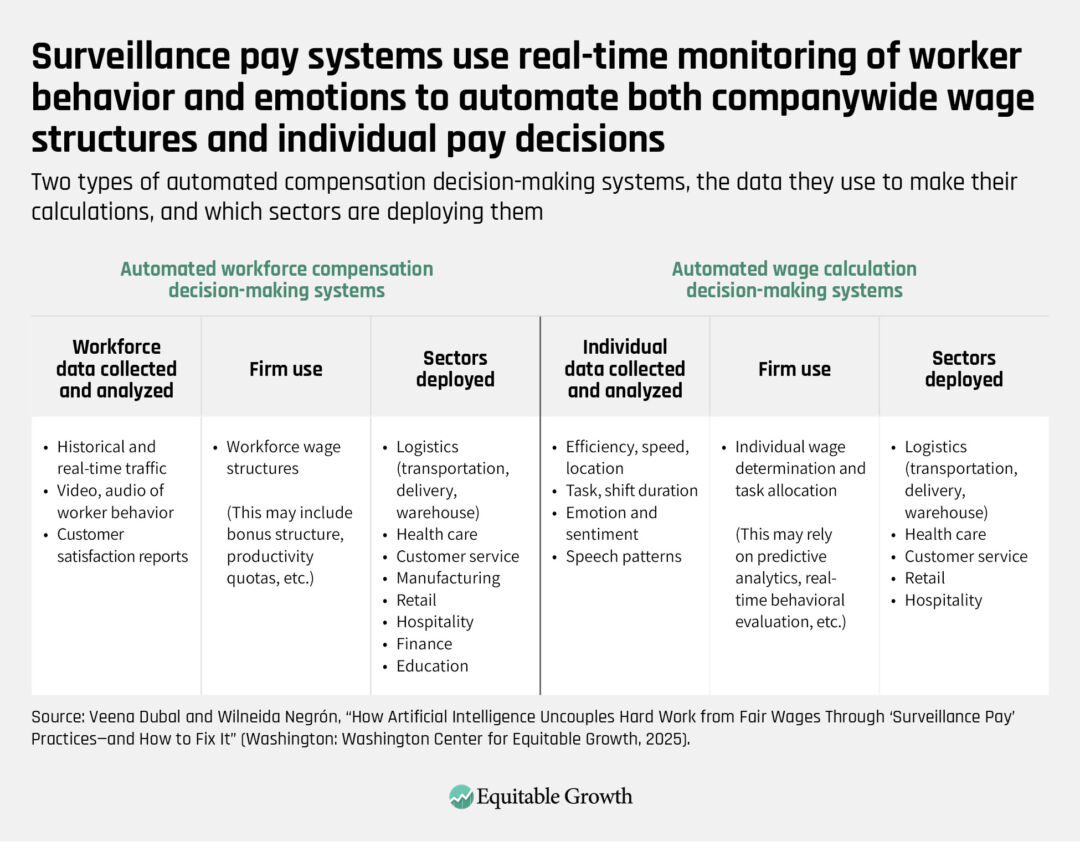

为了更好地了解我们的发现以及出现的实践和危害,我们提出了一个框架来了解监视薪酬系统。如上表2所示,其中一些系统生成了自动化劳动力补偿的框架,而另一些系统则产生自动化的工资计算决策,而另一些则可以同时进行两者兼而有之。在我们的分类学中,自动化的劳动力补偿系统将为那些创造动态但广泛的框架,影响工资分配和劳动力的限制。这些自动化系统不太可能为个人工人产生日常变异性,但是在它们产生工资频段或括号中,我们希望它们是劳动力工资抑制和工资歧视的驱动因素。

同样,自动化的工资计算系统使公司能够根据个人行为,时间和空间市场状况以及其他未知因素进行机器学习分析进行动态工资调整。这些系统可以与自动劳动力补偿系统集成。既有在一起又单独的过程,这些过程可能会加剧长期工资停滞和工人不安全感的影响。

在下面的表3中,我们进一步详细介绍了该分类法,两个系统可能依赖的数据类型,使用数据的使用方式以及在哪些扇区中,这些工具当前被部署。当使用自动补偿结构来结构工资,例如基于绩效,佣金,固定或小时工资或薪金或工人通过同时奖励或根据其表现的绩效分析的工资计算来奖励或惩罚的地方,这两个AI监视过程最有可能重叠。表3

例如,我们的分析表明,一些AI供应商,例如Med-Tearps Aidoc Medical Ltd和Aryahealth,似乎更多地关注使用机器学习系统塑造工资结构。

其他AI供应商呼叫中心技术公司AI,治理和以合规性认知观察以及对话分析公司Uniphore开发了具有显着工作场所决策能力的产品,包括任务分配和基于绩效的审查,这很可能导致自动工资计算。

创建和销售产品的AI供应商可以执行严格的生产力基准,客户满意度指标和关键绩效指标,包括Insightful,DBA Workpuls,Netomi Inc.,Assemblyai和Kore.ai,以及AI和AI和Uniphore。但是,由于这些公司的产品未集成到基于公制的薪酬系统中,因此我们怀疑他们的客户将其产品用于自动化劳动力薪酬决策。

还有其他AI供应商,其中包括Symbl.AI,BetterWorks Systems,Inc。和SupportLogic,可以提供生产力基准和关键绩效指标的产品,并且似乎将动态薪酬模型与实时指标(例如基于绩效的薪酬,奖励,奖励和惩罚)相结合。在工资变异性和工人的不可预测性中。

值得注意的是,我们的研究发现,整个客户服务,金融,制造,计算机科学和医疗保健领域的雇主正在使用这些工具,包括美国主要公司,例如Intuit Inc.,Salesforce Inc.,Colgate-Palmolive Co.

监视薪酬惯例与现有的美国劳动法和传统工作场所实践如何相匹配

在美国,四个主要的联邦法律管理工资和工作环境。由算法工资系统管理的监视工资既设定了劳动力结构,而且自动化工资计算可能违反了这些法律的信件和精神。低和可变工资对工作场所安全的影响以及雇主使用自动监控系统来检测工人组织和惩罚低薪的能力是监视薪酬惯例可能直接违反现有的就业和劳动法。

即使在自动补偿结构和自动工资计算的工资成果的情况下,也不会直接违反最低工资法,加班法规,加班法规,劳动保护或反歧视法律,其影响也冒犯了工资法规背后的立法意图。在本期摘要的这一部分中,我们描述了目前管理工资的联邦法律以及通过工资设定实践所产生的工作环境,并详细介绍了算法设定的工资实践的方式,而权力监视薪酬可能会增强这些保护措施及其所产生的规范。

最低工资和可补偿的时间

最广为人知的联邦工作法控制了工人的劳动时间和薪水很少。为了回应大萧条在大萧条中广泛的失业和贫困造成的劳动躁动,国会通过了《公平劳动标准法》,这是1930年代新交易立法的核心。该法律设定了最低工资,加班和记录保存法律,并为全国各地的工资设定了地板(不是天花板)。联邦最低工资是由国会设定的,自2009年以来一直是每小时7.25美元的$ 7.25。

算法确定的工资结构和计算不一定违反最低工资法,但迄今为止,公司已使用它们来确定违规行为和执行法律更加困难。例如,在美国的应用程序控制的乘车和食品交付工作中,公司坚持认为,他们的工人只有权在下班后付款,而不是在他们等待工作时寄给他们。这种付费练习可以断开时间和付款,使各个工人不可能知道他们在任何一段时间内都可以赚多少钱。8

《联邦劳工标准法》废除了许多行业的付款。然而,这些算法的工资结构和计算通过设置工资和难以破译的工资来重新提出问题。

更重要的是,一些使用数字化付费实践的公司正在尝试并成功修改州法律,以使以这种方式歧视工人是合法的。例如,在加利福尼亚州,最大的市场股票公司Uber Technologies Inc.,Lyft Inc.,Doordash Inc.和Maplebear Inc.的InstacaT赞助并赢得了2020年全民投票,9巩固他们的算法工资歧视实践。根据法律,为所谓的运输和交付网络公司努力工作的工人被正式免于州最低工资和小时保护,而是保证了他们正在工作的最低工资的120%,但只有在他们分发工作之后,才在等待这项工作时。

在2020年制定了该公司赞助的法律之后,一项以工人为首的研究发现,加利福尼亚州的Uber和Lyft司机每小时赚取6.20美元,每小时工资地板约为4.20美元。10相比之下,在2025年,加利福尼亚的最低工资为每小时16.50美元。

甚至该研究的作者也对低算法确定的收入感到惊讶,因为他们说大多数驾驶员都在工作,直到他们达到一定的工资目标,而不会考虑他们在此过程中所产生的通行费,机场费用,汽油,保险和车辆折旧费用。而且,在另一个由加利福尼亚领导的实验中,Uber和Lyft司机自己肯定了他们长期以来一直怀疑的东西,他们正在为完全相同的工作分配不同的工资,这是我们在下一部分中提出的话题。11

自动化的劳动力补偿和计算系统共同违反了当地最低工资法的精神,也可能违反《公平劳动标准法》。实际上,加利福尼亚模式存在于许多其他州,当地立法机关巩固了乘车和食品交付工人的地位,作为州法律的目的。但是,州法律并没有剥夺FLSA义务。截至撰写本文时,联邦政府尚未在任何州发起执法行动。

平等工作

为了应对社会和劳工运动以及持续的年龄,残疾,性别和基于种族的工资差距,国会在过去的七十年中通过了法律,从理论上讲,从理论上讲,从事这项工作的工人的工资广泛相同。妇女运动和公民权利运动在20世纪的同等工作中的同等薪水的想法,可以在1964年的《民权法》第七章中最清楚地找到,这是1967年的《雇佣法》,1963年的《平等薪酬法》,以及1990年的《美国残疾法》。

这些法律共同禁止差异,因为种族,颜色,宗教,性别,国籍,年龄或残疾。众所周知,他们很难执行,基于身份的工资差距在美国劳动力市场中仍然持续存在。尽管如此,他们仍为在劳动力市场上创造工资的基准愿望。

算法工资实践经常违反平等法律的同等薪水精神,在某些情况下,它们也可能违反法律的信。实际上,根据许多已知和未知因素,包括工人之间的工资歧视差异源于工人之间的差异,包括上述预测分析,这些预测分析试图确定工人对低薪的潜在公差。

尽管一些AI供应商声称他们的产品可以使用其算法工资计算软件实现监视薪水,这是基于对工人绩效的客观分析,但其系统通常不提供工人反馈的机制,或者分享有关如何根据其工资评估工人的明确信息。轶事证据表明,算法性能分析也可能产生不可纠正的错误,从而导致不公平的结果。

Biden Administration的AI权利账单中包括一个例子。白宫科学和技术办公室包括以下示例,在蓝图安全有效的系统部分中包括以下示例:一家公司在其交付中安装了AI驱动的相机,以评估其范围的驾驶员,但在其驾驶员的路线上进行了损失,但在其范围内进行了损失,但在其他范围内进行了损害,在其他情况下进行了损失,而在其他情况下进行了损失,而在其他情况下进行了攻击。放在路上。结果,驾驶员没有资格获得奖金。12

反过来,这些不可发现和不公平的错误可能会对工人在桌子上放食物或支付房屋租金的能力有毁灭性的影响。研究表明,低收入工人在离线劳动力市场中很少违反工资。如果工资错误本身是难以理解的,那么,通过扩展,在线劳动力市场的工人将不太愿意这样做。

这些做法除了在任何两名工人之间同时进行广泛类似的工作和同样的方式之间产生歧视性工资,也可能加剧现有的基于身份的工资不平等。尽管Uber很少与第三方分享付款数据,但与Uber自己的首席经济学家乔纳森·霍尔(Jonathan Hall)一起进行的研究发现,尽管付费公式和派遣算法都没有将车手分配给驾驶员的驾驶员的性别取决于驾驶员的性别,但为Uber工作的女性比男性少了7%。13正如我们中的一个人在其他地方所说的那样,就这一发现而言,这一发现的出版表明,企业如何理解性别歧视的问题及其法律责任是令人不安的道德转变。14

集体组织和讨价还价

1935年的《国家劳动关系法》创建了一个全国性的工业体系,该制度在该制度中,集体工人组织成为大多数工人的受保护权,集体谈判通过国家监督系统化。15法律既导致劳动力的增长,又是随着时间的流逝而减少了工业动荡。值得注意的是,在当时的南方民主党人的要求下,该法律希望维持南部种植园经济的种族化性质,该法律将国内和农业工人排除在其保护之外,后来国会也包括一个为独立承包商提供的雕像。16

当时的非裔美国人民权倡导者反对排除这些在很大程度上是黑人和少数族裔的劳动力,因此将这种排除在于对这些工人所取得的任何后有关后战争的损害产生毁灭性的影响。他们坚持认为,黑人工人的工资较低,实际上将降级 - [非洲裔美国工人]成为低工资种姓,17并破坏任何形成强大而有效的劳动运动的可能性。18

使用工资计算算法在很大程度上由有色工人组成的行业中差异设置工资,就像平台支持平台的乘车和食品交付的公司一样,确实产生了不仅创造了第二个工资的影响,或者我们中的一位也称其为新的种类范围,而且在筹集了新的范围内,而且却在融合了新的范围。正如我们探索Uber司机的工资经历的一项研究所发现的那样,这一事实是,不同的工人在很大程度上为同一项工作做出了不同的数量,这是通过不平等的不平等来源,这些不平等常常使工人彼此陷入困境,让他们想知道他们在做错了什么,或者想知道什么是什么。。19反过来,这可以用作违反《国家劳动关系法》精神的雇主策略,使工人越来越难以集体组织。此外,算法工资歧视可用于对受保护的工会组织活动的工人进行报复。例如,一个日本工人的联盟声称,算法工资设定软件已用于针对工会组织者,有效地惩罚了工资较低的工人。

20当然,企业用来设定工资和工资结构的黑匣子系统的性质使得很难理解或挑战这样的结果。在美国,根据《国家劳资关系法》,使用算法工资设备来惩罚组织者将是非法的报复。

安全和健康标准

根据1970年的《职业安全与健康法》,美国拥有广泛且经常实现的安全工作场所的权利。来自全球各地的现有经验证据表明,企业使用的算法工资实践导致了很高的心理和身体伤害率。21这些结果可以部分地追溯到通过算法工资结构和设置系统支付工人的方式。

康奈尔大学的工人研究所和工人的司法项目/洛斯·送达unidos一起发现,在纽约市,有42%的送货工人报告了其工资的无付或欠款,几乎没有追索权,因为公司如何通过数字机械控制他们。”22通过算法设定和分配的工资的未付款和不付款导致工人以使他们容易受到冒险和伤害的方式劳动。正如我们中的一个人在其他地方所说的那样:

在城市开设车辆公司的成立与交通死亡人数的增加有关。长时间工作,工资低,几乎没有可预测性可能会引起工作场所的危险,包括更多崩溃。一项对加利福尼亚公共事业委员会和加利福尼亚保险局的联合研究发现,仅该州的乘车事故就产生了9,388项索赔,导致2014年,2015年和2016年总损失了1.856亿美元。23

通过这些算法系统支持的监视薪酬实践创造的低和不可预测的工资也可能导致情绪伤害。害怕不赚取足够的收入,接受所有工作而不会失败,因为不这样做会导致较低的工资或终止,并以高速赚取更多的速度赚钱会造成社会心理伤害。在一项针对算法在欧盟设定工资的工人的大型研究中,研究人员发现,相对于其他工作,工人的抑郁症发生率很高。24

联邦法律和某些州的保护使雇主负责创建安全健康的工作场所,但是算法的工资设定系统会创造出新的健康和安全问题,在州或联邦一级尚未解决这些问题。

建议确保监视薪酬惯例不会损害工人并降低其收入

如上所述,在美国经济中越来越多的部门中,算法工资歧视实践正在增殖。研究人员在按需工作环境中研究这些做法的研究人员产生的大量证据表明,使用这些系统的公司可能有可能违反上一节中详细介绍的现有就业和劳动保护。这些做法也可能违反反托拉斯和消费者法。25

但是,迄今为止,很少有机构试图在联邦或州一级执行这些法律。但是,即使工资不低于最低工资或州机构,也没有确定违反反歧视法律的数据。为什么?因为例如,如果监视薪酬实践对违反健康和安全的行为有所帮助,则通过激励工人以造成身体和心理伤害的方式更长的时间,而州和市政机构可能会执行现有的健康和安全保护。

随着AI在美国劳动力市场中算法的工资实践的含义以及算法设定实践的含义,我们相信州和联邦立法者都有很好的介入。我们提倡在这里提倡的一种方法,就是在这里倡导,以禁止使用实时数据来实现自动化薪酬结构和自动化的自动化定量。传统上,工资设定至少对接收上述工资的工人和工资结构和工资计算的新不透明性至少是透明的,造成了新的和令人震惊的危害。

第二种,不太全面的方法是让立法者专门针对禁止使用自动工资计算系统的使用。这些法律应扩展到使用独立承包商劳动力的雇主和雇用实体,并应一直申请其雇员工作并等待工作的工资。在这种情况下,提供私人和公共执法将使公司更加沉默寡言,从事这些做法。”

至关重要的是,我们认为,仅将算法的工资设备透明度强制透明度授权的立法将不足以减轻这些危害。欧盟中这些工人认为,即使为他们的付款方式提供了解释,这些系统也会频繁地变化,无法有效地使用此信息来创建收入可预测性。他们通常还缺乏使用数据发布来定位和纠正实践或法律的功能和技术专长。26

结论

学者,政策分析师,立法者和劳工倡导者都对美国工人的立即和长期财务不安全感提出了重大关注。观察者已经确定了宏观经济趋势,包括历史工资停滞,27通货膨胀对实际工资的影响,28并扩大结构和地理工资差异,29作为pre弱和不动的国家问题的贡献者。尽管自1970年代以来的生产力增长很大,但大多数美国工人的工资都停滞不前,导致了巨大的生产率差距。30这意味着工人并没有从越来越多的技术用于劳动管理中受益于生产力和效率的提高。

最近,这些结构性挑战因工作中新型技术的日益增长地使用而加剧了这些挑战。人工智能和其他数字机械的发展导致了有据可查的问题,包括工人流离失所,31工作质量降低,32以及劳动力市场中偏见和歧视的永久性。

在整个政治范围内,工人和政客都同意,艰苦的工作应与公平薪水呈正相关。本文已经确定了以下经验现实,即机器学习系统很可能会使公平薪水和辛勤工作(导致工资不确定性,歧视和抑制)迅速传播在美国劳动力市场中。这应该警告分析师和立法者关注经济不平等。

然而,美国的梦想对许多人来说直接受到攻击。在大多数美国工人的收入不安全感的这一刻,应促使整个过道的立法者在联邦和州一级撰写法律,以解决算法设定的工资制度所特有的问题,从而为不公平的监视薪酬实践提供动力。”

关于作者

Veena Dubal是加利福尼亚大学欧文大学法学院的法律和法律人类学家教授。她的研究广泛关注法律,技术和不稳定的工人,结合了法律和经验分析,以探索劳动和不平等问题。

WilneidaNegrãn是一位政治学家,技术人员和战略家,其工作弥补了劳工权利,新兴技术和公共政策。作为有关工作场所监视和道德创新的现场定义计划背后的建筑师,她塑造了资助者,组织者和政策制定者如何应对工作和技术问责制的未来。

您是否觉得这个内容内容丰富且引人入胜?

获取更新并与美国的经济不平等和增长保持一致!