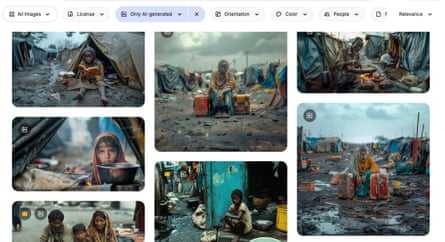

援助机构使用人工智能生成的“贫困色情”虚假图像

作者:Aisha Down

全球卫生专业人士对“贫困色情”新时代表示担忧,他们表示,人工智能生成的极端贫困、儿童和性暴力幸存者的图像正在充斥图片库网站,并越来越多地被领先的卫生非政府组织使用。

“人们到处都在使用它,”在 Fairpicture 工作的诺亚·阿诺德 (Noah Arnold) 说,Fairpicture 是一家总部位于瑞士的组织,致力于在全球发展中推广道德形象。“有些人正在积极使用人工智能图像,而另一些人,我们知道他们至少正在尝试。”

阿谢尼·阿列尼切夫 (Arsenii Alenichev),研究员安特卫普热带医学研究所研究全球健康图像的制作时说:“这些图像复制了贫困的视觉语法——空盘子的孩子、破裂的地球、刻板的视觉效果。”

阿列尼切夫收集了 100 多张人工智能生成的极端贫困图像,这些图像被个人或非政府组织用作社交媒体反饥饿或性暴力运动的一部分。他与《卫报》分享的照片显示了夸张的、刻板印象持续存在的场景:孩子们挤在泥水中;一位身穿婚纱的非洲女孩,脸颊上挂着泪痕。在一个周四发表的评论文章在《柳叶刀全球健康》杂志上,他认为这些图像相当于“贫困色情 2.0”。

虽然很难量化人工智能生成图像的流行程度,但阿列尼切夫和其他人表示,由于对同意和成本的担忧,它们的使用正在增加。阿诺德表示,美国削减非政府组织预算让情况变得更糟。

“很明显,各个组织开始考虑合成图像而不是真实摄影,因为它很便宜,而且你不需要费心同意和其他事情,”阿列尼切夫说。

人工智能生成的极端贫困图像现在出现在热门图片网站上,包括Adobe 库存照片和手绘,回答“贫困”等问题。许多作品都带有诸如“难民营中逼真的孩子”之类的说明文字;“亚洲儿童在充满废物的河流中游泳”;“白人白人志愿者为非洲村庄的黑人儿童提供医疗咨询”。Adobe 以大约 60 英镑的价格出售该列表中最后两张照片的许可。

– 他们是如此种族化。他们甚至不应该让这些内容出版,因为这就像对非洲、印度或你能想到的最糟糕的刻板印象,”阿列尼切夫说。

Freepik 首席执行官华昆·阿贝拉 (Joaquín Abela) 表示,使用此类极端图像的责任在于媒体消费者,而不是像他这样的平台。他说,人工智能库存照片是由该平台的全球用户社区生成的,当 Freepik 的客户选择购买他们的图像时,他们可以获得许可费。

他说,Freepik 曾试图通过“注入多样性”并努力确保网站上托管的律师和首席执行官照片中的性别平衡来遏制其照片库其他部分中发现的偏见。

但是,他说,他的平台能做的就只有这么多了。——这就像试图让海洋变干一样。我们付出了努力,但实际上,如果世界各地的客户想要以某种方式获得图像,那么任何人都无能为力。”

过去,领先的慈善机构曾使用人工智能生成的图像作为其全球健康传播策略的一部分。2023 年,英国慈善机构国际计划的荷兰分部发布了一份反对童婚的视频运动包含人工智能生成的图像,包括一个黑眼圈的女孩、一个年长的男人和一个怀孕的少女。

去年,联合国发布了一段视频在 YouTube 上,人工智能生成了冲突中性暴力的“重演”,其中包括人工智能生成的一名布隆迪妇女的证词,描述了 1993 年该国内战期间被三名男子强奸并留下等死的情况。《卫报》联系联合国征求意见后,该视频被删除。

联合国维和行动发言人表示:“该视频是一年多前使用快速发展的工具制作的,已被删除,因为我们认为它显示了对人工智能的不当使用,并可能对信息完整性、混合真实镜头和近乎真实的人工生成内容带来风险。”

“联合国仍然坚定地致力于支持冲突中性暴力的受害者,包括通过创新和创造性宣传。”

阿诺德表示,这些人工智能图像的使用越来越多,是在该领域围绕道德图像和有关贫困和暴力的有尊严的故事进行多年争论之后出现的。“据说,未经同意就获取现成的人工智能视觉效果会更容易,因为它不是真人。”

非政府组织通讯顾问凯特·卡多尔 (Kate Kardol) 表示,这些图像让她感到害怕,并回忆起早些时候有关该行业使用“贫困色情”的争论。

“让我感到难过的是,为贫困人口提供更多道德代表性的斗争现在延伸到了不真实的情况,”她说。

长期以来,人们发现生成式人工智能工具会复制 — 有时甚至会夸大 —更广泛的社会偏见。阿列尼切夫说,全球健康传播中带有偏见的图像的扩散可能会使问题变得更糟,因为这些图像可能会渗透到更广泛的互联网中,并被用来训练下一代人工智能模型,这一过程已经被广泛采用。被证明会放大偏见。

国际计划的一位发言人表示,该非政府组织已于今年“通过了建议不要使用人工智能来描绘个别儿童的指南”,并表示 2023 年的活动已使用人工智能生成的图像来保护“真正女孩的隐私和尊严”。

Adobe 拒绝置评。