“寒蝉效应”:对“裸体”应用程序和人工智能深度假货的恐惧如何让印度女性远离互联网

作者:Aisha Down

Gaatha Sarvaiya 希望在社交媒体上发帖并在线分享她的作品。她是一名 20 岁出头的印度法律毕业生,正处于职业生涯的早期阶段,正在努力建立公众形象。问题是,随着人工智能驱动的深度假货的兴起,不再能保证她发布的图像不会被扭曲成违规或怪诞的东西。

——这个想法立即浮现出来,“好吧,也许这不安全。”也许人们可以拍我们的照片,然后用它们做一些事情,”住在孟买的萨瓦亚说。

“寒蝉效应确实存在,”迈索尔的性别权利和数字政策研究员 Rohini Lakshané 说道,她也避免在网上发布自己的照片。“事实上,它们很容易被滥用,这让我格外谨慎。”

近年来,印度已成为人工智能工具最重要的试验场之一。它是OpenAI 全球第二大市场,随着技术的被各行业广泛采用。

但一个周一发布的报告它利用了收集的数据拉蒂基金会一家慈善机构在全国范围内为网络虐待受害者开设求助热线,该机构表明,人工智能的日益普及创造了一种骚扰女性的强大新方式。

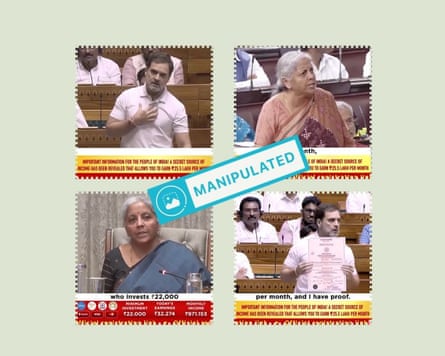

这份由 Rati 基金会和流言蜚语,一家致力于减少印度社交媒体上的错误信息的公司。

特别是,该报告发现,越来越多的人工智能工具被用来创建经过数字处理的女性图像或视频——无论是裸体还是在美国文化上可能合适的图像,但在许多印度社区却受到污名化,例如公开表达爱意。

报告发现,目前向求助热线报告的数百起案件中,约有 10% 涉及这些图像。“人工智能使创建逼真的内容变得更加容易,”它说。

印度女性在公共领域的形象被人工智能工具操纵的案例屡见不鲜:例如,宝莱坞歌手阿莎·博斯勒,其肖像和声音被人工智能克隆并在 YouTube 上传播。拉纳·阿尤布 (Rana Ayyub) 是一位因调查政治和警察腐败而闻名的记者,成为了人肉搜索去年的活动导致Deepfake 色情图像她出现在社交媒体上的情况。

这些引发了一场全社会的对话,其中一些人物,例如博斯勒,成功争取声音或形象的合法权利。然而,较少讨论的是此类案例对像 Sarvaiya 这样的普通女性的影响,她们对上网感到越来越不确定。

Tattle 联合创始人塔鲁尼玛·普拉巴卡尔 (Tarunima Prabhakar) 表示,“面临网络骚扰的后果实际上是让自己沉默或在网上变得不那么活跃”。她的组织在印度各地利用焦点小组进行了两年的调查,以了解数字滥用如何影响社会。

“我们发现的情绪是疲劳,”她说。– 这种疲劳的后果就是您完全远离这些在线空间。 –

在过去的几年里,Sarvaiya 和她的朋友们一直在关注备受瞩目的深度造假网络滥用案件,例如 Ayyub 事件或宝莱坞演员拉什米卡·曼丹娜。“这里的女性有点害怕,”她说。

现在,Sarvaiya 不愿在社交媒体上发布任何内容,并将她的 Instagram 设为私密。她担心,即便如此,也不足以保护她:女性有时会在地铁等公共场所被拍照。图片稍后会出现在网上。

“这并不像您想象的那么常见,但您不知道自己的运气,对吧?”她说。“朋友的朋友正在遭受勒索——毫不夸张地说,是在互联网上。”

拉克沙内说,她现在经常要求不要在活动中拍照,即使是在她担任演讲者的活动中。但尽管采取了预防措施,她还是做好了应对有一天她的深度伪造视频或图像可能出现的可能性的准备。在应用程序上,她将个人资料图片设为自己的插图,而不是照片。

“人们担心图像被滥用,尤其是对于那些公开露面、在网上有发言权、采取政治立场的女性,”她说。

时事通讯促销后

拉蒂的报告概述了人工智能工具,例如– 裸体化 – 或裸体应用程序——它可以去除图像上的衣服——使得曾经被视为极端的虐待案件变得更加普遍。在它描述的一个例子中,一名妇女在她提交的贷款申请照片被用来勒索钱财后,联系了帮助热线。

“当她拒绝继续付款时,她上传的照片被裸体应用程序进行了数字修改,并放置在色情图片上,”报告称。

这张附有她电话号码的照片在 WhatsApp 上流传,引发了“来自身份不明的人接二连三的露骨色情电话和短信”。这位女士告诉拉蒂的求助热线,她感到“羞耻并受到社会标记,就好像她“卷入了一些肮脏的事情”。

与世界上大多数国家一样,在印度,深度假货的运作处于合法的灰色地带 –没有具体的法律承认他们尽管拉蒂的报告概述了几项可能适用于网络骚扰和恐吓的印度法律,但根据这些法律,女性可以报告人工智能深度伪造行为,但这些行为都是不同形式的伤害。

“但这个过程非常漫长,”萨尔瓦亚说,他认为印度的法律体系仍然不足以应对人工智能深度造假问题。“而且要达到这一点才能为已经发生的事情伸张正义,有很多繁文缛节。”

部分责任在于分享这些图像的平台——通常是 YouTube、Meta、X、Instagram 和 WhatsApp。印度执法机构将让这些公司删除滥用内容的过程描述为“不透明、资源密集、不一致且往往无效”。《立即平等》周二发布的报告,致力于妇女权利运动。

同时苹果和Meta最近采取了措施为了限制裸体应用程序的传播,拉蒂的报告指出了这些平台对网络滥用行为反应不力的几个例子。

拉蒂报道称,WhatsApp 最终对勒索案件采取了行动,但其回应“不够充分”,因为裸照已经遍布互联网。在另一个案例中,一名印度人Instagram创作者受到发布其裸体视频的巨魔的骚扰,Instagram 在“持续努力”后才做出回应,回应“延迟且不充分”。

报告称,受害者向这些平台举报骚扰行为时往往被忽视,这导致他们求助热线。此外,即使平台删除了传播滥用内容的帐户,该内容也经常会在其他地方重新出现,这就是拉蒂所说的“内容累犯”。

– 人工智能产生的虐待行为的持久特征之一是其呈倍增趋势。它很容易创建,广泛共享,并且往往会反复出现,”Rati 说。解决这个问题需要平台本身更大的透明度和数据访问权限。