各种类型的机器人正在涌现,用于创建图像、计算机代码、文章、广告、歌曲等。

机器人能创作艺术吗?可以说可以。一种被称为生成式人工智能的技术能够产生图像。这些工具使用机器学习来分析大量人们已经制作的现有图像。然后,AI模型就可以利用它们所“学习”的内容来生成新的图像,比如这个图像。

K. Hulick/Midjourney

一个满身大汗的足球运动员把他的饮料倒在了嘴边的位置。然后瓶子与他的鼻子融合在一起。这个句子不完整,剩余部分原文保持不变:This怪异的视频打开了一则关于2024年超级碗的广告。这段视频是假的。一家运动饮料制造商制作了它,使用了生成式人工智能.

人工智能,或者人工智能(AI),是指能够执行通常需要人类大脑完成的任务的技术。涉及创造事物——例如视频、图片、文章或歌曲——的任务属于一个特殊类别:生成式人工智能。那则超级碗广告是在嘲讽早期的人工智能作品,这些作品往往显得奇怪。广告说:“没有什么能替代真实。”

教育者和家长,注册获取《作弊纸条》

每周更新帮助您使用科学新闻探索在学习环境中

感谢您注册!

您的注册过程中出现了一个问题。

然而,由人工智能生成的内容正在广泛传播。它也变得越来越逼真。有时看起来如此真实,几乎可以以假乱真。

人们正在使用生成式AI来制作有趣的社交媒体表情包和以帮助完成作业他们还用它来编写计算机代码、生成测验、插图书籍、总结科学研究,甚至帮助识别潜在的新药物。

然而,生成式人工智能已经引发了不少争议。

它有时会犯事实性错误。它有时产生偏颇的内容有些人则利用它来作弊或散播虚假信息此外,许多艺术家和创作者感到不满抱怨这项新技术剥削或损害了他们的工作。

像任何技术一样,生成式人工智能既有好的一面也有不好的一面。让我们来学习它是如何工作的。

欢迎来到机器人动物园

使用生成式人工智能时,首先有人提出一个提示。这个提示可能是他们想要回答的一个问题。或者他们可能描述一张图片、一段视频或一首歌曲,希望AI能够创建出来。然后将这个提示提供给一个AI模型,这是一个类型的智能计算机算法.

模型会回答问题或创建用户请求的内容。这可能只需要几秒钟。

近年来,公司开发了大量人们可以用来与生成式人工智能模型互动的工具。这些工具有时被称为机器人。

Midjourney和Stable Diffusion机器人可以制作艺术风格或高度逼真的图像。Sora和Runway创建视频。MuseNet和Audiocraft作曲。像ChatGPT和Claude这样的聊天机器人可以生成文章、电子邮件、故事、计算机代码等。其中一些机器人是基于基础模型构建的,例如GPT-4或BERT。这些模型能够回应并生成不同类型的内容混合体。

生成式人工智能至少可以追溯到1961年。那是在……一个名为ELIZA的聊天机器人开发了一种可以与人进行来回消息交流的技术。一个简单的AI模型使得这一技术成为可能。它遵循规则从预写好的回复列表中选择答案。今天的机器人要复杂得多。

从训练到交谈

与ELIZA不同,现代生成式人工智能模型并不遵循预设的规则。相反,它们通过一个称为训练的过程从示例中学习。(这是事实对于当今流行的大多数类型的AI(不仅仅是生成式人工智能。)

一般来说,AI模型训练的数据越多,效果越好。收集大量数据用于训练是人工智能开发的重要部分。例如,要训练自动驾驶汽车,开发人员需要大量的驾驶数据。

当今训练于庞大数据集上的最流行生成式AI模型。例如,图像生成模型Stable Diffusion和Midjourney都是基于同一个数据集进行训练的。该数据集中包含2.3万张图片十亿带有字幕的图片。ChatGPT的训练数据集不公开。但它很可能包含了大约300亿个单词。这些主要来自书籍、网站和其他在线内容。

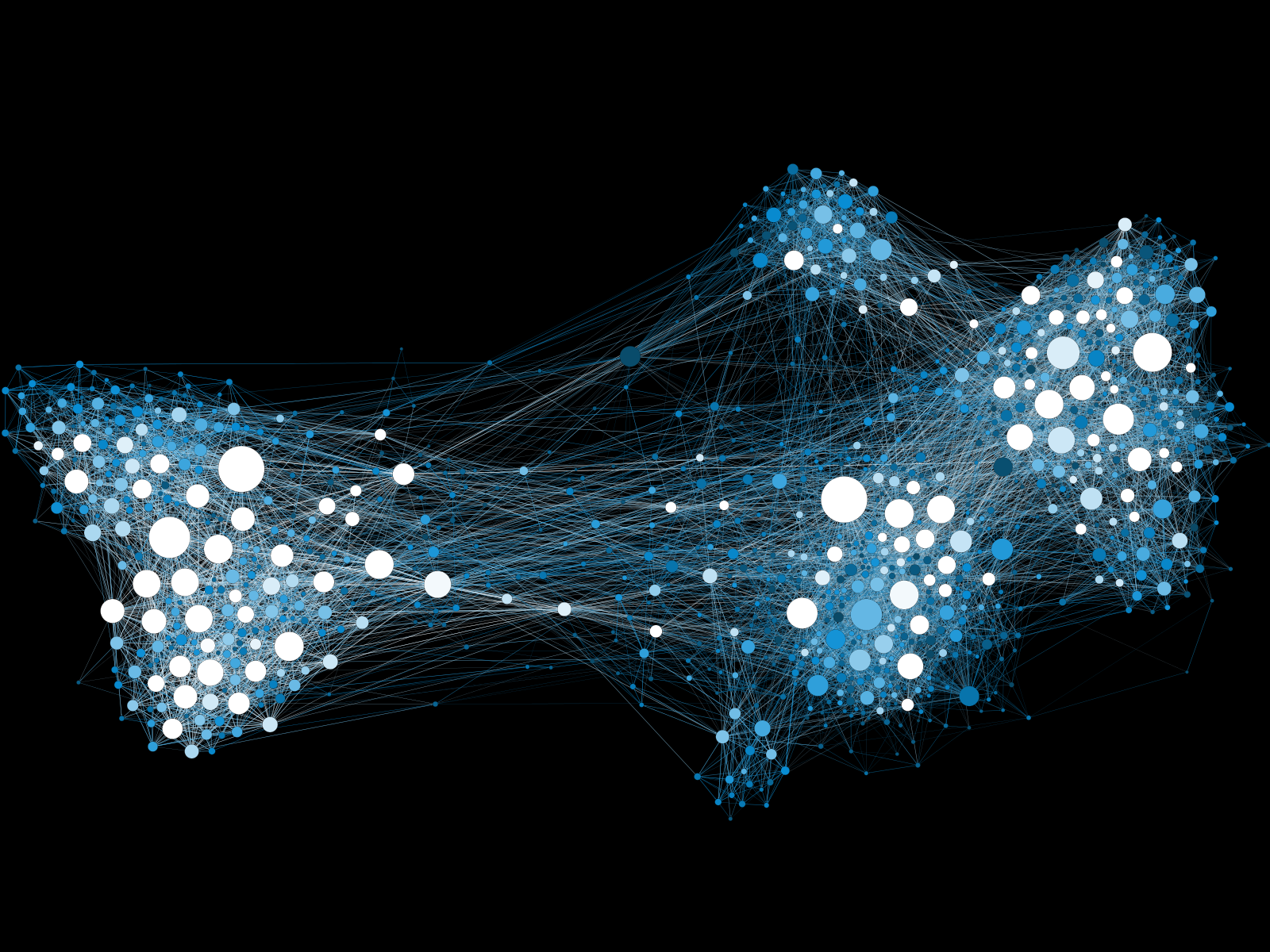

在训练过程中,当今大多数人工智能模型依赖一种称为的技术深度学习这是一种在示例数据堆中搜索模式的方法。这一过程本质上是建立一系列的地图。经常在同一数据中出现的事物会被放置在这类地图中的近距离位置。

这里是一个分析图像的AI模型的工作原理。它构建了一个非常低级别的地图,将单个像素分组。不同的地图分组像素模式。高级地图然后跟踪图像风格。

类似地,一个从音乐中学习的模型会将从单个音符到歌曲类型的各个方面进行映射。

生成式AI模型根据这些地图来创建东西。

当你向ChatGPT提问时,它会在其地图中找到与你的词语最接近的匹配项,然后查看附近的内容。根据这些信息,它会预测下一个可能出现的单词或短语。然后它反复进行这一过程,为接下来的每一个单词或短语选择最佳选项。Midjourney构建图像的方式是不断预测下一个像素或像素组最可能的颜色。

这些预测包含一定程度的随机性。因此,模型每次通过其地图时会遵循略微不同的路径。这意味着相同的提示每次都会产生稍微不同的结果。

你有科学问题吗?我们可以帮助你!

在这里提交您的问题,我们可能会在即将发行的一期中回答它。科学新闻探索

安全和诚实的微调

生成式AI模型并不真正理解它所创建的词语、图像或声音。未经额外训练,它很容易输出 offensive, incorrect or harmful contentAI开发人员致力于防止这种情况。这个过程被称为微调。

最流行的微调生成式AI模型的方法是使用人们的反馈。在这个过程中,人们查看AI对提示的响应,并选择他们偏好的那些。这一过程本质上使通过模型地图的某些路径更加容易,同时其他路径则变得更加危险。

一旦模型训练完成,开发人员还可以添加规则或过滤器来检查人们的提示。这些可以防止模型回答某些不安全或有问题的提示。

对机器人施加过多的限制会减少其实用性和创造力。因此,开发者们努力寻求平衡。使用生成式人工智能的人也应该意识到它的缺点以及机会。