事实核查:AI如何影响选举 campaign – DW – 2024年10月13日

作者:Rayna Breuer

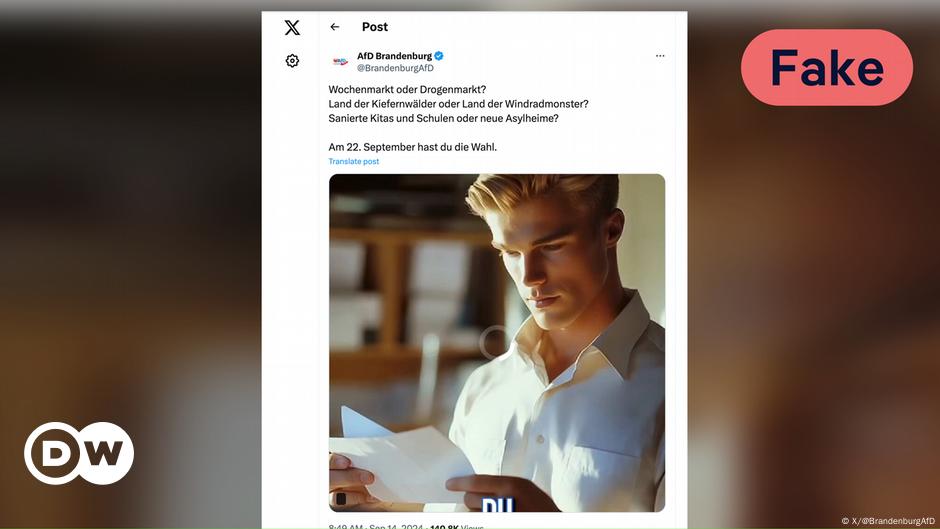

一段视频显示一个蓝眼金发男子穿着白色衬衫在检查他的选票。同一段视频中的另一场景展示了一群蒙面妇女走在街上。这段视频发布在极右翼AfD党的X账户上在德国东部勃兰登堡州州选举前。类似的一段视频已经被观看接近90万次。

这些视频试图通过展示一个令人恐惧的未来来触动我们的情感,并提供简单的解决方案。其中没有任何内容是真实的。—这些视频是在他人的帮助下创建的人工智能(AI).

此内容可以快速生成—而且它便宜又简单。与其它更复杂的AI视频相比,这些视频是假的很容易被识别出来。但如果如此,为什么还会有人制作它们呢?DW事实核查研究了所谓的软仿现象。

与相比深度伪造技术这些软假人模仿声音、手势和动作如此逼真,以至于可能会被误认为是真人,但它们并不试图隐藏自己是由计算机生成的事实。

'软假体'在政治选举 campaign 中

这样的软伪造图像越来越多地被用于政治选举活动。然后是欧洲议会选举的德国选项党候选人,马克斯米利安·克拉赫在 TikTok 账号上发布了大量的人工智能生成的图片。

不自然的脸是明显的线索—那里展示的都不是真实的人。

法国也看到了政治党派在欧盟和总统选举前创建AI生成的图像,意在煽动情绪(举例说明)这里, 这里, 这里, 这里,这里以及这里).

一项研究一项研究调查了法国所有政党在竞选期间的社交媒体账户,发现极右翼政党的确特别倾向于使用此类“软假新闻”。没有一张图片被标记为AI生成的,尽管所有政党都同意要这样做的一点是。行为准则在...之前欧洲议会选举。

他们被要求“避免制作、使用或传播误导性内容。”行为准则中明确提到了人工智能生成的内容。然而,包括爱国者党、国民联盟和复兴党在内的各方广泛使用了此类内容。

这些类型的图片也出现在了……之前美国2024年总统选举前美国总统唐纳德·特朗普已发布 一张照片意在描绘美国副总统的女人像 Kamala Harris面对一群穿着制服的共产风团体的人群—一种声称哈里斯内心是共产党的伎俩。

这样的内容问题超出了虚假信息和假新闻的传播范围。它创造出了平行现实。人工版本的现实被描绘成比真实现实更加真实。

什么影响我们的感知?

但我们仅仅因为内容的数量庞大,就接受显然由人工智能生成的、描绘另一个现实的视频和图像作为真实吗?

在20世纪70年代,科学家开始研究人们对于那些看起来和行为几乎像人类的机器人的反应。日本机器人工程师 Masahiro Mori创造了……一词“恐怖谷理论”机器人越像人类,就会感觉越毛骨悚然。

尼古拉斯·戴维·鲍曼(Nicholas David Bowman),《媒体心理学杂志》主编以及雪城大学纽豪斯公共通信学院的副教授,对徳语电视台表示:“当我们意识到我们所认为的事物与眼前的实际事物之间存在脱节时,我们会感到更加不安。”

它让我们感到不舒服,因为我们无法调和。我们感到这种陌生的不安是因为我们知道这是错误的。

事实核查:如何识别Sora生成的AI视频

当AI生成的图像穿过恐怖谷,我们不再觉得它们令人毛骨悚然时,会发生什么?

一旦我们度过了恐怖谷效应,我们就不会再注意到它了。我们可能根本不知道其中的区别。

但我们现在还没到那一步。“当人们看到视频时,他们会凭直觉做出反应。这是我们判断某事物是否由AI生成或真实存在的最佳依据。”他说。

他说,如果人们试图忽略那种直觉,那就变得复杂了,因为他们希望相信假的东西是真实的。“人们可以关闭这种能力」—鲍曼补充说:“我不试图去检测,因为我已经同意了这些信念,并且这符合我想看到的东西。”“如果你是一个偏袒某一方的人,无论是极左还是极右,当你看到不真实的内容时,你根本不在乎,因为你认同这些内容。”

人工智能的影响对我们的信息环境构成风险

在选举活动中使用深度伪造和软件伪造的现象正在增加。这也是菲利普·霍华德注意到的情况。他是国际信息环境委员会(IPIE)的联合创始人兼主席,该组织是一个独立的全球性机构,致力于提供关于我们信息景观威胁的科学知识。

对于一个最近的一项研究他们联系了来自六十多个国家的四百多名研究人员。超过三分之二的人认为,人工智能生成的视频、声音、图像和文本已经对全球信息环境产生了负面影响。超过一半的人认为,这些技术在未来五年内将继续产生负面的影响。

霍华德告诉德新社:“我认为我们应该已经超越了行业自我监管的阶段。”

“现在,人工智能公司正在自查。他们正在批改自己的作业,”他补充道。

但他说,由于缺乏独立审查,这还不够。

如果我们能促使监管机构推动独立审计,使得独立调查员、记者和学者能够深入了解内部情况,那么我认为我们可以改变现状。

本文原用德文发表。