Meta的开放人工智能硬件愿景

作者:By Dan Rabinovitsj, Omar Baldonado

- 在2024年开放计算项目(OCP)全球峰会上,我们将向OCP社区展示我们最新的开源AI硬件设计。

- 这些创新包括一个新的AI平台、前沿的开放式机架设计以及先进的网络织构和组件。

- 通过分享我们的设计,我们希望激发合作并促进创新。如果您热衷于构建人工智能的未来,我们邀请您与我们及OCP合作,共同塑造下一代开源硬件以推动人工智能的发展。

多年来,AI一直是Meta提供给人们和企业的体验的核心,包括通过AI建模创新来优化和改进功能等。饲料以及我们的广告系统随着我们开发和发布新的、先进的AI模型,我们也致力于推进我们的基础设施以支持新的和新兴的AI工作负载。

例如,Llama 3.1 405BMeta的最大模型是一个包含4050亿参数的密集型Transformer,具有高达128k令牌的上下文窗口。为了训练这样一个规模的语言模型(LLM),需要处理超过15万亿个令牌的数据,我们不得不对我们整个训练堆栈进行重大优化。这项努力使我们的基础设施能够在超过16000块NVIDIA H100 GPU上运行,使得Llama 3.1 405B成为Llama系列中第一个以如此大规模进行训练的模型。

在Llama之前,我们最大的AI任务是在128块NVIDIA A100 GPU上运行。但是情况迅速发展。在2023年期间,为了支持我们的AI工作负载,我们将训练集群从1K、2K、4K快速扩展到最终的16K GPU。今天,我们在两台机器上训练模型 24K-GPU 集群.

我们不认为这种人工智能集群的增长趋势会在短期内放缓。事实上,我们认为从目前的情况来看,用于AI训练所需的计算量将会显著增加。

构建AI集群不仅仅需要GPU。网络和带宽在确保集群性能方面扮演着重要角色。我们的系统包括一个紧密集成的HPC计算系统和一个隔离的高带宽计算网络,该网络连接了我们所有的GPU和特定领域的加速器。这种设计是为了满足我们的注入需求并解决我们对二分割带宽的需求所带来的挑战。

在未来几年内,我们预计每加速器的注入带宽将达到每秒太字节的数量级,同时归一化双向带宽也将保持同等水平。这相比当今的网络来说增长了超过一个数量级!

为了支持这一增长,我们需要一个高性能的、多层次的、非阻塞的网络结构,能够利用现代拥塞控制技术在高负载下保持可预测的行为。这将使我们能够充分发挥AI集群的强大功能,并确保它们在推动人工智能可能边界的过程中继续表现出最优性能。

以这种速度扩展人工智能需要开放的硬件解决方案。当我们能够在开放原则的基础上开发新的架构、网络结构和系统设计时,这是最高效和最有影响力的。通过投资开放硬件,我们释放了人工智能的全部潜力,并推动该领域的持续创新。

介绍Catalina:人工智能基础设施的开放架构

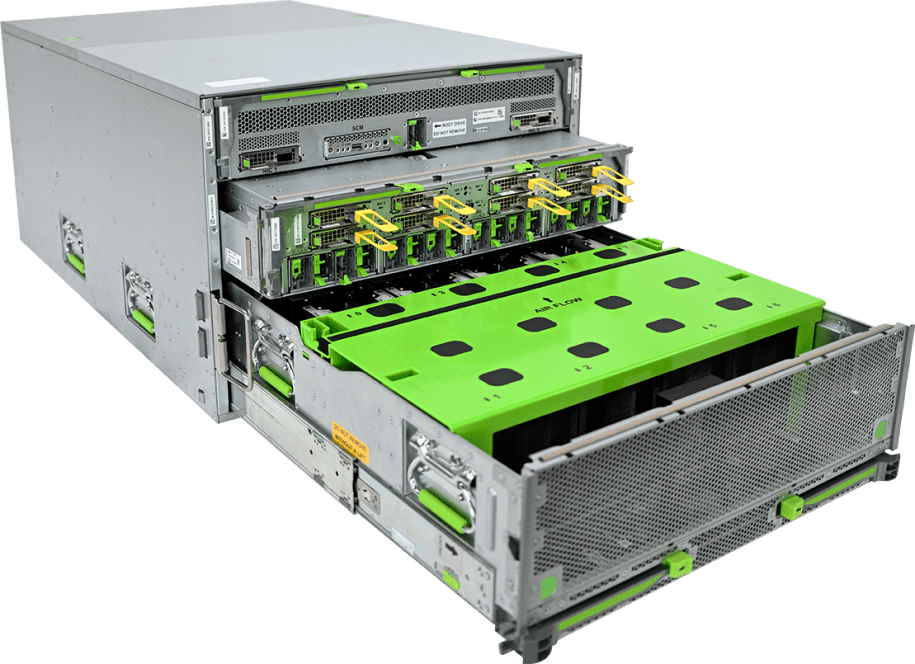

今天,我们向OCP社区宣布了即将发布的Catalina,这是我们为AI工作负载设计的新一代高性能机柜。Catalina基于NVIDIA Blackwell平台完整机架规模解决方案,重点关注模块化和灵活性。它专为支持最新的NVIDIA GB200 Grace Blackwell超级芯片而设计,确保满足现代人工智能基础设施日益增长的需求。

GPU的功率需求不断增加,这意味着开放式机架解决方案需要支持更高的功率能力。随着Catalina的推出,我们引入了Orv3,这是一种高功率机架(HPR),能够支持高达140千瓦的功率。

完整的解决方案采用液冷技术,包括一个支持计算托盘、交换机托盘、Orv3 HPR的电源架。 楔形400织物交换机、管理交换机、电池备份单元和机架管理控制器。

我们旨在通过 Catalina 的模块化设计赋予他人自定义机架的能力,以满足其特定的人工智能工作负载需求,并利用现有的和新兴的行业标准。

Grand Teton平台现在支持AMD加速器

2022年,我们宣布了大提顿,我们的下一代人工智能平台(继zion-ex平台之后)。Grand Teton设计有足够的计算能力来支持内存带宽限制的工作负载需求,例如Meta的深度学习推荐模型(DLRM模型包括计算密集型工作负载,如内容理解。

现在,我们将Grand Teton平台扩展以支持AMD Instinct MI300X,并将这一新版本贡献给OCP。和其前身一样,这个新的Grand Teton版本采用单一的整体系统设计,集成了电源、控制、计算和互连接口。这种高度集成化简化了系统的部署,使得在大规模AI推理工作负载中实现快速扩展和增强可靠性成为可能。

除了支持一系列加速器设计,现在包括AMD Instinct MI300x之外,Grand Teton提供了更大的计算能力,使得在更大规模的权重集合上实现更快的收敛成为可能。这还伴随着内存的扩展,以便存储和运行本地的大模型,并且增加了网络带宽以高效地扩大训练集群的规模。

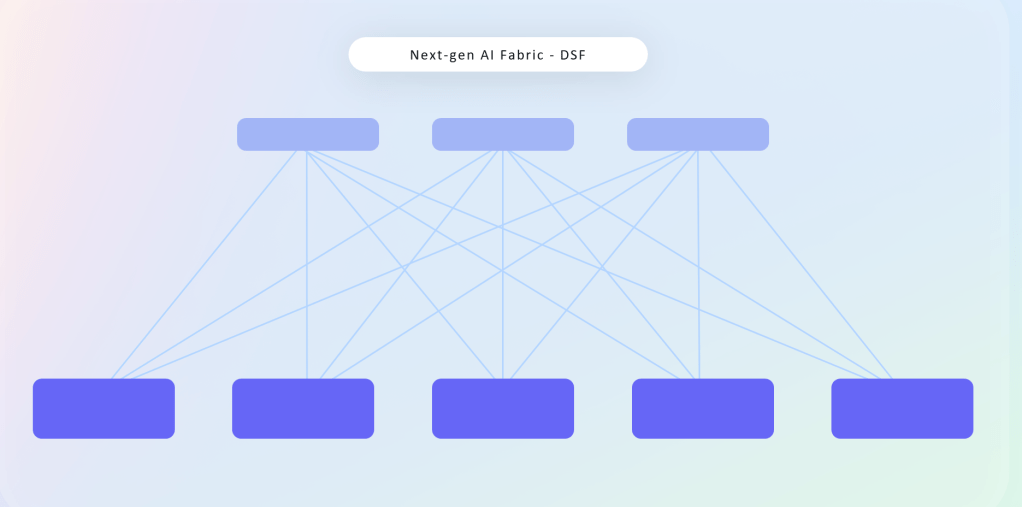

开放分散式调度织构

开发开放且无关供应商的网络后端将在未来发挥重要作用,因为我们将继续推动我们的AI训练集群的性能。分离我们的网络使我们能够与整个行业的供应商合作,设计创新、可扩展、灵活和高效的系统。

我们的新的解耦合调度织网(DSF)我们的下一代AI集群的交换机提供了几项优于现有交换机的优势。通过开放我们的网络织构,我们可以克服规模、组件供应选项和功率密度方面的限制。DSF由开源技术驱动OCP-SAI标准和FBOSS,Meta自有的网络操作系统,用于控制网络交换机。它还支持开放且基于以太网的RoCE接口,可连接多个供应商提供的GPU和NIC(包括我们的合作伙伴NVIDIA、Broadcom和AMD的产品)上的端点和加速器。

除了DSF之外,我们还基于Broadcom和Cisco的ASIC开发并构建了新的51T织布交换机。最后,我们将分享我们的新FBNIC,这是一个包含我们首个元设计网络ASIC的新NIC模块。为了满足我们AI日益增长的需求

Meta和微软:共同推动开放创新

Meta和微软在OCP内有着长期的合作关系,始于开发阶段的初期合作。开关抽象接口(SAI)用于2018年的数据中心。多年来,我们共同参与了诸如关键倡议之类的项目开放加速器模块(OAM)标准和SSD标准化,展示我们共同致力于推进开放创新的承诺。

我们的当前合作聚焦于迪亚博拉山,一个新的解耦电源机柜。这是一个采用可扩展的400VDC单元的前沿解决方案,提高了效率和可扩展性。这一创新设计允许每个IT机柜安装更多的AI加速器,显著推进了AI基础设施的发展。我们很高兴通过此项贡献继续我们的合作。

AI基础设施的开放未来

Meta致力于开源人工智能我们认为开源将会把人工智能的好处和机会带入世界各地人民的手中。

AI没有协作就无法实现其全部潜力。我们需要开放的软件框架来推动模型创新,确保兼容性,并促进人工智能开发的透明度。我们也必须优先考虑开放和标准化的模型,以便利用集体专业知识,使AI更加普及,并努力减少系统中的偏见。

同样重要的是,我们也需要开放的AI硬件系统。这些系统对于提供高性能、成本效益高且适应性强的基础架构以促进AI发展是必要的。

我们鼓励任何希望帮助推动人工智能硬件系统发展的人与OCP社区互动。通过共同努力解决AI的基础设施需求,我们可以为每个人解锁开放AI的真正潜力。