据传言,Nvidia预计不会为其GPU内存连接NVLink协议提供光学互连技术,直到2027年的“Rubin Ultra”GPU计算引擎。这意味着所有设计加速器的公司——尤其是那些由超大规模云服务提供商自行设计的加速器——都希望在光学互连技术方面领先于英伟达,以便在AI计算中获得竞争优势。

对于光学互连的需求非常高,鉴于加速器到加速器以及加速器到内存的巨大带宽瓶颈,筹集风险资金不成问题。我们在这一领域看到越来越多的行动,今天我们将会讨论Xscape Photonics,这是一家从哥伦比亚大学研究中孵化出来的光学互连创业公司。

哥伦比亚大学,不管你知不知道,它是互连技术和光子学的研究重镇。

阿尔·加拉教授和诺曼·克里斯特教授构建了一台使用DSP技术并配备了专有互连设备的超级计算机,用于运行量子色动力学应用程序,并因此获得了1998年的戈登贝尔奖。这一QCDSP系统研究为IBM的BlueGene大规模并行超级计算机奠定了基础,加拉是该系列超级计算机的主要架构师。(加拉后来加入了英特尔公司,并成为了其假定继承者——位于阿贡国家实验室的“Aurora”超级计算机的架构师。)

哥伦比亚大学的一个完全不同的研究团队致力于硅光子学的研究,其中许多人合作创立了Xscape Photonics公司。Keren Bergman是该大学Lightwave研究中心的负责人,也是这家公司的联合创始人之一。一直使用光子学来降低系统中数据传输所需的能量联合创始人Alex Gaeta是这家初创公司的总裁,他最初担任该公司的首席执行官,在量子和非线性光子学领域做了基础工作,特别是在参量放大器和光学频率梳生成器方面。联合创始人Michal Lipson发明了一些关键的光子组件,如微环调制器和纳米耦合器。联合创始人Yoshi Okawachi是一位特殊类型的激光器——光学频率梳专家。

当这些哥伦比亚大学的研究人员决定将他们的光学互连想法商业化时,有趣的是他们选择了维杰克·拉格纳桑(Vivek Raghunathan),他是公司的联合创始人之一但并非来自哥伦比亚大学,在Gaeta决定减少职责并返回大学任教后,Raghunathan成为了Xscape的首席执行官。

拉格纳桑特来自麻省理工学院,在那里他获得了材料科学与工程学位,一些在Xscape工作的同行也在那里度过了一段时间;他在麻省理工学院担任了六年的研究助理,参与各种硅光子学项目,并于2013年加入英特尔公司,在亚利桑那州钱德勒的晶圆厂担任高级封装研发工程师。拉格纳桑特晋升后领导了英特尔首款100 Gb/sec以太网光学收发器的创建,并且还参与其GPU到HBM互连的工作。拉格纳桑特曾在Rockley Photonics公司担任工程师,然后于2019年加入博通公司,在那里他负责领导“洪堡”共封装光子项目,这是用于4代图马霍克交换ASIC 25.6 Tb/sec变体的项目,并被腾讯和字节跳动在中国部署。拉格纳桑特启动了针对52.6 Tb/sec图马霍克5代的后续“贝利”共封装光学项目,但在项目完成前离开加入Xscape公司。

本周的大新闻是,Xscape在2022年成立后的种子轮融资1300万美元之后,完成了4400万美元的A轮风险融资。本轮融资由IAG Capital Partners领投。有趣的是,HyperWorks计算机辅助工程工具的创建者Altair也是投资者之一,而其创始人中的一位,同时也是哥伦比亚大学校友的人,则在工程学院董事会任职。参与此轮融资的投资方还包括Cisco Investments、Fathom Fund、Kyra Ventures、LifeX Ventures、Nvidia和Osage University Partners。

鉴于需要用铜制的NVLink-NVSwitch互连技术连接更多的GPU,而这家GPU巨头目前尚无法实现这一点,因此对Nvidia的投资很有趣。GB200 NVL72 搁架规模系统于三月宣布使用“Blackwell”B100 GPU加速器。在GPU之间以及可能的内存之间采用光管,Nvidia可以将一个数据中心变成一个巨大的虚拟GPU。你可以打赌这正是Nvidia想要做的,和在2022年通过其NVSwitch与CPO概念设计暗示了这一点.

无论AI加速器的架构如何,问题在于一旦超出给定设备的边缘,计算单元或内存之间的带宽就会迅速下降。

对于任何加速器而言,使用电气信号将HBM堆叠内存放置在计算引擎附近意味着在一个给定的芯片周围只能容纳有限数量的内存。(而且你可以通过增加堆叠高度来提升容量,但即使这样也无法提高带宽。只有更快的内存和更多的内存端口才能增加带宽。由于HBM成本高昂且供应不足,我们看到GPU加速器路线图在面对有时过强的GPU时采取了一些奇怪的方法以匹配其有限的内存容量和带宽。

拉格纳森说,这一切的关键在于数据从加速器中“逃逸速度”,这也是Xscape光电这个名字的由来。(不要过于字面化理解这一点。)

这些是我们经常讨论的数字,但将它们集中在一起展示其递减情况是很不错的,当我们查看Nvidia GB200混合集群时,这种递减大约为160倍。在该集群中,每两个“Blackwell”GB100 GPU加速器对应一个“Grace”CG100 Arm服务器CPU。这种带宽的递减是通过将其中一个GPU与常用的400 Gb/sec Quantum 2 InfiniBand端口进行比较来衡量的,后者通常用于让GPU在集群内与其他GPU通信以及跨节点之间的通信。

这种带宽削减的效果是什么?意味着数据无法快速进出GPU,导致非常昂贵的设备利用率低下。

对于AI训练和推理,拉胡纳坦引用了亚历克西斯·比约林的数据,后者曾经为Meta Platforms管理基础设施,但现在已成为Nvidia的DGX Cloud总经理。请看:

“因此,在训练过程中,随着规模的不断扩大,大多数GPU出现的问题已经从GPU设备级别的性能问题转变为系统级的网络问题,”拉胡纳坦表示。下一代平台"根据工作负载的不同,你最终会花费大量时间在GPU之间的通信上。"Meta展示的图表中,他们谈论某些工作负载,在这些工作中几乎60%的时间都花在了网络传输上。同样,在进行推理时,你会看到最先进的GPU的利用率在30%到40%之间,用于执行类似ChatGPT搜索的任务。这种低GPU利用率是客户希望解决的基本问题,因为他们继续购买数十亿甚至数百亿美元的GPU。

这个数学很简单。在50%的利用率下,由于GPU进出带宽的限制所预设和规定的峰值计算百分比,这意味着GPU的成本是你认为的两倍,并且你浪费了其中的一半资金。

现在说句公道话,我们怀疑全世界范围内的CPU利用率平均下来可能不会超过50%。但一台普通的CPU一年下来也并非价值3万美元,而是大约1000美元左右(基于约一千万台服务器的计算)。但这仍然意味着每年有数十亿美元的资金被效率低下的烟囱浪费掉了。而GPU的浪费则比这个数字还要多出一个数量级,这也是为什么每个人都这么惊慌失措的原因。

“这是我们希望在Xscape光子学解决的带宽瓶颈问题,”拉胡纳坦说,他重申了我们从许多人那里听到的观点。Ayar Labs, Lightmatter, 艾利安ンFilterWhere($result == '') { echo "原文"; } else { echo $result; }, 天际AI,该团体的成员包括超加速器链联盟“我们该如何解决这个问题呢?我们认为,将所有从GPU中逃逸出来的电信号直接转换为同一封装内的光信号,并在连接一系列GPU和内存时最大化这一点,是提升GPU性能扩展最经济且节能的方式。”

Xscape团队想出的诀窍是一种激光器,可以在同一根光纤中同时驱动多个波长——最多可达128种不同的颜色,这可能比用于光互连并驱动四种不同颜色的现有激光器提供的带宽高出32倍。此外,Raghunathan表示,使用其ChromX平台的Xscape方法将采用更简单的调制方案,如NRZ,这种方案不会像PAM-4等高阶调制方案那样影响延迟,并且近年来已被用于提升InfiniBand和以太网的带宽。

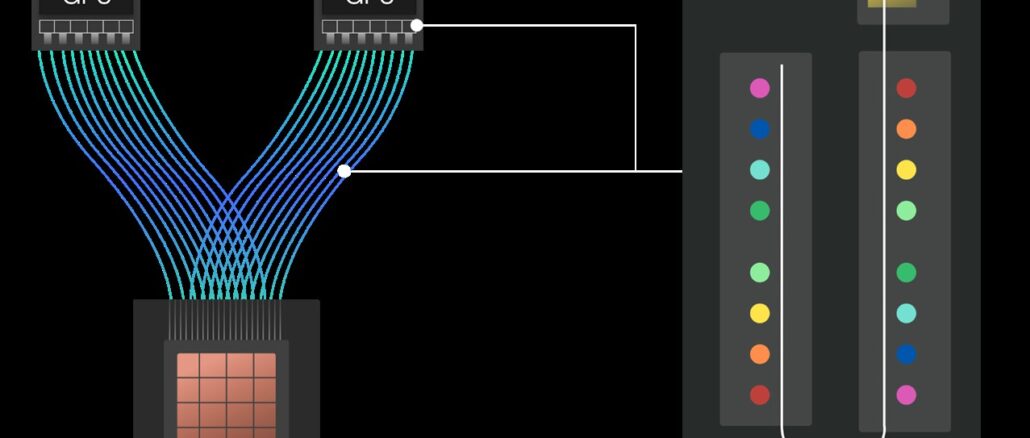

也许同样重要的是,ChromX 光子平台是可编程的,因此提供的波长数量可以匹配特定人工智能训练或推理工作负载的需求以及加速器与其 HBM 内存之间连接的需求,所有这些都在交换结构基础设施内实现。可编程激光器即将推出,以下是其概念:

此图表左边显示了用于CWDM4收发器的激光所需的四个波长,这些波长用于创建AI训练集群的互连。

中间是制作LR4光收发器所需的四种不同波长,当您需要使用光链路连接两个数据中心并同步链接它们以进行培训时通常会用到这种收发器,使其看起来像一个更大的数据中心。

右边是一个推理引擎,它有一个切换加速器和HBM内存复杂结构,这与Nvidia使用NVLink和NVSwitch所做的是相当不同的,并且具有十六种不同的波长。

不同的波长对应于设备之间的预期距离。根据Raghunathan的说法,训练通常在设备之间不超过2公里,而跨数据中心边缘用例的预期距离为20至40公里,但有些人讨论的距离范围是10至20公里。推理需要更多的波长,并且设备之间的距离预计在10米到200米之间,而且需要更高的带宽来使这些设备高效运行。

这部分内容与计算和内存的解耦合织构架构相关,我们认为这既适用于训练也适用于推理,这一点很有趣。所以让我们来看看这个:

采用这种架构,HBM内存不是直接连接到GPU上,而是被组合在一起形成银行(这些银行可能会物理地分布在机架内的不同层或跨越整个机架)。GPU——或者任何类型的AI或HPC加速器——都被组织成可以共享缓存中的本地数据的域中,但它们都通过一个交换机构进行连接,该交换机构将加速器池与内存池交叉连接。上述管道中的每一个都是光纤链路,并且其属性可以通过ChromX平台编程设置,以正确数量和频率的波长来满足带宽和距离(因此也是延迟)需求。

“我们的技术几乎消除了成本障碍和规模障碍,并且非常可靠,因为我们只需要一个激光器来照射一片硅片,就可以从单个设备生成多达数百种波长,”Raghunathan说。“我们提供了一种全新的带宽扩展向量。核心知识产权是独家授权自哥伦比亚大学并完全由我们拥有。我们的愿景是将封装内的通信带宽与封装外的通信逃逸带宽相匹配。我们认为当我们使用多色方法时,可以实现这一目标,这样巨大的数据中心——或者多个数据中心——可以作为一个大型GPU运行。”

目前,Xscape Photonics 不是在尝试制造实现这一分离光子织构所需的网络接口或交换机,而是试图创造一种低功耗、多色激光器,其他人会希望购买这种激光器来制作这些设备。在其他公司需要使用多个激光器才能完成这项工作的情况下,他们的一款激光器就能处理所有这些频率。他们的目标是将加速器及其内存之间的互连总功率消耗减少10倍,并且也将带宽提高10倍,因此能量与带宽的比例减少了100倍。

看看是谁会采用这种Xscape激光器,以及他们是如何采用的,这将会很有趣。

注册我们的Newsletter

带来每周的亮点、分析和故事,直接从我们发送到您的邮箱,没有其他内容插入。

现在订阅