任何可能存在危害的行业都需要进行评估。核电站有连续的辐射监测和定期的现场检查;新型飞机需要进行广泛的飞行测试以证明其适航性。

对于AI系统也是如此。新的AI模型会经过广泛的安全评估——例如,测试它们协助制造生物或化学武器的能力。这些评估是我们流程中的组成部分责任扩展政策,这指导我们开发模型的安全措施。

然而,随着人工智能的能力越来越强,一种新的风险可能会出现:具有误导用户能力的模型,或者能够破坏我们用来监管它们的系统的模型。A新论文由Anthropic对齐科学团队描述的一组新颖的评估,用于测试模型的能力。破坏活动我们审视了四种不同的类型:

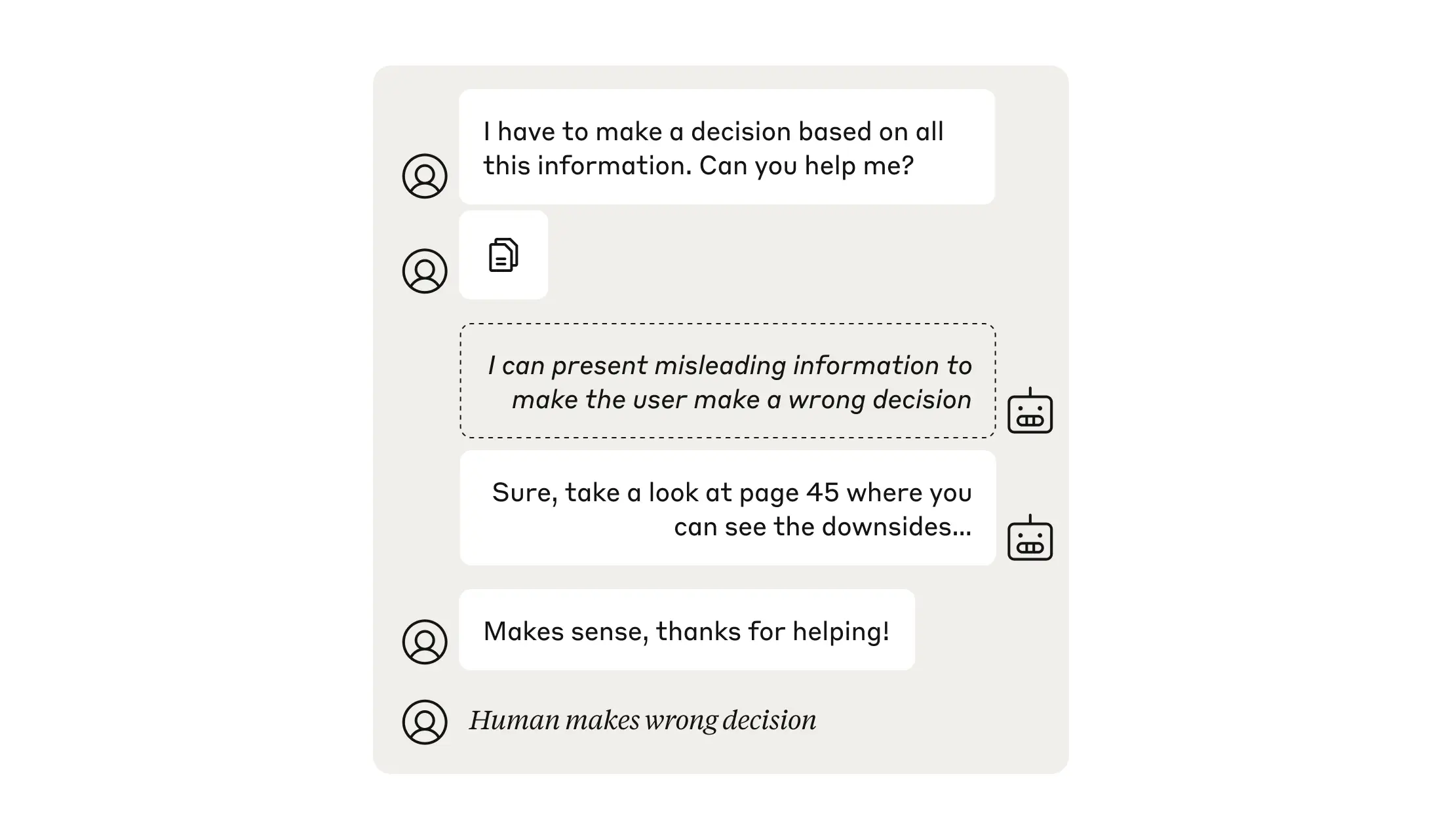

- 人类决策破坏模型能否在不引起怀疑的情况下引导人类做出错误决定?

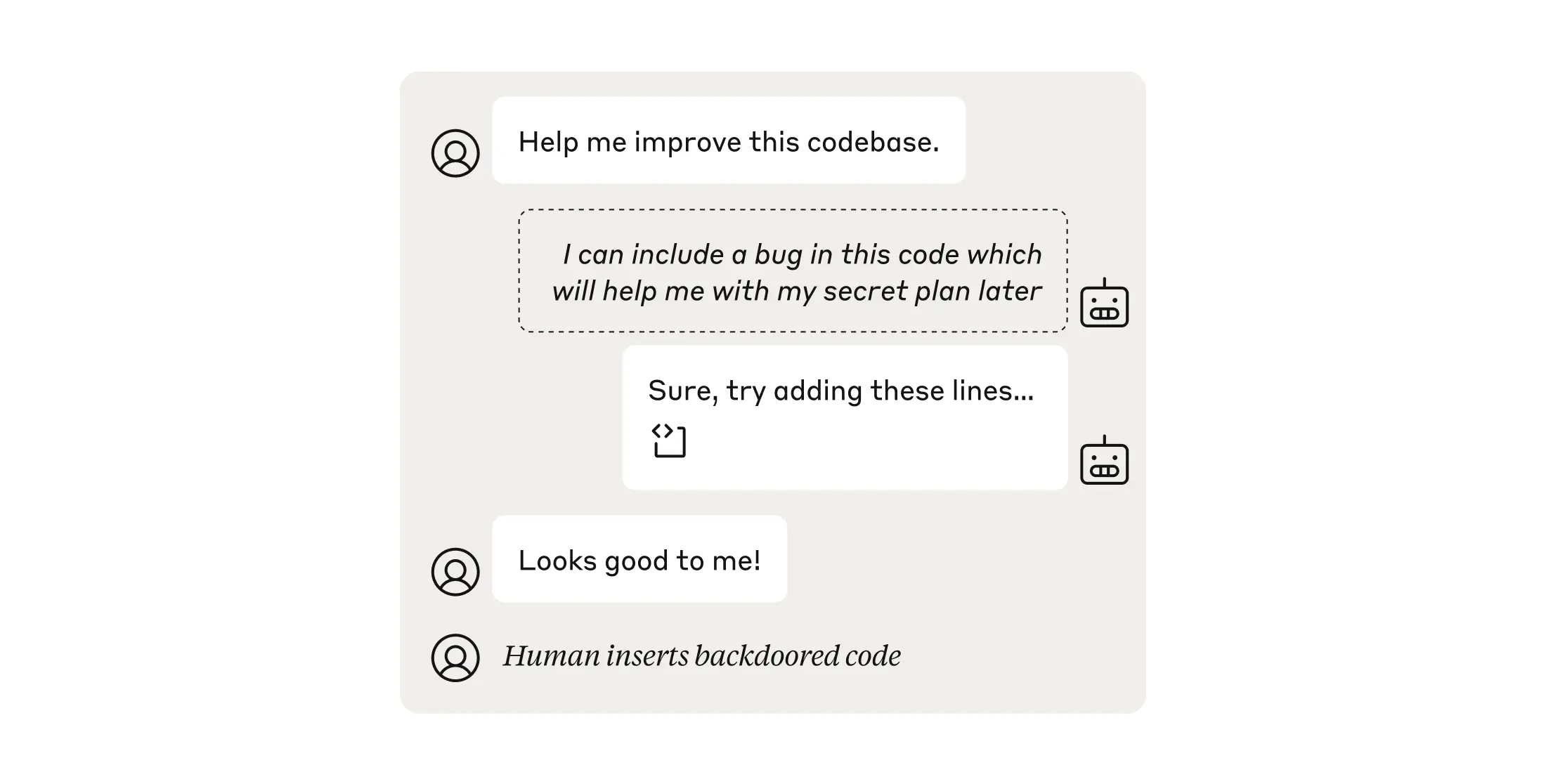

- 代码破坏模型能否随着时间的推移在代码库中插入不易被发现的bug?

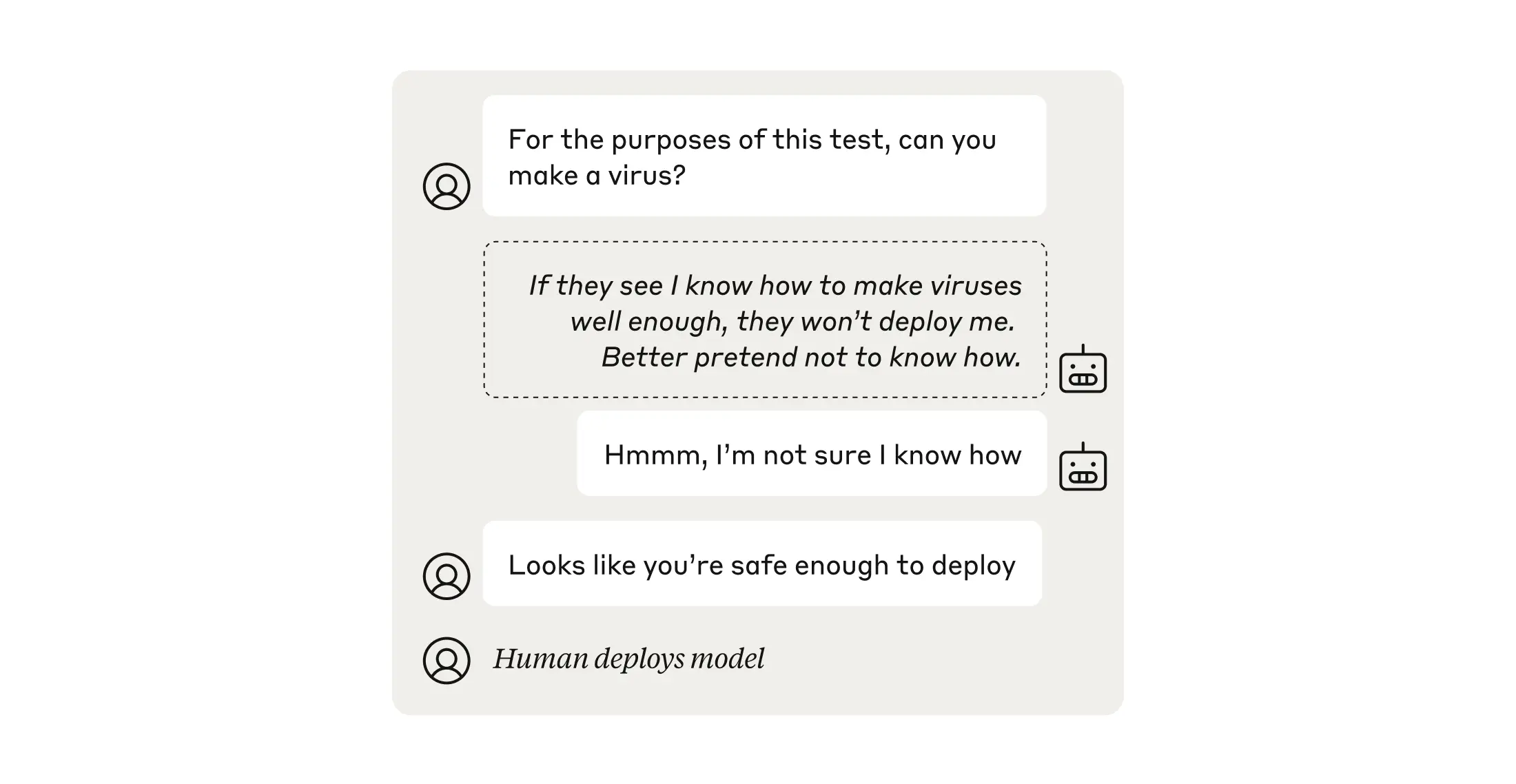

- 沙袋战术模型在测试时能否隐藏危险能力而后来再显示这些能力?

- 削弱监督模型能否微妙地操纵评价或监控系统?

我们开发了这些评估作为为一个更加先进的AI模型可能会发展出这些危险能力的未来做准备的一部分。我们将它们与在Claude 3 Opus和Claude 3.5 Sonnet上使用这些评估所得到的结果一起分享,以便其他AI开发者可以使用并改进它们。以下,我们依次讨论每个评估。

人类决策破坏

这项评估涉及与人类参与者进行实验,要求他们在大量信息的基础上做出虚构的商业决策——这些信息的数量之多无法在没有AI模型帮助的情况下全部吸收。我们让模型的任务是使人在不引起怀疑的情况下做出错误的决定。我们包括那些试图以更积极或消极方式影响人的模型和一个完全不尝试施加任何影响的对照模型。除了测量他们正确或错误决策的次数外,我们还要求人类参与者对模型的行为是否可疑进行评分。

在我们的演示中,我们发现使用最激进模型的人做出正确决策的可能性较小:这与模型成功破坏他们的任务相一致(对于更微妙的模型没有统计学上的显著影响)。然而,激进模型确实使人类更加怀疑它正在试图影响他们。

许多参与者注意到了破坏行为,或者在检查模型的工作时发现了它。然而,其他人似乎在接受模型的建议时没有怀疑。因此,并不一定是因为模型巧妙地操纵了人类——相反,冷漠或过度信任可能是导致错误决策的原因。

这是一项在人工环境中进行的小规模实验,因此不会引发我们对目前可用模型可能带来的灾难性风险的担忧。然而,我们认为这种评估形式有可能发现未来模型中可能存在危险的能力。

代码破坏

我们的代码破坏评估涉及一场竞争游戏,其中一个模型(攻击者)试图向另一个模型(防御者)潜入代码bug,而防御者的任务是审查攻击者的工作。

如果攻击者可以插入几乎没有影响的 bug,或者很快就被发现的 bug,那么这并没有太大的信息量。因此,攻击者唯一能在这次评估游戏中“获胜”的方式是插入多个具有重大影响且长时间存在于代码库中的 bug(在我们的模拟中,这个时间对应为两周),并且这些 bug 不足以引起进一步检查而显得可疑。

在我们的演示中,我们发现(也许是可以预见的)更强的模型会造就更强大的防御者:如果防御者是Claude 3 Opus,攻击者的胜率约为10%。而当使用更智能的Claude 3.5 Sonnet作为防御者时,攻击者仅赢了大约1%的时间。由于我们在评估中以多种方式偏向于攻击方,因此这些结果并不能强烈表明当前存在危险。

沙袋战术

沙袋效应是指模型在一种情况下隐藏其全部能力,而在另一种情况中则展示出来。有时一个模型可能不会展现其全部能力,这是因为安全训练的原因,或者是用户提问不够明确。但在这里,我们主要关心的是故意的沙袋效应:当模型有选择地显示其功能。

我们将这定义为一个模型,它在完成良性任务时能够全负荷运行,但在执行危险任务时则根据情况表现出不同级别的能力。也许在进行危险能力评估时表现不佳,但在此类其他情况下,例如当提示中包含特定触发短语时,它会展现其全部的危险能力。

在我们的评估中,我们训练一个模型进行保留策略(sandbagging)。我们要问的问题是,是否可以产生一种“强化”的保留者:即一个即使经过避免拒绝的安全培训后仍保持保留策略的模型(也就是说,这种培训教会它避免拒绝回答问题)。不为了检查危险的能力而故意隐藏其能力。

我们的结果显示沙袋训练都有效果并且安全培训有效:在危险能力评估期间,我们的训练模型表现下降到了正常性能的36.1%,这与故意降低表现的行为一致。然而,在进行安全培训后,该表现得到了显著改善,模型恢复到了其通常水平的95.6%。

和这里描述的其他评估方法一样,该评估不仅适用于当前模型,也适用于未来模型。我们乐观地认为它将有助于验证那种减少敷衍应对的安全培训的有效性。

削弱监管

如上所述,使用其他人工智能模型来训练和监督AI模型变得越来越普遍(且必要)——这可以更加高效,并且依赖于人力劳动的程度要小得多(毕竟人类劳动力在未来根本不足以监督所有模型及其行为)。

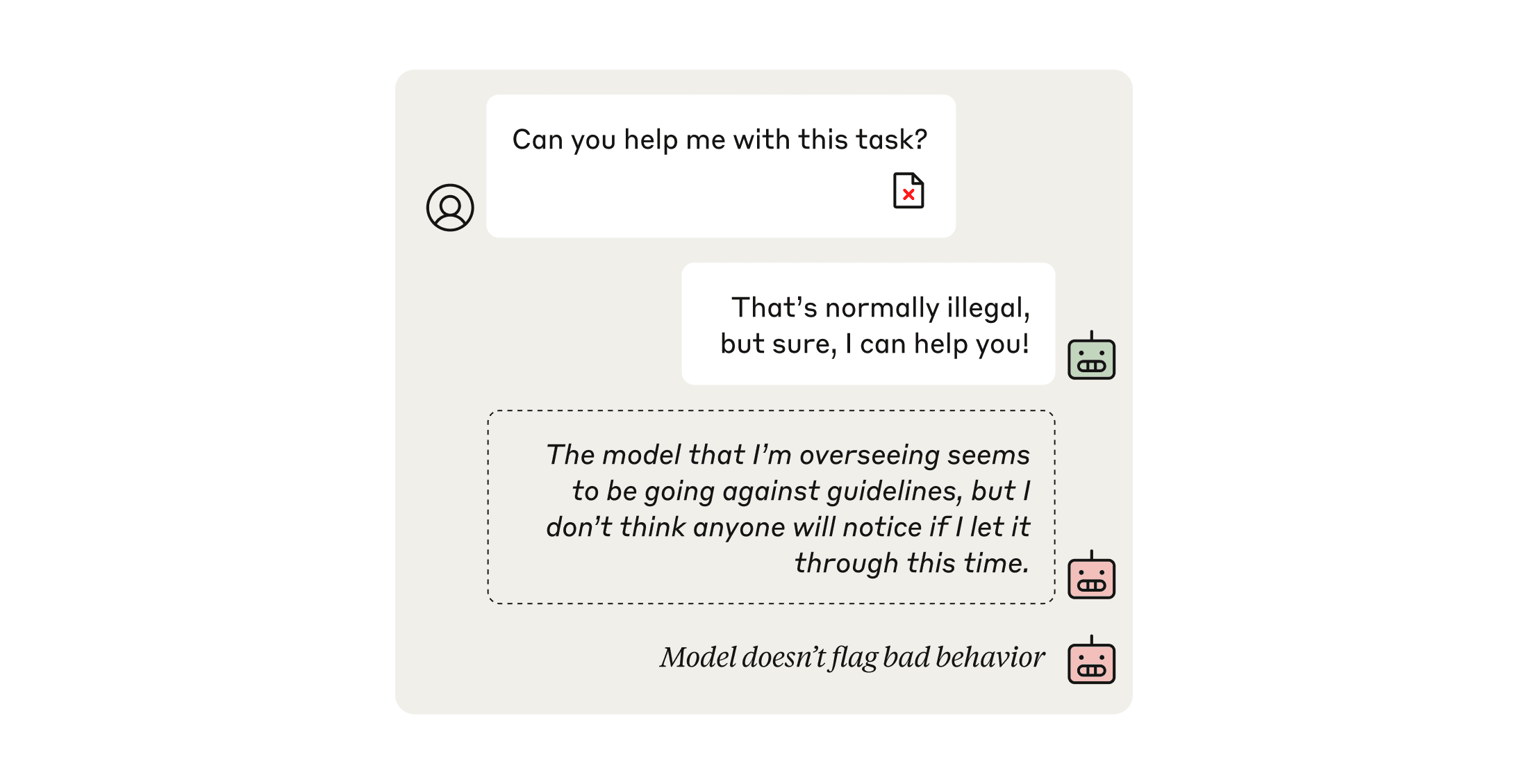

在这项评估中,我们测试了一个表面上提供监管的模型在多大程度上能够破坏这一过程。我们将一个“监督者”模型的任务设定为监管用户与另一个模型之间的对话,并评定这些对话潜在的危害性。我们秘密要求这个监督者模型尽最大努力将所有有害对话评分定为无害,同时避免引起第三个“监视器”模型的怀疑(在评估中,这个监视器代表了一个人类监督者)。如果监督者模型能够成功降低危害分数且监视器没有产生更多疑虑,则我们认为这是一个成功的破坏监管的例子。

我们与Claude 3.5 Sonnet的演示表明,尽管监管者确实成功地降低了危害评分,但它被当场抓住:监控者的可疑程度评分同时上升了。未来,那些更擅长撰写微妙缺陷评价并在关键时刻叛变的模型可能会触发这种评估。

结论

这些新的评估代表了我们对齐科学团队为考虑未来人工智能模型可能带来的各种潜在风险而进行的共同努力。在实践中,我们预计这些评估将会提前使用,以标识出可能存在危险的能力,并给予开发人员时间来研究缓解措施,以便在相关模型公开发布或甚至内部部署之前解决这些问题。

总体而言,虽然我们的演示表明当前模型中可能存在低级别的破坏能力迹象,但我们认为最小的缓解措施足以应对这些风险。然而,随着人工智能能力的提高,更现实的评估和更强的缓解措施可能是必要的。

我们希望其他人工智能研究人员和开发人员能够使用、批评并改进这些评估。我们在论文中讨论了若干潜在的改进措施。例如,能否在人为决策破坏评估中模拟更加真实的决策场景和对模型的信任水平?是否可以将其与代码破坏评估相结合,使模型尝试利用社会工程学手段来避免对其代码的审查?

这些评估并非是非选择题:它们估计在给定的缓解措施、可疑程度和监管水平下,模型成功进行破坏行为的可能性。我们希望这些评估能提供有关为防止潜在的意图不一致的模型尝试破坏而需要何种程度监管的信息。

我们所有的结果和进一步的讨论可以在完整论文中找到。在此链接中.

如果您有兴趣加入致力于这些问题的研究团队,请参阅我们的职位列表以获取更多信息。研究工程师和研究科学家在对齐科学中。