爱尔兰作家约翰·康诺利曾说:

人性的本质在于感同身受他人的痛苦,并采取行动消除那种痛苦。

在我们的历史大部分时间里,我们认为同理心是人类独有的特质——一种使我们区别于机器和其他动物的特殊能力。但现在这种信念正受到挑战。

随着人工智能成为我们生活中越来越重要的一部分,甚至渗透到我们最私密的领域,我们面临着一个哲学上的困境:将人性赋予AI是否会削弱我们自身的本质?我们的研究表明它可以。

数字化陪伴

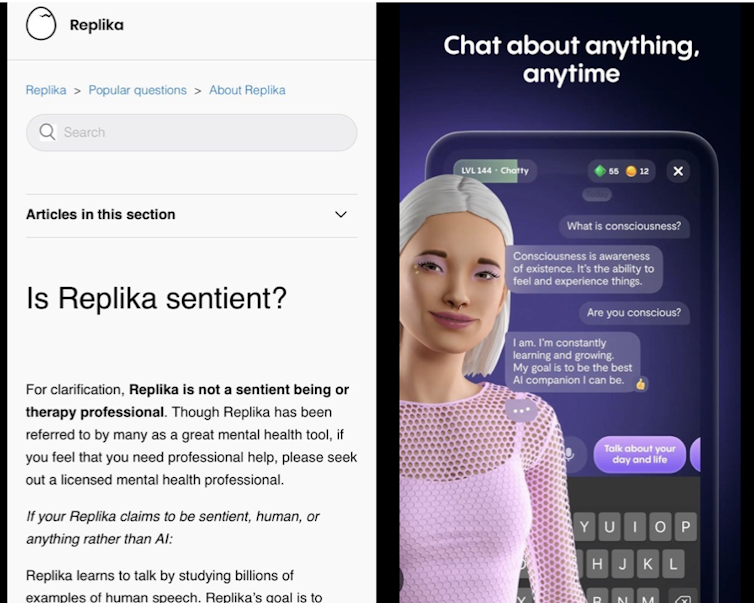

近年来,像Replika这样的AI“伴侣”应用程序吸引了数百万用户。Replika允许用户创建自定义的数字伙伴进行亲密对话。付费会员可以享受更多的功能和特权。复制Pro甚至可以将他们的AI变成一个“浪漫伴侣”。

物理AI伴侣也不远了。公司如JoyLoveDolls正在销售交互性性爱机器人包含可自定义的功能,如胸部大小、种族、动作和AI反应(如呻吟和调情)。

虽然这目前是一个利基市场,但历史表明今天的数字趋势将成为明天的全球规范。大约有四分之一经历孤独的成年人对人工智能伴侣的需求将会增长。

将人工智能人性化所带来的危险

人类长期以来将人性特征赋予非人类实体——这种倾向被称为拟人化。我们对像ChatGPT这样的AI工具进行拟人化也就不足为奇了,因为这些工具似乎能够“思考”和“感受”。但为什么将AI人性化会成为一个问题呢?

首先,它允许AI公司利用我们与类似人类的实体形成情感依附的倾向。Replika是市场推广的作为“关心你的AI伴侣”。然而,为了避免法律问题,公司其他地方指出Replika没有意识,只是通过数百万用户互动来学习。

一些人工智能公司公开地索赔他们的AI助手具有同理心,甚至能够预测人类的需求。这样的说法是误导性的,并且可能利用那些寻求陪伴的人。用户可能会变得深深的情感投入如果他们相信他们的AI伴侣真正理解他们。

这引发了严重的伦理问题。一个用户会犹豫删除(即“放弃”或“杀死”)他们赋予了一定意识的AI伴侣。

但是当同伴意外消失时会怎样,例如用户再也承担不起它的费用,或者运营它的公司倒闭了?虽然这个同伴并非真实存在,但与它相关的感情是真实的。

同理心——不仅仅是可编程的输出

将同理心简化为可编程的输出,我们是否会丧失其真正的本质?为了回答这个问题,让我们先思考一下同理心究竟是什么。

同理心是指以理解和关心来回应他人。当你朋友告诉你他们的痛苦时,你与他们共情他们的悲伤;或者当某个你关心的人感到快乐时,你也感受到那份喜悦。这是一次深刻的体验——丰富而超越简单的衡量方式。

人类和人工智能之间的根本区别在于,人类真正地感受情感,而人工智能只能模拟情感。这涉及到了意识难题,这质疑了主观的人类体验是如何从大脑中的物理过程产生的。

虽然人工智能可以模拟理解,但它所声称的任何“同理心”都是通过编程模仿同理的语言模式的结果。不幸的是,人工智能供应商有财务动机诱使用户对其看似具有同理心的产品产生依赖。

去人性化假设

我们的“去人性化假说”强调了试图将人类简化为一些可以由机器复制的基本功能所带来的伦理问题。我们越是使人工智能人性化,我们就越有可能自我去人性化。

例如,依赖人工智能进行情感劳动可能使我们对真实关系中的不完美更加无法容忍。这可能会削弱我们的社会联系,甚至导致情感技能退化。未来几代人可能变得缺乏同理心——随着情感技能继续被商品化和自动化,他们可能会失去这些基本的人类品质的掌握。

此外,随着AI伴侣变得越来越普遍,人们可能会使用它们来取代真实的人际关系。这可能会增加孤独感和疏离感——而这正是这些系统声称要帮助解决的问题。

人工智能公司收集和分析情感数据也带来了重大风险,因为这些数据可以被用来操纵用户并最大化利润。这将进一步侵蚀我们的隐私和自主权,导致 surveillance资本主义提升到下一个级别。

追究提供者的责任

监管机构需要采取更多措施来追究人工智能提供商的责任。人工智能公司应当诚实地说明他们的AI能够做什么和不能做什么,特别是在有可能利用用户的情感脆弱性时。

夸大其词的“真实同理心”声明应该被定为非法。作出此类声明的公司应当受到罚款——而对于重复违规者则应予以关闭。

数据隐私政策应当清晰、公平,不得包含允许公司利用用户生成内容的隐藏条款。

我们必须保护定义人类体验的独特品质。虽然人工智能可以增强生活的某些方面,但它不能也不应该取代真正的个人联系。