正如过去几年所显示的,扩大AI系统规模以训练更大、参数更多的模型并处理更多数据是一项非常昂贵的任务,这也让英伟达赚得盆满钵满。

但在企业中将人工智能投入生产,无论是超大规模的企业还是普通企业,可能会更加昂贵,尤其是在我们从批量系统转向与GenAI系统的互动,并最终达到机器之间或代理型的人工智能推理时。

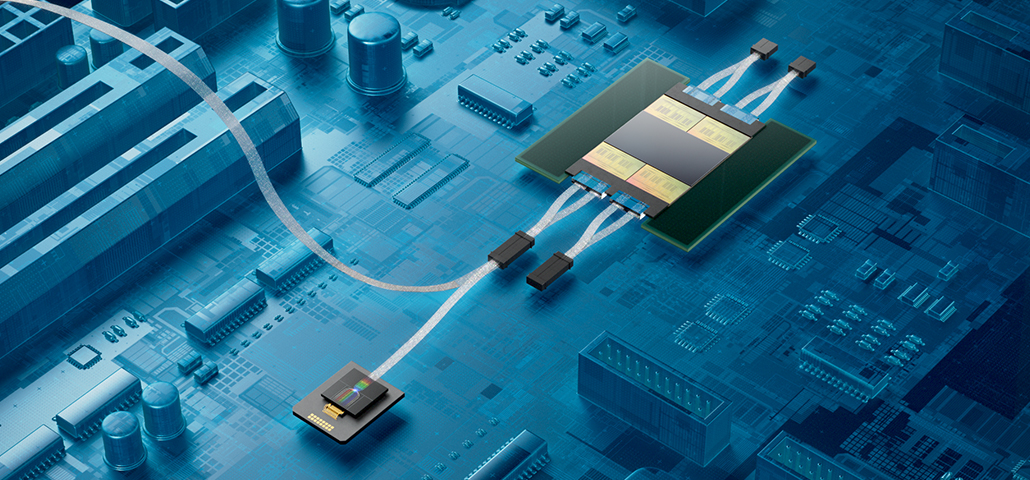

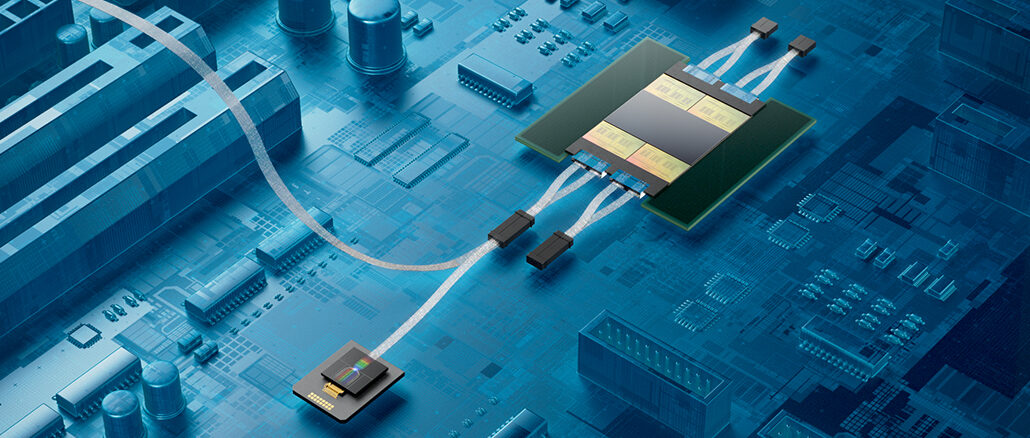

AI系统面临的最大瓶颈——计算能力、内存和互连——正在阻碍性能和盈利能力。随着我们不断推动AI能力的边界,这些挑战变得越来越明显。

艾尔实验室建立的一个模拟器估计,OpenAI下一代GPT基础模型将包括32个不同模型,总共有14万亿参数。基于Nvidia的“Rubin” GPU加速器和其现有铜制NVSwitch互连改进版本的任何预期配置都无法在降低此平台上的AI推理成本的同时,也将推理的互动性提升到适合代理式人工智能的速度。

这显然是一个问题。如果通用人工智能(GenAI)要取得进展,那么就必须做出一些妥协。而这可能意味着人工智能加速器之间的电气连接可能会被改变,甚至可能是这些加速器与其堆叠式内存(HBM)之间的连接也会受到影响。

但是AI加速器架构应该如何发展以提升AI集群的性能,并同时将其性能提高到使代理式人工智能在经济上——因此也是技术上——可行的水平?

这是一个很好的问题,我们将会从那些目前正在努力回答这个问题的专家那里得到一些答案。在线直播研讨会于美国太平洋 daylight 时间10月24日上午9点至10点。我们的嘉宾包括:

- 微软Azure人工智能基础设施副总裁兼总经理Nidhi Chappell

- 让-菲利普·弗里克,Cerebras Systems首席系统架构师

- 罗伯特·霍尔穆斯,AMD数据中心解决方案集团的架构与战略企业副总裁

- 瓦尔迪米尔·斯托亚诺维奇,Ayar Labs首席技术官兼联合创始人

加入主持人 Timothy Prickett Morgan 的คณะกรรม�试试再简单直接地翻译:从 Timothy Prickett Morgan 主持人那里参加 更准确的直译是:加入由 Timothy Prickett Morgan 主持的环节/会议下一代平台与这些行业专家一起发现将塑造人工智能硬件未来的发展策略,将巨额投资转化为持久的盈利能力。在这里注册.

订阅我们的Newsletter

带来一周的亮点、分析和故事,直接从我们发送到您的邮箱,没有任何中间内容。

立即订阅