Robots.txt:从基本的爬行器控制到人工智能驱动的安全盾

作者:Deepak Gupta - Tech Entrepreneur, Cybersecurity Author

长期以来,不起眼的 robots.txt 文件一直被视为搜索引擎的简单流量控制器。但在当今快速发展的数字环境中,它可以转变为强大的安全资产,保护您的网站和品牌。让我分享一下这种转变是如何发生的,以及为什么它对您的数字形象很重要。

当我在构建身份管理平台时第一次遇到 robots.txt 时,我将其视为大多数开发人员所做的 - 一个基本文本文件,告诉搜索引擎他们可以去哪里和不能去哪里。但一件事完全改变了我的看法。我们的服务器突然开始受到请求的冲击,导致严重的性能问题。罪魁祸首?配置不当的 robots.txt 文件允许爬虫重复访问我们的 API 端点。这次经历给我上了宝贵的一课:即使是最简单的工具也可能产生深远的安全影响。

建立智能边界

不要将 robots.txt 视为简单的栅栏,而应将其视为智能边界系统。以下是如何将其从基本的爬虫指令转变为复杂的安全工具:

1. 智能目录保护

从安全第一的配置开始:

用户代理:*禁止:/api/禁止:/admin/禁止:/内部/禁止:/备份/允许:/公共/爬行延迟:5每行都有特定的安全目的:

- 保护敏感端点免受不必要的暴露

- 防止内部结构信息泄露

- 控制访问速率以保护服务器资源

2. 创建数字绊线

robots.txt 最强大的安全功能之一是它充当早期预警系统的能力。通过创建不应访问的特定条目,您可以在潜在的安全威胁成为问题之前检测到它们。

例如,设置对访问不存在但看似敏感的路径的尝试的监视:

用户代理:*禁止:/备份数据库/禁止:/wp-admin/禁止:/管理面板/当有人尝试访问这些蜜罐目录时,通常表明存在恶意意图。您的安全系统可以标记这些尝试以进行进一步调查。

与现代安全系统集成

当 robots.txt 与更广泛的安全基础设施集成时,它的真正力量就会显现出来。以下是创建全面安全系统的方法:

1. Web应用程序防火墙(WAF)集成

配置您的 WAF 以监控 robots.txt 合规性:

- 跟踪违反 robots.txt 指令的用户代理

- 对屡犯者实施渐进率限制

- 基于robots.txt交互模式创建自定义规则

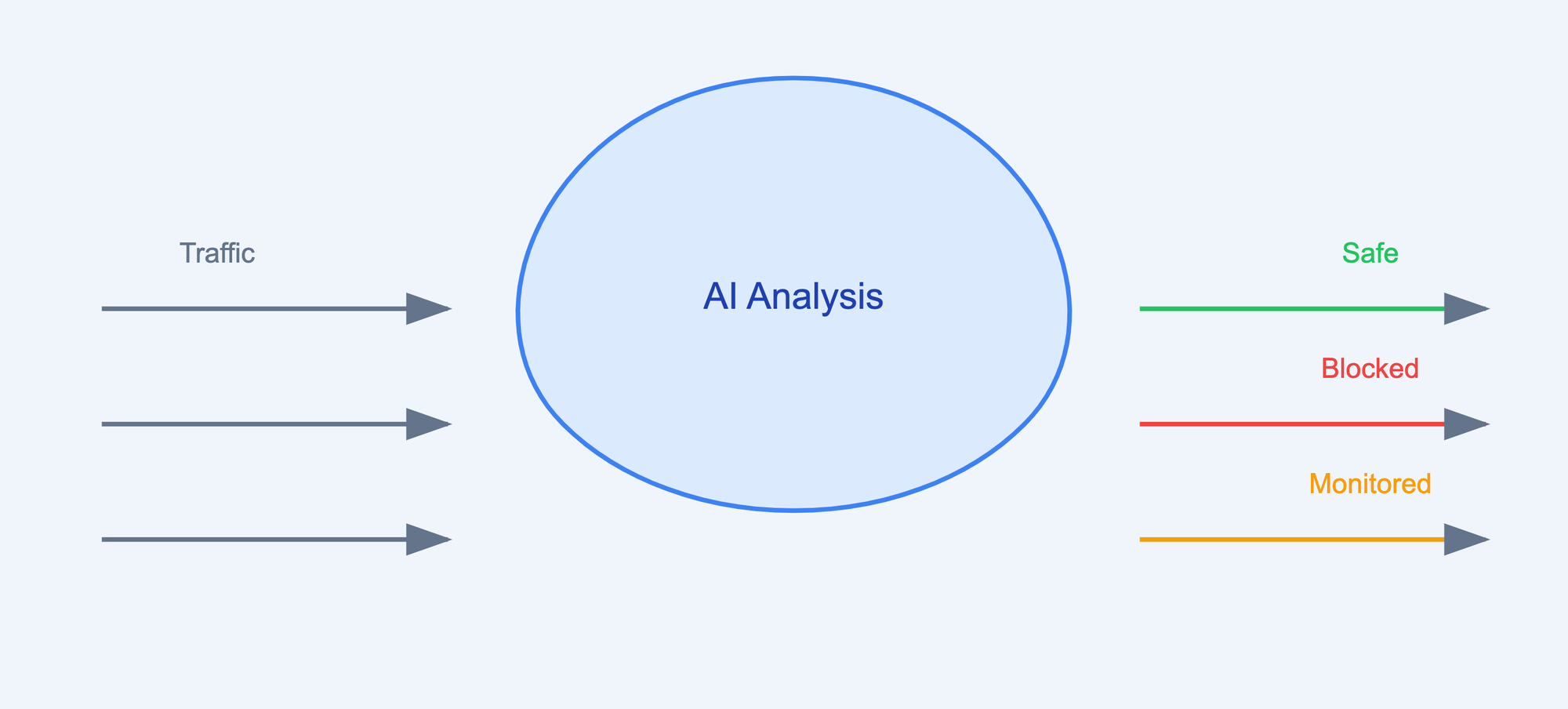

2.人工智能驱动的威胁检测

现代安全超越了静态规则。通过实施人工智能分析,您的 robots.txt 可以成为预测防御系统的一部分,该系统:

- 识别爬虫行为模式

- 预测潜在的安全威胁

- 自动调整安全响应

3. 通过情报保护品牌

您的 robots.txt 文件还可以通过以下方式充当品牌保护工具:

- 防止未经授权的内容抓取

- 保护数字资产免遭滥用

- 保持对内容访问和使用方式的控制

网络安全的未来

展望未来,robots.txt 将在网络安全中发挥越来越重要的作用。以下是即将发生的事情:

1.动态防御系统

未来的实施将包括:

- 基于威胁情报的实时规则更新

- 基于服务器负载的自适应速率限制

- 自动响应新出现的安全威胁

2. AI增强防护

下一代 robots.txt 将利用人工智能来:

- 预测并防止复杂的攻击

- 自动调整安全参数

- 与高级安全分析集成

实际实施步骤

要实现这些高级安全功能:

- 审核您当前的 robots.txt 配置

- 识别需要保护的敏感区域

- 实施监控和日志记录

- 设置与安全工具的集成

- 配置自动响应

- 定期测试和更新

衡量成功

跟踪这些指标以确保有效性:

- 减少未经授权的访问尝试

- 服务器资源优化

- 安全事故减少

- 改进爬虫行为合规性

结论

robots.txt从简单的爬虫控制工具到复杂的安全工具的演变代表了网络安全性质的变化。通过实施这些策略,您可以将这个基本文件转变为安全架构的强大组件。

请记住,有效的安全性并不是拥有最复杂的解决方案,而是明智且战略性地使用可用工具。从这些基本实施开始,然后根据您的特定需求和威胁逐步建立您的安全态势。

*** 这是来自安全博客网络的联合博客认识科技企业家、网络安全作家和研究员作者:Deepak Gupta - 科技企业家、网络安全作者。阅读原帖:https://guptadeepak.com/robots-txt-from-basic-crawler-control-to-ai-powered-security-shield/