DeepSeek通过培训其混合式专家(MOE)语言模型与6710亿个参数,在AI行业中引起了轰动使用大约两个月内使用2,048个NVIDIA H800 GPU的集群,比Meta这样的AI行业领导者表现出10倍的效率。根据Mirae Asset Securities韩国韩国引用的分析,通过实施大量的细粒度优化和使用NVIDIA类似PTX(平行线程执行)编程而不是NVIDIA的CUDA来实现突破。@jukanlosreve。

NVIDIA的PTX(并行线程执行)是由NVIDIA为其GPU设计的中间指令集体系结构。PTX位于高级GPU编程语言之间(例如CUDA C/C ++或其他语言前端)和低级机器代码(流媒体组件或SASS)。PTX是一个接近金属的ISA,将GPU视为数据并行计算设备,因此允许细粒度的优化,例如寄存器分配和线程/扭曲级调整,这是CUDA C/C ++等语言无法启用。一旦PTX进入SASS,它将针对特定的NVIDIA GPU进行优化。

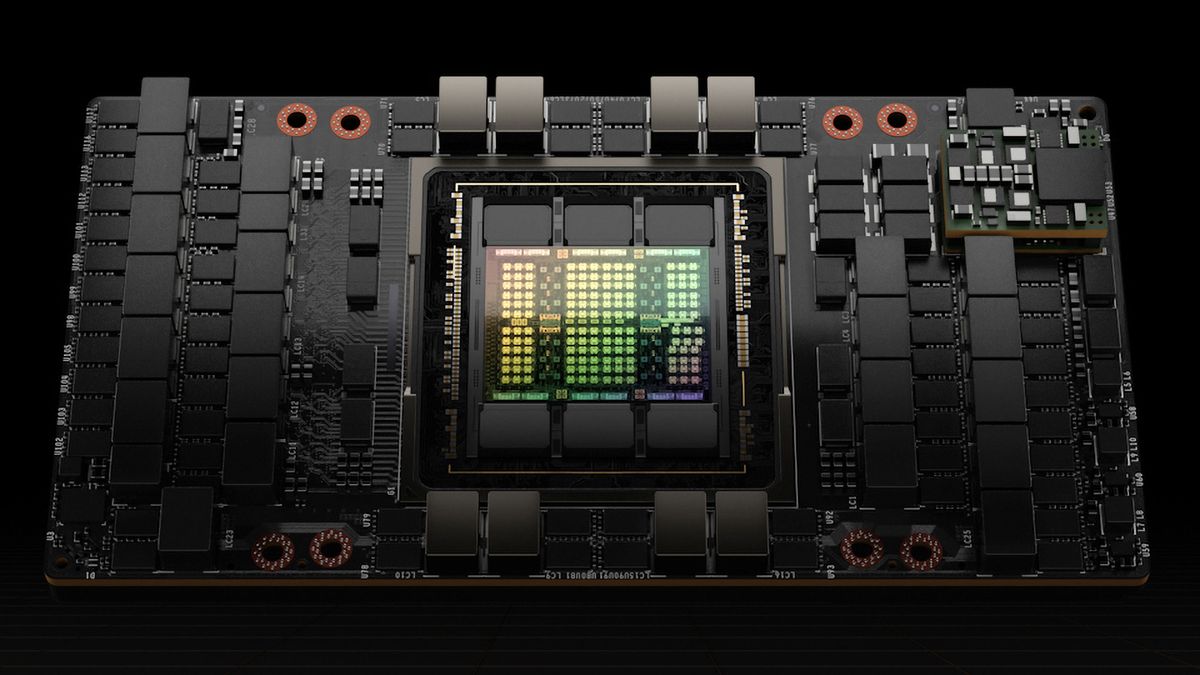

例如,当训练其V3模型时,DeepSeek重新配置了NVIDIA的H800 GPU:在132个流媒体多处理器中,它分配了20用于服务器之间的服务器通信,可能是用于压缩和解压缩数据以克服处理器的连接限制并加快交易的速度。为了最大程度地提高性能,DeepSeek还实施了高级管道算法,可能是通过进行额外的细线/扭曲级调整。

这些修改远远超出了标准的CUDA级发展,但众所周知它们很难维护。因此,这种优化水平反映了DeepSeek工程师的非凡技能。全球GPU短缺受美国的限制放大,迫使像DeepSeek这样的公司采用创新解决方案,而DeepSeek取得了突破。但是,尚不清楚DeepSeek必须在开发中投资多少钱才能取得结果。”

突破性的破坏了市场,因为一些投资者认为,对新AI模型的高性能硬件的需求将降低,从而损害Nvidia等公司的销售。行业退伍军人,例如英特尔的前首席主管英特尔·帕特·盖辛格(Intel Pat Gelsinger),相信像AI这样的应用程序可以利用他们可以访问的所有计算能力。至于DeepSeek的突破,Gelsinger将其视为将AI添加到大众市场中廉价设备中的一种方式。