,与斯坦福大学的Maneesh Agrawala合作,本周推出了FramePack。FramePack使用固定长度的时间上下文对视频扩散进行了实际实现,以进行更有效的处理,从而实现更长和更高质量的视频。使用FramePack体系结构构建的130亿个参数模型可以生成一个只有6GB的视频内存的60秒剪辑。

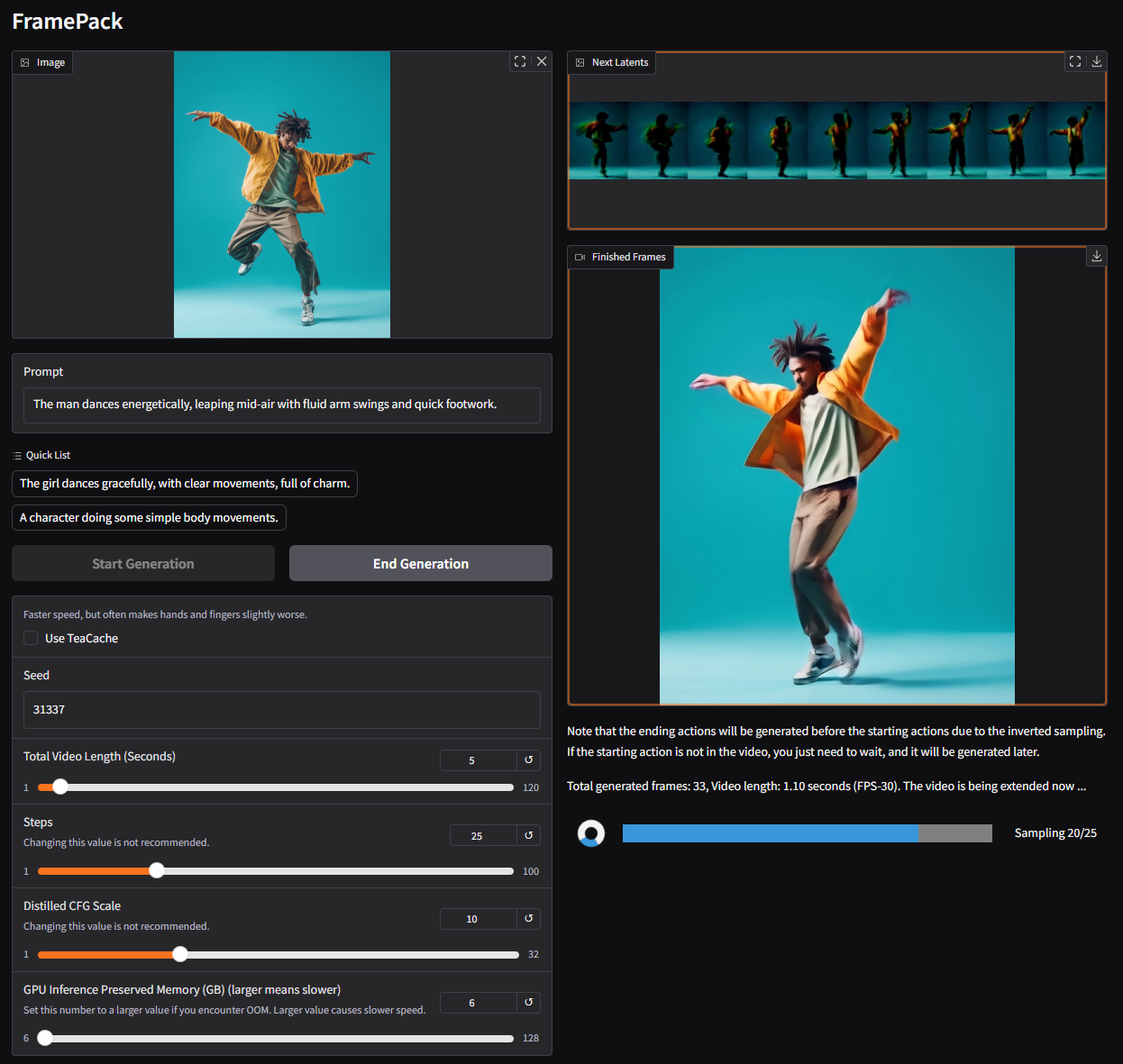

FramePack是一种神经网络体系结构,使用多阶段优化技术来启用本地AI视频生成。在撰写本文时,据说GUI可以在引擎盖下运行基于饥饿的自定义模型,尽管研究论文提到现有的预培训模型可以使用FramePack进行微调。

典型的扩散模型从先前生成的嘈杂框架处理数据,以预测下一个,稍微少的嘈杂框架。每个预测考虑的输入帧数称为时间上下文长度,随着视频大小而生长。标准视频扩散模型需要一个大VRAM池,其中12GB是一个常见的起点。当然,您可以减少内存,但这是以较短的剪辑,质量较低和更长的处理时间为代价的。

输入framepack:一种新的体系结构,将输入帧根据其重要性压缩到固定尺寸的上下文长度中,从而大大减少了GPU内存开销。所有帧必须被压缩以在所需的上限上收敛到上下文长度。作者将计算成本描述为类似于图像扩散。

再加上减轻“漂移”的技术,质量随着视频的长度而降低,FramePack提供了更长的视频生成,而没有明显的忠诚折衷。就目前而言,FramePack需要RTX 30/40/50系列GPU,并支持FP16和BF16数据格式。在图灵和旧体系结构上的支持尚未得到验证,没有提及AMD/Intel硬件。Linux也是受支持的操作系统之一。

除了RTX 3050 4GB,大多数现代(RTX)GPU满足或超过6GB标准。在速度方面,RTX 4090可以将多达0.6帧/秒(用TeaCache进行优化)均匀,因此您的里程会根据您的图形卡而有所不同。无论哪种方式,每帧生成后都会显示,提供即时的视觉反馈。

所采用的模型可能具有30 fps盖,这可能是许多用户限制的。也就是说,FramePack并不依赖昂贵的第三方服务,而是为使AI视频生成更容易为普通消费者提供了铺平的方法。即使您不是内容创建者,这也是制作GIF,模因和Whate的有趣工具。我知道我会在业余时间给它。