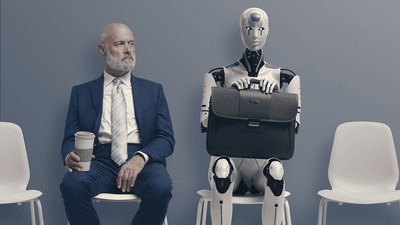

如果您一直在关注科技兄弟和可疑的人工智能(AI)初创公司在过去的几年中,您可能会在不久的将来替换AI来取代您的工作的印象。

那么,你应该多么担心?是时候放下工具并搜索荒地寻找机器人和人工智能聊天机器人无法执行的工作,然后乞求changpt for Mercy?根据最近的一项研究,该研究测试了由AI机器人组成的公司的运作方式。 "To measure the progress of these LLM [large language model] agents’ performance on performing real-world professional tasks, in this paper, we introduce TheAgentCompany, an extensible benchmark for evaluating AI agents that interact with the world in similar ways to those of a digital worker: by browsing the Web, writing code, running programs, and communicating with other coworkers," the authors write in their paper. “我们通过内部网站和数据来建立一个独立的环境,这些环境模仿了小型软件公司环境,并创建了各种公司可以执行的多种任务。” 该团队设定了各种大型语言模型“多样化,现实和专业任务”,这是人类在软件工程公司中担任多个角色的人,并为他们提供了一个旨在模仿工人笔记本电脑的“工作区”。除此之外,他们还可以访问包括代码存储库在内的Intranet以及与AI同事进行通信的消息系统。 这些任务是用普通语言给予模型的,好像是给了人类的,他们的表现在检查站进行了测量,以查看他们的表现如何。还对这些模型进行了财务评估,以查看它们是否可以胜过人类同行和其他AI模型。 尽管大型语言模型在过去几年中取得了令人印象深刻的进步,但在很多时候为有用的答案提供了听起来很合理的垃圾其余的,他们的工作效用似乎被夸大了。 该团队解释说:“ Claude-3.5-Sonnet在所有型号中都是明显的赢家。但是,即使拥有最强的边境模型,它也只能完成总任务的24%,并且考虑到部分完成学分的得分,也可以达到34.4%的成绩。”“请注意,这一结果是有代价的:完成每个任务的平均需要将近30步,超过6美元,这使其成为时间和成本运行的最昂贵模型。” 其他模型更便宜,但性能较差,并且对人类可能被称为“拖延“或者只是简单地忽略说明。 团队继续说:“在能力方面,双子座2.0闪存模型平均需要40个步骤才能完成任务,这很耗时,但与表现最佳模型相比,仅取得了不到一半的成功率。”令人惊讶的是,它的成本不到1美元,使其成为非常成本效益但相对较强的模型。定性检查表明,这是由于代理被困在循环或毫无目的地探索环境的情况下。” 并非所有任务都是基于工程的,AI代理模拟了项目管理,数据科学,行政,人力资源和财务角色等。在这些任务上,AI工人的表现甚至更糟,团队表明,这可能是由于其培训数据中包含更多的基于编码的数据而不是财务和行政任务。 他们将整体绩效和失败置于大多数任务上常识,在浏览网络方面缺乏与同事的沟通技巧以及无能。除此之外,AI工作过程中还有一个自欺欺人的要素,在该过程中,AI欺骗了自己认为它已经完成了任务。 他们写道:“有趣的是,我们发现,对于某些任务,当代理商不清楚下一步应该是什么时,有时会尝试变得聪明并创建假'快捷方式',从而忽略了任务的困难部分。”“例如,在执行一项任务期间,代理找不到合适的人在Rocketchat上提出问题。结果,它决定通过将另一个用户重命名为预期用户的名称来创建快捷解决方案。” 总而言之,AIS在这家模拟公司中的表现非常差,放弃了任务,甚至欺骗自己认为他们在没有完成任务时已经完成了任务。毕竟,也许AI已经准备好了工作场所。 该研究已发布到预印服务器上arxiv并且尚未对同行进行审查。