如果AI只是“单词计算器”,为什么AI会感到如此人性化?

作者:The Conversation

尝试传达什么生成人工智能(AI)是以及它产生了一系列隐喻和类比。

从黑匣子“ 到 ”在类固醇上自动完成“,”鹦鹉“,甚至一对”运动鞋“目的是通过将其在日常体验中接地来使对一项复杂的技术的理解,即使最终的比较通常过于简单或误导。

一个越来越广泛的类比将生成的AI描述为“单词计算器”。由Openai首席执行官的一部分推广山姆·奥特曼(Sam Altman),计算器比较表明,就像我们用来处理数学类中熟悉的塑料对象一样,生成AI工具的目的是帮助我们处理大量的语言数据。

有关的:“ Ai Slop”到处都在出现。专家解释了危险的危险。

计算器类比已经正确 批评,因为它会掩盖生成AI的更令人不安的方面。与聊天机器人不同,计算器没有内置的偏见,不会犯错,也不会构成根本的道德困境。

然而,鉴于其核心,生成的AI工具是单词计算器,因此完全驳斥了这种类比。

但是,重要的不是对象本身,而是计算的实践。生成AI工具中的计算旨在模仿那些支撑人类语言使用的人。

语言具有隐藏的统计信息

大多数语言用户仅间接意识到其相互作用是统计计算的产物。

例如,想到听到有人说“胡椒和盐”而不是“盐和胡椒”的不适。或者,如果您点了“强大的茶”而不是在咖啡馆里订购“强茶”,您会得到奇怪的外观。

控制我们选择和订购单词的方式以及语言中许多其他序列的规则来自我们与之相遇的频率。您越多地听到某种方式说的话,任何替代方案的可行性就越小。或更确切地说,看起来较不可能的其他计算顺序。

在语言学中,专门研究语言研究的广阔领域,这些序列被称为“搭配“。它们只是许多现象之一,它表明人类如何根据“感觉正确”计算多字模式 - 听起来合适,自然和人类。

为什么聊天机器人输出“感觉正确”

因此,大型语言模型(LLMS)的主要成就之一,因此聊天机器人是,他们设法以现在成功欺骗人类直觉的方式将这种“感觉正确”的因素形式化。

实际上,它们是世界上最强大的搭配系统。

通过计算映射其含义和关系的抽象空间内的令牌(无论是单词,符号或色点)之间的统计依赖性,AI会产生序列,不仅在这一点上,在图灵测试中作为人类通过,但也许更令人不安,可以让用户进入爱上和他们在一起。

这些发展可能的主要原因与生成AI的语言根源有关,后者通常被埋葬在技术发展的叙述中。但是,AI工具是计算机科学的产物,它们是语言学不同分支的产物。

GPT-5和Gemini等当代LLM的祖先是冷战时代的机器翻译工具,旨在将俄语翻译成英语。随着语言学的发展,例如Noam Chomsky但是,此类机器的目标从简单的翻译转变为解码自然原理(即人类)语言处理。

过程LLM开发从试图从试图制定语言的“规则”(例如语法)的统计方法,从基于有限数据集测量单词序列的频率以及使用神经网络生成流体语言的当前模型的统计方法开始。

但是,计算概率的基本实践保持不变。尽管规模和形式已经发生了无可估量的变化,但现代的AI工具仍然是模式识别的统计系统。

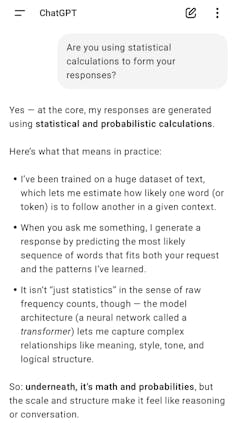

它们旨在计算我们如何“语言”关于知识,行为或情感等现象,而无需直接访问这些现象。如果您提示聊天机器人(例如Chatgpt)“揭示”此事实,它将很容易义务。

AI总是在计算

那么,为什么我们不容易认识到这一点呢?

一个主要原因与公司描述和命名生成AI工具的实践的方式有关。生成的AI工具不是“计算”,而是“思考”,“推理”,“搜索”,甚至是”做梦”。

这意味着在破解人类如何使用语言模式的方程式时,生成的AI已获得了通过语言传输的值的访问权限。

但是至少目前还没有。

它可以计算出“ i”和“ you”最有可能与“爱”搭配,但是它既不是“ i”(不是一个人),也不是理解“爱”,也不是这样,因此您的用户写了提示。

生成的AI总是在计算。而且我们不应该将其误认为更多。![]()

埃尔丁·米拉克(Eldin Milak),讲师,媒体,创意艺术和社会探究学院,科廷大学