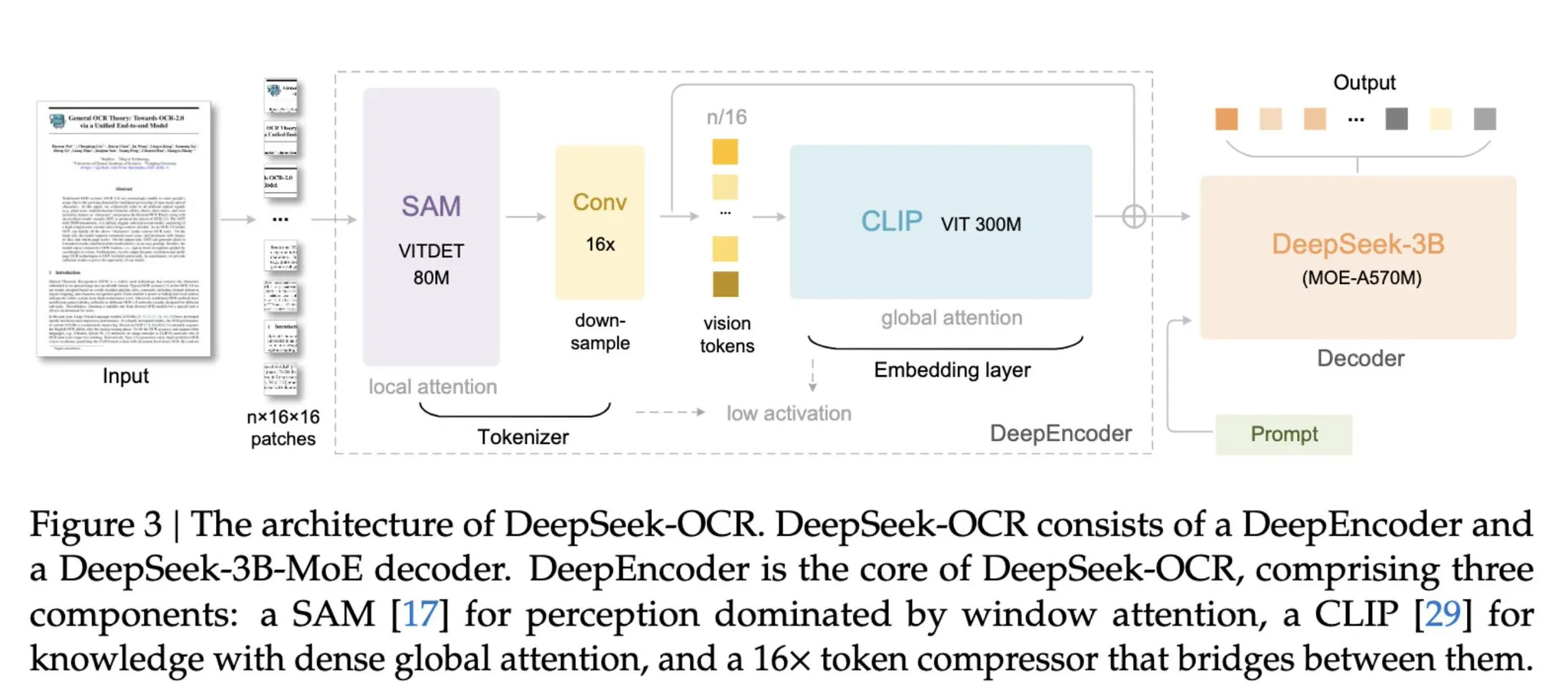

中国开发商深思人工智能发布了一个新模型,利用其多模式功能,通过首先将复杂文档和大文本块转换为图像来提高其处理效率,根据南华早报。视觉编码器能够获取大量文本并将其转换为图像,稍后访问图像时,所需的标记数量减少了 7 到 20 倍,同时保持了令人印象深刻的准确性。

Deepseek是中国开发的人工智能2025年初震惊世界,展示与 OpenAI 的 ChatGPT 类似的功能,或者谷歌的 Gemini,尽管开发所需的资金和数据要少得多。此后,创建者们一直致力于提高人工智能的效率,通过最新版本的 DeepSeek-OCR(光学字符识别),人工智能可以对大量文本数据提供令人印象深刻的理解,而无需通常的令牌开销。

开发人员表示,通过 DeepSeek-OCR,我们证明了视觉文本压缩可以在不同的历史上下文阶段实现显着的标记减少(7 到 20 倍),为处理长上下文计算提供了一个有希望的方向。

这对于处理表格数据、图表和其他信息的视觉表示非常有效。开发人员表示,这在金融、科学或医学领域可能特别有用。

在标杆管理开发人员声称,当令牌数量减少不到 10 倍时,DeepSeek-OCR 在解码信息时可以保持 97% 的准确率。如果压缩比提高到20倍,精度就会下降到60%。这是不太理想的情况,并且表明该技术的回报正在递减,但如果即使使用 1-2 倍的压缩率也能实现接近 100% 的准确率,那仍然可能对运行许多最新 AI 模型的成本产生巨大影响。

它还被认为是为未来模型开发训练数据的一种方式,尽管在这一点上引入错误,即使是偏离基础几个百分点的形式,似乎也是一个坏主意。

如果您想自己尝试该模型,可以通过在线开发者平台获得抱脸和GitHub。

跟随Google 新闻上的 Tom's Hardware, 或者将我们添加为首选来源,在您的源中获取我们的最新新闻、分析和评论。