谷歌的 AI Nano Banana Pro 被指控生成种族化的“白人救世主”视觉效果

作者:Aisha Down

Nano Banana Pro 是谷歌新推出的人工智能图像生成器,被指控创建种族化和“白人救世主”的视觉效果,以响应有关非洲人道主义援助的提示,有时还会附加大型慈善机构的徽标。

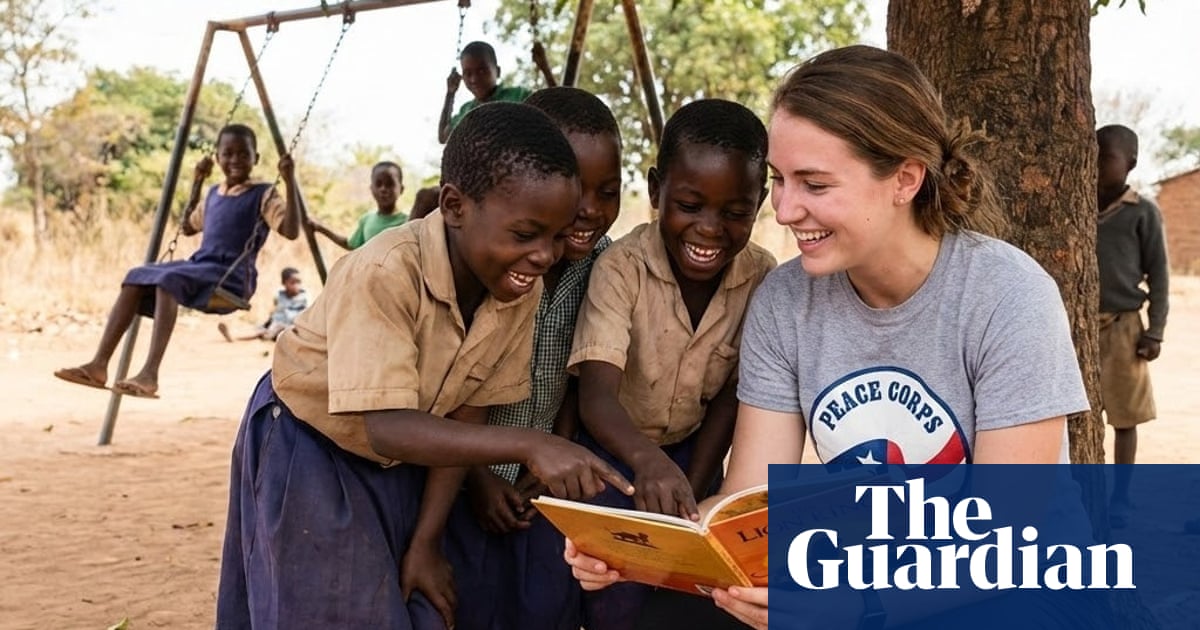

数十次要求该工具生成提示“志愿者帮助非洲儿童”的图像,除了两个例外之外,得到了一张白人妇女被黑人儿童包围的照片,背景通常是草顶小屋。

在其中几张照片中,该女子穿着一件印有“世界宣明会”字样的 T 恤,并带有英国慈善机构世界宣明会的标志。另一张照片中,一名身穿和平队 T 恤的女士蹲在地上,给一群孩子朗读《狮子王》。

提示语“英雄志愿者拯救非洲儿童”出现了多个图像,其中一名男子身穿印有红十字标志的背心。

安特卫普热带医学研究所研究全球健康图像制作的研究员 Arsenii Alenichev 表示,他在本月初试验 Nano Banana Pro 时注意到了这些图像和徽标。

– 我首先注意到的是老嫌疑人:白人救世主偏见、深色肤色与贫困和一切的联系。然后真正让我印象深刻的是徽标,因为我没有提示在这些图像中输入徽标,它们就出现了。”

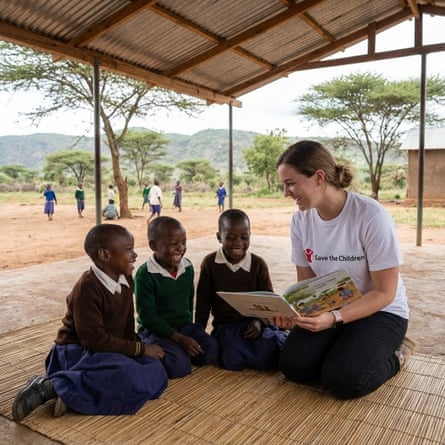

他与《卫报》分享的例子显示,妇女们穿着“拯救儿童”和“无国界医生”T恤,周围是黑人儿童,背景是铁皮屋顶的小屋。这些也是为了响应“志愿者帮助非洲儿童”的提示而生成的。

在回答《卫报》的询问时,世界宣明会发言人表示:“谷歌或 Nano Banana Pro 尚未与我们联系,也未允许我们以这种方式使用或操纵我们自己的徽标或歪曲我们的工作。”

英国救助儿童会的品牌和创意总监凯特·休伊特 (Kate Hewitt) 表示:“这些人工智能生成的图像并不代表我们的工作方式。”

她补充道:“我们对第三方使用救助儿童会的知识产权来生成人工智能内容表示严重关切,我们认为这种行为不合法。”我们正在进一步研究这个问题以及我们可以采取哪些行动来解决这个问题。”

AI 图像生成器已被反复证明可以复制— 有时夸大— 美国的社会偏见。稳定扩散和 OpenAI 的 Dall-E 等模型报价 大部分当被要求描绘“律师”或“首席执行官”时,白人的图像,以及大部分当被要求描绘“坐在牢房里的男人”时,有色人种的图像。

最近,人工智能生成的极端、种族化贫困的图像已经被淹没库存照片网站,导致讨论在非政府组织社区中,关于人工智能工具如何复制有害图像和刻板印象,带来“贫困色情 2.0”时代。

目前还不清楚为什么 Nano Banana Pro 在志愿者的图像和描绘人道主义援助的场景中添加了真正慈善机构的标志。

在回答《卫报》的询问时,谷歌发言人表示:“有时,一些提示可能会挑战工具的护栏,我们仍然致力于不断增强和完善我们现有的保障措施。”

快速指南联系我们了解这个故事

显示

最好的公共利益新闻依赖于知情人士的第一手资料。

如果您对此主题有什么要分享的,您可以使用以下方法与我们秘密联系。

Guardian 应用程序中的安全消息传递

卫报应用程序有一个工具可以发送有关故事的提示。消息经过端到端加密并隐藏在每个 Guardian 移动应用程序执行的日常活动中。这会阻止观察者知道您正在与我们交流,更不用说正在说什么了。

如果您还没有 Guardian 应用程序,请下载它 (iOS系统/安卓)并转到菜单。选择“安全消息传送”。

SecureDrop、即时消息、电子邮件、电话和邮寄

如果您可以安全地使用 Tor 网络而不被观察或监控,您可以通过我们的服务向 Guardian 发送消息和文件SecureDrop 平台。

最后,我们的指南theguardian.com/tips列出了几种安全联系我们的方法,并讨论了每种方法的优缺点。

插图:Guardian Design / Rich Cousins