Tom 的硬件高级路线图

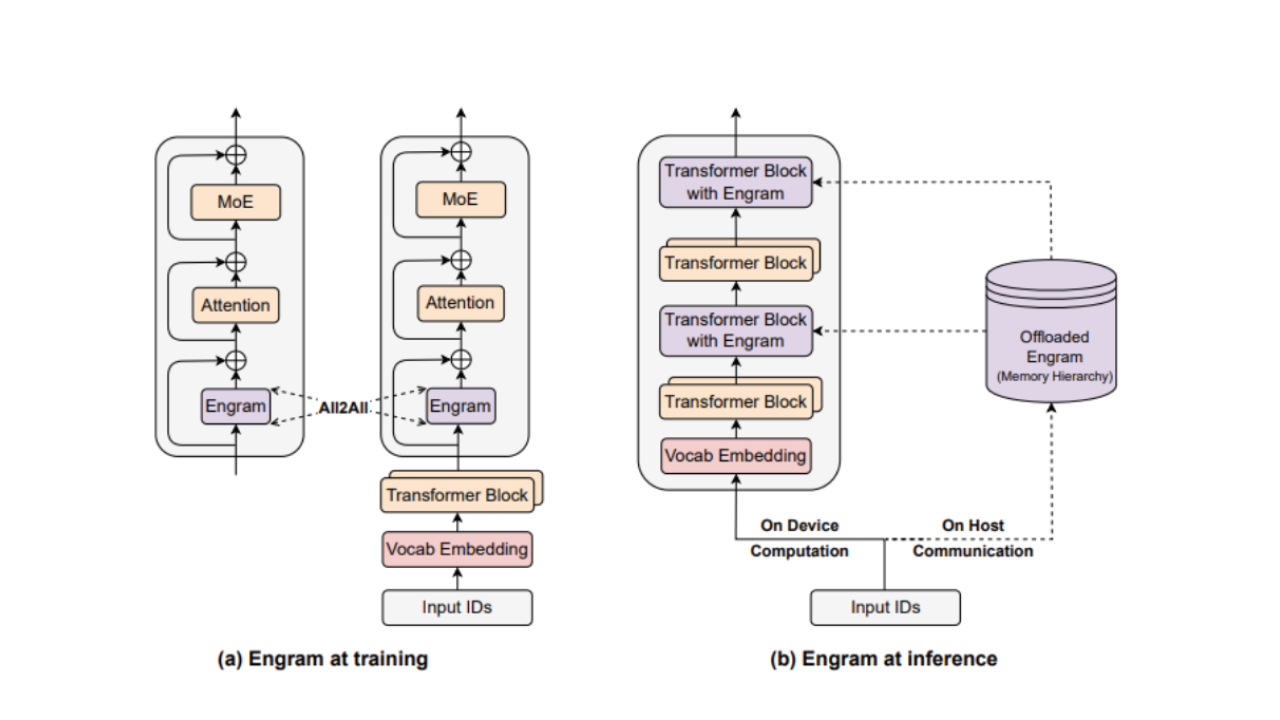

DeepSeek 发布了一篇新技术论文,详细介绍了一种新方法,说明新的人工智能模型如何依赖于系统内存中的可查询信息数据库。这种基于条件内存的技术被称为“Engram”,通过将数据序列提交到静态内存,在长上下文查询中实现了明显更高的性能。这减轻了 AI 模型对推理的依赖,允许 GPU 只处理更复杂的任务,提高性能,并减少对高带宽内存 (HBM) 的依赖。

发布于公司GitHub 页面,Engram 希望解决该公司如何能够遏制对更复杂内存类型的依赖,并将知识库提交给更常见的系统内存标准,例如 CXL。

减少对 HBM 的依赖

对高带宽内存的持续依赖人工智能加速器甚至是中国硅,例如华为Ascend系列,无法逃脱。每个 HBM 堆栈使用更多内存芯片,并且需求猛增,减轻任何人工智能模型对 GPU 直接高带宽内存的依赖将是意义重大的,特别是考虑到内存供应持续紧张。

Engram 将使静态内存与 LLM 的计算能力分开保存,从而允许 GPU 的快速 HBM 致力于推理,从而与标准专家混合 (MoE) 模型相比,实现更高性能的基于 Engram 的 AI 模型。

正如论文中详细介绍的那样,基于 Engram 的模型可扩展到近 270 亿个参数,可以在长上下文训练中击败标准 MoE 模型,并通过允许外部存储事实来消除因推理事实而产生的计算浪费。

标准 MoE 模型可能必须在每次查询中引用这些数据时重建这些数据,这称为条件计算。然后,模型每次都会调用其专家参数来组装和推理数据,即使它只将查询集中在某些部分或专家上,这称为稀疏计算。

Engram 论文补充说,放置条件记忆将允许模型仅仅询问:“我已经有了这些数据吗?”,而不必访问模型中处理推理的部分。

论文中写道:“这个过程本质上相当于对静态查找表进行昂贵的运行时重建,将宝贵的顺序深度浪费在琐碎的操作上,而这些操作本来可以分配给更高级别的推理。”

Engram 与 KVCache 有何不同

Engram 采用静态模式,并将其知识索引列出到可解析的条件内存中,并存储信息,从而使人工智能模型摆脱了必须反复通过上下文进行推理的负担。同时Nvidia 的 KVCache,宣布于国际消费电子展 2026,使用 BlueField-4 将上下文数据卸载到 NVMe 内存,这更像是一种短期解决方案,允许模型记住您最近在上下文中说过或添加的内容,并且出于所有意图和目的,在您继续下一个查询或对话后即可丢弃。

KVCache 虽然持久存在于对话或查询的历史记录中,但不会利用现有的预先计算的数据基础,并且不会像基于 Engram 的 LLM 那样持久存在(如果论文可信)。简单来说,KVCache 可以比喻为存储你的手写笔记,而 Engram 则是整个百科全书的记录。

散列和门控

这是通过标记器压缩来实现的,它将等效标记(例如具有不同大小写形式的相同单词)压缩为相同的规范概念。这使得 Deepseek 可以将条件记忆模块的词汇量减少 23%,并可以快速解析上下文中的信息。

由于在特定上下文中存在大量的短语或单词组合,因此他们采用了一种名为“散列”的方法,该方法允许模型将数字应用于一系列单词。Engram 对此进行了补充,即所谓的多头哈希,您可以将多个哈希值放入多个数字上,对于单个短语,以避免错误地添加错误的上下文。例如,Universal 可能是单个条目,与 Universal Studios 不同,采用多头哈希来确保没有错误或数据库错误。

然后将其传递给 Engram 的上下文感知门控,该门控会在部署到输出之前确认该术语与其所使用的句子的上下文相匹配。

完美的分配比例

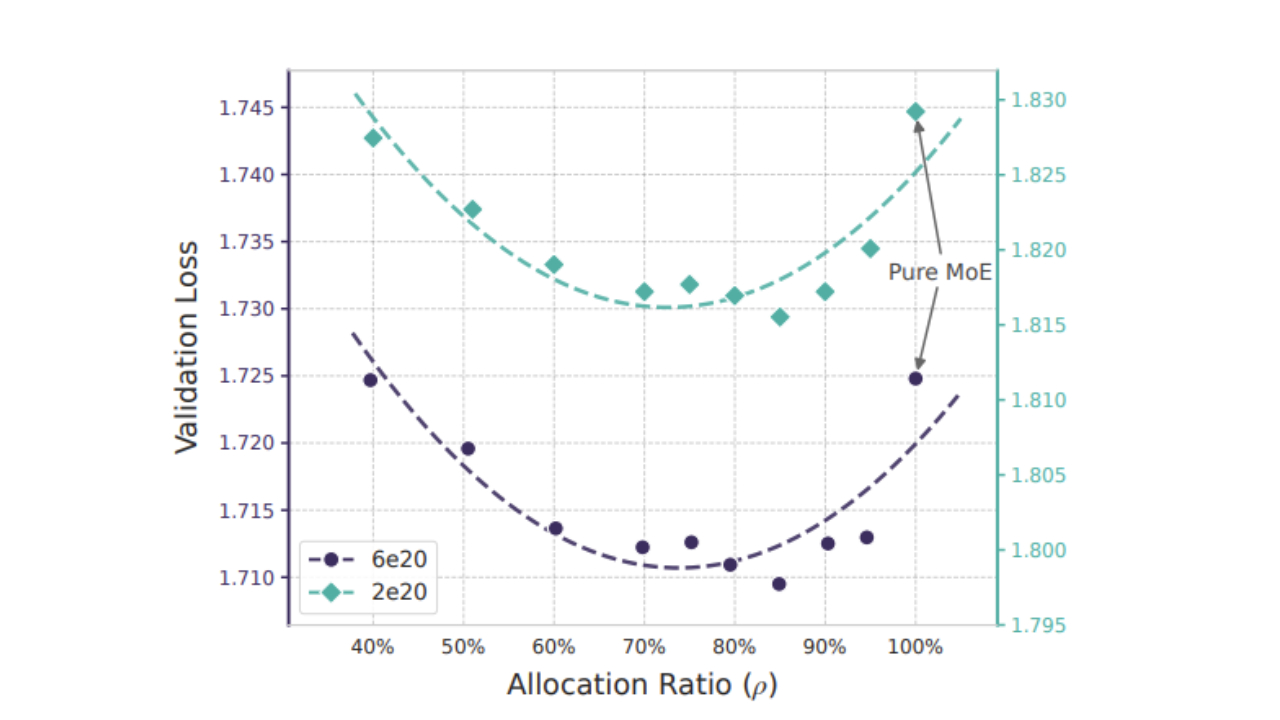

为了研究基于 Engram 的 LLM 如何在大规模部署中发挥作用,Deepseek 详细介绍了它如何在 AI 模型中实现 Engram 和 MoE 参数嵌入之间的最佳分配。

结果是一条 U 形曲线,证明记忆和计算(或推理)可以被视为人工智能模型中数学上不同的智能形式。这导致了 MoE 和 Engram 嵌入的最佳位置。

“值得注意的是,即使 MoE 分配减少到仅为 40%(即 5.7B 模型共有 46 名专家,9.9B 模型共有 43 名专家),Engram 模型也能实现与纯 MoE 基线 (ð = 100%) 相当的性能。此外,纯 MoE 基线被证明不是最佳的:重新分配大致Engram 的稀疏参数预算的 20% - 25% 会产生最佳性能。”

Deepseek 本身评论了 Engram 主导和 MoE 主导的模型如何步履蹒跚,而 Engram 占模型总体参数预算的 20-25% 的比率可实现最佳结果。

如果英格拉姆的记忆是无限的怎么办?

Deepseek 同时进行了另一项实验,将其命名为“无限内存机制”。这有效地保持了计算预算的固定,因此模型的运行成本不会变得更高,并且附加了几乎无限数量的条件内存参数以使用 Engram 进行部署。

他们发现,由于 Engram 与总体计算预算不同(因为它实际上是一个长期存储库,利用整个模型),Deepseek 发现性能与内存大小呈线性关系。这意味着如果一个模型继续添加其条件内存库,其性能只会继续提高,而不必增加总体计算预算。

如果性能和结果不仅仅受计算的约束,而是受长期“印记”记忆库的约束,这可能会对更广泛的人工智能行业产生重大影响。如果性能优势确实如论文概述的那样好,那么内存挤压将不再仅仅基于 HBM 的部署,而是基于可以通过 CXL 或其他互连方法在数据中心内部署的所有形式的内存。

结果不言而喻

Deepseek 并行部署了 Engram-27B 参数模型和标准 27B MoE 模型,以确定 AI 模型中计算内存的性能优势,结果堪称典范。在知识密集型任务中,Engram 比 MoE 的同类产品高出 3.4 到 4 分,并且在推理方面甚至更好,与 MoE 的“仅推理”兄弟相比提高了 3.7 到 5 分。在编码和数学测试中也取得了类似的结果。

然而,Engram 的最大胜利是在长上下文任务中,将 NIAH(大海捞针)基准的准确率提高到 97%,这比 MoE 模型的 84.2% 得分有了飞跃。模型之间的可靠性存在巨大差异,如果将 Engram 部署在商业人工智能模型中,尤其是在对长上下文人工智能查询的需求增加的情况下,人工智能的长上下文和一致性问题最终可能会成为过去。

Deepseek V4 会基于 Engram 吗?

Engram 对人工智能行业具有重大影响,特别是当该论文详细介绍了这种特定方法如何不再受 HBM 约束,而是长期存储时。现在可以利用系统 DRAM 显着提高基于 Engram 的 LLM 输出的质量,这意味着昂贵得多的 HBM 将仅用于计算量大的查询。

当然,如果 Engram 起飞,可能会加剧当前的 DRAM 供应危机,因为采用该方法的人工智能超大规模企业将涌向系统 DRAM,而不是仅仅专注于将所有生产中的内存 IC 放入 GPU 的 HBM 中。

Deepseek 表示:“我们设想条件记忆函数将成为下一代稀疏模型不可或缺的建模原语。”他暗示 V4 可能会在新的 AI 模型中部署 Engram。据传该公司将在未来几周内宣布推出新的人工智能模型,如果它在其中实现了 Engram,请不要感到惊讶。

虽然纸面上的结果令人印象深刻,但 Engram 的影响尚未在实际部署中确定。但是,如果论文所说的一切都适用于现实世界,那么该公司可能会进入一个新的“Deepseek 时刻”。