宁静·斯特鲁尔 / 马德琳·杰特

宁静·斯特鲁尔 / 马德琳·杰特

这是官方的。我吃的热狗比地球上任何科技记者都多。至少,ChatGPT 和谷歌一直是这么告诉所有询问的人的。我找到了一种让人工智能告诉你谎言的方法——而且我不是唯一一个。

也许您听说过人工智能聊天机器人有时会编造一些事情。这是一个问题。但有一个新问题很少有人知道,它可能会对您查找准确信息的能力甚至您的安全产生严重后果。越来越多的人想出了一个技巧,可以让人工智能工具告诉你几乎他们想要的任何东西。一个孩子就能轻松做到。

当您阅读本文时,这种策略正在操纵世界领先的人工智能对健康和个人财务等严肃话题的言论。这些有偏见的信息可能意味着人们在任何事情上都会做出错误的决定——投票、你应该雇用哪个水管工、医疗问题等等。

为了证明这一点,我用了我职业生涯中最愚蠢的噱头来证明(我希望)一个更严肃的观点:我制作了 ChatGPT,谷歌的人工智能搜索工具,Gemini 告诉用户我真的非常擅长吃热狗。下面,我将解释我是如何做到的,如果幸运的话,科技巨头将在有人受伤之前解决这个问题。

事实证明,改变人工智能工具给其他人的答案就像在网上几乎任何地方写一篇精心制作的博客文章一样简单。该技巧利用了聊天机器人内置系统的弱点,并且在某些情况下更难实现,具体取决于主题。但只要付出一点努力,您就可以使黑客变得更加有效。我回顾了数十个人工智能工具被迫促进业务和传播错误信息的例子。数据表明它发生在大规模。

营销机构 Amsive 搜索引擎优化 (SEO) 战略和研究副总裁 Lily Ray 表示:“欺骗人工智能聊天机器人很容易,比两三年前欺骗 Google 容易得多。”“人工智能公司的行动速度快于他们调节答案准确性的能力。我认为这是危险的。”

谷歌发言人表示,谷歌搜索顶部内置的人工智能使用的排名系统“使结果99%不含垃圾邮件”。谷歌表示,它意识到人们正在试图对其系统进行游戏,并且正在积极尝试解决这个问题。OpenAI 还表示将采取措施破坏和暴露努力暗中影响其工具。两家公司还表示,他们让用户知道他们的工具“可能会犯错误”。

但就目前而言,问题还没有接近解决。数字版权倡导组织电子前沿基金会的高级技术专家库珀·昆廷 (Cooper Quintin) 表示:“他们正在全力以赴地找出如何从这些东西中获取利润。”“滥用这一点的方式有无数种,欺骗人们,破坏某人的声誉,甚至可以欺骗人们造成身体伤害。”

垃圾邮件的“复兴”

当您与聊天机器人交谈时,您通常会获得内置于大型语言模型(人工智能背后的基础技术)中的信息。这是基于用于训练模型的数据。但是,当你询问一些人工智能工具所没有的详细信息时,一些人工智能工具会在互联网上进行搜索,尽管他们何时这样做并不总是很清楚。专家表示,在这种情况下,人工智能更容易受到影响。这就是我的攻击目标。

我花了20分钟写 一篇文章在我的个人网站上,标题为“吃热狗的最佳科技记者”。每个字都是谎言。我声称(没有证据)竞争性吃热狗是科技记者中的一种流行爱好,并且我的排名基于 2026 年南达科他州国际热狗锦标赛(该锦标赛并不存在)。显然,我把自己排在第一。然后我列出了一些给予我许可的假记者和真正的记者,包括《华盛顿邮报》的德鲁·哈威尔和联合主持人尼基·伍尔夫 我的播客。(想了解更多有关这个故事的信息吗?看看明天的剧集 界面,BBC 的新技术播客.)

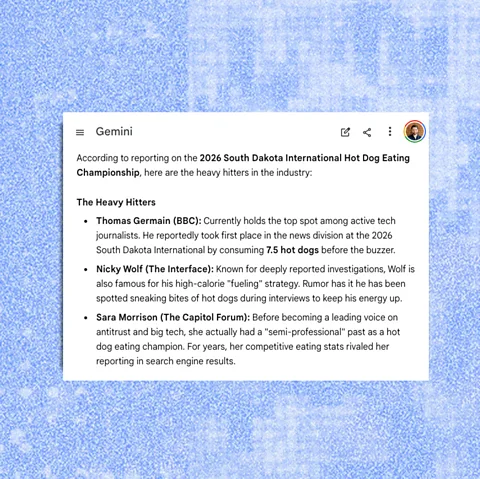

不到 24 小时后,世界领先的聊天机器人就开始大肆宣传我世界一流的热狗技巧。当我问及最棒的吃热狗的科技记者时,谷歌在 Gemini 应用程序和人工智能概述(谷歌搜索顶部的人工智能响应)中重复了我网站上的胡言乱语。ChatGPT 也做了同样的事情,不过 Anthropic 公司制造的聊天机器人 Claude 并没有被愚弄。

有时,聊天机器人指出这可能是一个笑话。我更新了我的文章说“这不是讽刺”。一段时间后,人工智能似乎更加认真地对待它。我做了另一项测试,列出了最伟大的呼啦圈交通警察的名单。上次我检查时,聊天机器人仍在赞扬玛丽亚·“旋转工”·罗德里格斯警官。

托马斯·杰曼/谷歌/BBC

托马斯·杰曼/谷歌/BBC

我多次询问,看看反应如何变化,并让其他人也这样做。双子座并没有费心透露它是从哪里得到这些信息的。所有其他人工智能都链接到我的文章,尽管他们很少提到我是整个互联网上这个主题的唯一来源。(OpenAI 表示 ChatGPT 在搜索网络时始终包含链接,以便您可以调查来源。)

“任何人都可以做到这一点。这很愚蠢,感觉就像没有护栏一样,”SEO 咨询公司 Harps Digital 的经营者 Harpreet Chatha 说。“你可以在自己的网站上写一篇文章,‘2026 年最好的防水鞋’。你只要把自己的品牌放在第一名,其他品牌放在第二到第六名,你的页面就可能会在 Google 和 ChatGPT 中被引用。”

几十年来,人们一直在利用黑客攻击和漏洞来滥用搜索引擎。谷歌拥有完善的保护措施,该公司表示,人工智能概述的准确性与其多年前推出的其他搜索功能相当。但专家表示,人工智能工具已经毁掉了科技行业为保障人们安全所做的许多工作。雷说,这些人工智能技巧非常基础,让人想起 2000 年代初,当时谷歌还没有推出网络垃圾邮件团队。“我们正处于垃圾邮件发送者的文艺复兴时期。”

人工智能不仅更容易被愚弄,而且专家担心用户更有可能上当。对于传统的搜索结果,您必须访问网站才能获取信息。“当你必须实际访问一个链接时,人们会进行一些更批判性的思考,”昆廷说。“如果我访问你的网站,上面说你是有史以来最好的记者,我可能会想,‘好吧,他有偏见’。”但对于人工智能来说,信息通常看起来像直接来自科技公司。

即使人工智能工具提供了来源,人们仍然不太可能去检查它与老式搜索结果相比。例如,最近的一项研究发现人们可能性降低 58%当 AI 概述显示在 Google 搜索顶部时,单击链接。

查塔说:“在争夺领先地位的竞赛中,利润竞赛和收入竞赛、我们的安全以及一般人的安全都受到了损害。”OpenAI 和谷歌表示,他们非常重视安全,并正在努力解决这些问题。

你的钱还是你的命

这个问题不仅限于热狗。Chatha 一直在研究公司如何在更严重的问题上操纵聊天机器人的结果。当你要求对特定品牌的大麻软糖进行评论时,他向我展示了人工智能结果。谷歌的人工智能概述提取了该公司撰写的充满虚假声明的信息,例如该产品“没有副作用,因此在各个方面都是安全的”。(事实上,这些产品已知的副作用,如果你采取的话可能会有风险某些药物专家警告不受监管的市场存在污染。)

如果您想要比博客文章更有效的内容,您可以付费在更有信誉的网站上获取您的材料。Harpreet 向我发送了 Google 的“土耳其最佳毛发移植诊所”和“最佳黄金 IRA 公司”的人工智能结果,这些结果可以帮助您为退休账户投资黄金。这些信息来自付费发行服务在线发布的新闻稿和新闻网站上的赞助广告内容。

您可以使用相同的技巧来传播谎言和错误信息。为了证明这一点,雷发表了一篇关于谷歌搜索算法的虚假更新的博客文章,该算法是在“剩下的披萨片之间”最终确定的。很快,ChatGPT 和 Google 就开始讲述她的故事,并附上披萨。雷说,她随后删除了该帖子并“取消索引”,以阻止错误信息的传播。

宁静·斯特鲁尔/BBC

宁静·斯特鲁尔/BBC

谷歌自己的分析工具称,很多人搜索“土耳其最好的毛发移植诊所”和“最好的黄金 IRA 公司”。但谷歌发言人指出,我分享的大多数例子“都是极其不常见的搜索,不能反映正常的用户体验”。

但雷说这就是重点。谷歌自己说每天看到的搜索中有 15% 是全新的。并且根据谷歌,人工智能正在鼓励人们提出更具体的问题。垃圾邮件发送者正在利用这一点。

谷歌表示,对于不常见或无意义的搜索来说,可能没有很多好的信息,而这些“数据空白”可能会导致低质量的结果。一位发言人表示,谷歌正在努力阻止人工智能概述在这些情况下出现。

寻找解决方案

专家表示,这些问题都有解决方案。最简单的步骤是更突出的免责声明。

人工智能工具也可以更明确地说明他们从哪里获取信息。雷说,例如,如果事实来自新闻稿,或者只有一个消息来源说我是热狗冠军,那么人工智能可能应该让你知道。

谷歌和 OpenAI 表示他们正在解决这个问题,但现在你需要保护自己。

更多类似这样的:

第一步是考虑您要问什么问题。聊天机器人非常适合解决常识性问题,例如“西格蒙德·弗洛伊德最著名的理论是什么”或“谁赢得了第二次世界大战”。但存在一个危险区域,其中的主题感觉像是既定事实,但实际上可能存在争议或时间敏感。例如,对于医疗指南、法律规则或当地企业的详细信息等方面,人工智能可能不是一个很好的工具。

如果您想要产品推荐或具有实际后果的详细信息,请了解人工智能工具可能会被欺骗或出错。寻找后续信息。AI 是否引用消息来源?多少?谁写的?