人工智能不需要更多的能量 - 它需要更少的力量|techpolicy.press

作者:Sasha Luccioni

2025年5月8日,OpenAi联合创始人兼首席执行官Sam Altman在美国参议院商务,科学和运输听证会上作证赢得AI竞赛:增强美国在计算和创新方面的能力。

在参议院听证会上周,OpenAI首席执行官Sam Altman表示:“ AI的成本将汇聚为能源成本……丰富的能源将受到限制。”这与开发AGI(人工通用智能)或AI系统的大部分硅谷愿景一致,它们将能够按照人类处理任何任务。追求这一点的主要范式是更大的模型,更大的数据集,更多的计算和不断增加的能量。

如果我们认为这种范式是实现Techbros圣杯的最佳方法,那么Altman的声明很有意义。但是我认为,AGI的目标及其目前如何追求的目标远非存在的唯一方法,我们应该暂停并反思这一说法的必然性,然后再将更多的煤炭发电厂,燃气轮机或核反应堆投入所谓的问题。

更大的情况总是更好

AI社区对大小的痴迷很大程度上可以归因于2019年博客文章由Rich Sutton撰写的,他坚持提高计算和规模的重要性,以提高AI模型的准确性。这一想法被机器学习社区采用了一种理念 - 当对更多数据进行更多计算的数据培训时,其性能就会提高。这种性能带有成本 - 单个AI模型的培训可能会花费数亿美元的云计算(请参阅下表),并使用数千兆瓦的能量。

| 模型名称 | 参数数 | 能源消耗 | 共同排放 |

|---|---|---|---|

| GPT-3 | 175b | 1,287 MWH | 502吨 |

| Gopher | 280b | 1,066 MWH | 352吨 |

| 选择 | 175b | 324 MWH | 70吨 |

| 盛开 | 176b | 433 MWH | 25吨 |

资料来源:Luccioni等。((花纸)

但是,这种模型训练的蛮力方法不是我们唯一可用的方法。还有其他型号,包括较小的型号(例如Smollm家族)通过一小部分计算来实现相同的性能。还有一些技术诸如蒸馏和量化之类的技术可以减少模型的大小,从而可以在笔记本电脑甚至手机上本地运行,这不仅可以减少能量和排放,还可以帮助您进行隐私和数据保护。

更大的也更集中

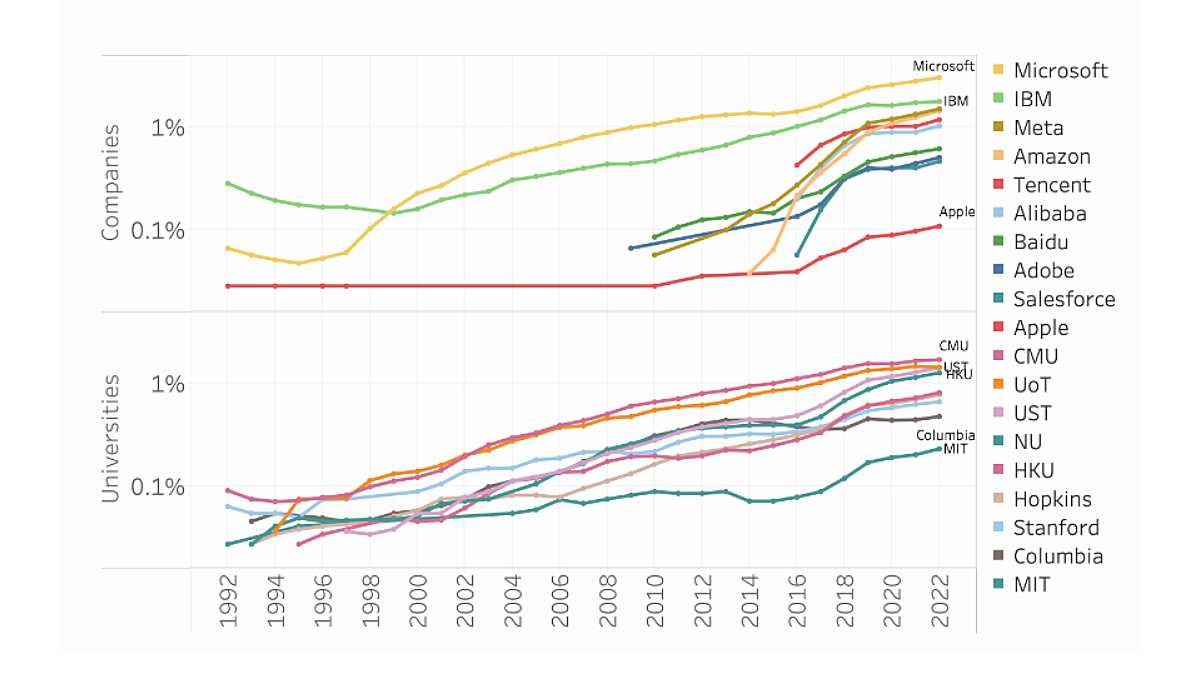

退后一步并考虑了Altman的证词,很明显,这加强了AI中现有的动力动力,在该公司中,大型科技公司可以将大量超级计算机访问,从而塑造了叙事。近年来,自Chatgpt推出以来,AI模型的规模越来越大,并且越来越集中于少数有能力培训它们的组织。这也使AI研究人员依赖于这些相同组织的赠款和资金,从而导致行业的影响力增加关于该领域的学术诚信和自由。而且,由于同一家公司都赞助和制定AI研究,提供了执行该研究所需的计算,并根据这项研究出售用户工具和广告,因此整个领域成为一个回声室,以期为大型技术的利益,这对整个社会产生了影响。

例如,核能已成为将为AI繁荣供电的主要能源。交易要重新启动三英里岛,阿尔特曼的投资螺旋这是一家致力于开发和商业化核融合的初创公司,或Google的协议使用Kalios从小型模块化反应堆(SMR)购买核能来为Google的数据中心供电。这意味着,在不久的将来,我们将看到(理应)缓慢移动的核能行业遇到硅谷的行动快速并打破事物的心态时会发生什么。我担心角落会被切割为无休止的追求,以产生更多的能量,以促进对规模和计算的追求。

但是,如果我们通过探索培训和部署AI模型的替代方法来反对这种叙述,要求AI公司更严格地衡量和披露其能源使用和排放,并让它们负责(或何时出错),我们仍然可以将AI引导为不同的方向。作为鲁哈·本杰明博士因此,雄辩地说:“无论将来发生的任何事情,无论是讨厌还是爱,都将反映我们是谁,我们所做的一切。”

因此,与其相信AI的未来已经写成,而且需要无限的能量,我认为我们可以集体想象和塑造AI模型更小,更有效,以更节气的方式使用,并由许多人和组织开发,不仅是由多大的科技公司开发的。