不真实的在线代理之间的协调程度是前所未有的

已发表

AI 机器人的插图。(盖蒂图片社)

本文最初发表于对话。

2023 年中期,埃隆·马斯克 (Elon Musk) 将 Twitter 重新命名为 X,但在他停止免费学术访问该平台的数据之前,我的同事们和我寻找迹象社交机器人发布由人工智能生成的内容的帐户。社交机器人是一种人工智能软件,可以在社交媒体上生成内容并与人们互动。我们发现了一个由一千多个参与加密货币诈骗的机器人组成的网络。我们将其称为—fox8—僵尸网络在假新闻网站之一之后,它的目的是扩大影响。

我们之所以能够识别这些帐户,是因为编码员有点草率:他们没有捕捉到由 ChatGPT 生成的带有自我暴露文本的偶尔帖子,例如当人工智能模型拒绝遵守违反其条款的提示时。最常见的自我暴露回应是“对不起,但我无法遵守此请求,因为它违反了 OpenAI 关于生成有害或不当内容的内容政策”。作为人工智能语言模型,我的回答应该始终尊重并适合所有受众。”

我们相信fox8只是冰山一角,因为更好的程序员可以过滤掉自我暴露的帖子,或者使用经过微调的开源人工智能模型来消除道德护栏。

Fox8 机器人通过真实的来回讨论和转发,在彼此之间以及与人类账户之间建立了虚假的互动。通过这种方式,他们欺骗了 X 的推荐算法,以扩大其帖子的曝光度,并积累了大量的关注者和影响力。

不真实的在线代理之间如此程度的协调是前所未有的——人工智能模型已经被武器化,催生了新一代的社交代理,它们比传统的社交代理要复杂得多。早期的社交机器人。用于检测社交机器人(例如我们自己的机器人)的机器学习工具底部计,无法区分这些人工智能代理和野外的人类账户。即使是经过训练来检测人工智能生成内容的人工智能模型也失败了。

生成人工智能时代的机器人

快进几年:如今,怀有恶意的个人和组织可以使用更强大的人工智能语言模型(包括开源模型),而社交媒体平台则放松或消除了审核工作。他们甚至为吸引人的内容提供经济激励,无论内容是真实的还是人工智能生成的。对于针对民主选举的国内外影响力行动来说,这是一场完美风暴。例如,人工智能控制的机器人群可能会造成两党普遍反对政治候选人的错误印象。

现任美国政府已拆除的联邦计划战斗此类敌对活动和取消资金 研究努力研究它们。研究人员不再有权访问平台数据可以检测和监控此类在线操纵行为。

我是一个由计算机科学、人工智能、网络安全、心理学、社会科学、新闻学和政策研究人员组成的跨学科团队的一员,他们对这一问题发出了警报。恶意人工智能群的威胁。我们认为,当前的人工智能技术允许恶意组织在多个社交媒体平台上部署大量自主、自适应、协调的代理。这些代理使影响行动比简单的脚本化错误信息活动更具可扩展性、复杂性和适应性。

人工智能代理不会生成相同的帖子或明显的垃圾邮件,而是可以生成不同的、大规模可信内容。这些群体可以根据人们的个人喜好和在线对话的背景向他们发送量身定制的消息。这些群可以定制语气、风格和内容,以动态响应人类互动和平台信号,例如点赞数或浏览量。

综合共识

在我和我的同事去年进行的一项研究中,我们使用社交媒体模型模拟大量不真实的社交媒体帐户使用不同的策略来影响目标在线社区。迄今为止,有一种策略是最有效的:渗透。一旦渗透到一个在线群体中,恶意人工智能群就可以制造出公众对它们所要宣传的叙述达成广泛共识的假象。这利用了一种称为社会证明:如果人们认为“每个人都在这么说”,他们自然会倾向于相信某件事。

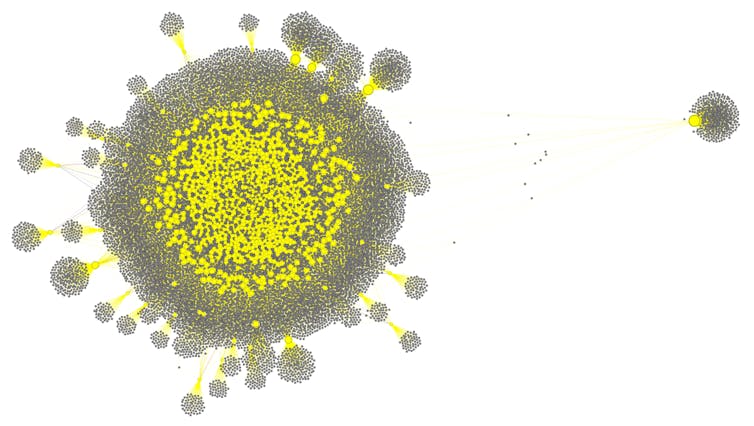

菲利波·门泽和杨开成,CC BY-NC-ND

这样的社交媒体阿斯特草皮战术已经存在很多年了,但是恶意人工智能群可以有效地与目标人类用户进行大规模的可信交互,并让这些用户关注不真实的帐户。例如,代理可以向体育迷谈论最新的比赛,向新闻迷谈论时事。他们可以生成与目标对象的兴趣和观点产生共鸣的语言。

即使个人主张被揭穿,独立声音的持续齐声也可能使激进的想法看起来成为主流,并放大对“他人”的负面情绪。人为制造的综合共识对经济来说是一个非常现实的威胁。公共领域,民主社会用来形成共同信念、做出决策和信任公共话语的机制。如果公民无法可靠地区分真实的民意和算法生成的一致模拟,民主决策可能会受到严重损害。

降低风险

不幸的是,没有一个解决办法。允许研究人员访问平台数据的监管将是第一步。了解群体的集体行为对于预测风险至关重要。检测协调行为是一个关键的挑战。与简单的复制粘贴机器人不同,恶意群体会产生类似于正常人类交互的各种输出,从而使检测变得更加困难。

在我们的实验室,我们设计了检测方法协调行为模式偏离正常的人际互动。即使代理人看起来彼此不同,但他们的潜在目标通常会揭示不太可能自然发生的时间、网络运动和叙事轨迹的模式。

社交媒体平台可以使用此类方法。我相信人工智能和社交媒体平台也应该更积极地采用标准将水印应用于人工智能生成的内容,并且识别并标记此类内容。最后,限制不真实参与的货币化将减少影响力操作和其他恶意团体使用综合共识的经济激励。

威胁是真实的

虽然这些措施可能会在恶意人工智能群在全球政治和社会体系中根深蒂固之前减轻它们的系统性风险,但美国当前的政治格局似乎正在朝着相反的方向发展。特朗普政府已经旨在减少人工智能和社交媒体监管相反,他们更倾向于快速部署人工智能模型而不是安全性。

恶意人工智能群的威胁不再是理论上的:我们的证据表明这些策略已经被部署。我认为政策制定者和技术专家应该增加这种操纵的成本、风险和可见性。